参考:https://www.cnblogs.com/pinard/p/6069267.html

以及:https://blog.csdn.net/qq_32690999/article/details/78737393

朴素贝叶斯法是基于贝叶斯定理与特征条件独立假设的分类方法。对于给定的训练数据集,首先基于特征条件独立假设学习输入/输出的联合概率分布,然后基于此模型,对给定的输入x,利用贝叶斯定理求出后验概率最大的输出y.

先验概率:

通俗来说,对于某一个概率事件,我们都会有基于自己已有的知识,对于这个概率事件会分别以什么概率出现各种结果会有一个预先的估计,而这个估计并未考虑到任何相关因素。

后验概率:

所以后验概率就是在先验概率的基础上加了一层“考虑”:结合我们已有的知识,将与待检验事件(即我们正在估计概率的随机事件)相关的因素也考虑进去后,我们对随机事件的概率的预估。

先验概率基于已有知识对随机事件进行概率预估,但不考虑任何相关因素求(P(c))。后验概率基于已有知识对随机事件进行概率预估,并考虑相关因素求(P(c|x))

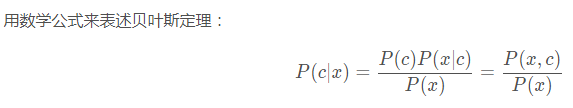

贝叶斯定理所阐述的也就是后验概率的获得方法:

由上图可知,贝叶斯最终是要获得后验概率P(c|x),为了获得这个后验概率由公式可得需要先获得P(x|c).但是它的获取相对较为麻烦,因为x往往包含多个相关因素(是一个多种因素构成的向量),即它可能有多个需要考虑的属性值,任一xi都代表了所有相关因素中的其中一个。我们若要计算P(x|c),实际上就是要计算P(x1,x2,x3,...,xn∣c),这往往计算什么复杂,但是朴素贝叶斯做了属性条件独立性假设(朴素的体现)那么假设属性的取值可能性都是独立的,以简化P(x1,x2,x3,...,xn∣c)的计算为P(x1∣c)∗P(x2∣c)∗P(x3∣c)∗...∗P(xn∣c) 。

朴素贝叶斯法通过训练数据集学习联合概率分布P(X,Y),具体的就是学习先验概率分布以及条件概率分布,P(X,Y)=P(Y)P(X|Y),先验概率就是训练数据中这些类别的概率,同时朴素贝叶斯做了条件独立性假设,这个假设是用于分类的特征在类确定的条件下都是条件独立的,这使得朴素贝叶斯变得简单了,但会使得分类准确性下降。由此可见朴素贝叶斯法是学习到生成数据的机制,故属于一种生成模型。朴素贝叶斯法分类时,对给定的输入x,通过学习到的模型计算后验概率分布P(Y|X),将后验概率最大的类做为x的输出类,(在训练时已知概率最大的类,对参数进行优化所以用极大似然估计,此外这里也可以用贝叶斯估计(加了一个平滑项,解决出现0的情况))