一、编写spark代码的几种方式:

(主要看重的方面:1、观察数据集 2、编写代码测试数据集 3、固化代码、提交集群运行上线)

1、spark-shell

(数据集的探索、测试)

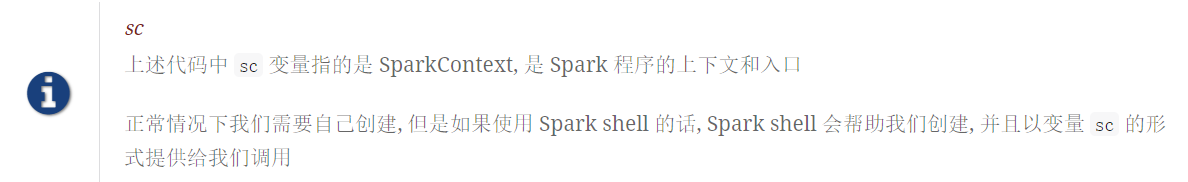

Spark shell 简介

-

启动 Spark shell

进入 Spark 安装目录后执行spark-shell --master master就可以提交Spark 任务 -

Spark shell 的原理是把每一行 Scala 代码编译成类, 最终交由 Spark 执行

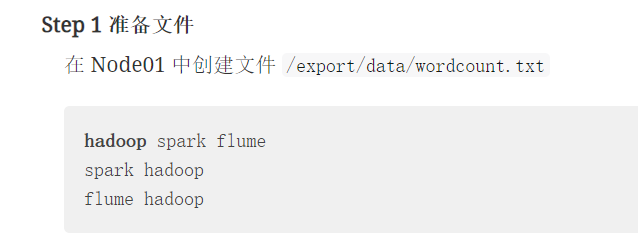

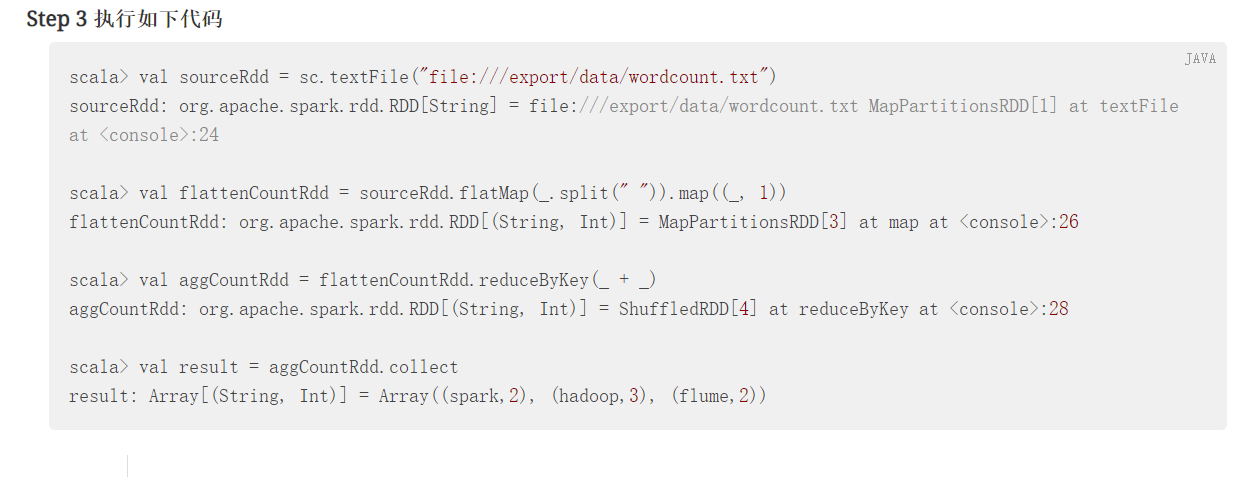

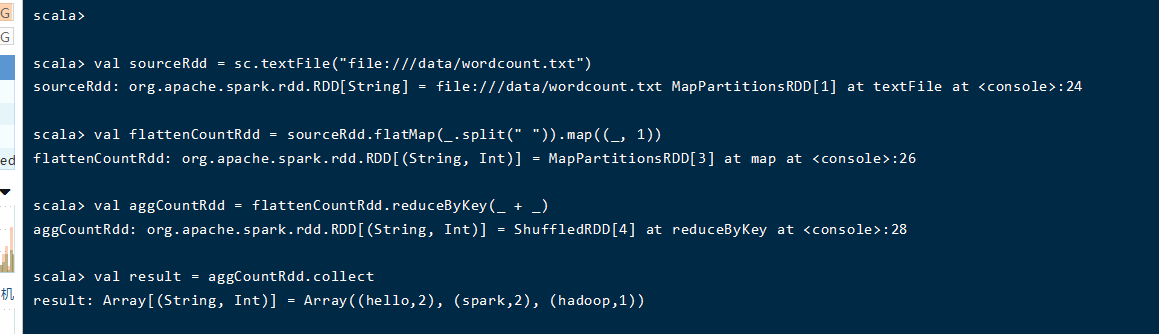

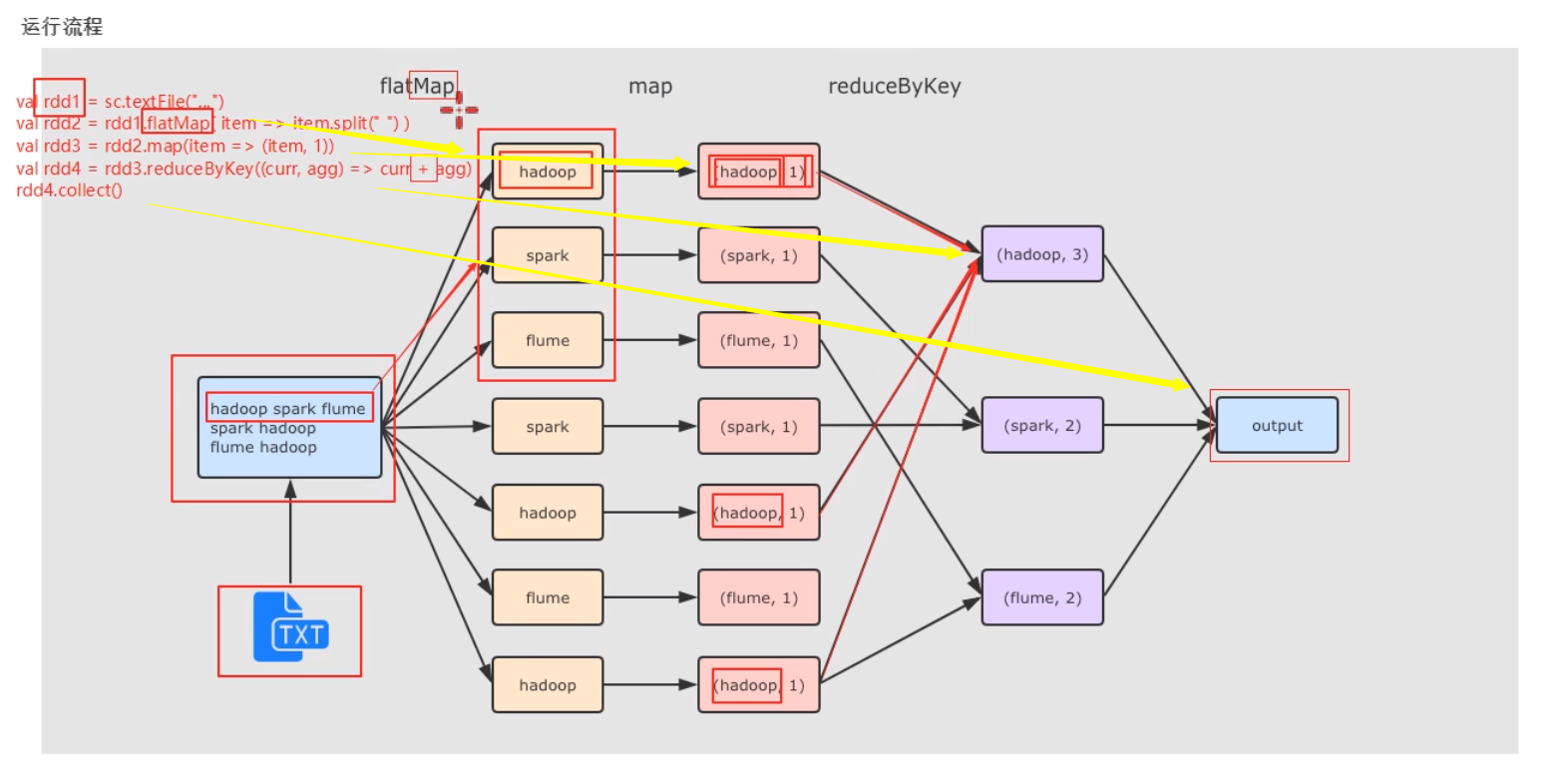

1.1读取本地文件

步骤一:

步骤二:

步骤三:

注意事项:

运行的结果如下:

退出scala操作是:

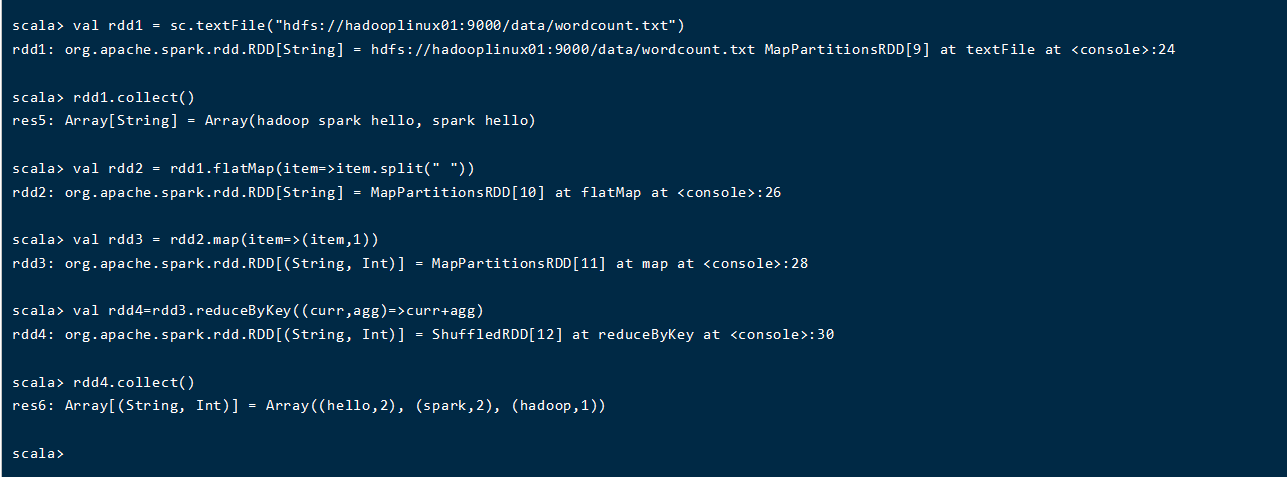

1.2读取hdfs

删除当前文件夹中的文件:

hdfs上创建新的文件夹:

将文件上传到hdfs:

HDFS操作如下: