1.简述人工智能、机器学习和深度学习三者的联系与区别。

答:人工智能学科研究的主要内容包括:知识表示、自动推理和搜索方法、机器学习和知识获取、知识处理系统、自然语言理解、计算机视觉、智能机器人、自动程序设计等方面,它是一个大的概念;机器学习是属于人工智能的一个研究方向,是人工智能的一个研究方法吧;深度学习是机器学习中的一个研究方法,方向;

2. 全连接神经网络与卷积神经网络的联系与区别。

答:在全连接神经网络中,每两层之间的节点都有边相连;卷积神经网络也是通过一层一层的节点组织起来的,对于卷积神经网络,相邻两层之间只有部分节点相连。在卷积神经网络的前几层中,每一层的节点都被组织成一个三维矩阵。前几层中每一个节点只和上一层中部分节点相连;他们的区别在于相邻层连接的方式不一样。

3.理解卷积计算。

以digit0为例,进行手工演算。

from sklearn.datasets import load_digits #小数据集8*8

digits = load_digits()

| 0 | 0 | 5 | 13 | 9 | 1 | 0 | 0 |

| 0 | 0 | 13 | 15 | 10 | 15 | 5 | 0 |

| 0 | 3 | 15 | 2 | 0 | 11 | 8 | 0 |

| 0 | 4 | 12 | 0 | 0 | 8 | 8 | 0 |

| 0 | 5 | 8 | 0 | 0 | 9 | 8 | 0 |

| 0 | 4 | 11 | 0 | 1 | 12 | 7 | 0 |

| 0 | 2 | 14 | 5 | 10 | 12 | 0 | 0 |

| 0 | 0 | 6 | 13 | 10 | 0 | 0 | 0 |

手工演算如下图所示:

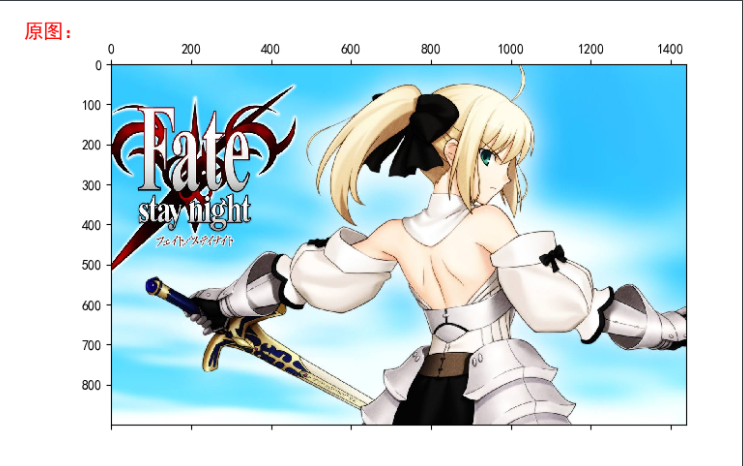

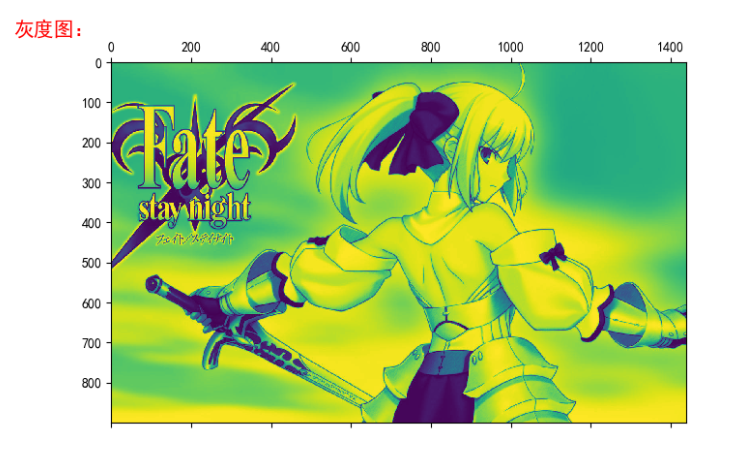

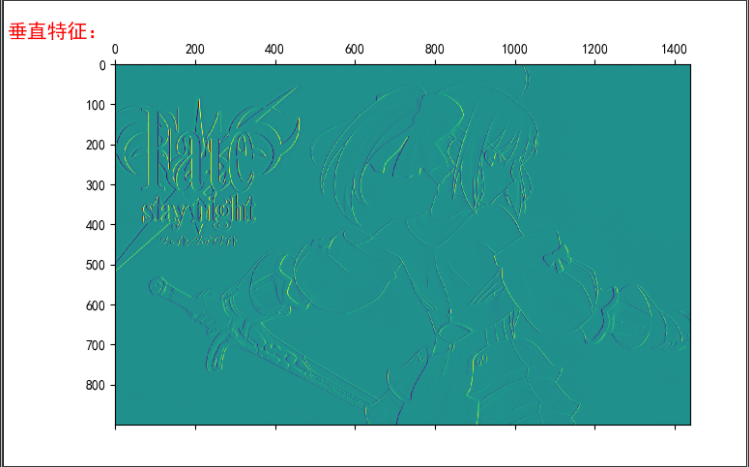

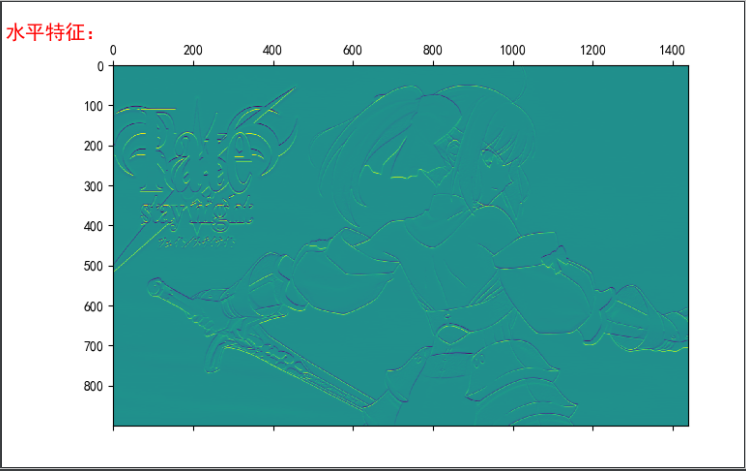

4.理解卷积如何提取图像特征。

读取一个图像;

以下矩阵为卷积核进行卷积操作;

显示卷积之后的图像,观察提取到什么特征。

| 1 | 0 | -1 |

| 1 | 0 | -1 |

| 1 | 0 | -1 |

| 1 | 1 | 1 |

| 0 | 0 | 0 |

| -1 | -1 | -1 |

| -1 | -1 | -1 |

| -1 | 8 | -1 |

| -1 | -1 | -1 |

卷积API

scipy.signal.convolve2d

tf.keras.layers.Conv2D

代码如下:

from PIL import Image import matplotlib.pyplot as plt import numpy as np from scipy.signal import convolve2d I = Image.open(r"C:Users无语saber.jpg") L = I.convert('L') saber = np.array(I) saberg = np.array(L) k1 = np.array([[1, 0, -1], [1, 0, -1], [1, 0, -1]]) k2 = np.array([[1, 1, 1], [0, 0, 0], [-1, -1, -1]]) k3 = np.array([[-1, -1, -1], [-1, 8, -1], [-1, -1, -1]]) saber1 = convolve2d(saberg, k1, boundary='symm', mode='same') # 垂直特征 saber2 = convolve2d(saberg, k2, boundary='symm', mode='same') # 水平特征 saber3 = convolve2d(saberg, k3, boundary='symm', mode='same') # 边缘特征 plt.rcParams['font.sans-serif'] = ['SimHei'] # 中文字体 plt.matshow(saber) plt.title('原图:', fontsize=15, x=-.1 , color='red') plt.show() plt.matshow(saberg) plt.title('灰度图:', fontsize=15, x=-.1 , color='red') plt.show() plt.matshow(saber1) plt.title('垂直特征:', fontsize=15, x=-.1 , color='red') plt.show() plt.matshow(saber2) plt.title('水平特征:', fontsize=15, x=-.1 , color='red') plt.show() plt.matshow(saber3) plt.title('边缘特征:', fontsize=15, x=-.1 , color='red') plt.show()

运行结果图如下:

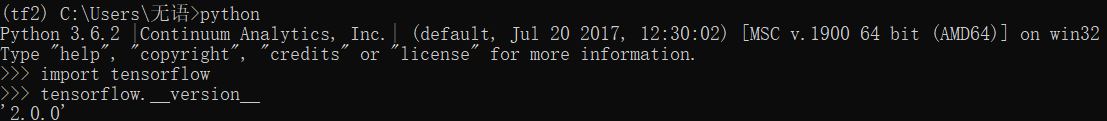

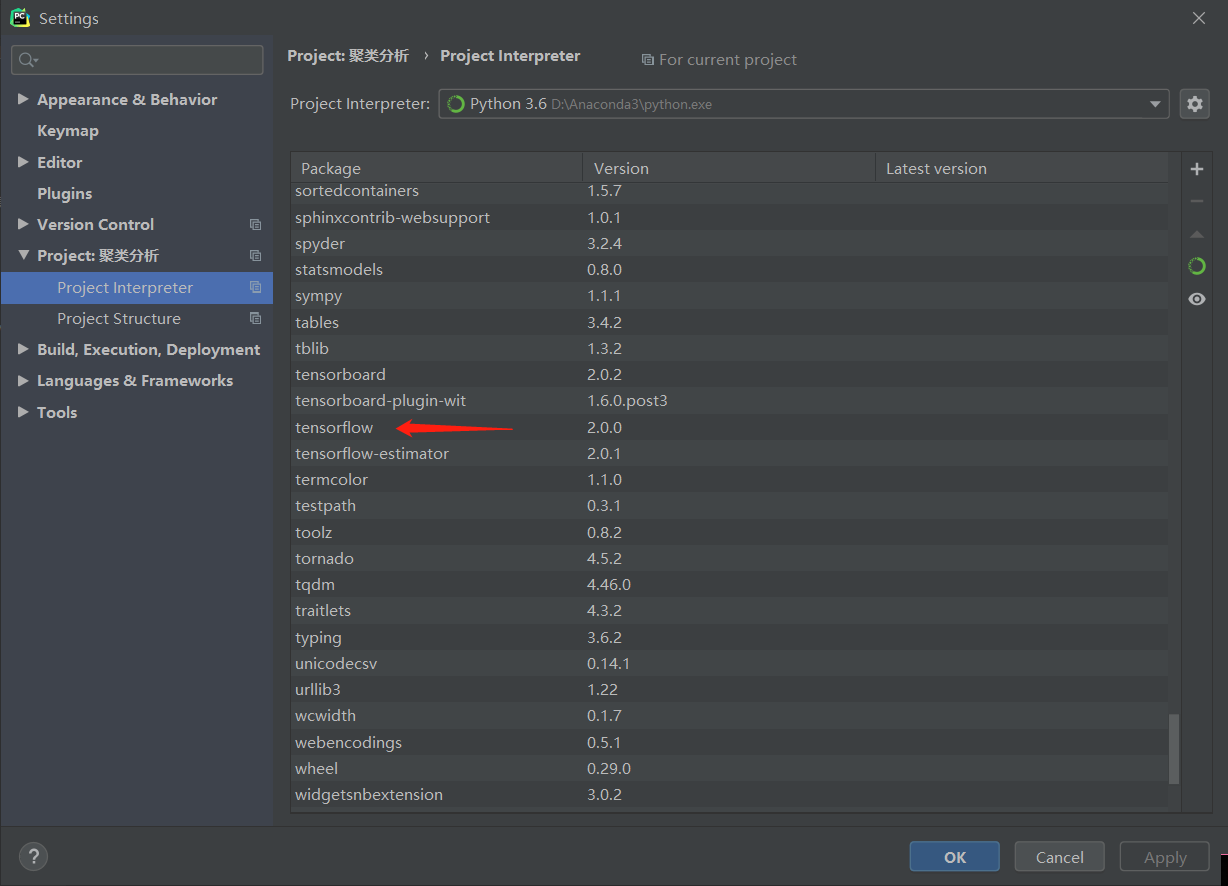

5. 安装Tensorflow,keras

参考:https://blog.csdn.net/u011119817/article/details/88309256

6. 设计手写数字识别模型结构,注意数据维度的变化。

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Dense, Flatten, Conv2D, MaxPool2D

model = tf.keras.Sequential()

model.add(Conv2D(…))

model.add(MaxPool2D(…))

...

#可以上传手动演算的每层数据结构的变化过程。model.summary()

代码如下:

# 导入相关包 from tensorflow.keras.models import Sequential from tensorflow.keras.layers import Dense, Dropout, Flatten, Conv2D, MaxPool2D # 建立模型 model = Sequential() # 一层卷积 model.add( Conv2D( filters=16, kernel_size=(5, 5), padding='same', input_shape=(28, 28, 1), activation='relu')) # 池化层1 model.add(MaxPool2D(pool_size=(2, 2))) # 二层卷积 model.add( Conv2D( filters=32, kernel_size=(5, 5), padding='same', activation='relu')) # 池化层2 model.add(MaxPool2D(pool_size=(2, 2))) model.add(Dropout(0.25)) # 三层卷积 model.add( Conv2D( filters=64, kernel_size=(5, 5), padding='same', activation='relu')) model.add(Flatten()) # 平坦层 model.add(Dense(128, activation='relu')) # 全连接层 model.add(Dropout(0.25)) model.add(Dense(10, activation='softmax')) # 激活函数 model.summary()

运行结果图如下:

参考:

https://www.jianshu.com/p/afe485aa08ce

https://blog.csdn.net/junjun150013652/article/details/82217571