Bounding-Box regression

最近一直看检测有关的paper,从rcnn,fast rcnn, faster rcnn, yolo, r-fcn, ssd,到今年cvpr最新的yolo9000.这些paper中损失函数都包含了边框回归,除了rcnn详细介绍了,其他的paper都是一笔带过,或者直接引用rcnn就把损失函数写出来了。前三条网上解释的比较多,后面的两条我看了很多paper,才得出这些结论。

- 为什么要边框回归?

- 什么是边框回归?

- 边框回归怎么做的?

- 边框回归为什么宽高,坐标会设计这种形式?

- 为什么边框回归只能微调,在离Ground Truth近的时候才能生效?

为什么要边框回归?

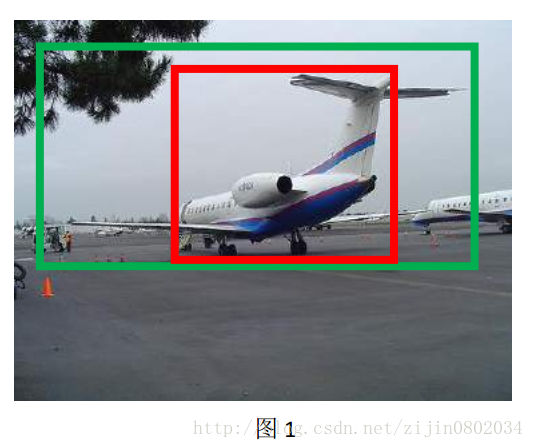

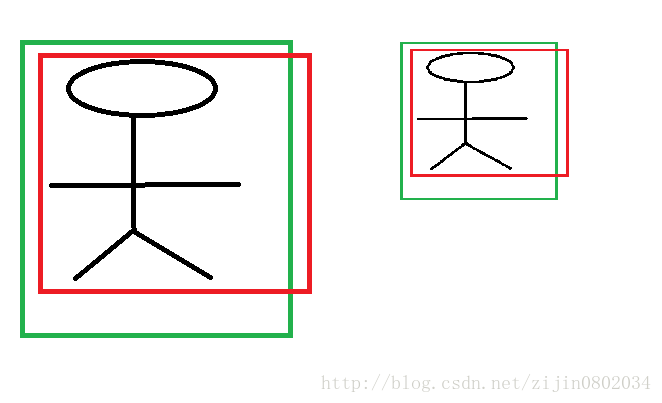

这里引用王斌师兄的理解,如下图所示:

对于上图,绿色的框代表Ground Truth,红色的框为Selective Search提取的Region Proposal。那么即便红色的框被分类器识别为飞机,但是由于红色的框定位不准(IoU<0.5),那么这张图相当于没有正确的检测出飞机。如果我们能对红色的框进行微调,使得经过微调后的窗口跟Ground Truth更接近,这样岂不是定位会更准确。确实,Bounding-Box regression就是用来微调这个窗口的。

边框回归是什么?

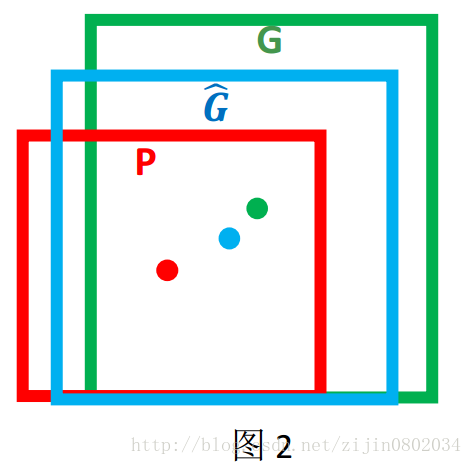

继续接用师兄的理解:对于窗口一般使用四维向量$(x, y, w, h)$来表示,分别表示窗口的中心点坐标和宽高。对于图2,红色的框P代表原始的Proposal,绿色的框G代表目标的Ground Truth,我们的目标是寻找一种关系使得输入原始的窗口P经过映射得到一个跟真实窗口G更接近的回归窗口$hat{G}$

边框回归的目的即是:给定$(P_x, P_y, P_w, P_h)$寻找一种映射$f$,使得$f(P_x, P_y, P_w, P_h) = (hat{G}_x, hat{G}_y, hat{G}_w, hat{G}_h)$并且$(hat{G}_x, hat{G}_y, hat{G}_w, hat{G}_h) approx (G_x, G_y, G_w, G_h)$

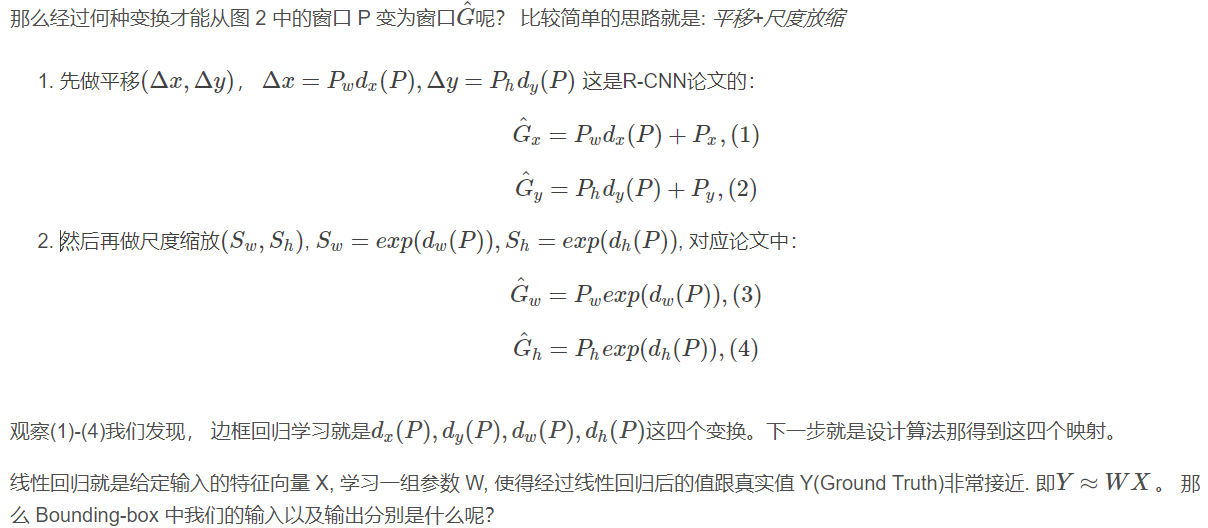

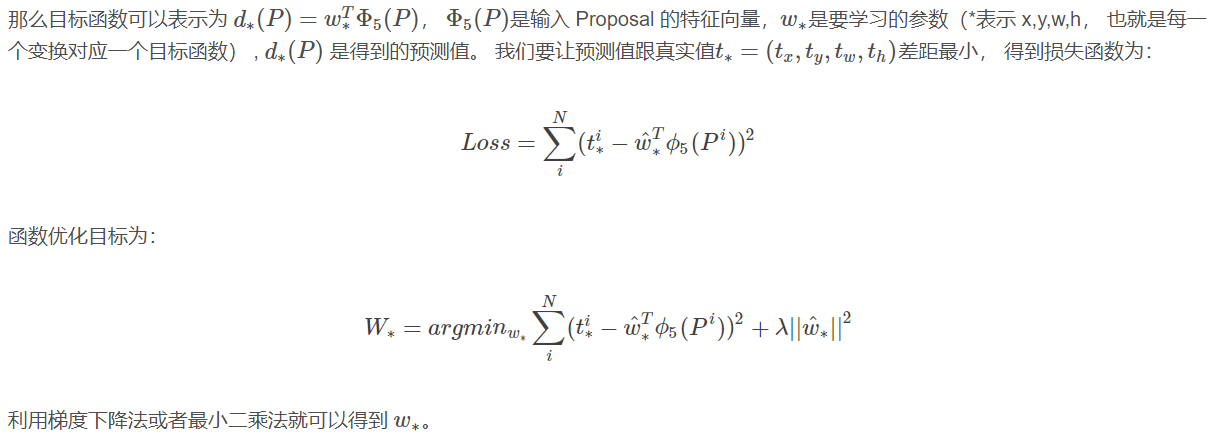

边框回归怎么做的?

为什么宽高尺度会设计这种形式?

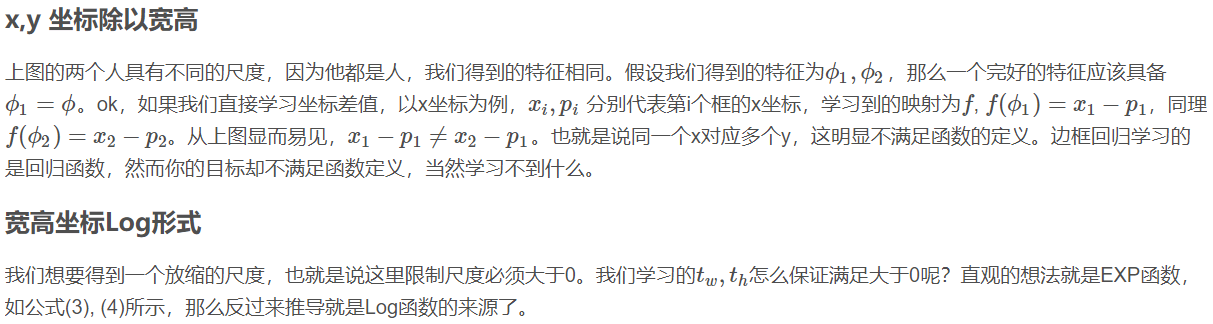

这边我重点解释以下为什么设计的$t_x, t_y$为什么除以宽高,为什么$t_w, t_h$会有log形式!!!

首先CNN具有尺度不变性,以图3为例

转自:https://blog.csdn.net/zijin0802034/article/details/77685438