第一章基本概念

1.1什么是模式识别

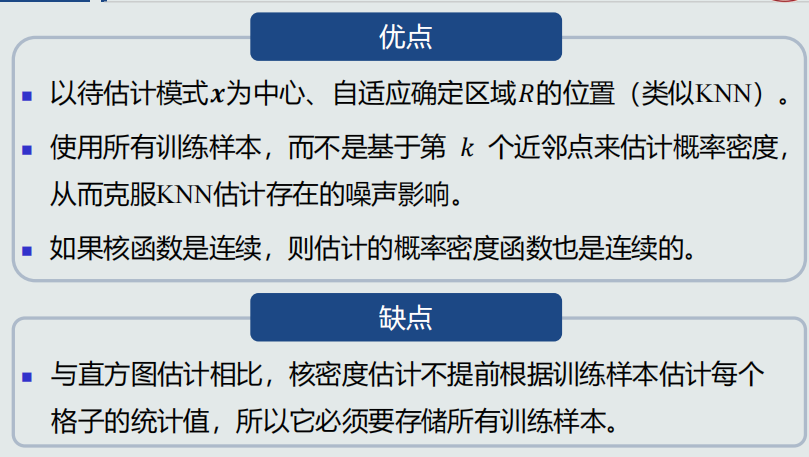

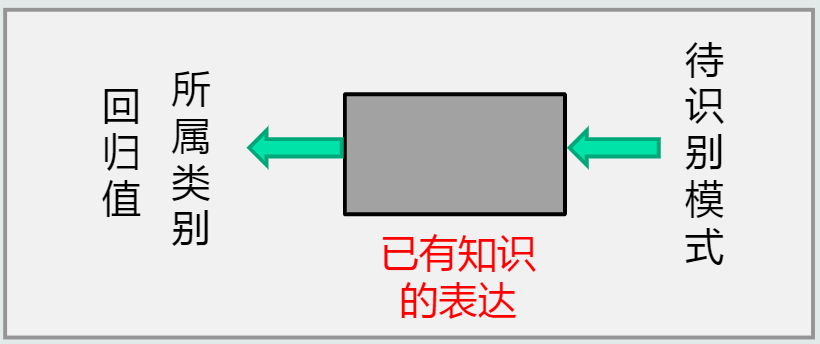

1.定义:根据已有知识的表达,针对待识别模式,判别决策其所属类别或者预测其对应的回归值。

2.应用领域:计算机视觉,人机交互,医学,网络,金融,机器人,无人车。

1.2模式识别数学表达

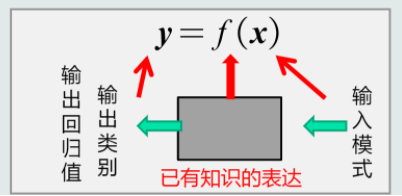

1.数学解释:看成一种函数映射f(x),将待识别模式x从输入空间映射到输出空间,f(x)是关于已有知识的表达。

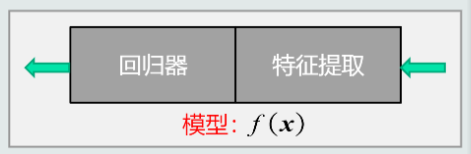

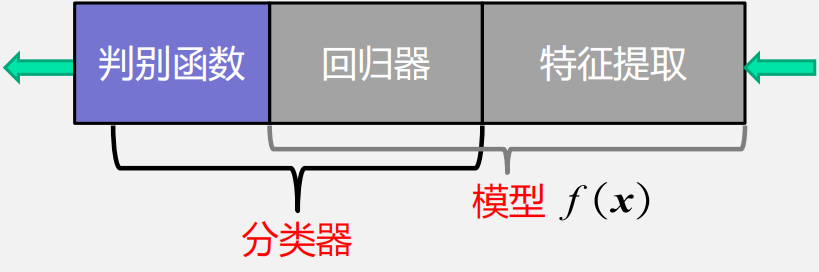

2.模型:关于已有知识的一种表达方式,即函数f(x)。模型可用于回归和分类。

- 回归:特征提取+回归器

- 分类:

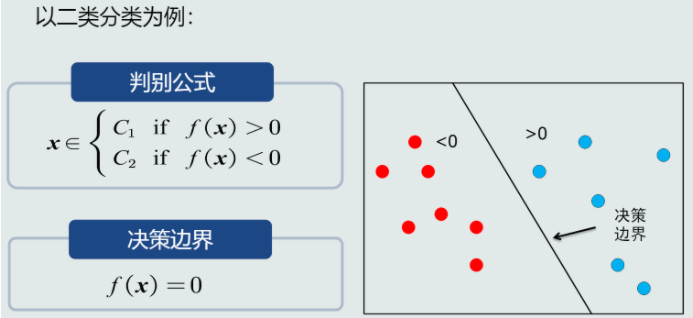

其中,判别函数使用一些特定的非线性函数实现,分为:

- 二类分类:sign函数(判断回归值>0还是<0)。

- 多类分类:max函数(取最大的回归值所在维度对应的类别)。

3.特征:可以用于区分不同类别模式的、可测量的量。

- 特征特性:特征要具有辨别能力、鲁棒性。

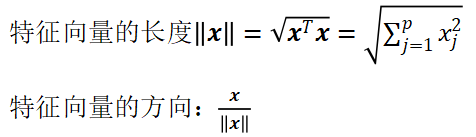

- 特征向量:多个特征构成的(列)向量,可以表达为模长x方向。

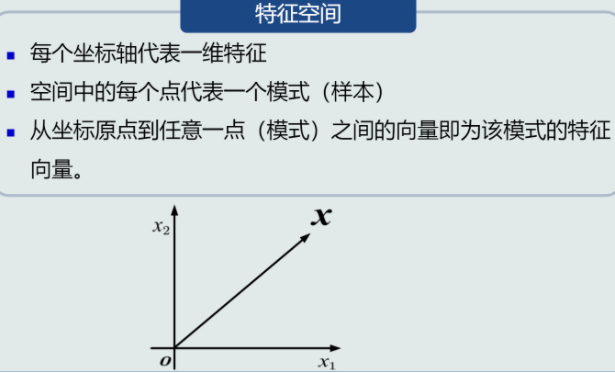

- 特征空间:

1.3特征向量的相关性

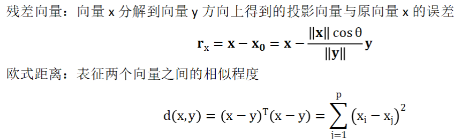

- 特征向量点积(标量、对称、线性变化) VS 特征向量投影:x0=∥x∥cosθ (不具有对称性)。

- 残差向量

- 特征向量的欧式距离

1.4机器学习基本概念

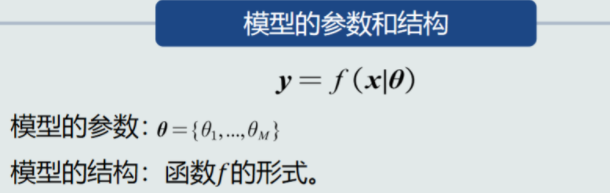

1.模型使用机器学习技术来得到,那么怎样进行机器学习?

1)可理解为“用一组训练样本(数据)学习模型的参数和结构”(利用训练样本,定义目标函数,使用优化算法来解出一组最优参数作为模式识别的模型)。

训练样本可认为是尚未加工的原始知识,模型则是经过学习后的真正知识表达。

线性模型(直线、面、超平面):y=w^Tx+w0 适用于线性可分的数据。

非线性模型:多项式,神经网络,决策树。

2)训练样本个数N与模型参数M的关系

N=M唯一的解;

N>>M没有准确的解(Over-determined);

N<<M无数个解/无解(Under-determined)。

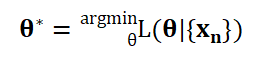

3)目标函数:(对于Over-determined情况)通过优化该标准来确定一个近似解。(对于Under-determined情况)加入对于参数解的约束条件,从无数个解中选最优解。

优化算法:最小化或最大化目标函数的技术。

4)机器学习流程示意图:

2.机器学习方式:监督式学习、无监督式学习、半监督式学习、强化学习。

模型怎么学?

1.5模型的泛化能力

- 训练集:集合中的每个样本称作训练样本。

- 测试集:集合中的测试样本。

训练集训练模型,测试集评估模型。 - 训练误差:模型在训练集上的误差。

- 测试(泛化)误差:模型在测试集上的误差。它反映了模型的泛化能力。

- 泛化能力:训练得到的模型不仅要对训练样本具有决策能力,也要对新的(训练过程中未看见)的模式具有决策能力。

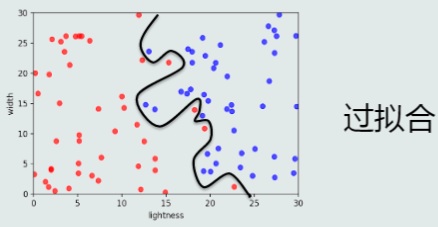

- 泛化能力低:过拟合:训练阶段表现好,测试阶段表现差。

提高方法:(1)选择复杂度适合的模型(2)正则化(在目标函数中加入正则项实现)

1.6评估方法与性能指标

1.评估方法:留出法、K折交叉验证、留一验证(缺点:计算开销大 优点:确定性、适用于小样本)

2.性能指标:

- 准确度(Accuracy)、精度(Precision)、召唤率(Recall)

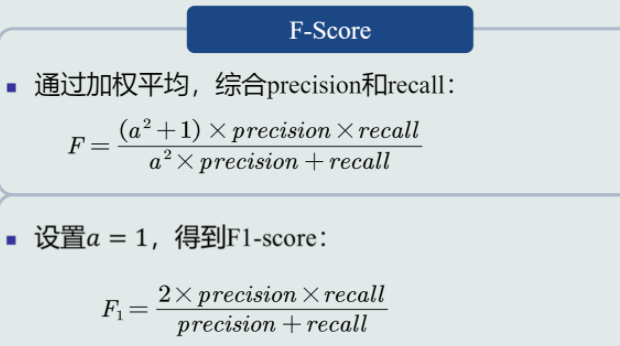

- F-Score、F1-Score

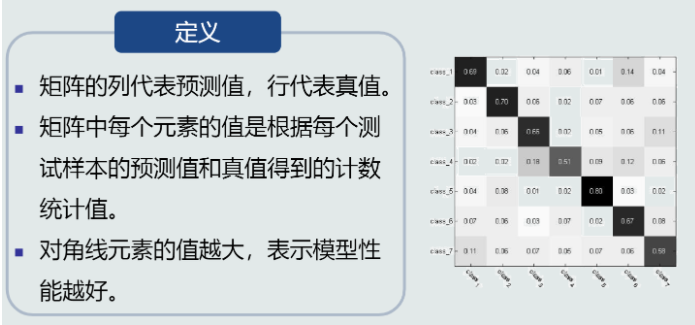

- 混淆矩阵

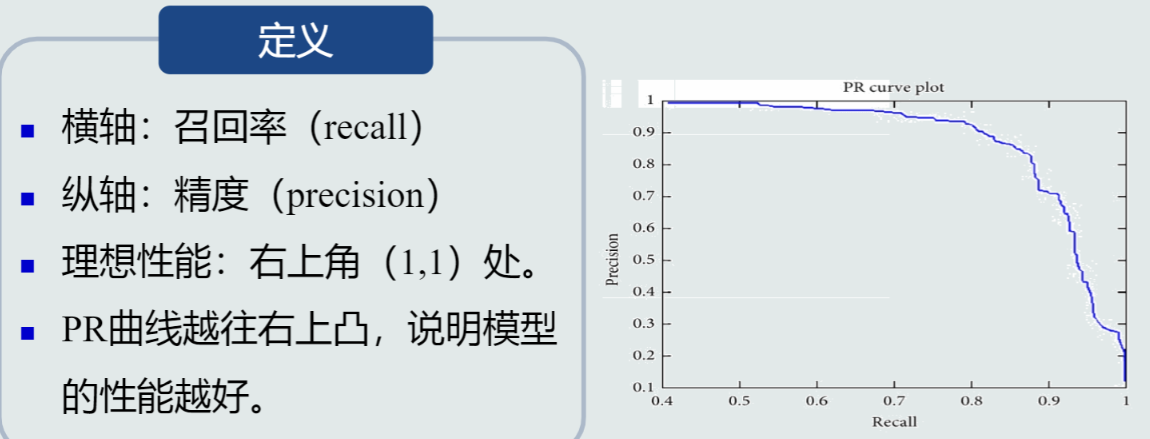

- PR曲线

- ROC曲线

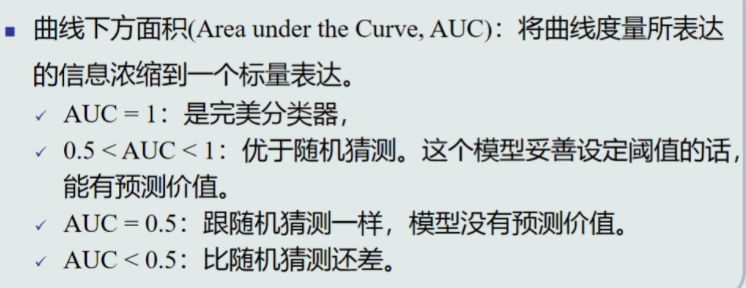

- AUC曲线

第二章基于距离的分类器

2.1 MED分类器——最小欧式距离分类器 (类的原型是均值,衡量的距离为欧式距离)

1.基于距离的决策:把测试样本到每个类之间的距离作为决策模型,将测试样本判定为与其最近的类。

2.原型的种类:均值——将该类中所有训练样本的均值作为类的原型。

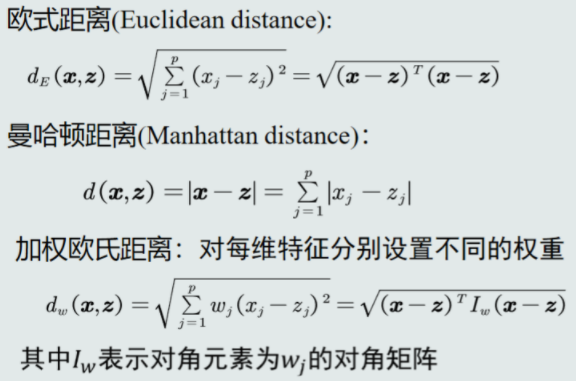

3.距离的种类:欧式距离,曼哈顿距离,加权欧式距离。

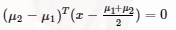

4.MED分类决策边界方程:

5.存在的问题:MED分类器采用欧氏距离作为距离度量,没有考虑特征变化的不同及特征之间的相关性。 ———解决方法:特征白化

2.2特征白化

1.特征白化的目的: 将原始特征映射到一个新的特征空间,使得在新空间中特征的协方差矩阵为单位矩阵,从而去除特征变化的不同及特征之间的相关性。

2.步骤

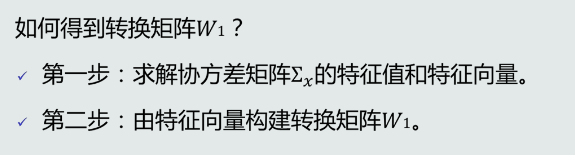

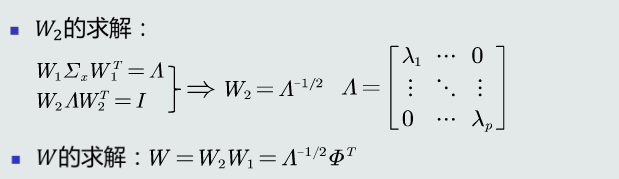

(1)解耦:通过W1实现协方差矩阵对角化,去除特征之间的相关性。

(2)白化:通过W2对上一步变换后的特征再进行尺度变换,实现所有特征具有相同方差。

W1起到旋转的作用

W转换后的欧式距离发生改变,变成马氏距离

2.3MICD分类器——最小类内部距离分类器 (类的原型是均值,衡量的距离为马氏距离)

1.在MED分类器的基础上经过特征白化而得,优点是不受量纲的影响。

2.存在的问题: 当两个类均值一样时,偏向于方差大的类。事实上在此种情况,决策真值应该是倾向于方差小(分布紧致)的类。

3.补充:

- 马氏距离是非奇异、线性变换不变的。

- 欧式距离具有平移不变性、旋转不变性。

- 马氏距离具有平移不变性、旋转不变性、尺度缩放不变性、不受量纲影响的特性。

第三章贝叶斯决策与学习

- MED、MICD分类器:基于距离的决策仅考虑了每个类各自观测到的训练样本的分布情况,没有考虑类的分布等先验知识。

- 设计新的决策机制——从概率出发。

3.1贝叶斯决策与MAP分类器

1.后验概率P(Ci|x):(输入模式x、类别输出C):用于分类决策,表达给定模式x属于类Ci的可能性。

2.怎么得到后验概率?基于贝叶斯规则、在已知先验概率和观测概率的情况下:

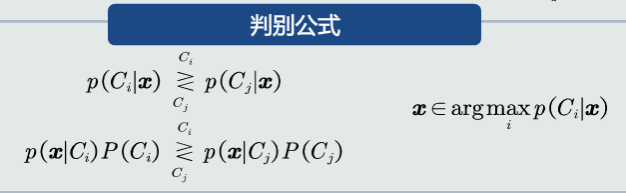

3.MAP分类器:最大后验概率分类器,将测试样本决策分类给后验概率最大的那个类,等于最小化平均概率误差,即最小化决策误差。

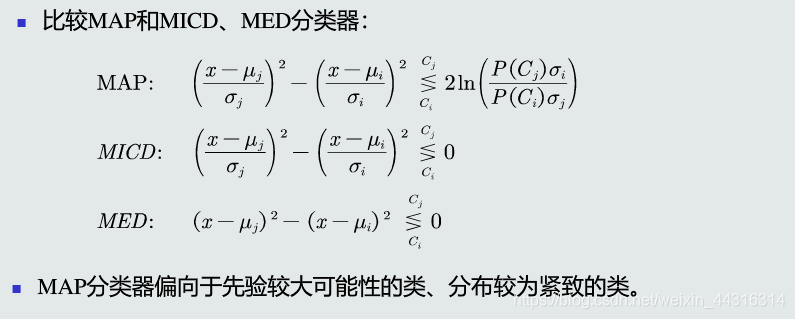

4.判别公式、决策边界(二类分类; 单维空间:通常有两条决策边界,高维空间:复杂的非线性边界)

5.决策误差(一个样本:概率误差=未选择的类对应所对应的后验概率; 全部样本:概率误差的均值)

3.2MAP分类器:高斯观测概率(决策误差最小)

1.表达先验和观测概率的方式

1)常数表达:例如P(Ci)=0.2

2)参数化解析表达:高斯分布...

3)非参数化表达:直方图、核密度、蒙特卡洛...

2.若观测似然概率为一维高斯分布:在方差相同的情况,MAP决策边界偏向先验可能性较小的类,即分类器决策偏向先验概率高的类。方差不同且先验概率相同时,分类器倾向于选择方差较小(紧致)的类。

3.3 决策风险与贝叶斯分类器

贝叶斯决策不能排除出现错误判断的情况,由此会带来决策风险;不同的错误决策会产生程度完全不一样的风险。

1.损失(loss):表征当前决策动作相对于其他候选类别的风险程度。

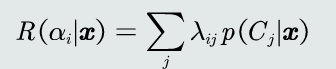

2.决策风险的评估:给定一个测试样本x,分类器决策其属于Ci类的动作αi对应的决策风险可以定义为相对于所有候选类别的期望损失。记为R(αi|x)。

3.贝叶斯分类器:在MAP分类器基础上,加入决策风险因素,得到贝叶斯分类器。贝叶斯分类器选择决策风险最小的类,即最小化期望损失。

4.朴素贝叶斯分类器:当特征是多维的,假设特征之间是相互独立的,从而得到以下公式:

(特征维度太高,通过即假设特征之间符合独立同分布以达到简化计算的目的)

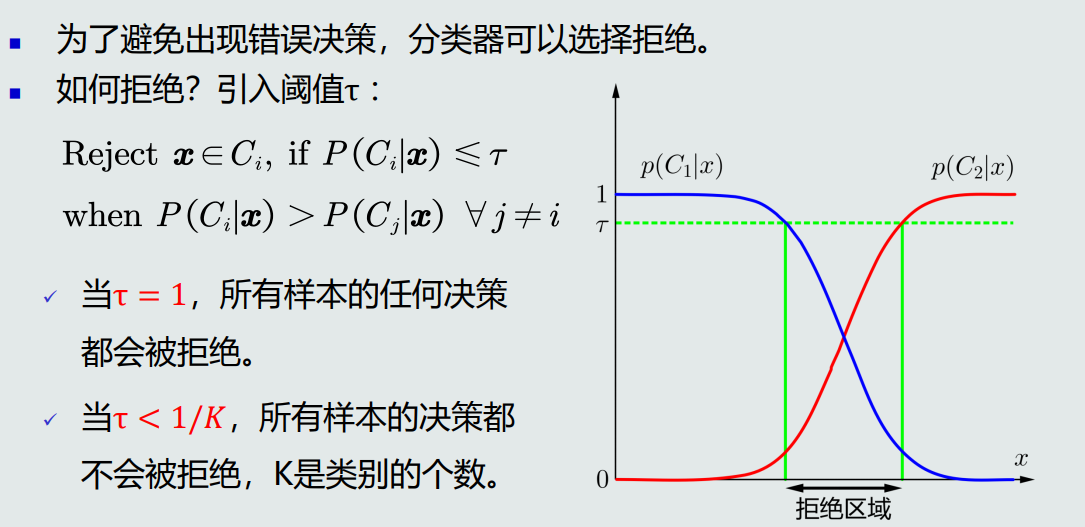

5.拒绝选项:当测试数据在决策边界时,即使选择后验概率高的,该概率的值仍然可能很小。为了避免错误决策,引入阈值,当概率低于阈值时不决策。

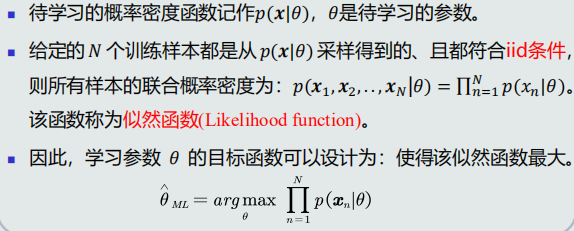

3.4最大似然估计(MLE)

求后验概率要先知先验概率与观测似然概率,先验概率与观测似然概率怎么用最大似然估计思想求解?

1.给定样本,采用监督式学习

- 参数化方法:最大似然估计、贝叶斯估计

- 非参数化方法

2.求解的步骤:

- 根据要求的概率分布写出似然函数;

- 对似然函数取对数;

- 对参数求偏导;

- 解似然方程(取函数导数为0的点)。

结论:(1)先验概率的最大似然估计就是该类训练样本出现的频率。

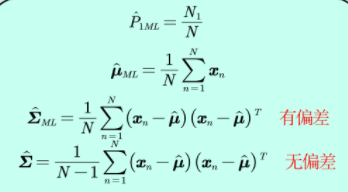

(2)高斯分布均值的最大似然估计等于样本的均值(无偏估计);高斯分布协方差的最大似然估计等于所有训练模式的协方差(有偏估计)。

(3)估计偏差是一个较小的数。当N足够大时,最大似然估计可以看做是一个较好的估计。

3.5最大似然估计的估计偏差

1.无偏估计:如果一个参数的估计量的数学期望是该参数的真值,则该估计量称为无偏估计。

2.高斯分布均值的最大似然估计是无偏的,协方差的最大似然估计不是无偏的。实际计算中通过将训练样本的协方差乘以N/(N-1)来修正协方差的估计值。

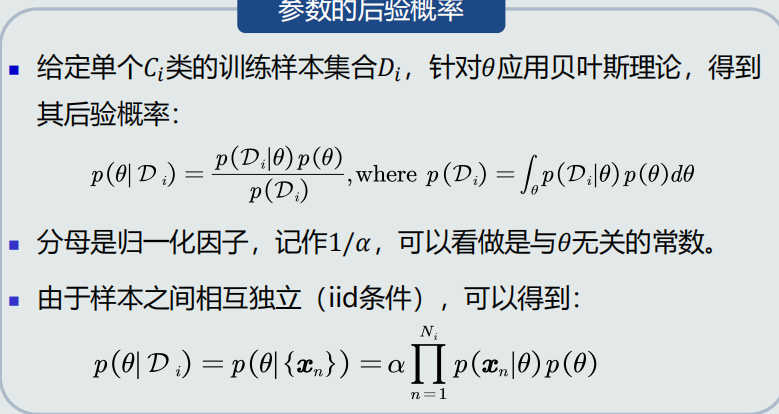

3.6&3.7贝叶斯估计

(如果参数θ不是确定值,给定其先验概率与训练样本,估计θ的后验概率。)

1.贝叶斯估计:给定参数分布的先验概率以及训练样本,估计参数分布的后验概率。

2.贝叶斯估计具有不断学习的能力,随着训练样本的不断增加,可以串行的不断修正参数的估计值,从而达到该参数的期望真值。

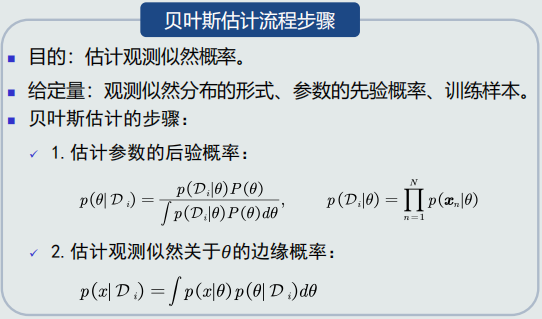

3.贝叶斯估计的目的:估计观测似然概率,给定量为观测似然分布的形式、参数的先验概率、训练样本。

- 1)贝叶斯估计与最大似然估计的对比:贝叶斯估计把参数看作参数空间的一个概率分布,依照训练样本来估计参数的后验概率,从而得到观测似然关于参数的边缘概率,随着样本个数逐渐增大,贝叶斯估计越来越能代表真实的观测似然分布。最大似然估计的参数是确定值,不需要估算参数的边缘概率。

2)贝叶斯估计等是假设概率分布为高斯分布,但如果分布未知,就需要使用无参数估计技术来实现概率密度估计。

3)常用的无参数估计技术:KNN估计、直方图估计、核密度估计,基于p(x)=k/(NV)估计概率密度。

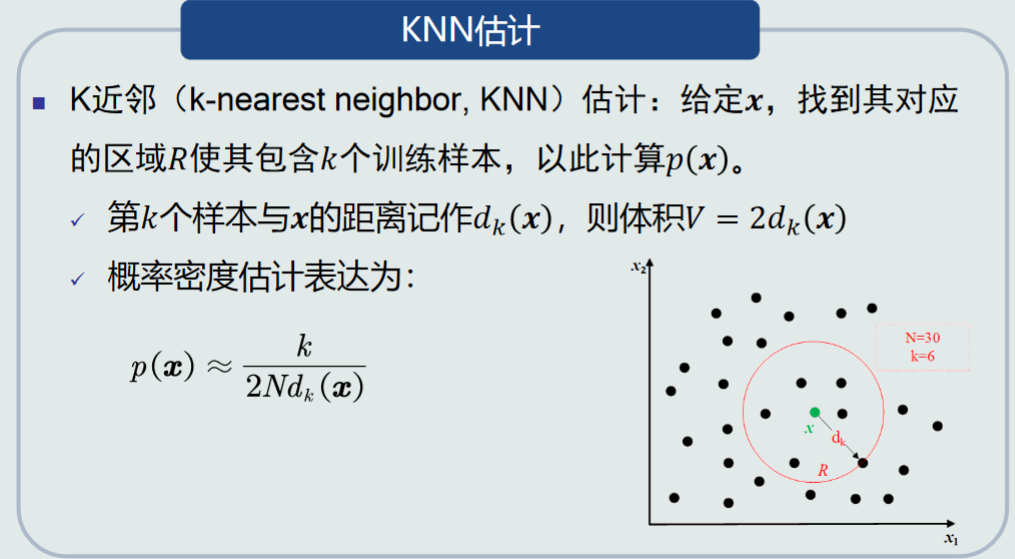

3.8KNN估计

1.原理:p(x)≈k/NV

2.KNN存在的问题:1)在推理测试阶段,仍然需要存储所有训练样本,因为针对任意一个模式x,需要以其为中心,在训练样本中寻找k个相邻点来估计该模式的概率。2)易受噪声影响。

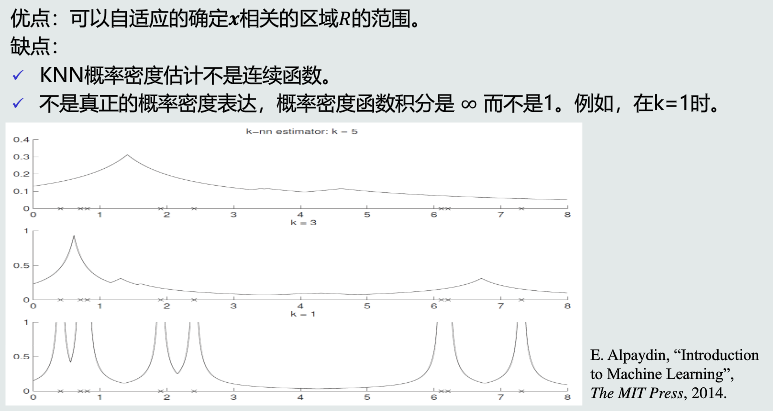

3.优缺点

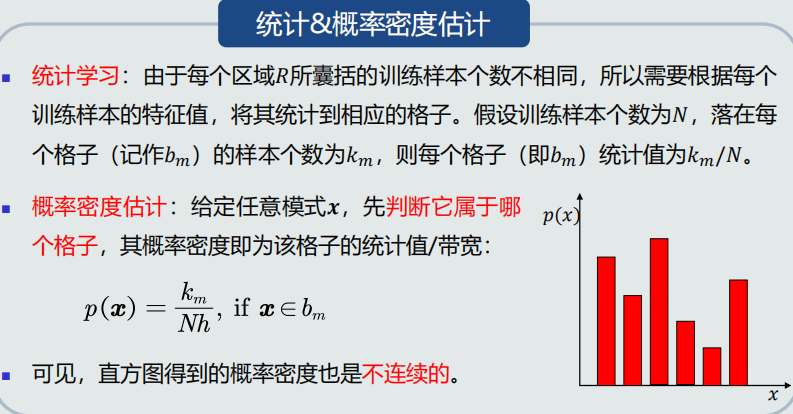

3.9直方图与核密度估计

1.直方图估计

- 原理

- 优缺点

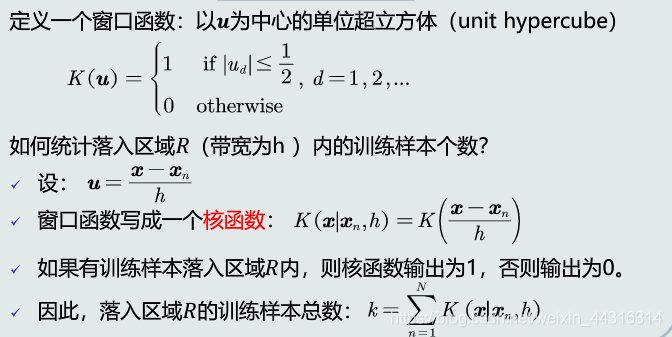

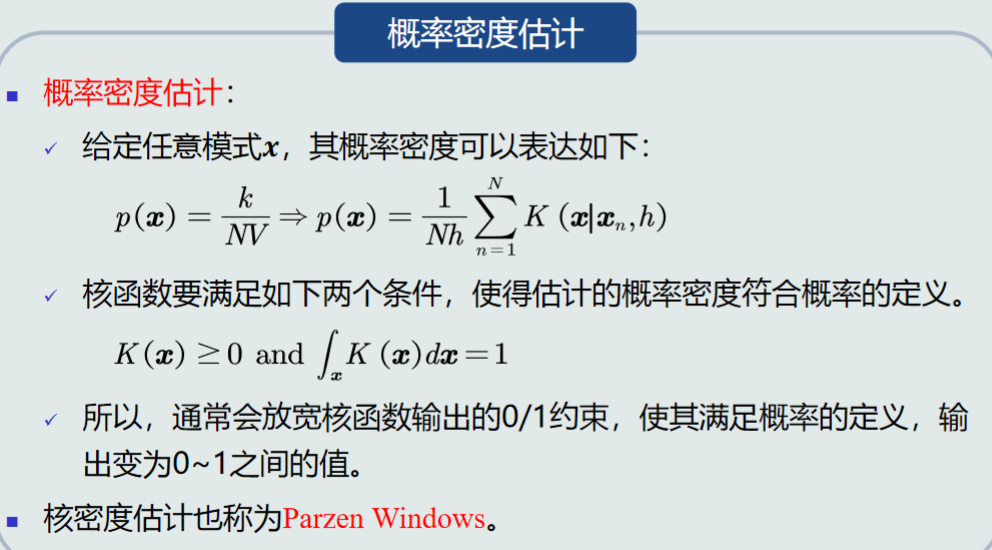

2.核密度估计

- 常用核函数:高斯分布、均匀分布、三角分布。

- 原理

- 优缺点