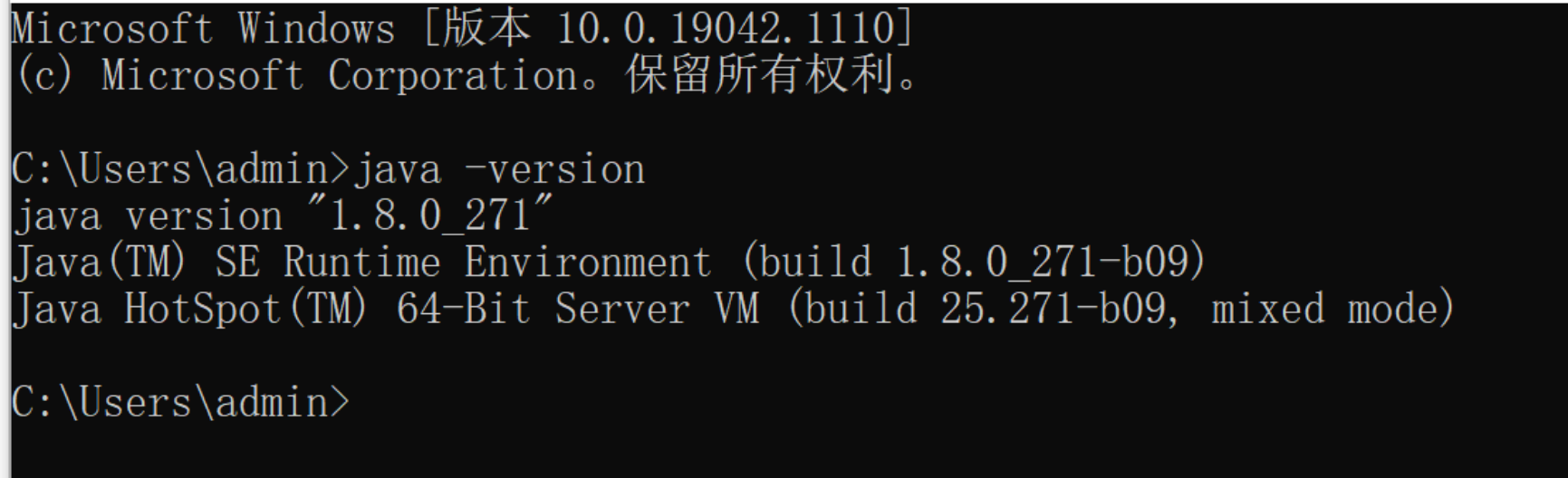

1 安装java

pyspark需要java支持, 首先必须安装java, 至少安装java8,或者更高版本, 推荐java8

安装教程:https://www.runoob.com/java/java-environment-setup.html

记得配置环境变量:java_home

安装成功如下:

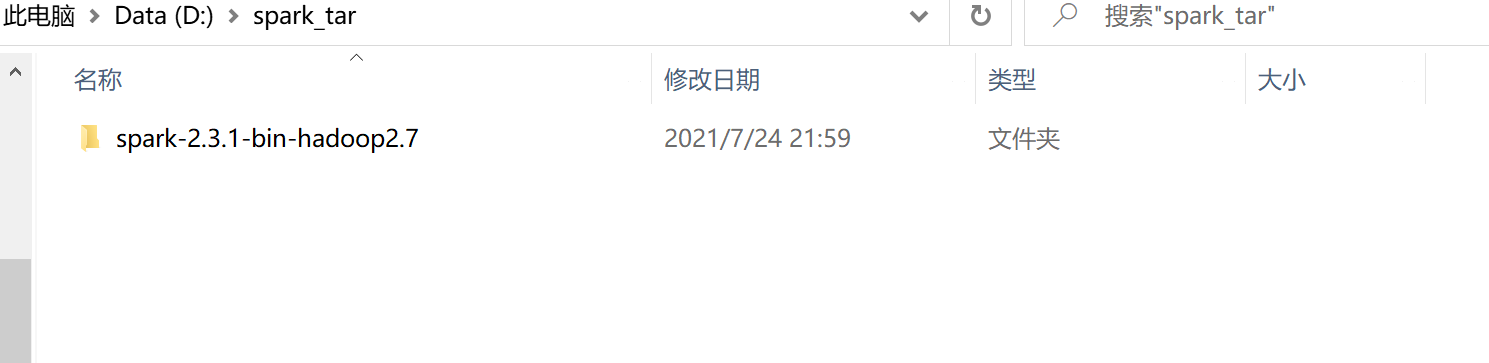

2 下载spark并解压放在一个新的文件夹下

spark官网:https://archive.apache.org/dist/spark/

一定要下载比较老的版本,作者下载的是spark-2.3.1,参考的是国外一个印度小哥的视频,所以下载的和他一样。

j记得配置环境变量:spark_home

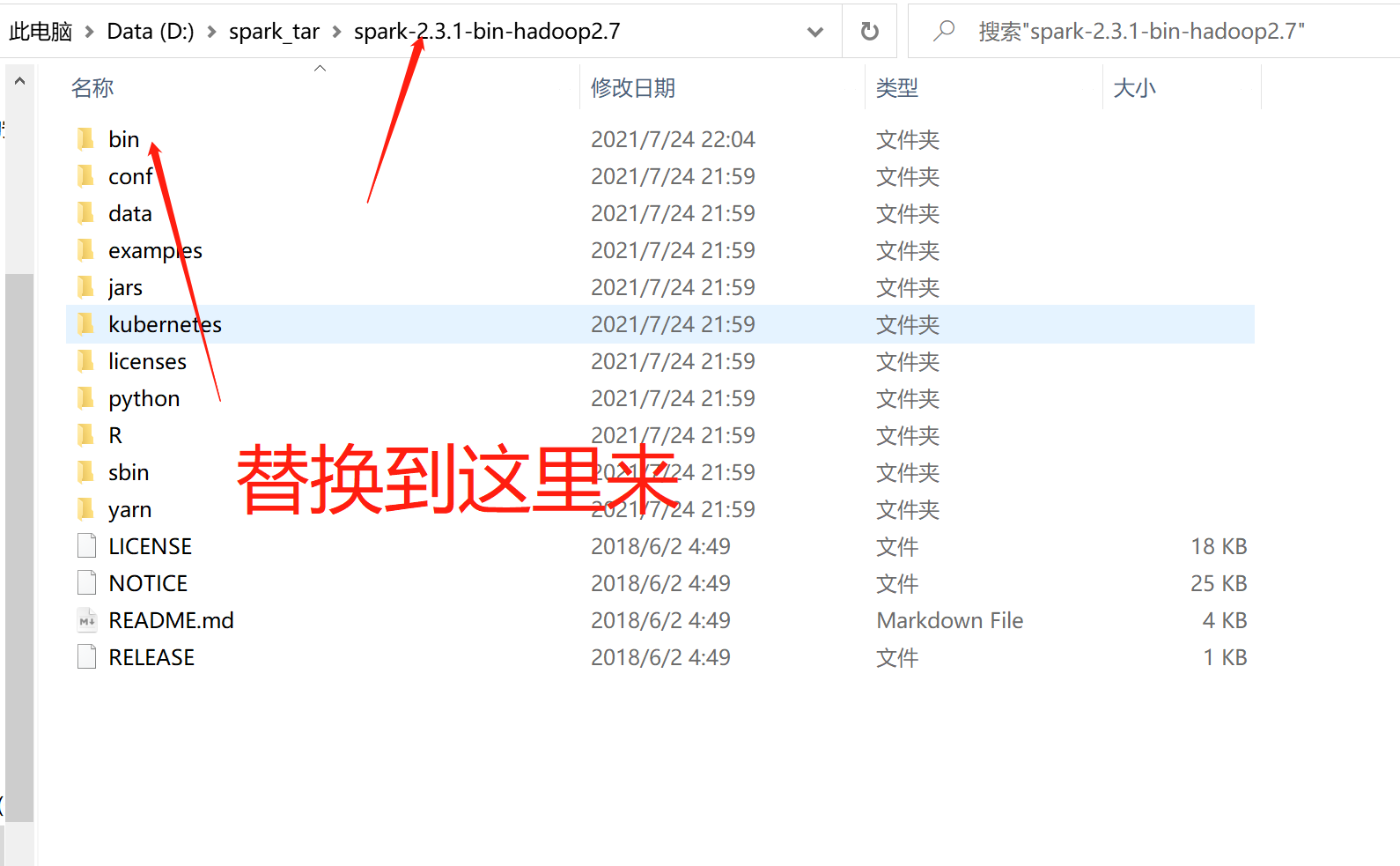

解压出来如下图:

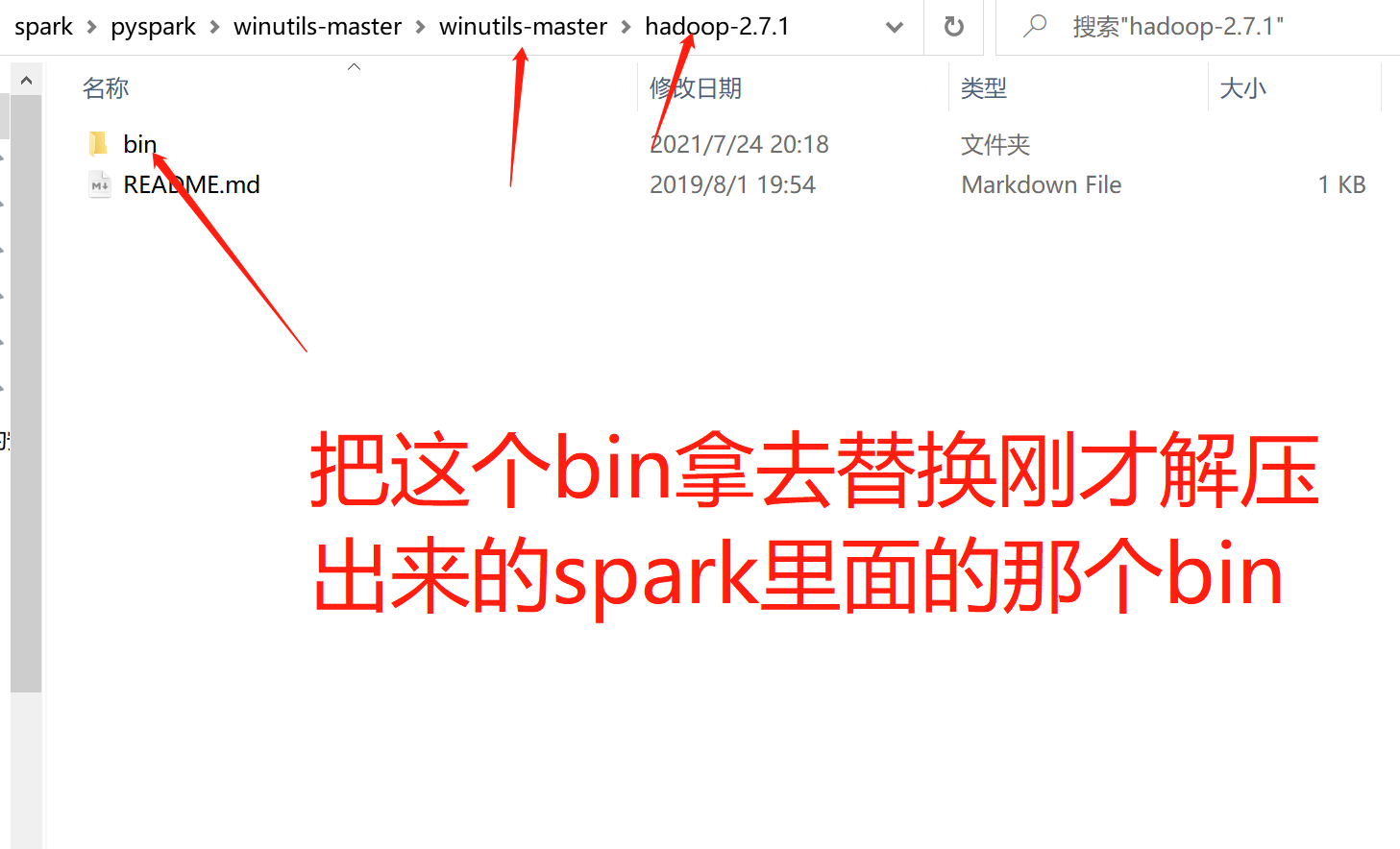

3 winutils安装

windows环境下还需要装个东西来替换掉spark里的bin文件才行

https://github.com/steveloughran/winutils

替换完成后

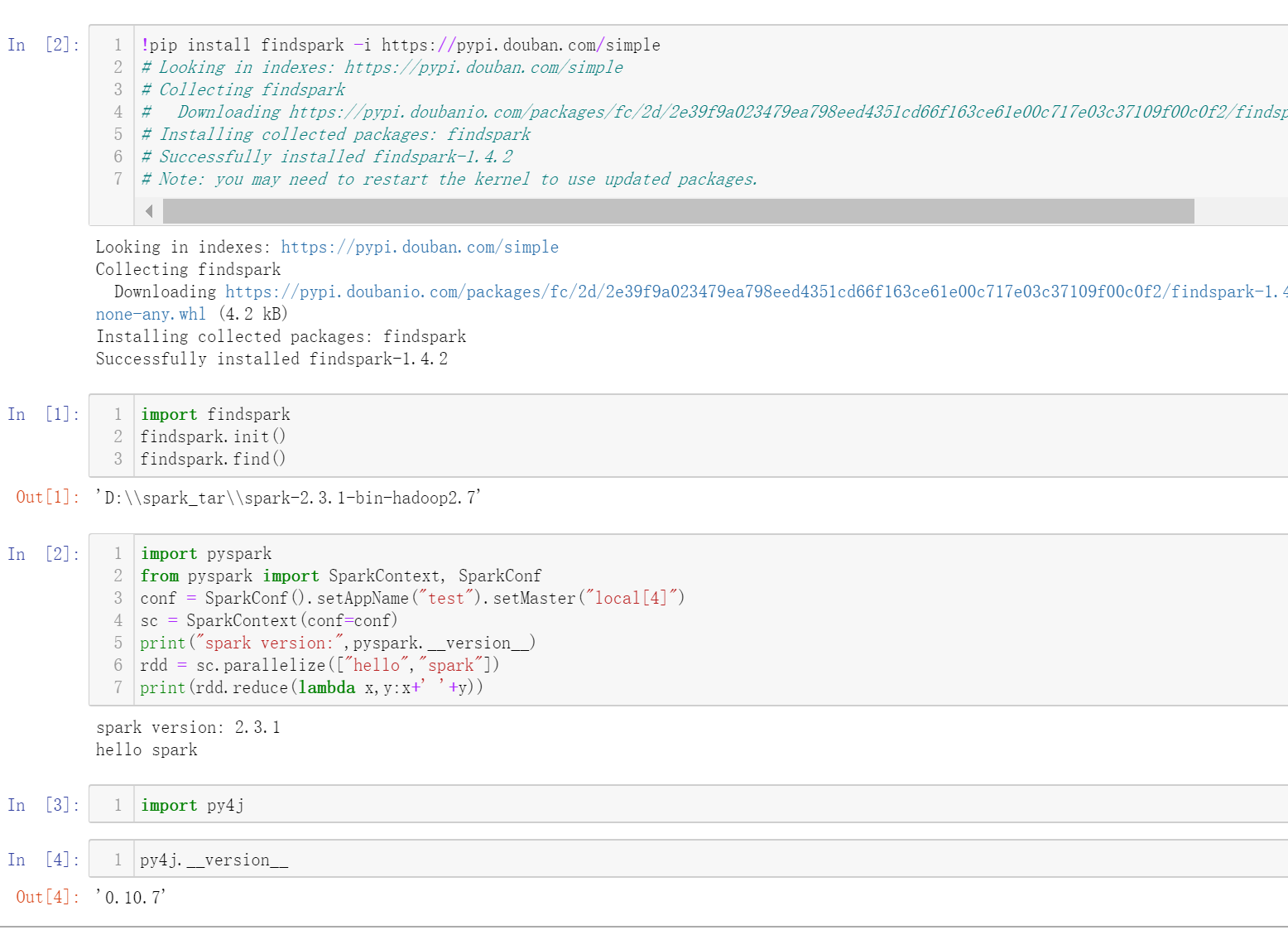

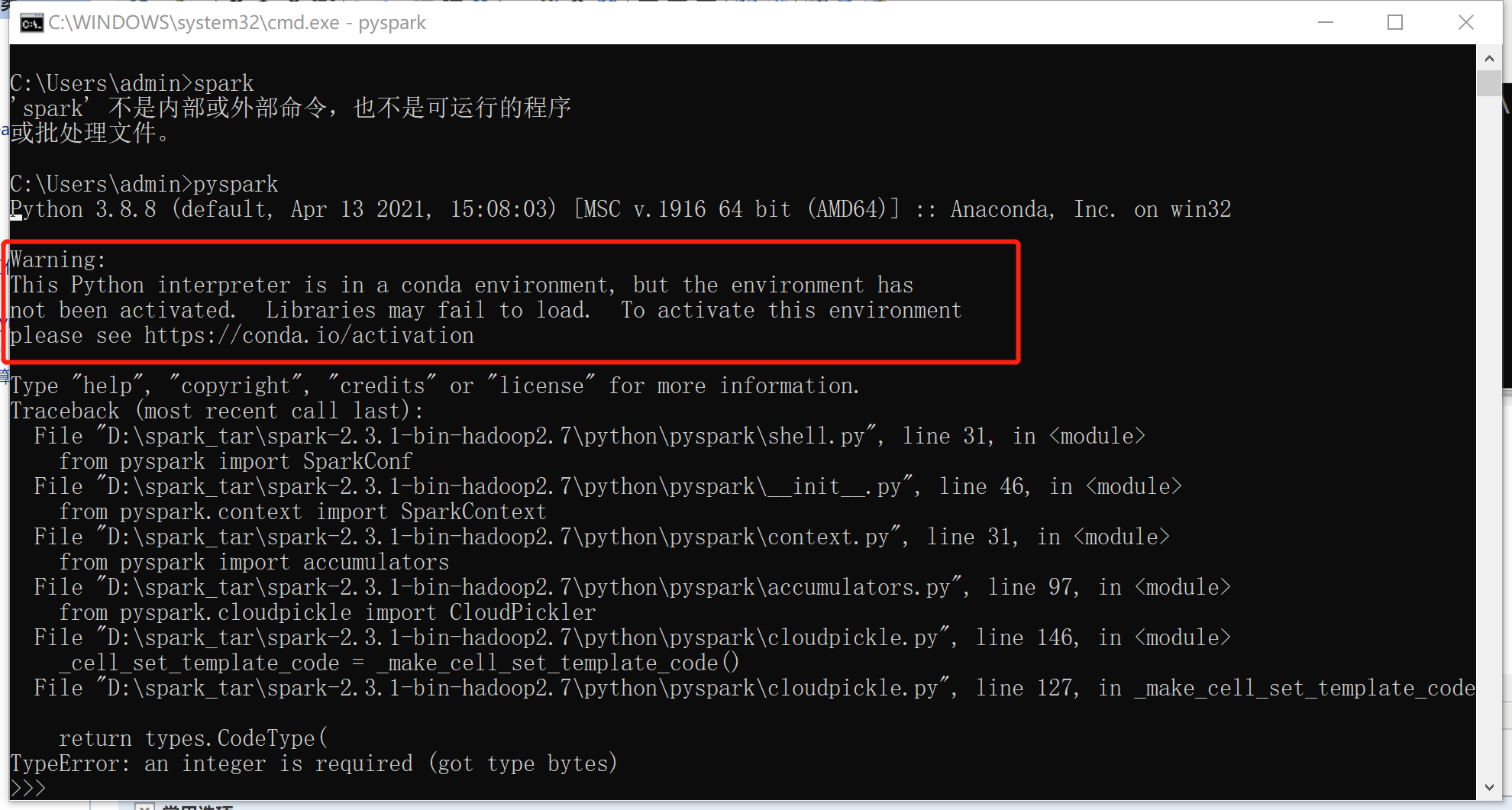

4 第一次检验

cmd pyspark, 如果找不到就说明spark_home环境变量没有配置好。打开如下这种是说python的环境没有激活,

好, 那你现在用anaconda prompt打开, 再试试

这次并没有说未激活, 但是还是报错。按说明用的python的版本过高,spark不支持你目前的python, 比如我这里是python 3.8.8, 版本太高。

想法是降低python版本。

5 创建低python版本的虚拟环境

1 打开anaconda rprompt

2 先更换镜像源, 让后面创建的时候快起来。

conda config --add channels https://mirrors.tuna.tsinghua.edu.cn/anaconda/pkgs/free

conda config --add channels https://mirrors.tuna.tsinghua.edu.cn/anaconda/pkgs/main

conda config --set show_channel_urls yes

用户目录下创建 .condarc 文件,然后把这个文件的 -default删除(针对windows),不然后面又要报错

3 创建虚拟环境

conda create --name pyspark_env python=3.6.9

创建虚拟环境的名字是pyspark_env, python 版本3.6.9, 也是外国的小哥一样。

这里会让选择, 记得敲y. 回车。

4 为这个虚拟环境装其他包

pip install numpy

pip install pandas

pip install matplotlib

pip install seaborn

pip install numpy

pip install warings

pip install scipy

pip install scikit-learn

pip install requests

pip install notebook

pip install jupyterlab

pip install pyarrow

pip install Py4J -i https://pypi.douban.com/simple

pip install pyspark -i https://pypi.douban.com/simple

都可以加上镜像源, 或者用已经换源的conda都行,作者习惯pip。

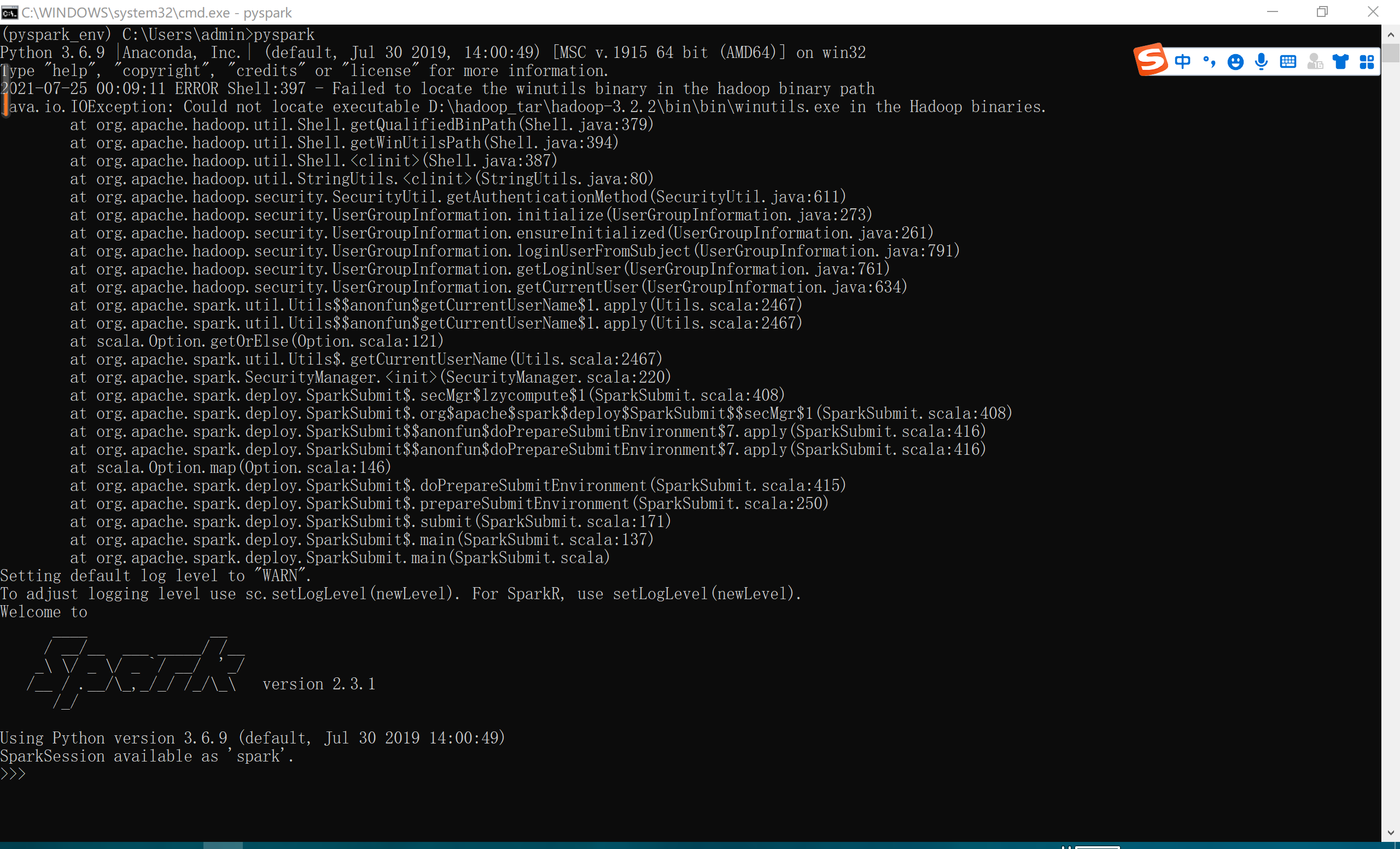

6 进入虚拟环境再进入pyspark

成功。搞一天了,已经凌晨,赶紧记下来,。

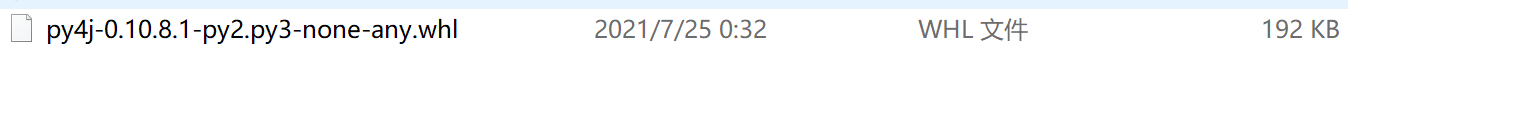

补充:py4j版本有点高, 更换成下面这个版本。

成功