一.前述。

完全分布式基于hadoop集群和Zookeeper集群。所以在搭建之前保证hadoop集群和Zookeeper集群可用。可参考本人博客地址

https://www.cnblogs.com/LHWorldBlog/p/8232935.html搭建hadoop集群

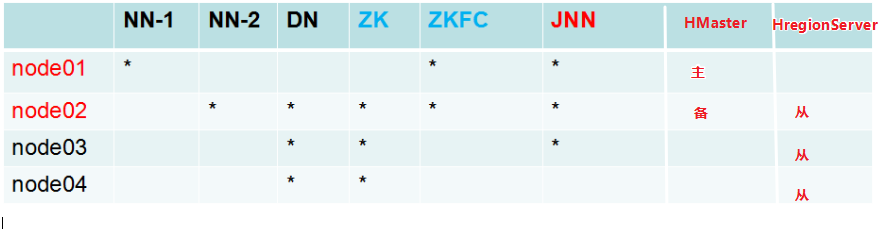

二.集群规划。

说明:因为HMaster主节点和从节点不会自动切换,所以需要互相配置免密,并且配置从主节点到从节点的免密,备节点到从节点的免密。

推荐使用ssh-copy-id 主机名称 即从当前节点免密到其他节点。当不能用时推荐使用如下命令:

ssh-keygen

ssh-copy-id -i ~/.ssh/id_rsa.pub root@node04

三.搭建流程

3.1 时间同步ntpdate(一定要注意时间同步!!!)

yum install ntp -y

ntpdate 时间服务器

3.2 hbase-env.sh配置

JAVA_HOME

HBASE_MANAGES_ZK=false(关闭Hbase本身的zookeeper集群)

3.3 hbase-site.xml配置

<configuration>

<property>

<name>hbase.rootdir</name>

<value>hdfs://mycluster/hbase</value><--在HDFS上创建一个干净的节点,用于存放元数据-->

</property>

<property>

<name>hbase.cluster.distributed</name><--是否开启分布式-->

<value>true</value>

</property>

<property>

<name>hbase.zookeeper.quorum</name><--对应的zookeeper集群,不用加端口-->

<value>node02,node03,node04</value>

</property>

</configuration>

3.4 regionservers配置

node02

node03

node04

3.5 backup-masters配置(注意backup-masters需要手动创建)

node02

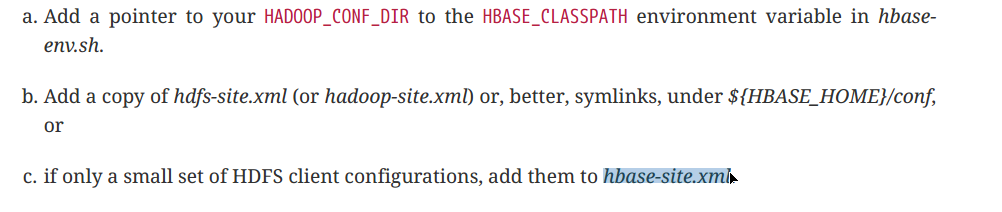

3.6 将hdfs当中的hdfs-site.xml 拷贝hbase的conf目录下(因为存储数据需要在hdfs上)

实际上以上三种方式将Hdfs和Hbase整合,推荐使用拷贝hdfs.xml到hbase的配置目录中。

3.7 配置文件分发

保证集群当中每一台服务器配置文件相同

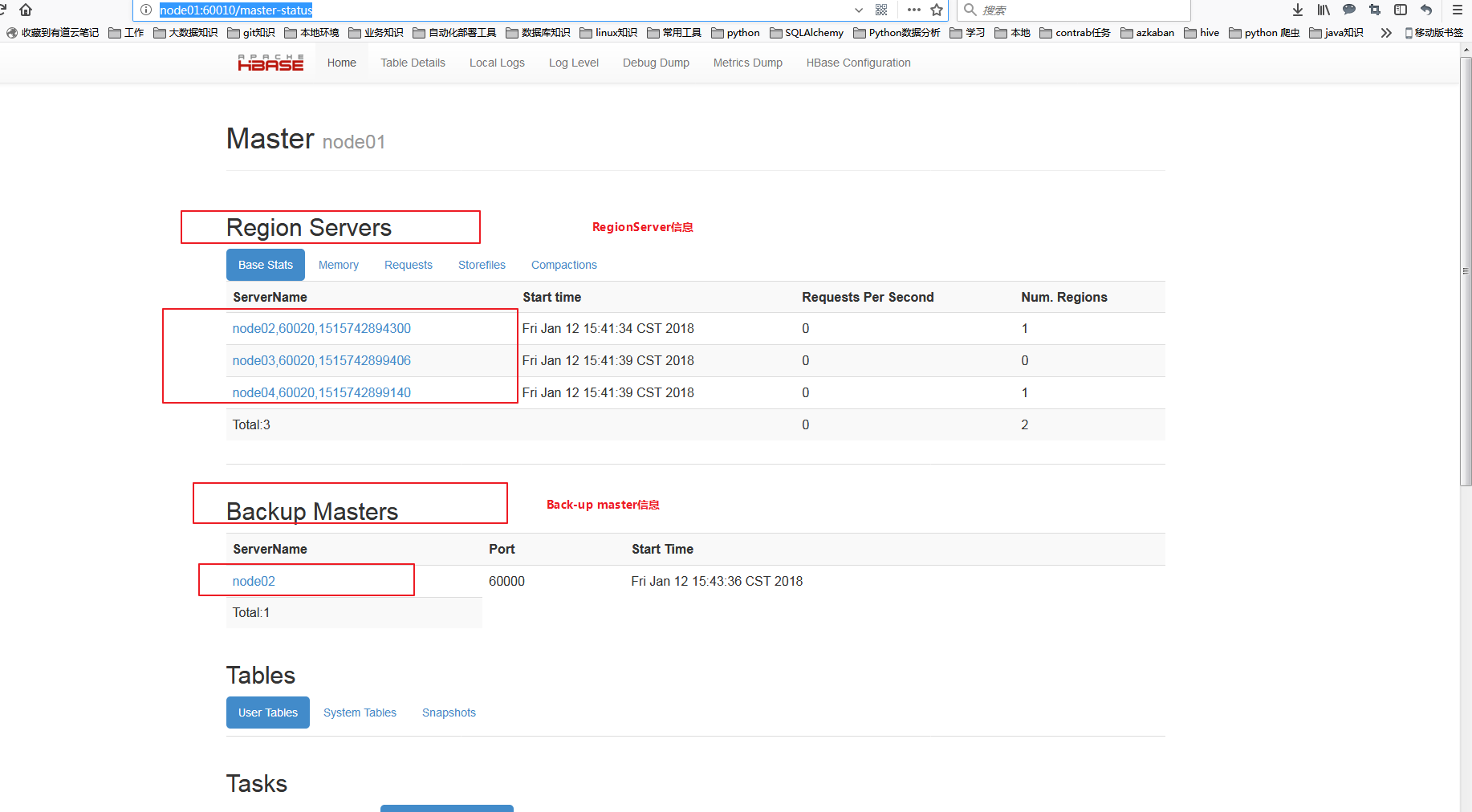

3.7 启动节点

在node01(Master节点) 执行 bin/start-hbase.sh启动主节点。

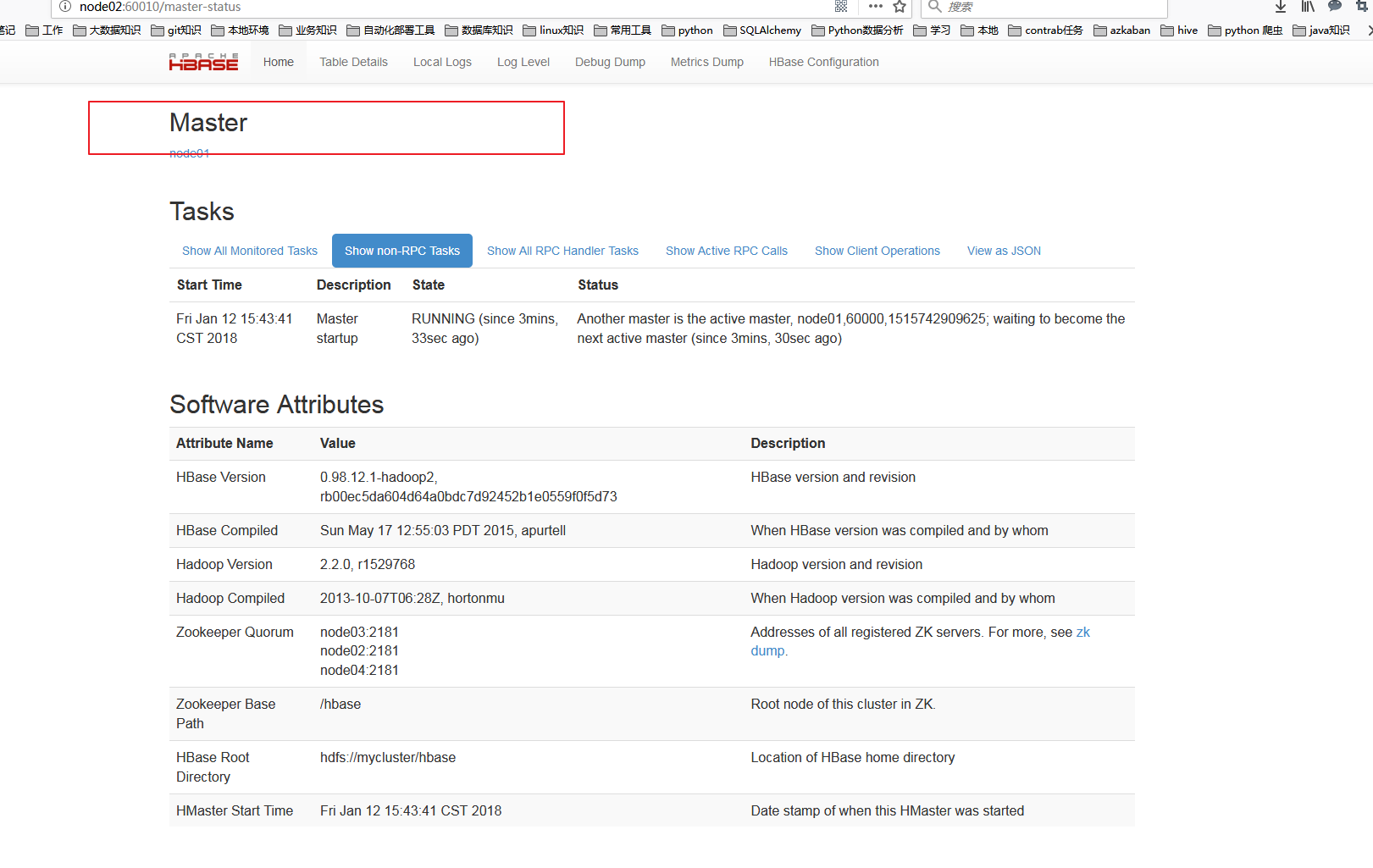

在node02(backup-Master节点) 执行 bin/start-hbase.sh启动备份节点。最好配置成全局,加载到环境变量中去。

主节点:Hmaster

从节点:(归属于某个主节点)

至此,完全分布式集群搭建完毕。!!!!

持续更新中。。。。,欢迎大家关注我的公众号LHWorld.