词向量技术是NLP领域中一种基础的技术,词向量将一个词语转换为固定维度的向量,通过处理向量关系让NLP中语义计算的任务得以实现。

我们都知道句子是由一个个词语组成的,词向量技术只是将单个词语转成固定维度的向量,那么怎么得到多个词语组成的句子的向量了?这是一个好问题,毕竟实际环境中需要处理的文本是一个个句子,而非一个个词语。为了让读者了解用词向量生成句向量的具体步骤,本文将介绍如下几种词向量生成句向量的无监督学习手段,它们分别是:累加法、平均法、TF-IDF加权平均法以及SIF嵌入法。

1 累加法

累加法是得到句子向量最简单的方法,假设有这样一句文本:

——Euclid(欧几里得)

这句是古希腊著名数学家欧几里得的名言,其中文意思是“通往几何并没有皇家大道”。NLP处理一段文本首先需要将一段文本进行去停用词处理,英语中常见的停用词有be动词、介词、连词等,经过去停用词处理后上述文本可得下面的词语距离:

{there, no, royal, way, geometry}

本文采用相应的词向量词典(GoogleNews-vectors-negative300.bin)和python的gensim来得到词向量,可得上述单词的如下词向量(本文篇幅有限,用5维的词向量来演示)

| 词语 | 词向量 |

|---|---|

| There | [ 0.1, 0.2, 0.3, 0.4, 0.5] |

| No | [ 0.2, 0.3, 0.4, 0.5, 0.6] |

| Royal | [ 0.3, 0.4, 0.5, 0.6, 0.7 ] |

| Way | [ 0.4, 0.5, 0.6, 0.7, 0.8 ] |

| Geometry | [0.5, 0.6, 0.7, 0.8, 0.9] |

累加法的做法是将句子中所有非停用词的词向量叠加,如果句子有n个非停用词,则句子的词向量通过下面的手段获得:

Vsentence = Vword1 + Vword2 + …… + Vwordn

根据此方法可以得到” There is no royal way to geometry.“ 的句子向量为:

Vsentence = Vthere + Vno + Vroyal + Vway + Vgeometry

= [ 0.1, 0.2, 0.3, 0.4, 0.5] + [ 0.2, 0.3, 0.4, 0.5, 0.6] + … + [0.5, 0.6, 0.7, 0.8, 0.9]

= [1.5, 2.0, 2.5, 3.0, 3.5]

2 平均法

平均法和累计法方法相似,同样需要将一个句子中所有的非停用词向量叠加起来,但最后需要加叠加起来向量处以非停用词的个数。句子的词向量通过下面的手段获得:

Vsentence = (Vword1 + Vword2 + …… + Vwordn) / n

根据此方法可以得到” There is no royal way to geometry.“ 的句子向量为:

Vsentence =( Vthere + Vno + Vroyal + Vway + Vgeometry) / 5

= ([ 0.1, 0.2, 0.3, 0.4, 0.5] + [ 0.2, 0.3, 0.4, 0.5, 0.6] + … + [0.5, 0.6, 0.7, 0.8, 0.9]) / 5

= [1.5, 2.0, 2.5, 3.0, 3.5] / 5

= [0.3, 0.4, 0.5, 0.6, 0.7]

3 TF-IDF加权平均法

TF-IDF加权平均法需要利用到TF-IDF技术,TF-IDF技术是一种常用的文本处理技术。TF-IDF模型常用评估一个词语对于一个文档的重要程度,经常应用于搜索技术和信息检索的领域。一个词语TF-IDF值与它在文档中出现频数成正比,与它在语料库中出现的频率成反比。TF-IDF由TF词频(Term Frequency)和IDF逆向文件频率(Inverse Document Frequency)相乘而得。对于词语ti来说:

其中ni,j是词语ti在自己所处的文档j中出现频数,Σknk,j是文档j中所有所有词语对应数

之和,|D|表示训练语料库中文档的总数,| j:ti∈dj|表示训练语料库中包含词语ti的文档总数。

另外值得注意的是,如果词语ti不在语料库中那么(1)式中| j:ti∈dj|为0,那么会导致IDFj中分母为0,则无法计算出IDFj值。所以需要改进为如下:

TF-IDF加权法不仅需要得到句子中每个非停用词的词向量,还需要得到句子中每个非停用词的TFIDF值。每个非停用词的TF部分还好计算,IDF部分就要看用户使用哪个语料库,如果是做query检索,那么IDF部分对应的语料库就是所有query句子;如果是做文本自相似聚类,那么IDF部分对应的语料库就是全体待分类句子。然后通过如下手段得到TF-IDF加权的的句子向量:

Vsentence = TFIDFword1 * Vword1 + TFIDFword2 * Vword2 + …… + TFIDFwordn * Vwordn

假设” There is no royal way to geometry.“ 是做query检索,那么计算IT-IDF对应的语料库就是全体query句子。若全体query句子一共有100个; 其中60个query句子含有词语there, 65个query句子含有词语no, 7个query句子含有词语royal, 72个query句子含有词语way, 9个quer句子y含有词语geometry。那么这句话中每个非停用词的TF-IDF数如下所示:

There: 1/(1+1+1+1+1) * log(100/(1+60) = 0.098

No: 1/(1+1+1+1+1) * log(100/(1+65) = 0.083

Royal: 1/(1+1+1+1+1) * log(100/(1+7) = 0.505

Way: 1/(1+1+1+1+1) * log(100/(1+72) = 0.629

Geometry: 1/(1+1+1+1+1) * log(100/(1+9) = 0.460

所以这句话的IT-IDF加权据向量为:

Vsentence = TFIDFthere * Vthere + TFIDFno * Vno + …… + TFIDFgeometry * Vgeometry

=0.098[0.1,0.2,0.3,0.4,0.5]+0.083[0.2,0.3,0.4,0.5,0.6]+…+0.460*[0.5,0.6,0.7,0.8,0.9]

= [0.147, 0.166, 1.2625 , 1.887, 1.61]

4 ISF嵌入法

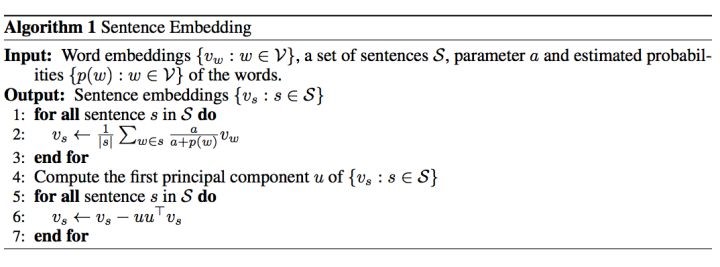

ISF加权平均法和TF-IDF加权平均法类似,ISF加权计算来源于普林斯顿大学的论文A latent variable model approach to pmi-based word embeddings. ( https://openreview.net/forum?id=Sy K00v5xx),按照论文作者说法,此方法可以很好的根据每个词词向量得到整个句子的据向量。SIF嵌入法需要利用主成分分析和每个词语的estimated probability, SIF嵌入法具体操作如下所示:

图1 SIF句子向量嵌入生成

整个算法的输出为:

一个句子向量

算法的具体步骤是:

(1) 得到初步句向量

遍历语料库中每个句子,假设当前句子为s, 通过如下计算式子得到当前句子s的初步句向量:

即加权求平均的过程,每个词语向量乘以系数a/(a+p(w)后叠加,最后叠加向量处以句子s中词语的个数,对于可调参数a论文中作者使用0.001和0.0001两个。P(w)是词语在全体语料库中unigram probability,即词语w词频处以语料库所有词语词频之和。

(2) 主成分计算

全体初步句向量进行主成分分析,计算出全体初步句向量第一主成分u

(3) 得到目标句向量

通过如下计算时对初步句向量进行二次处理,得到目标句向量

此论文作者也在Github上公开了源代码,感兴趣的读者可以自行下载做实验,Github代码

小结

本文主要介绍了四种无监督手段来根据词向量生成一个句子的句向量,除了无监督手段外,实际环境中还有用到监督方法来生成一个句子向量,例如训练一个CNN的文本分类器,取最后一个隐藏层的输出作为句子向量,感兴趣的读者可以google来进一步学习。

参考文献

[1] Arora S, Liang Y, Ma T. A simple but tough-to-beat baseline for sentence embeddings[J]. 2016.