首先利用tensorflow写了一个简单的线性回归,自己捏造数据来回归:

import tensorflow as tf import numpy as np x_data = np.float32(np.random.rand(2,100)) y_data = np.dot([0.1,0.2],x_data) + 3 b = tf.Variable(tf.zeros([1])) w = tf.Variable(tf.random_uniform([1,2],-1,1)) y = tf.matmul(w,x_data)+b loss = tf.reduce_mean(tf.square(y - y_data)) optimzier = tf.train.GradientDescentOptimizer(learning_rate=0.2) train = optimzier.minimize(loss) init = tf.initialize_all_variables() sess = tf.Session() sess.run(init) for step in range(401): sess.run(train) if step % 20 == 0: print(step,sess.run(w),sess.run(b),sess.run(loss))

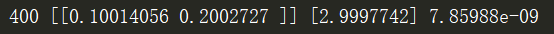

得到如下结果,误差显然很小:

不需要多解释,都是简单的操作。

下面再利用tensorflow的开源的数据集mnist来训练softmax回归:

每一个MNIST数据单元有两部分组成:一张包含手写数字的图片和一个对应的标签。我们把这些图片设为“xs”,把这些标签设为“ys”。训练数据集和测试数据集都包含xs和ys,比如训练数据集的图片是 mnist.train.images ,训练数据集的标签是 mnist.train.labels。

每一张图片包含28像素X28像素。我们可以用一个数字数组来表示这张图片:

我们把这个数组展开成一个向量,长度是 28x28 = 784。如何展开这个数组(数字间的顺序)不重要,只要保持各个图片采用相同的方式展开。从这个角度来看,MNIST数据集的图片就是在784维向量空间里面的点, 并且拥有比较复杂的结构 (提醒: 此类数据的可视化是计算密集型的)。

展平图片的数字数组会丢失图片的二维结构信息。这显然是不理想的,最优秀的计算机视觉方法会挖掘并利用这些结构信息,我们会在后续教程中介绍。但是在这个教程中我们忽略这些结构,所介绍的简单数学模型,softmax回归(softmax regression),不会利用这些结构信息。

因此,在MNIST训练数据集中,mnist.train.images 是一个形状为 [60000, 784] 的张量,第一个维度数字用来索引图片,第二个维度数字用来索引每张图片中的像素点。在此张量里的每一个元素,都表示某张图片里的某个像素的强度值,值介于0和1之间。

相对应的MNIST数据集的标签是介于0到9的数字,用来描述给定图片里表示的数字。为了用于这个教程,我们使标签数据是"one-hot vectors"。 一个one-hot向量除了某一位的数字是1以外其余各维度数字都是0。所以在此教程中,数字n将表示成一个只有在第n维度(从0开始)数字为1的10维向量。比如,标签0将表示成([1,0,0,0,0,0,0,0,0,0,0])。因此, mnist.train.labels 是一个 [60000, 10] 的数字矩阵

Softmax回归

我们知道MNIST的每一张图片都表示一个数字,从0到9。我们希望得到给定图片代表每个数字的概率。比如说,我们的模型可能推测一张包含9的图片代表数字9的概率是80%但是判断它是8的概率是5%(因为8和9都有上半部分的小圆),然后给予它代表其他数字的概率更小的值。

这是一个使用softmax回归(softmax regression)模型的经典案例。softmax模型可以用来给不同的对象分配概率。即使在之后,我们训练更加精细的模型时,最后一步也需要用softmax来分配概率。

softmax回归(softmax regression)分两步:第一步

为了得到一张给定图片属于某个特定数字类的证据(evidence),我们对图片像素值进行加权求和。如果这个像素具有很强的证据说明这张图片不属于该类,那么相应的权值为负数,相反如果这个像素拥有有利的证据支持这张图片属于这个类,那么权值是正数。

下面的图片显示了一个模型学习到的图片上每个像素对于特定数字类的权值。红色代表负数权值,蓝色代表正数权值。

我们也需要加入一个额外的偏置量(bias),因为输入往往会带有一些无关的干扰量。因此对于给定的输入图片 x 它代表的是数字 i 的证据可以表示为

其中  代表权重,

代表权重, 代表数字 i 类的偏置量,j 代表给定图片 x 的像素索引用于像素求和。然后用softmax函数可以把这些证据转换成概率 y:

代表数字 i 类的偏置量,j 代表给定图片 x 的像素索引用于像素求和。然后用softmax函数可以把这些证据转换成概率 y:

这里的softmax可以看成是一个激励(activation)函数或者链接(link)函数,把我们定义的线性函数的输出转换成我们想要的格式,也就是关于10个数字类的概率分布。因此,给定一张图片,它对于每一个数字的吻合度可以被softmax函数转换成为一个概率值。softmax函数可以定义为:

展开等式右边的子式,可以得到:

但是更多的时候把softmax模型函数定义为前一种形式:把输入值当成幂指数求值,再正则化这些结果值。这个幂运算表示,更大的证据对应更大的假设模型(hypothesis)里面的乘数权重值。反之,拥有更少的证据意味着在假设模型里面拥有更小的乘数系数。假设模型里的权值不可以是0值或者负值。Softmax然后会正则化这些权重值,使它们的总和等于1,以此构造一个有效的概率分布。

下面是代码:

from tensorflow.examples.tutorials.mnist import input_data import tensorflow as tf #加载数据 path = 'C:\test_mnist_tf' mnist = input_data.read_data_sets(path, one_hot=True) #x为占位符号,可以输入任意数量的图片信息 x = tf.placeholder('float',[None,784]) #权值 和 偏重量定义 w = tf.Variable(tf.zeros([784,10])) b = tf.Variable(tf.zeros([10])) #目标值 y = tf.nn.softmax(tf.matmul(x,w) + b) #交叉熵 y_ = tf.placeholder('float',[None,10]) cross_entropy = -tf.reduce_sum(y_ * tf.log(y)) #梯度下降法 train_step = tf.train.GradientDescentOptimizer(learning_rate=0.01).minimize(cross_entropy) #初始化图 init = tf.global_variables_initializer() sess = tf.Session() sess.run(init) #开始训练 for i in range(5000): bach_xs, bach_ys = mnist.train.next_batch(100) sess.run(train_step,feed_dict={x:bach_xs,y_:bach_ys}) #评价模型 correct_prediction = tf.equal(tf.argmax(y,1),tf.argmax(y_,1)) accuracy = tf.reduce_mean(tf.cast(correct_prediction,'float')) print(sess.run(accuracy,feed_dict={x:mnist.test.images, y_:mnist.test.labels}))

最后得到的的精度为0.9218,虽然效果不是太好,是因为这是一个非常简单的模型。

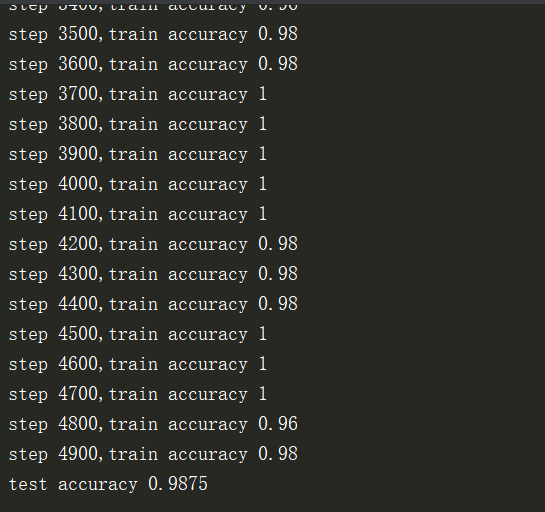

为了提高准确率,采用卷积神经网络对其进行改进:

import tensorflow as tf from tensorflow.examples.tutorials.mnist import input_data #加载数据 path = 'C:\test_mnist_tf' mnist = input_data.read_data_sets(path, one_hot=True) sess = tf.InteractiveSession() x = tf.placeholder("float", shape=[None, 784]) y_ = tf.placeholder("float", shape=[None, 10]) def weight_variable(shape): initial = tf.truncated_normal(shape,stddev=0.1) return tf.Variable(initial) def bias_variable(shape): initial = tf.constant(0.1,shape = shape) return tf.Variable(initial) def conv2d(x,W): return tf.nn.conv2d(x,W,strides=[1,1,1,1],padding='SAME') def max_pool_2x2(x): return tf.nn.max_pool(x,ksize=[1,2,2,1],strides=[1,2,2,1],padding='SAME') #第一层卷积 W_conv1 = weight_variable([5,5,1,32]) b_conv1 = bias_variable([32]) x_image = tf.reshape(x,[-1,28,28,1]) h_conv1 = tf.nn.relu(conv2d(x_image,W_conv1) + b_conv1) h_pool1 = max_pool_2x2(h_conv1) #第二层卷积 w_conv2 = weight_variable([5,5,32,64]) b_conv2 = bias_variable([64]) h_conv2 = tf.nn.relu(conv2d(h_pool1,w_conv2) + b_conv2) h_pool2 = max_pool_2x2(h_conv2) #全连接 w_fc1 = weight_variable([7*7*64,1024]) b_fc1 = bias_variable([1024]) h_pool_flat = tf.reshape(h_pool2,[-1,7*7*64]) h_fc1 = tf.nn.relu(tf.matmul(h_pool_flat,w_fc1) + b_fc1) #dropout keep_prob = tf.placeholder('float') h_fc1_drop = tf.nn.dropout(h_fc1,keep_prob) w_fc2 = weight_variable([1024,10]) b_fc2 = bias_variable([10]) y_conv = tf.nn.softmax(tf.matmul(h_fc1_drop,w_fc2) + b_fc2) #训练 cross_entropy = -tf.reduce_mean(y_*tf.log(y_conv)) train_step = tf.train.AdamOptimizer(1e-4).minimize(cross_entropy) correct_prediction = tf.equal(tf.argmax(y_conv,1),tf.argmax(y_,1)) accuracy = tf.reduce_mean(tf.cast(correct_prediction,'float')) sess.run(tf.global_variables_initializer()) for i in range(5000): batch = mnist.train.next_batch(50) if i % 100 == 0: train_accuracy = accuracy.eval(feed_dict={x:batch[0],y_:batch[1],keep_prob:1.0}) print('step %d,train accuracy %g'%(i,train_accuracy)) train_step.run(feed_dict={x:batch[0],y_:batch[1],keep_prob:0.5}) print('test accuracy %g'%accuracy.eval(feed_dict = {x:mnist.test.images,y_:mnist.test.labels,keep_prob:1})) #print(sess.run(accuracy,feed_dict={x:mnist.test.images,y_:mnist.test.labels,keep_prob:1}))

准确率达到了98.75%,有了很大的提高。

另外,本次学习并没有加入可视化,后续的实践当中会加入此类的东

********************

神经网络训练需要一个有好的gpu机器,gpu版本下训练速度飞快,本人的电脑因为显卡不行换成cpu版本训练的特别慢。。。。。

---恢复内容结束---

---恢复内容结束---