交叉熵(Cross-Entropy)

交叉熵是一个在ML领域经常会被提到的名词。在这篇文章里将对这个概念进行详细的分析。

1.什么是信息量?

2.什么是熵?

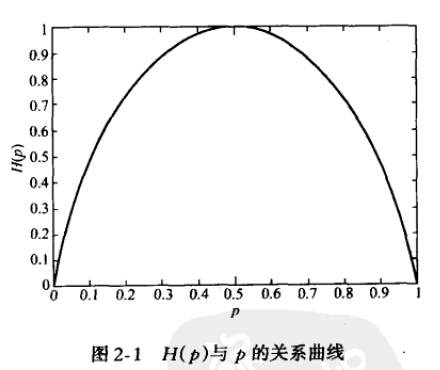

可以看出,当两种取值的可能性相等时,不确定度最大(此时没有任何先验知识),这个结论可以推广到多种取值的情况。在图中也可以看出,当p=0或1时,熵为0,即此时X完全确定。

熵的单位随着公式中log运算的底数而变化,当底数为2时,单位为“比特”(bit),底数为e时,单位为“奈特”。

3.什么是相对熵?

4. 什么是交叉熵?

5.参考链接:

https://blog.csdn.net/rtygbwwwerr/article/details/50778098

https://zhuanlan.zhihu.com/p/27223959

维基百科关于cross-entropy的解释

交叉熵损失函数

UFLDL中关于logistic regression的说明

Kraft’s inequality

Visual Information