机器学习十讲——第七讲最优化

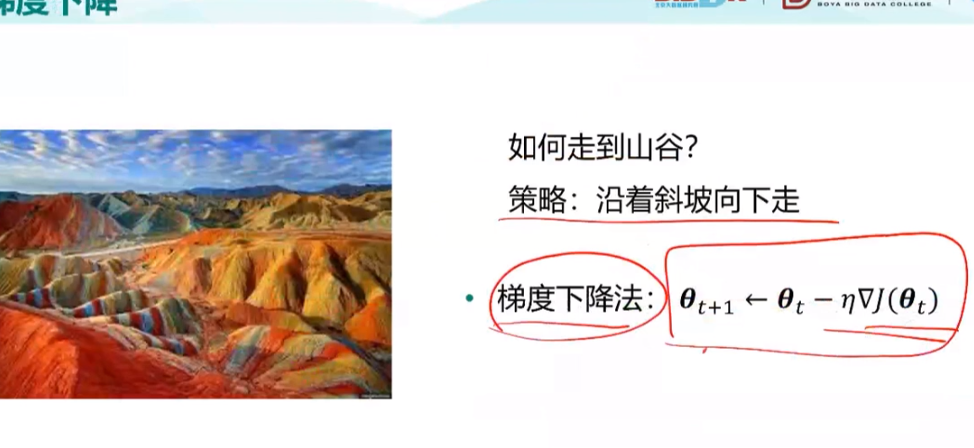

之后以线性回归为例子,举了梯度下降法的实例(人以最快速度到山谷)

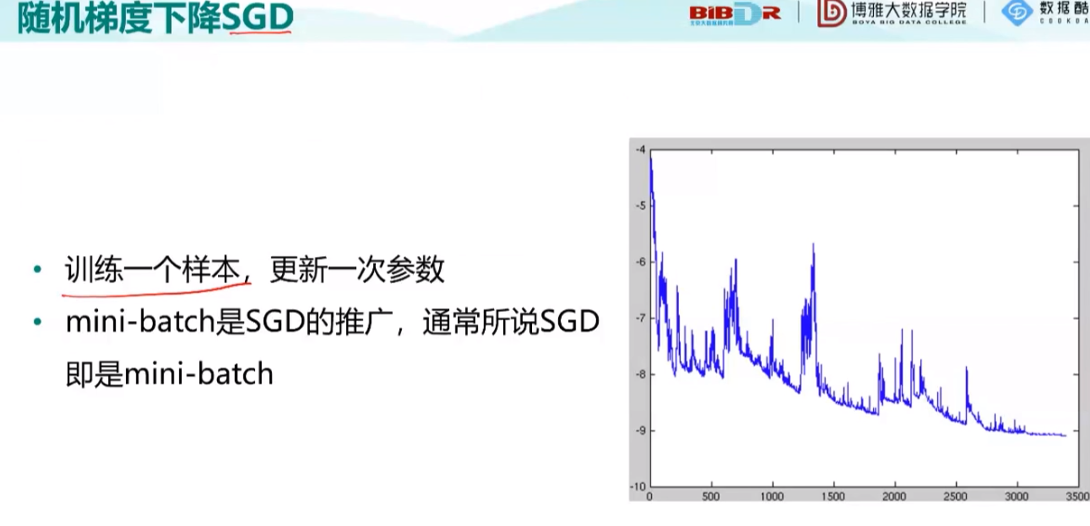

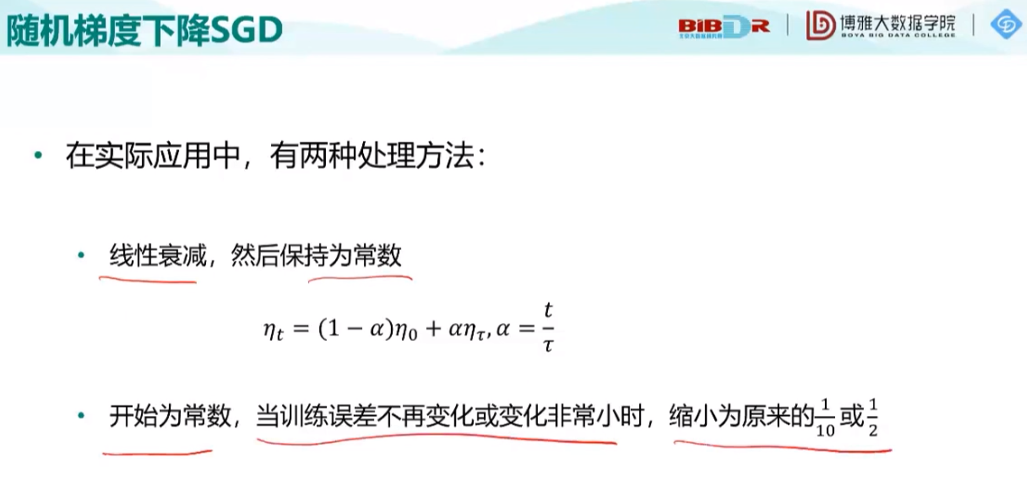

之后提到了之前学过的随机梯度下降法

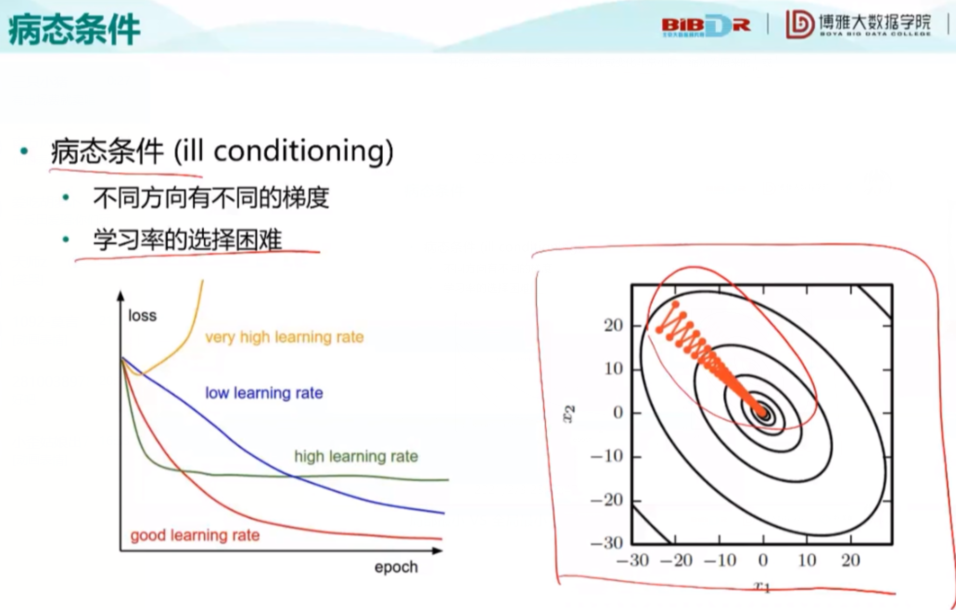

关于病态条件:

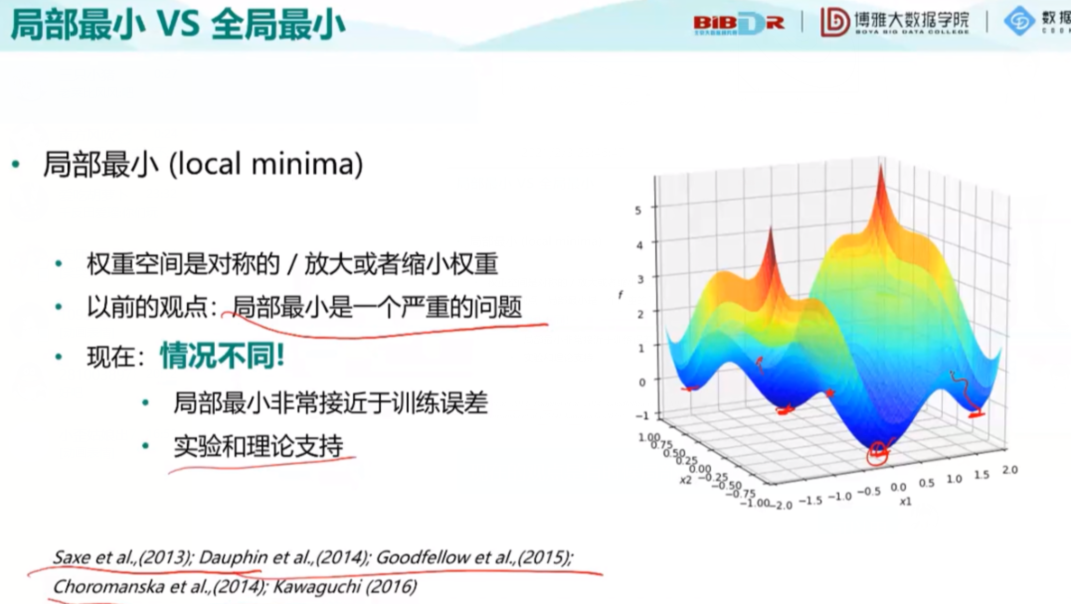

现在的观点是有时候局部极小值和最小值相差不多,可以使用。

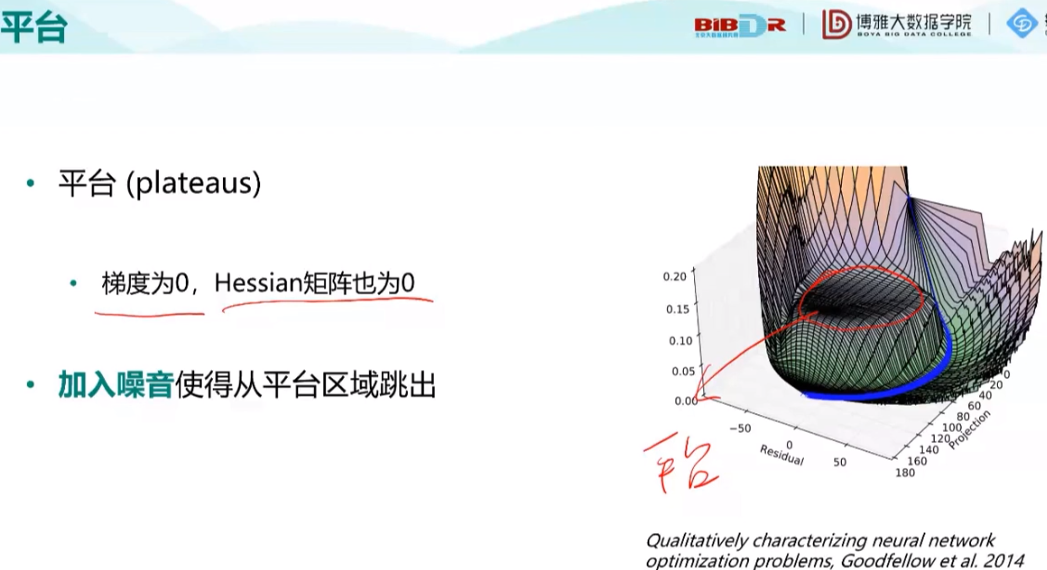

随后介绍了几个特殊的点:

( 当参数很大会发生梯度爆炸,很小时会出现悬崖)

解决方法:

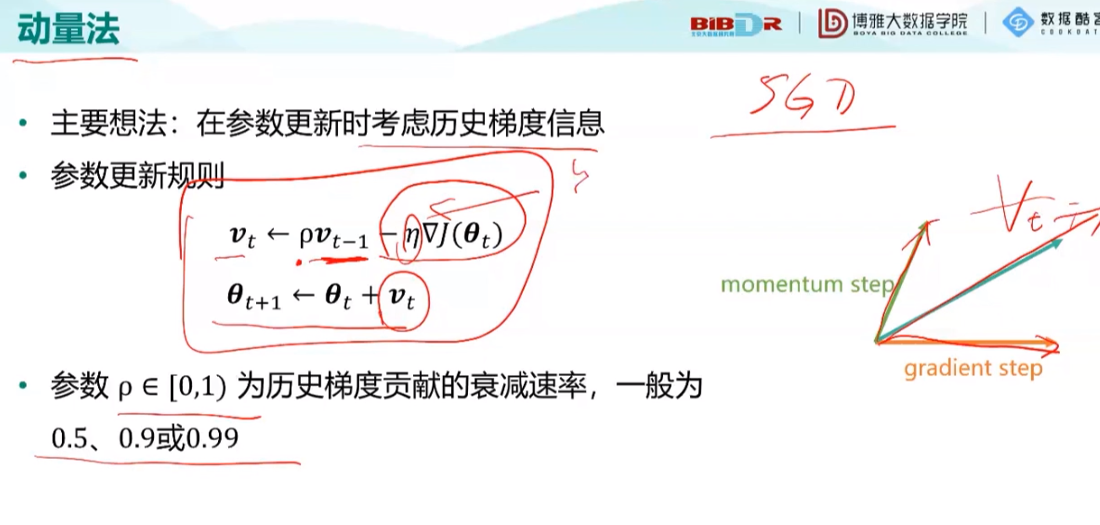

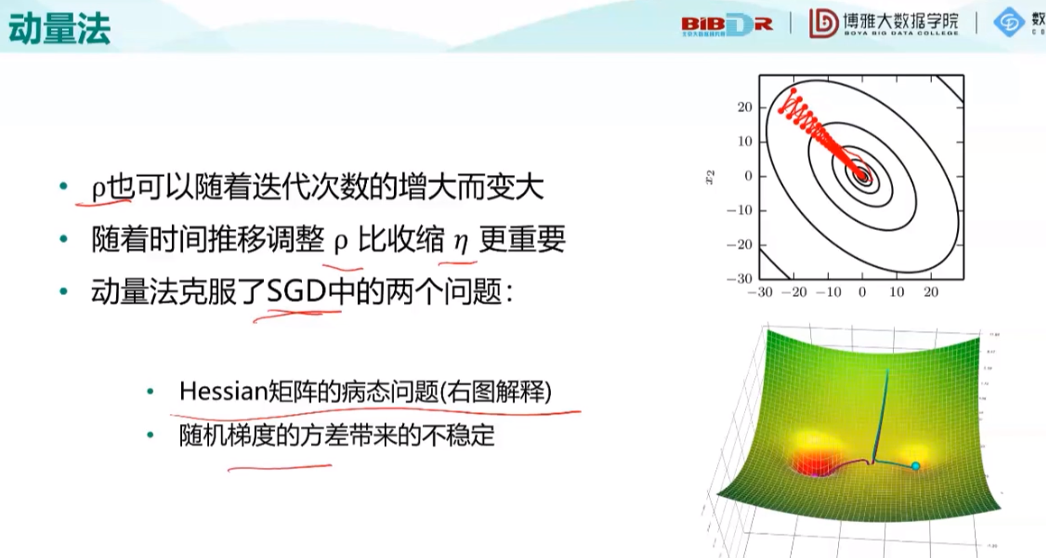

动量法:考虑了历史因素,解决了不稳定问题

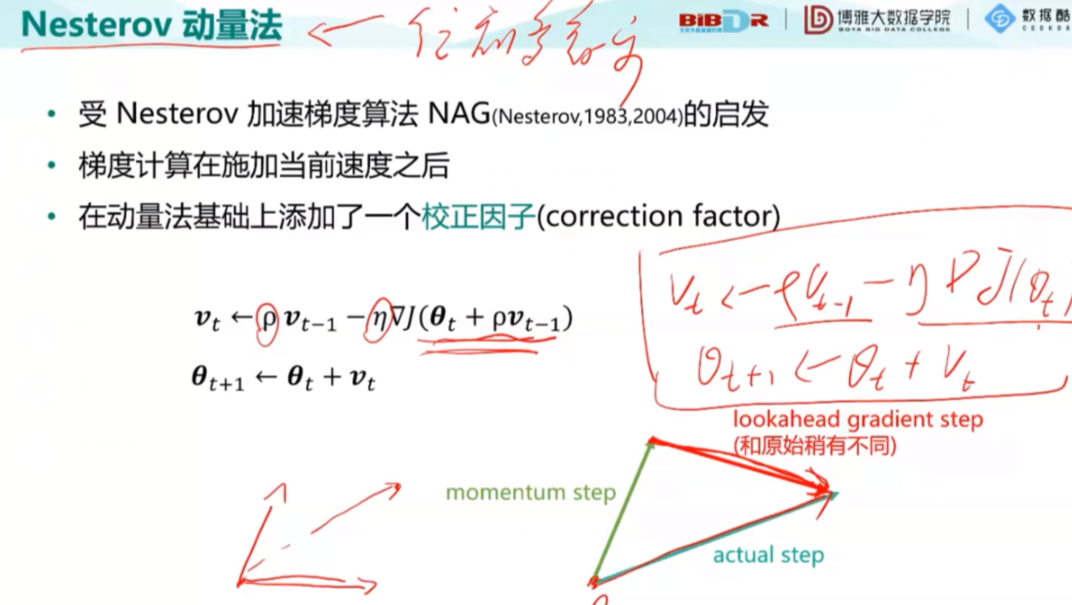

第二种方法:

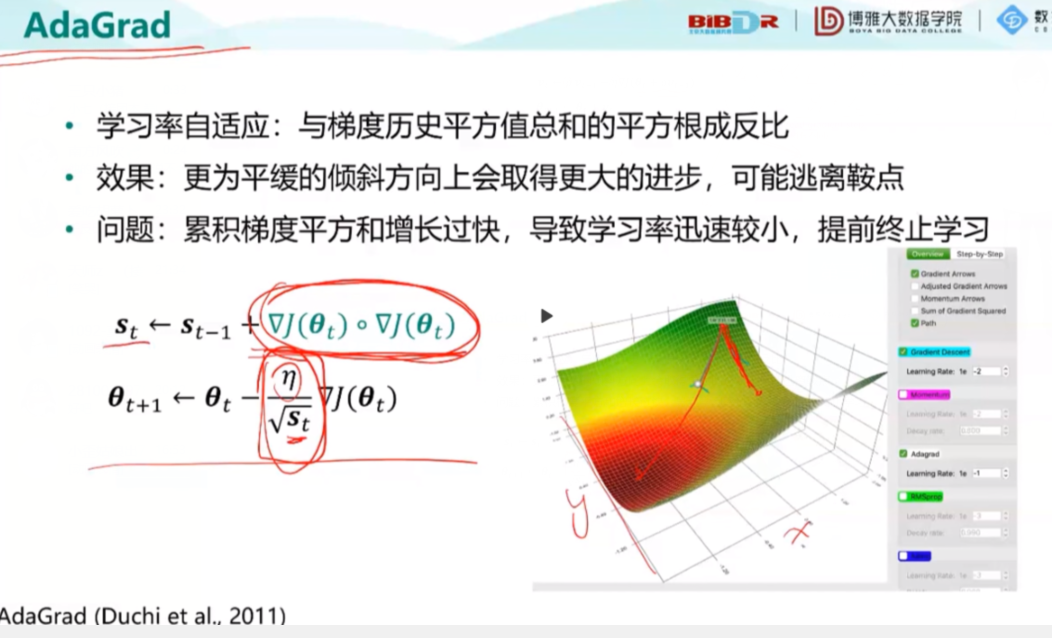

第三种:

第四种:(考虑最近的,忽略远的)

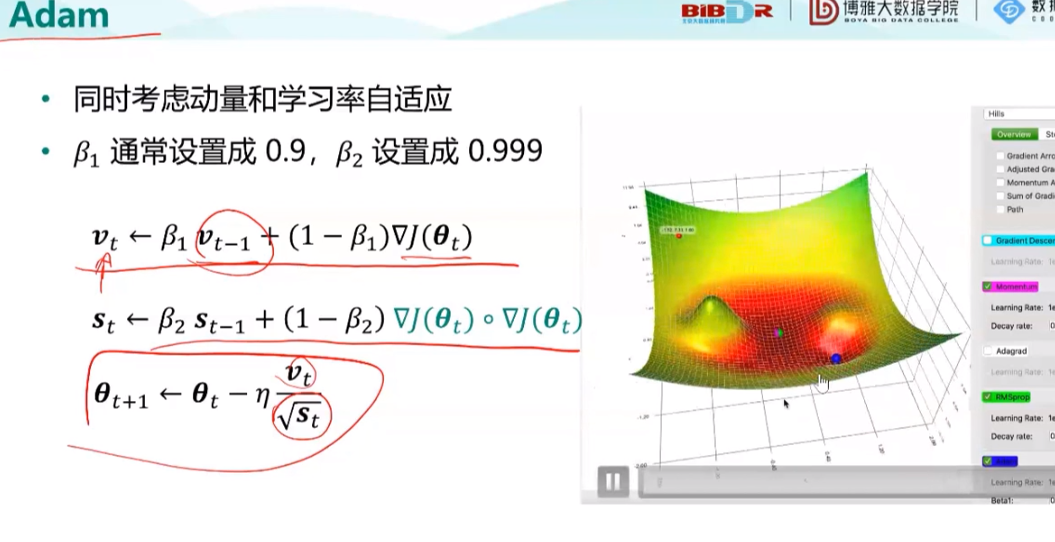

第五种:

蓝色小球的位置是最小值,其他两个球是局部最小值,Adam方法能找到最小值,而另外两种RMSProp和Nesterov方法不能准确找出最小值。

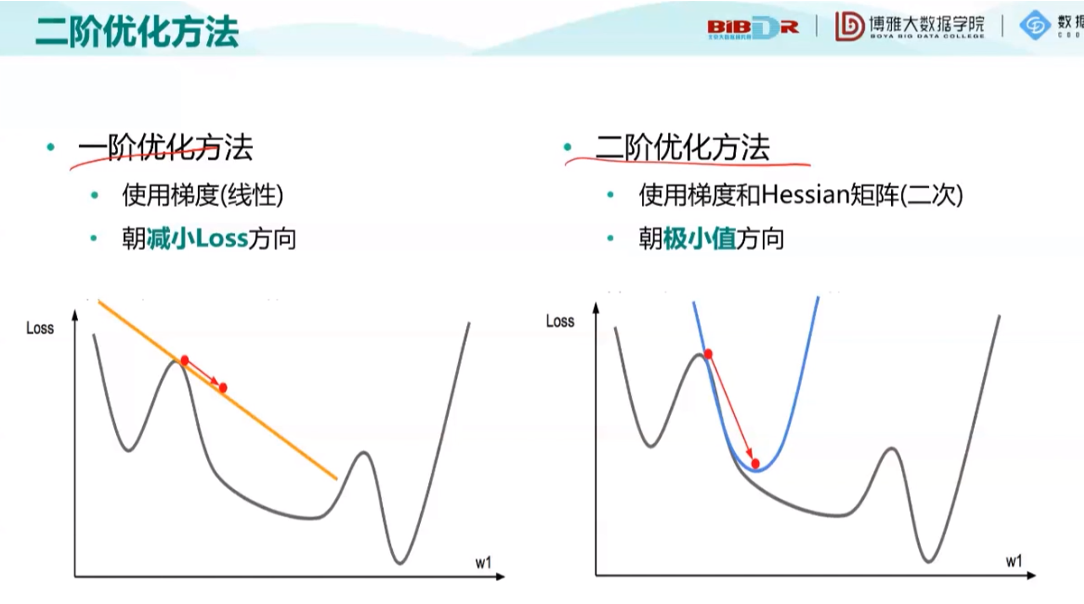

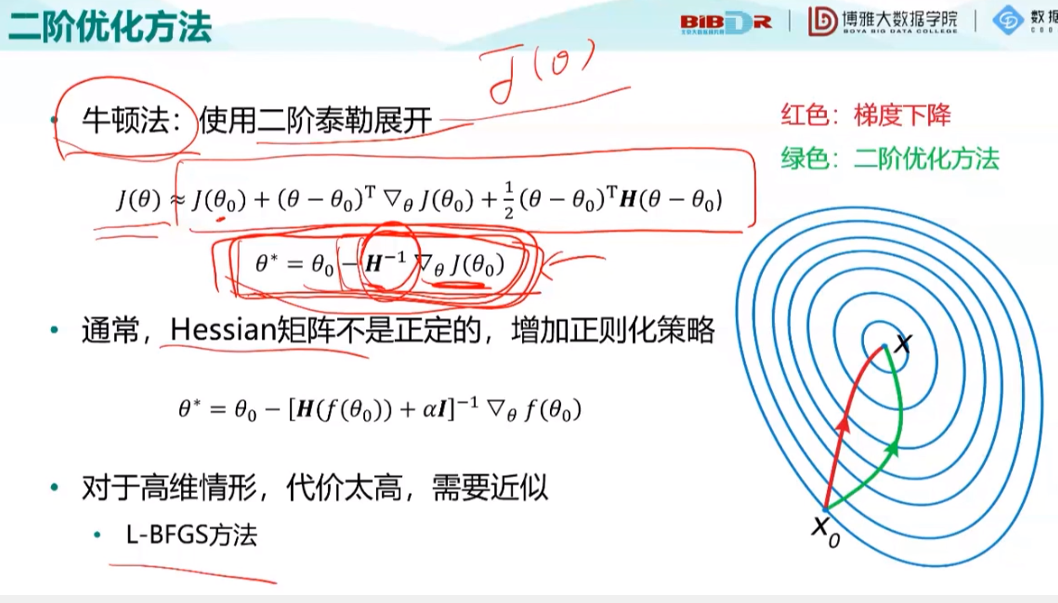

两种优化方式:

二阶方法计算量很大

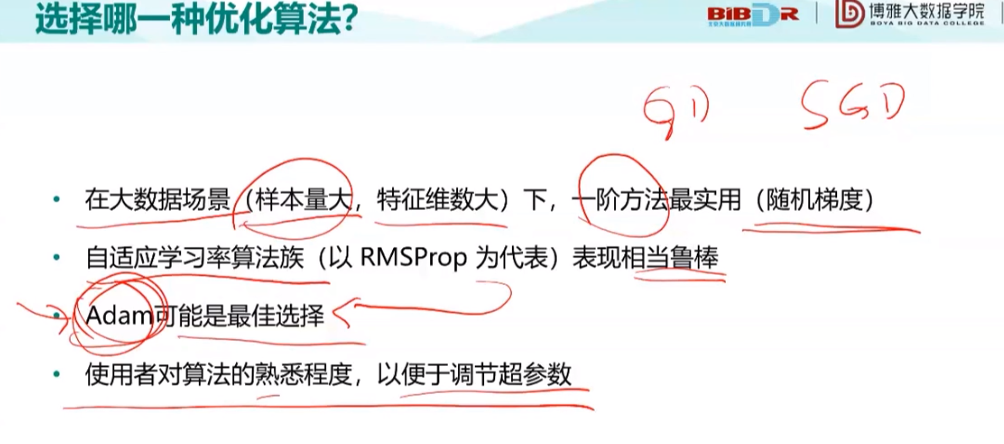

那么,这么多算法,应该如何选择呢?

如果不知道选什么 就用Adam,他的表现一般来说不会太差。

最后就是不可缺少的演示实例了……