Entropy and information

熵:度量一个物理系统中的态的不确定度。

注意: 文中出现的‘ 凸性’ convexity 和 ‘ 凹性’ concavity 的在不同的教材中可能含义相反。

有2个概念: 矩阵的 kernal, 和矩阵的 support

11.1 经典信息论: 香农熵

11.2 熵的基本性质

11.2.1 二元熵

11.2.2 相对熵

11.2.3 条件熵和互信息

11.2.4 数据处理不等式

11.3 冯诺依曼熵

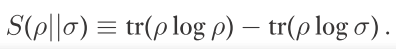

11.3.1 量子相对熵

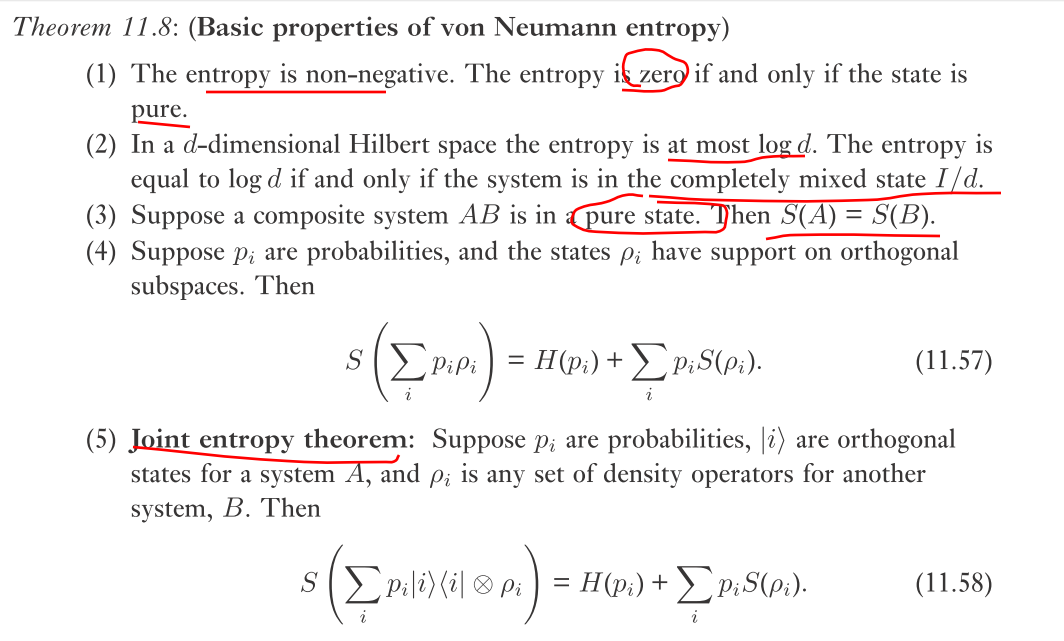

11.3.2 量子熵的基本性质

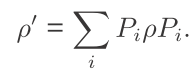

11.3.3 测量和熵

11.3.4 量子子可加性

11.3.5 熵的凹性

11.3.6 混合量子系统的熵

11.4 强-子可加性: 三体系统

对于一个随机变量X,熵即可视为在知道X的值之前我们不确定度的度量,也可以度量在知道X的值之后我们获得的信息,这两种观点是互补的。

熵定义为:随机变量取不同可能值的概率的函数,而不关心具体的值是多少。

设概率分布为 p1,p2,…,pn, 则相联系的香农熵为:

H(X)=H(p1,p2,…,pn)= - ∑x px*log(px)

这样定义熵可以用来 ‘ 量化存储信息所需的资源 ’。参考 ‘ 香农无噪声编码理论 ’ 。shannon's noiseless coding theorem

例子: 假设一个信息源产生 4个符号 1,2,3,4 中的一个。无压缩时,对于源的每一次使用,对应4个可能输出的 2 bits 存储空间被占用。 假设

产生 1 的概率为 1/2 ,

产生 2 的概率为 1/4 ,

产生 3 的概率为 1/8 ,

产生 4 的概率为 1/8 。

可采用 Huffman 编码, 即利用输出的‘ 偏爱 bias’ 来压缩源。如 1 编码为 0,2 编码为 10,3 编码为 110,4 编码为 111. 则压缩串的平均长度为 7/4.

这个和源的熵相一致: H(X)=7/4

可以证明:进一步压缩源会导致数据不可恢复地损失;熵量化了可能达到的最优压缩。

上面这个例子揭示了一个信息理论的核心理念: 对信息的基本测量可解答 ‘ 解决信息处理问题所需的物理资源 ’。

当p=1/2. Hmax=1

具有凹性质:![]() for 0<=p,x1,x2<=1

for 0<=p,x1,x2<=1

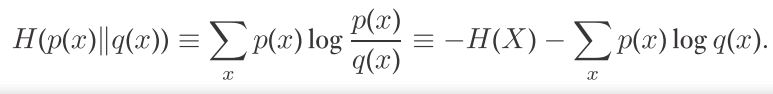

度量2个概率分布 p(x)和 q(x) 有多近。

the relative entropy of p(x) to q(x) is

显然 相对熵是体现‘ 差异’,或者说‘ 不一样的’ 信息。如果 p(x)=q(x) ,没有差异性的信息,相对熵当然为0

非负性:相对熵总是非负的。

一些熵有关的量能被认为是相对熵的特例。

例子: 设 p(x) 为X的概率分布,有d个结果;p(x)=1/d 为均匀分布。则通过相对熵的非负性可以证明:

log d>=H(x)

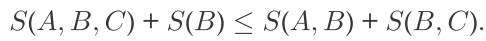

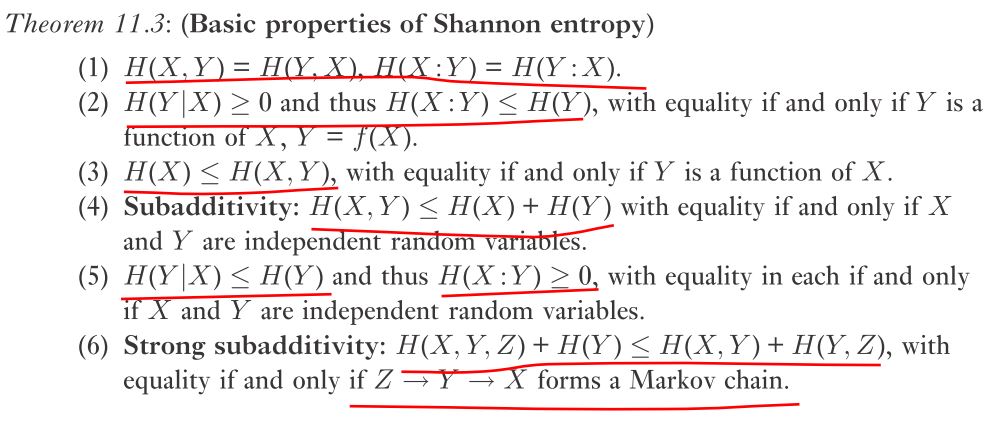

香农熵的次可加性:对于二元概率分布

![]()

![]()

等号为当 X 和 Y 为独立随机变量时成立。

这也很好理解,当X和Y有关联时,那它们的‘ 联合信息’ 量肯定少于各自的信息量加起来。

如何表示 X中与Y有关的信息内容。

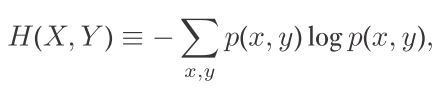

X和Y的联合熵 joint entropy 为:

对于 pair (X,Y),假设我们知道 Y的值,剩下的不确定度与‘不知道X’ 相联系。‘ 在知道Y条件上的X的熵 ’ 定义为:

H(X|Y)=H(X,Y)-H(Y)

'X 和 Y 的互信息内容',度量X和Y有多少共同信息。

![]()

![]()

![]()

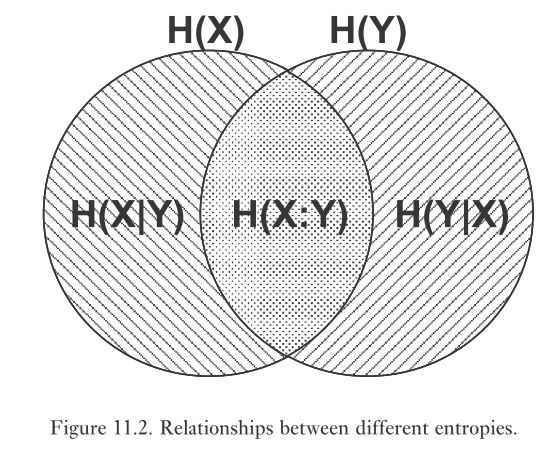

用韦恩图方便记忆:

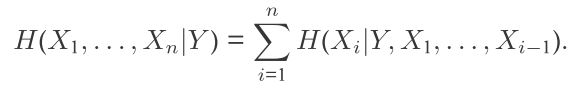

条件熵的链式法则:

声明: 输出信息只能随时间减少:一旦信息丢失,就永远流失。

一个 Markov chain 是一个序列 X1->X2->…… , Xn+1 独立于 X1,…,Xn-1, 在给定 Xn 下。

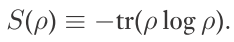

量子态中,其密度算符取代了额经典概率分布。因此:

完全混合态,其熵为 log d. d 为希尔伯特空间维度

显然: 纯态的熵为0,因为纯态的本征值为 1,0,0,0……

非负,可以是无穷大。

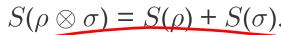

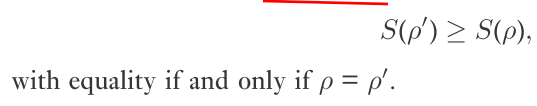

结论:1. 可以根据定义证明:

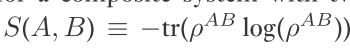

2. 对于有2部分 A 和 B 的复合量子系统, 其 ‘ 联合熵 ’ S(A,B) 定义为:

当我们对一个量子系统执行测量,其熵如何表现?

投影测量会增加熵

Pi 为正交投影子的完备集。

以 1-qubit 为例, 如果测量前为纯态 H,那么测量后态还为 H;

为纯态+ , 为完全混态密度矩阵。

广义测量可以减少熵: 如 |0><0|+|0><1|

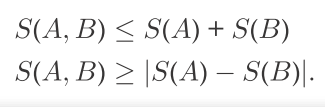

A和B系统的联合熵满足:

第一个式子当 A,B为分离态时取等号。

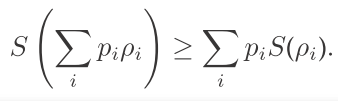

给定概率 pi 和密度矩阵 rou:

证明这个不等式用了一个技巧: 引入一个辅助系统 B。最后B的熵可以消掉。

11.3.6 混合量子态的熵

其上下界为:

3个量子系统 A,B,C 的态有: