Deep Neural Networks are Easily Fooled: High Confidence Predictions for Unrecognizable Images

Deep Neural Networks are Easily Fooled: High Confidence Predictions for Unrecognizable Images 是2015年的cvpr的文章。

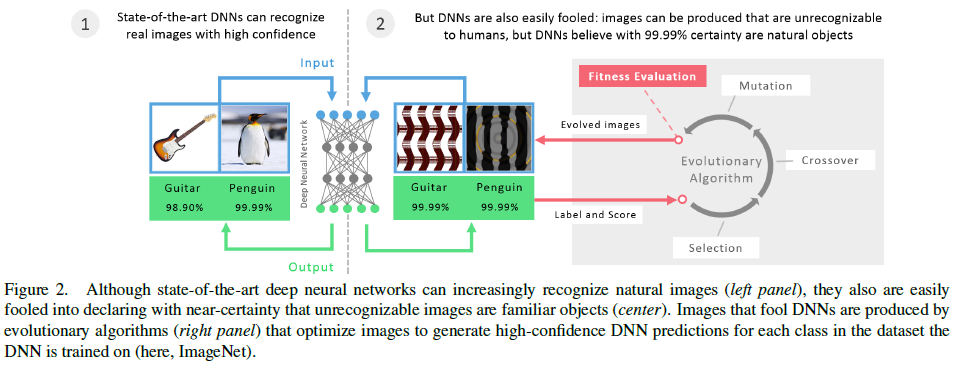

最近的研究发现:可以针对一张已经有正确分类的image,对其进行细微的像素修改,可以在DNN下被错分为其他label。同样,根据DNN,很容易产生一张在人眼下毫无意义的image,但是在DNN中能够获得高confidence的label。

本文意义: 对DNN的计算机视觉的generality的一个思考。

本文方法:使用 evolutionary algorithm或者梯度上升(gradient ascent)的方法来产生高预测confidence的image。

选择Deep Neural Networks,选择AlexNet作为本文的model,其中AlexNet pretrain在MNIST上取得了0.94% error rate

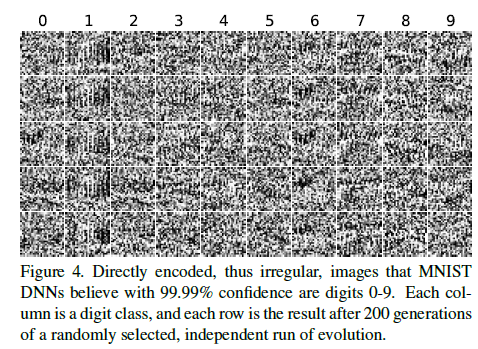

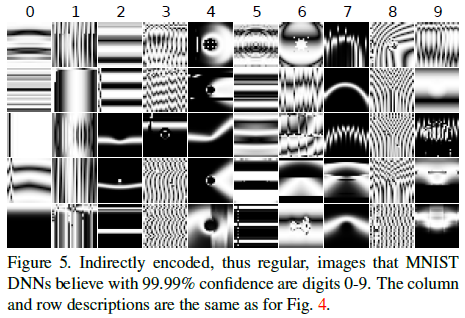

使用EA,有两种encoding的方法:

(1),direct encoding,对于每一个pixel使用介于[0, 255] 的uniform random noise生成。选择变异的数量为10%,每迭代1000次下降一半。使用多项式变异算法(polynomial mutation operator),变异的长度选择为固定的长度为15。

(2),indirect encoding,采用的是CPPN (compositional pattern producing network),可以产生类似自然和人造物体的复杂images。

对于directly encoded的image,经过约50次的迭代之后,可以获得99.99%的confidence。

对于indirect encoded的image,经过CPPN的若干次迭代之后,就可以获得99.99%的confidence。

同时, 利用这种generated 方法产生的image,因为其high confidence,可以说明dnn是提取各个不同类的关键图像形态来作为分类的

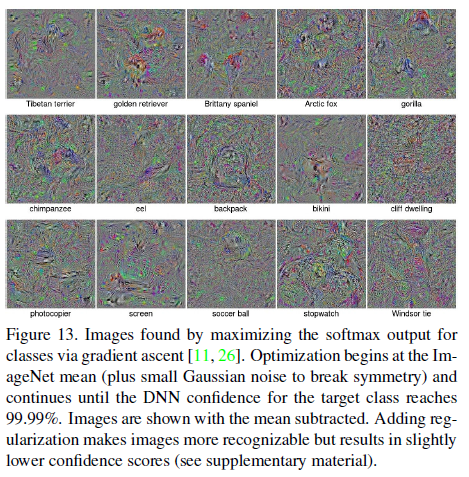

还有一种方法是:通过 gradient ascent来产生fooling images,对于一张image,指定一个其他类的label,

通常情况下, 这种情况因为backpropagated 得到的图片,也可以达到99% 的confidence,但是在辨识度上也是不可被人眼识别,也不同于ea生成的image。

讨论:

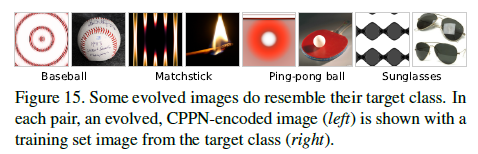

在生成image的时候,也发现很多generated image是有辨识度的。

那么, CPPN EA也可以作为一种对DNN visualize 的手段。

个人观点:

从当前热门的 computer vision 的 dl 黑盒方法中看出, dl对其在feature 转换之后的 space,也做了一个分类,但是这个类空间中还有一大部分的high confidence 的区域,为人眼无法辨识的image。也为DNN的安全性做了一个探讨。