1、偏置什么时候可以不要?

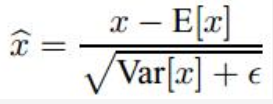

BN操作,里面有一个关键操作

其中x1 = x0 * w0 + b0,而E[x1] = E[x0*w0] + b0, 所以对于分子而言,加没加偏置,没有影响;

而对于下面分母而言,因为Var是方差操作,所以也没有影响(为什么没影响,回头问问你的数学老师就知道了)。

所以,卷积之后,如果要接BN操作,最好是不设置偏置,因为不起作用,而且占显卡内存。

2、github周末编辑的内容没有上传

3、hourglass

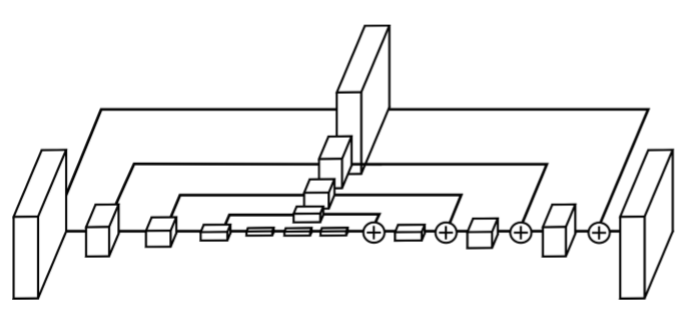

上面这个是single hourglass,每一个方框都是residual block, 如果简化的话可以将residual 改为常规的cnn

层和层之间的连接关系

Layer Implementation

他的动机是捕捉所有尺寸的信息,网络的最小的分辨率是4*4像素

网络设置: CNN+maxpooling 用来将feature 分辨率降低,每一个maxpooling step之前都会进行一个卷积

输入是256*256的分辨率需要一个很大的GPU内存,因此hourglass输入最大的分辨率是64*64, 这个不会影响网络产生精确的joint的能力

网络开始是7*7的卷积层,步长是2, 然后是residual module 和一个max pooling 将分辨率从256降低到64

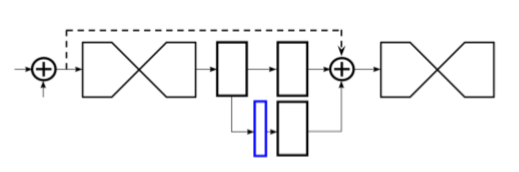

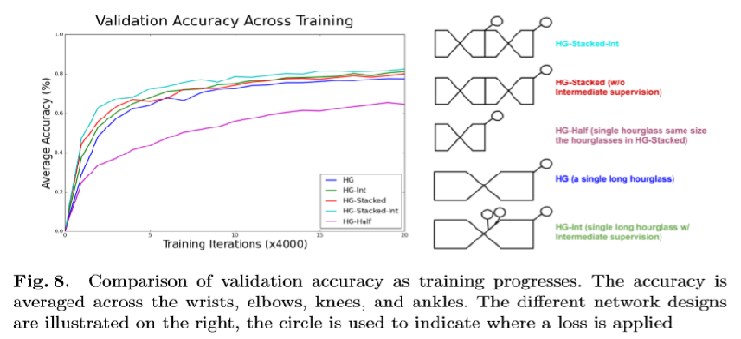

Stacked Hourglass with Intermediate Supervision

stacked hourglass的关键是,我们可以在哪一个feature map 上计算loss

每一个single hourglass ,都对loss 有贡献的情况下,对于pose estimate效果好

蓝色的是1*1的卷积网络用来提升卷积的featuremap 数目的,这里是expansion