理论知识:

第四范式自主研发算法GBDT(Gradient Boosting Decision Tree)

GBDT是一种基分类器为决策树的集成学习方法。决策树是一种常见的机器学习算法,GBDT中使用到的是回归树,如下图所示,回归树包含一个根结点、若干个内部结点和若干个叶子结点,每个叶子结点对应于一个实数值的预测结果,其他每个结点对应于一个特征判断,根结点包含所有样本,每个结点包含的样本集合根据特征判断的结果被分到子结点中。

GBDT模型是一个由很多棵树组成的决策森林,预测结果是所有决策树的预测结果加权之和。

目标函数

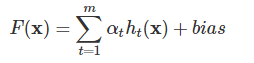

形式上,GBDT可以表示为

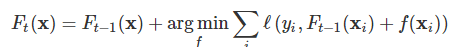

其中ht(x)ht(x)是第t个回归树αt,是第t个回归树的权重bias,bias是偏差项。GBDT的学习过程可以看作迭代式函数梯度下降过程,每次迭代学习一个拟合负梯度方向的基分类器

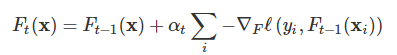

对其中的优化问题做一步梯度下降迭代

其中

其中Ft(x)是第t轮的模型,是损失函数,先知系统里面使用的是常见的对数几率损失函数

其中y是样本真实标记,是预测标记。

优化算法

GBDT使用的基分类器是回归树,每颗回归树用于拟合梯度下降中的梯度值。先知中回归树的学习目标是均方误差

其中为第t轮第i个样本的梯度值。回归树学习完之后,根据树的结果,解一个简单的优化问题,更新。