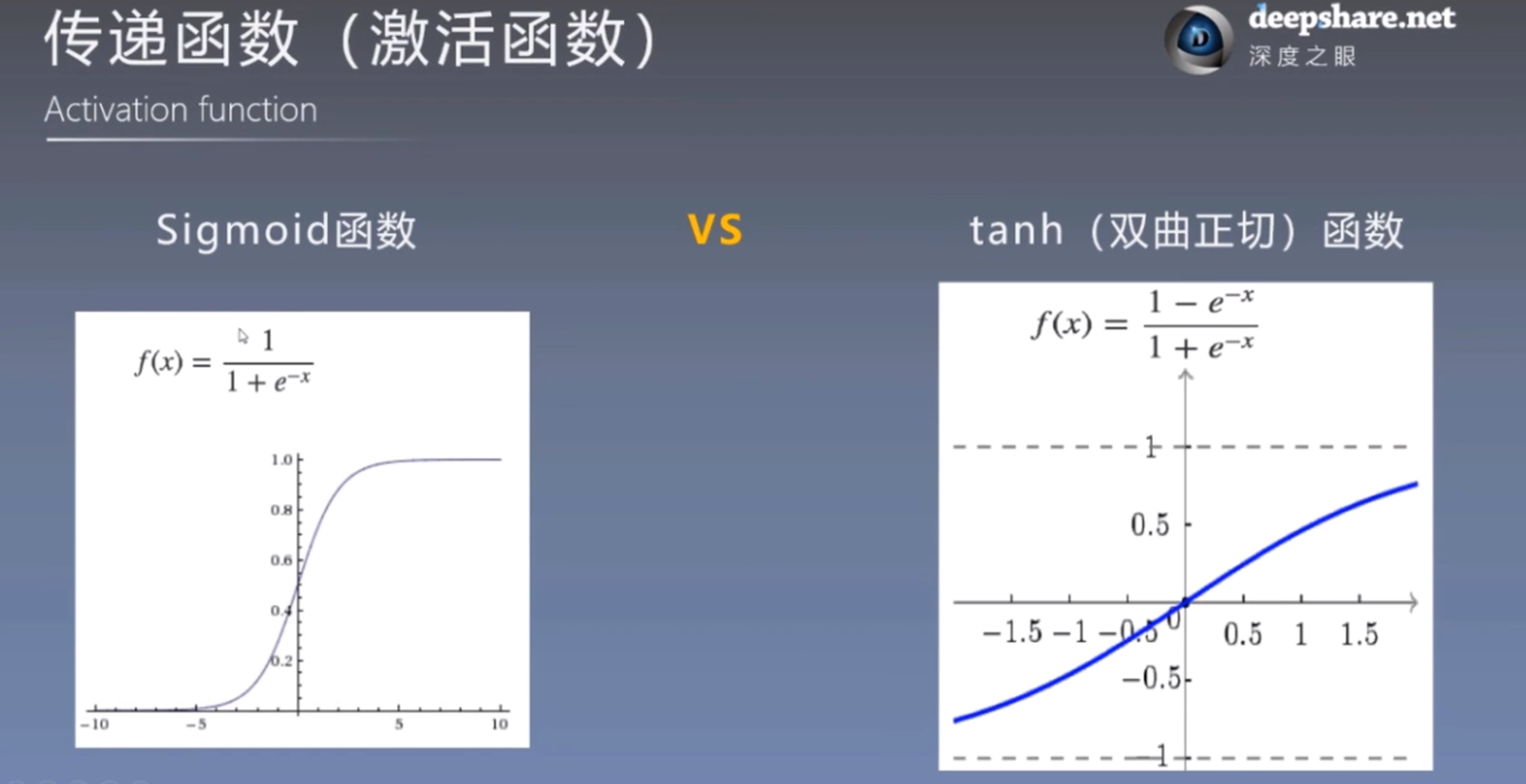

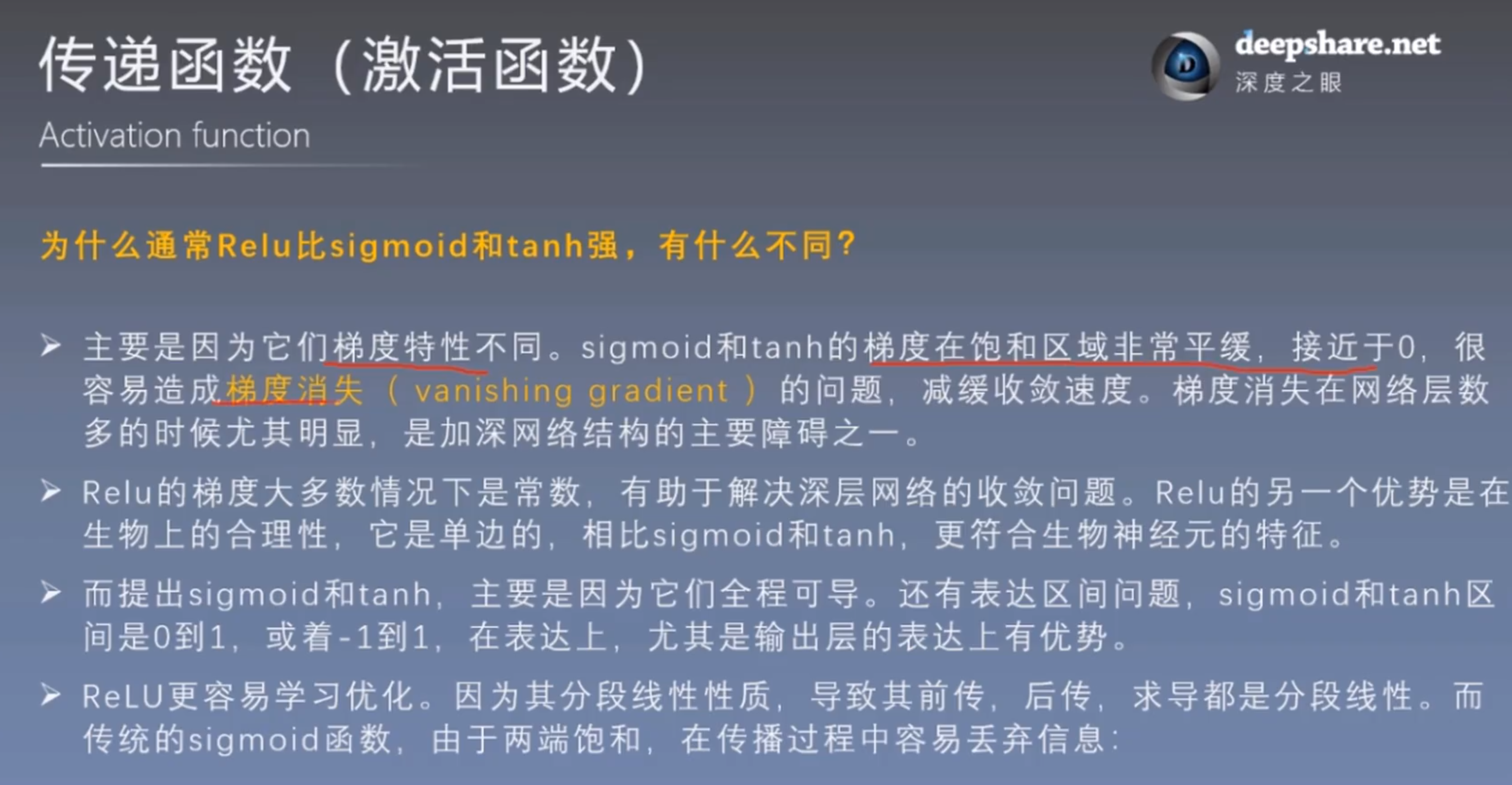

Sigmoid函数的优点是什么呢?优点就是当数据有噪声被扰动的时候函数值基本上不会受到什么影响,因为函数值的变化一定会很小。那么它的缺点是什么呢?它的缺点就是当神经网络进行反向传播的时候有可能会造成梯度的消失。因为sigmoid函数在x大于5的时候它的梯度是很平缓的接近于零的,所以反向传播可能会造成梯度的消失,就是说这个时候你训练一个神经网络就很有可能训练不动,可能很难去收敛。

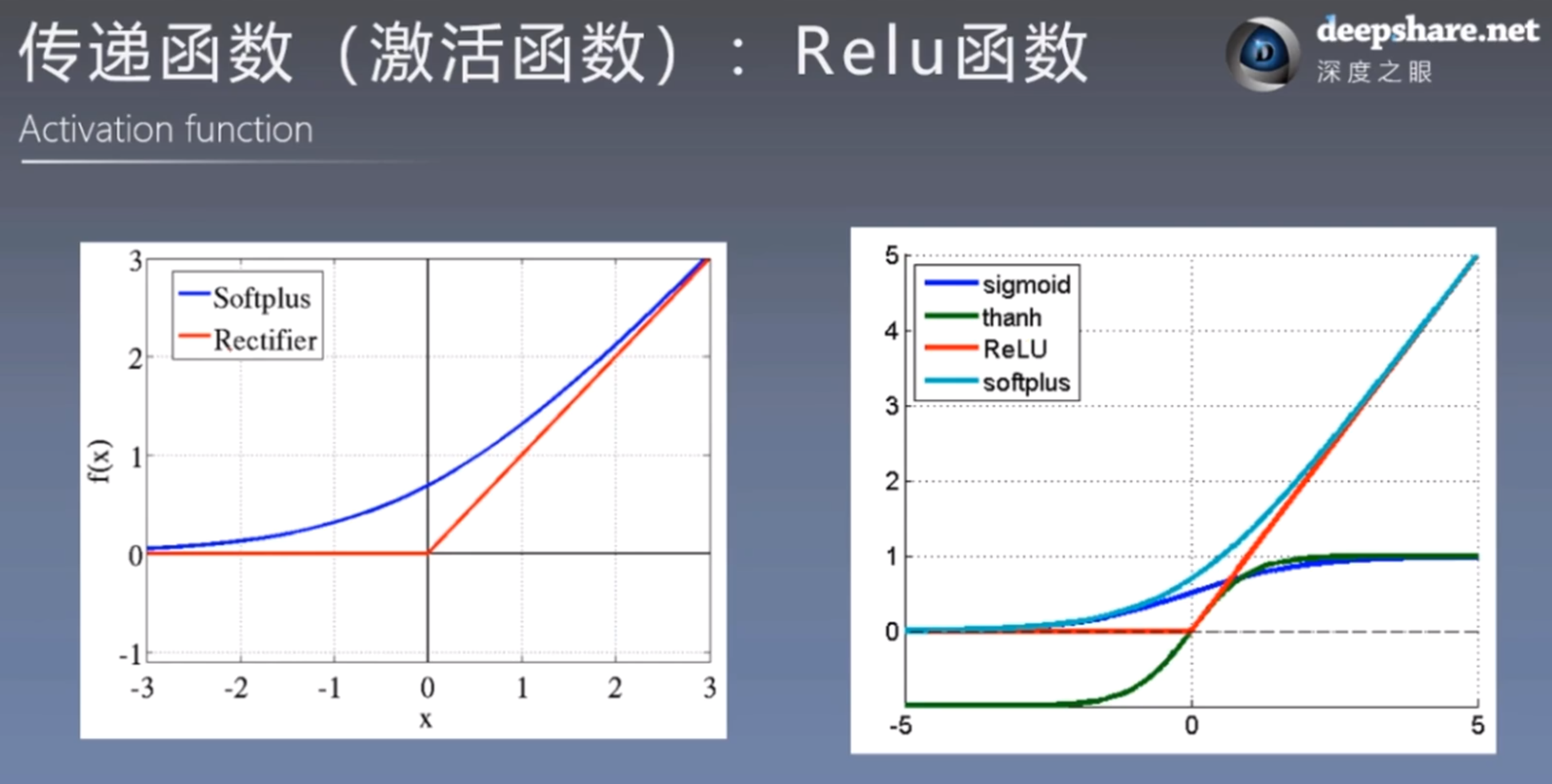

relu函数在x大于零的时候它的梯度永远是常数,就是说它的梯度不可能消失在反向传播的时候不可能消失。但是relu函数也有它的缺点因为当x受到噪声扰动的时候就是说x比较小的变化会造成y发生同样的变化就是说他没有sigmoid函数和tanh函数稳定。但是,也有缺点,是没有一个输出值控制的,有可能在训练训练的过程中最后的输出值发散。

对于sigmoid激活函数来讲,当神经元的值在0附近的时候。在反向传播的时候它的权重是比较大的,因为sigmoid函数在0的时候变化最剧烈,在0附近的时候变化最剧烈。

对于relu激活函数而言,当自变量的值大于0的时候。所有神经元所起的作用都是一样的,因为它的导数或者说梯度都相同。

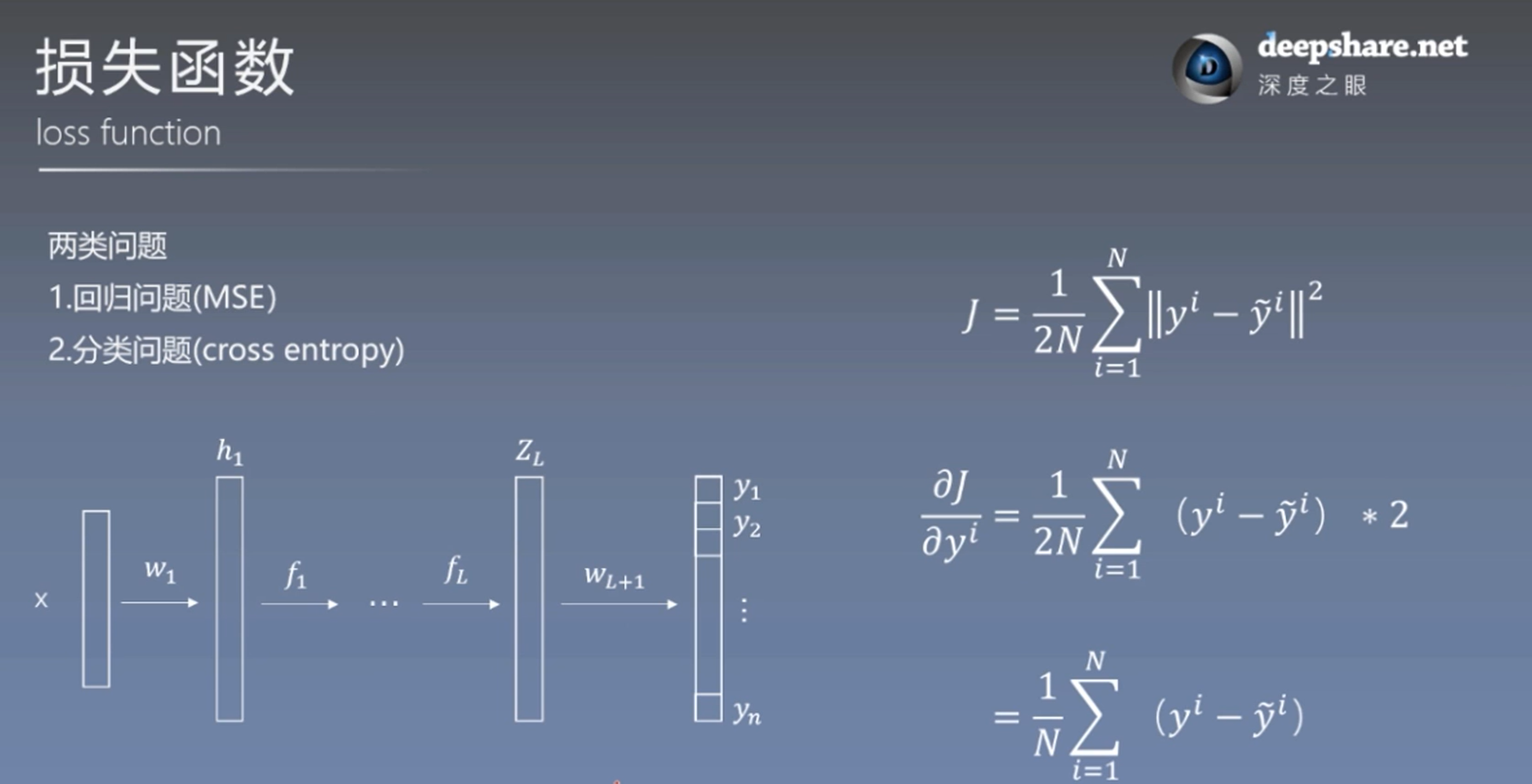

对于一个输出节点而言,损失函数,对于某个节点的梯度就是输出值减去标签值。