hadoop压缩包下载:

链接:https://pan.baidu.com/s/1dz0Hh75VNKEebcYcbN-4Hw

提取码:g2e3

java压缩包下载:

链接:https://pan.baidu.com/s/1DriDVSKQWAQme0QuoiEnQg

提取码:cmag

centos7的安装和配置可以再网上搜到,但是在安装的时候一定要注意要选择图形化界面安装,这样在进行后续的操作的时候比较方便

本人实在vbox上面安装的

ip地址的配置:https://www.cnblogs.com/xuzhaoyang/p/11264573.html由于centos采用的小红帽的内核所以在文件的结构上大同小异

然后配置本地的yum源,首先将盘片挂载到虚拟机上面之后

mkdir /mnt/cdrom

mount /dev/cdrom /mnt/cdrom

然后将/etc/yum.repos.d路径下的文件都删除,然后创建本地的yum源

vi /etc/yum.repos.d/CentOS-local.repo

文件里面输入

[base-local]#这个是本源的名字,不能和其他的重复(随便,不重复)

name=CentOS-local #名字(随便)

baseurl=file:///mnt/cdrom #上方步骤一挂载镜像创建的目录

enabled=1 #yum源是否启用 1-启用 0-不启用

gpgcheck=1 #安全检测 1-开启 0-不开启

gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-CentOS-7

然后保存,这样本地的yum源就配置好了

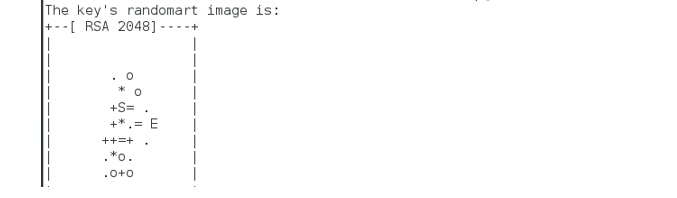

一、 安装ssh免密登录

命令:ssh-keygen

overwrite(覆盖写入)输入y

一路回车

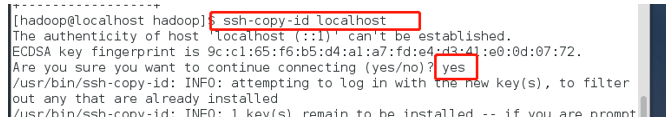

将生成的密钥发送到本机地址

ssh-copy-id localhost

(若报错命令无法找到则需要安装openssh-clients)

yum –y install openssh-clients

测试免密设置是否成功

ssh localhost date

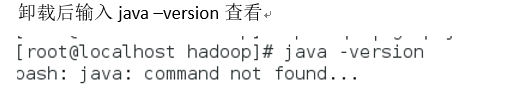

卸载已有java

确定JDK版本

rpm –qa | grep jdk

rpm –qa | grep gcj

如果有版本号的话,

切换到root用户,根据结果卸载java

yum -y remove java-1.8.0-openjdk-headless.x86_64

yum -y remove java-1.7.0-openjdk-headless.x86_64

一、 安装java

切换回hadoop用户,命令:su hadoop

查看下当前目标文件,命令:ls,查看当前路径下的文件

新建一个app文件夹,命令:mkdir app

将桌面的hadoop文件夹中的java及hadoop安装包移动到app文件夹中,可以使用Xftp进行传输,Xftp使用步骤参考:https://www.cnblogs.com/xuzhaoyang/p/11264587.html

解压java程序包,命令:tar –zxvf jdk-7u79-linux-x64.tar.gz

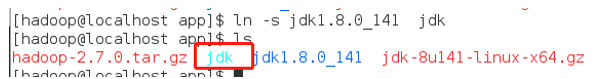

创建软连接

ln –s jdk1.8.0_141 jdk

配置jdk环境变量

切换到root用户

再输入vi /etc/profile

输入

export JAVA_HOME=/home/hadoop/app/jdk1.8.0_141

export JAVA_JRE=JAVA_HOME/jre

export CLASSPATH=.:$JAVA_HOME/lib:$JAVA_JRE/lib

export PATH=$PATH:$JAVA_HOME/bin

保存退出,并使/etc/profile文件生效

source /etc/profile

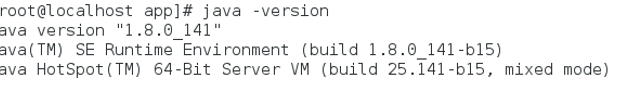

能查询jdk版本号,说明jdk安装成功

java -version

安装hadoop

切换回hadoop用户,解压缩hadoop-2.6.0.tar.gz安装包

创建软连接,命令:ln -s hadoop-2.7.0 hadoop

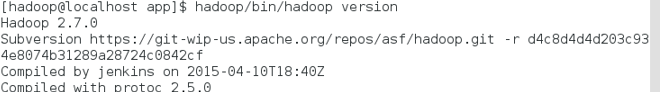

然后验证单机模式的Hadoop是否安装成功,命令:

hadoop/bin/hadoop version

配置伪分布式登录

进入hadoop/etc/hadoop目录,修改相关配置文件

cd etc/

cd hadoop/

修改core-site.xml配置文件

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>file:/home/hadoop/data/tmp</value>

</property>

<property>

<name>hadoop.proxyuser.hadoop.hosts</name>

<value>*</value>

</property>

<property>

<name>hadoop.proxyuser.hadoop.groups</name>

<value>*</value>

</property>

</configuration>

修改hdfs-site.xml配置文件

<configuration>

<property>

<name>dfs.namenode.name.dir</name>

<value>/home/hadoop /data/dfs/name</value>

<final>true</final>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>/home/hadoop /data/dfs/data</value>

<final>true</final>

</property>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.permissions</name>

<value>false</value>

</property>

</configuration>

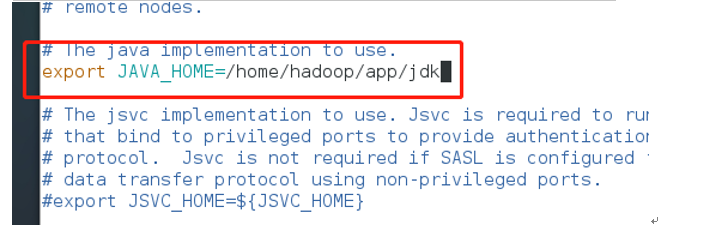

修改hadoop-env.sh配置文件 vi ~/app/Hadoop/etc/Hadoop/Hadoop-env.sh

修改mapred-site.xml.template配置文件

<configuration>

<property>

<name>mapreduce.frameword.name</name>

<value>yarn</value>

</property>

</configuration>

修改yarn-site.xml配置文件

<property>

<name>yarn.nodemanager.aux-servies</name>

<value>mapreduce_shuffle</value>

</property>

</configuration>

配置hadoop环境变量 vi ~/.bashrc

JAVA_HOME=/home/localhost/app/jdk HADOOP_HOME=/home/localhost/app/hadoop CLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar PATH=$JAVA_HOME/bin:$HADOOP_HOME/bin:$PATH export JAVA_HOME CLASSPATH PATH HADOOP_HOME

使修改生效,命令:source ~/.bashrc

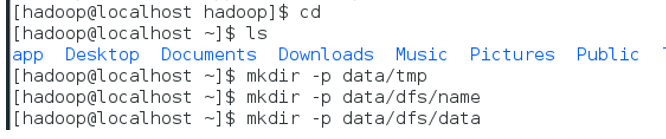

在hadoop相关配置文件中配置了多个数据目录,提前建立这些文件夹

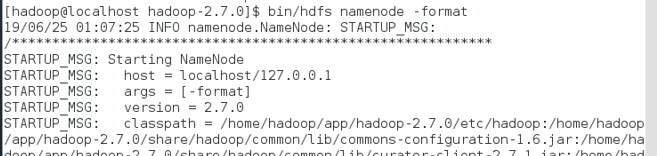

格式化namenode

在启动hadoop集群前需要格式化namenode。需要注意的是,第一次安装Hadoop集群的时候需要格式化Namenode,以后直接启动Hadoop集群即可,不需要重复格式化Namenode。

切回到hadoop目录,输入如下命令:

bin/hdfs namenode -format

启动hadoop伪分布式集群

sbin/start-all.sh