1. 损失函数角度

对一个多分类问题,我们一般用onehot编码来表示label,比如猫、老虎、狗的3分类问题,label为[ 1 , 0 , 0 ] ,交叉熵损失只于当前类别有关,与其它类别无关,

在均方误差看来,预测为[ 0.8 , 0.1 , 0.1 ] [0.8, 0.1, 0.1][0.8,0.1,0.1]要比[ 0.8 , 0.15 , 0.05 ] [0.8, 0.15, 0.05][0.8,0.15,0.05]要好,即认为平均总比有倾向性要好,但这有悖我们的常识。

而对交叉熵损失,既然类别间复杂的相似度矩阵是难以量化的,索性只能关注样本所属的类别,只要当前类别的该类别的概率接近1就好来,更合理。

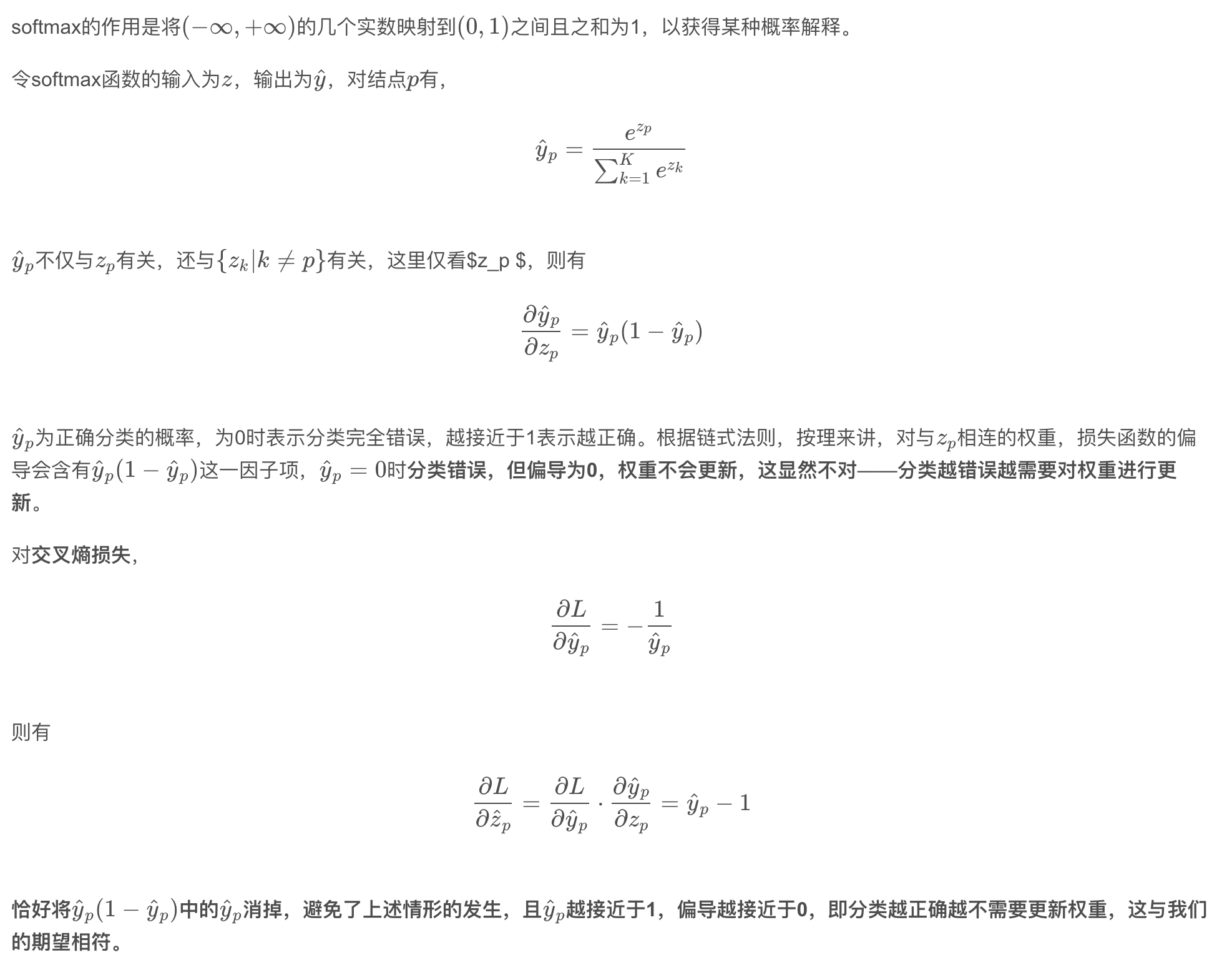

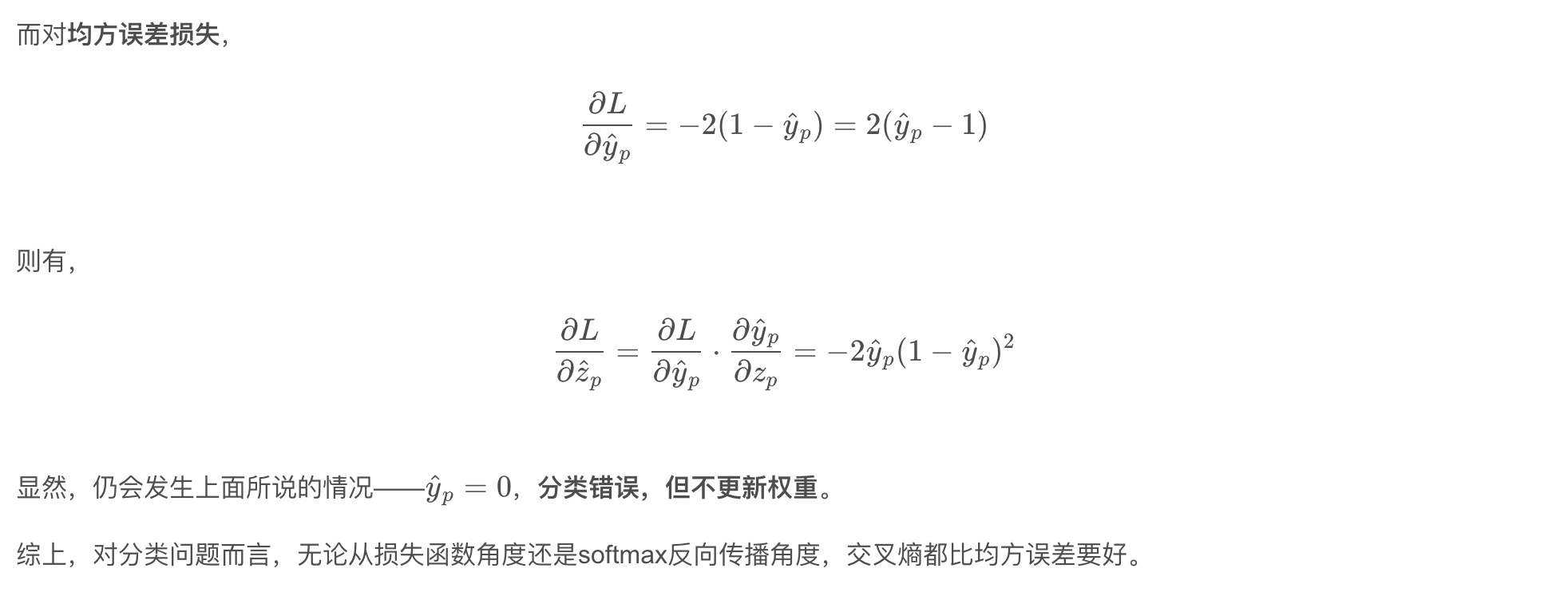

2. softmax(sigmoid)反向传播角度