遇到的问题

参考自:

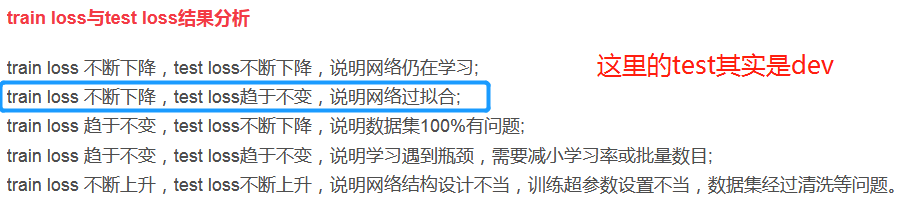

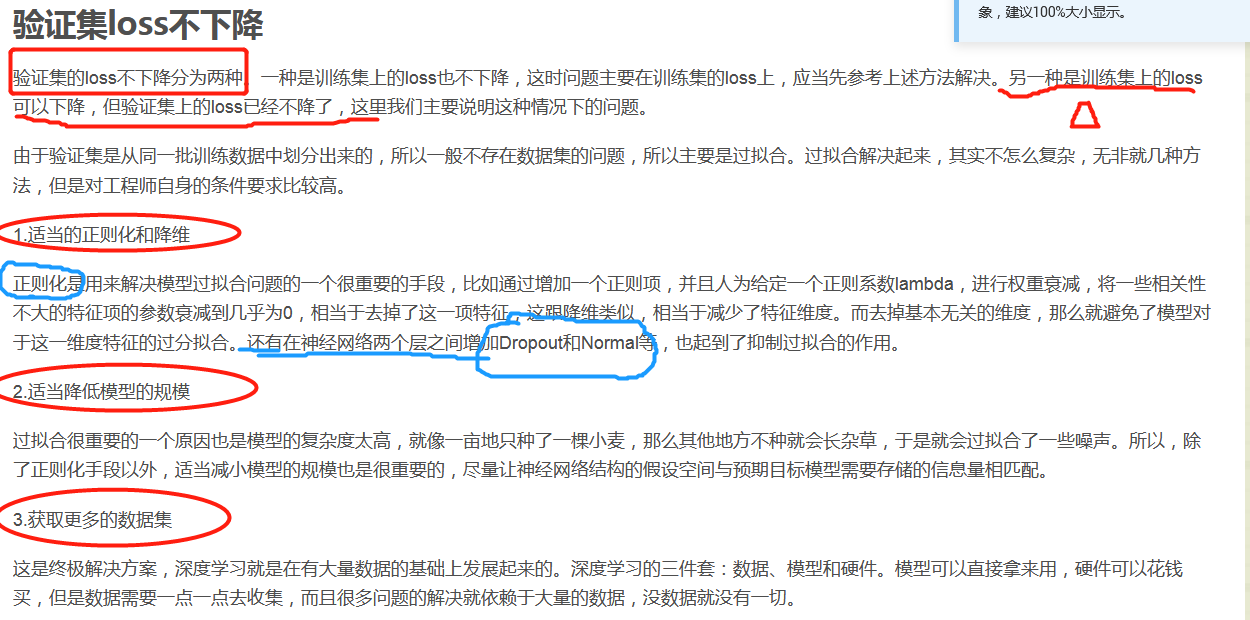

该博文分析了模型训练过程中三种loss不下降的情况,并给出了一些解决的思路。

其他可能的情况

1 网络层没有初始化参数

2 超参数设定不合理

2.1 训练的epoch太少

看到的只是局部情况,最终要的其实是整体收敛就行,也许训练100、1000、10000试试?

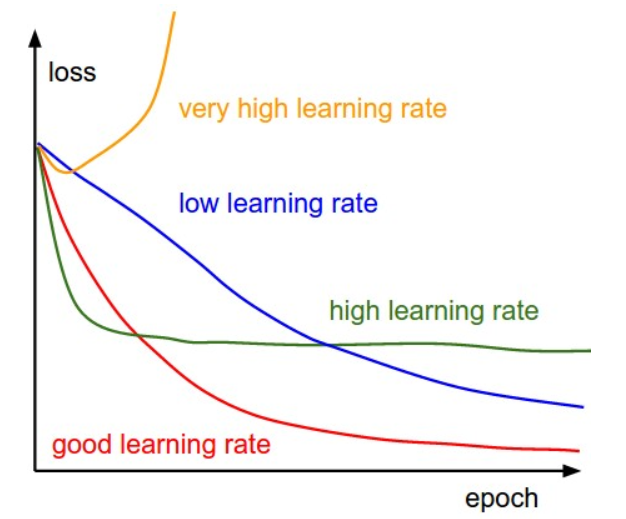

2.2 学习率过高或者过低?

合适的学习率可以保证每轮完整训练之后,loss都减小,且能在一段时间后降到一个较小的程度。太小的学习率下loss减小的速度很慢,如果太激进,设置太高的学习率,开始的loss减小速度非常可观,可是到了某个程度之后就不再下降了,在离最低点一段距离的地方反复,无法下降了。

3 是否正则化

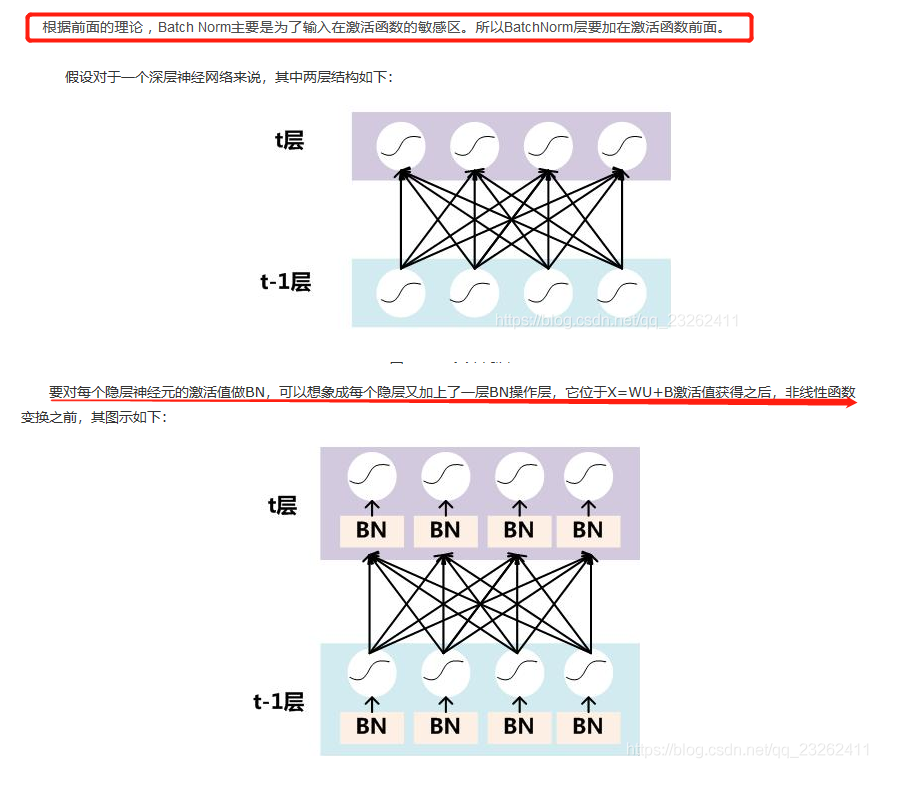

4 是否批量标准化

参考https://blog.csdn.net/qq_23262411/article/details/100175943

5 疑问-是否需要更新预训练嵌入的梯度?

6 网络深度不够

可以尝试的方法