背景

之前热门的目标检测方法都是two stage的,即分为region proposal和classification两个阶段,本文是对one stage方法的初次探索。

方法

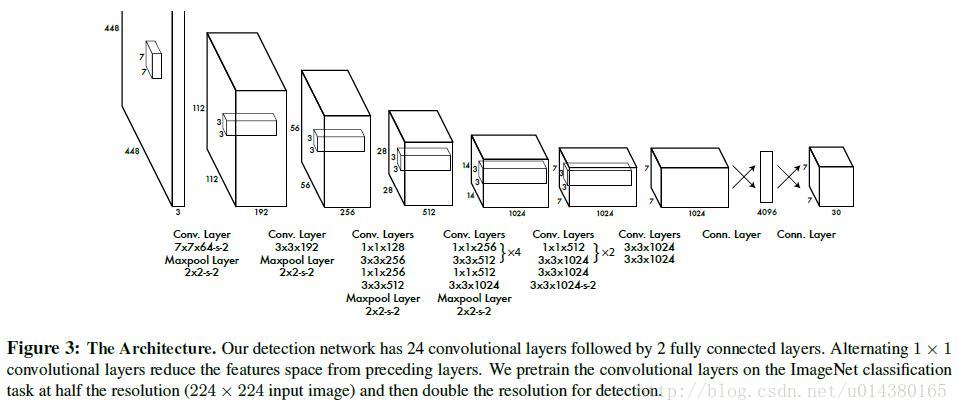

首先看一下模型的网络结构,输入的原图片,经过24个卷积层提取特征,全连接层输出一个7*7*30的tensor,这个tensor里面就包含我们预测的结果了。

那么这个7*7*30的tensor包含哪些信息呢?

首先,7*7可以映射到448*448的原图片中,得到7*7个64*64的grid cell,对于原图中的每一个目标,中心点落在哪个grid cell里,就交给它来预测。

而每个grid cell可以预测两个目标的位置(x,y,w,h),还有他们的置信度confidence=Pr(Object)*IOU,但是论文里面规定两个目标类别一致,所以再加上class属性,一共20种。

2*4+2+20=30

总结

YOLO v1比较简单,用回归的思想做检测,但在读论文的时候明显能感觉到有很多人为的特殊规定,所以效果也一般般。

缺点

检测的位置不准;密集物体检测的效果不好(只要一个grid cell里面的物体多于2个就检测不到了)。