在这里我给大家继续分享一些关于HDFS分布式文件的经验哈,其中包括一些hdfs的基本的shell命令的操作,再加上hdfs java程序设计。在前面我已经写了关于如何去搭建hadoop这样一个大数据平台,还没搭好环境的童鞋可以转到我写的这篇文章Hadoop在Ubuntu的安装,接下来就开始我们本次的经验分享啦。

HDFS的Shell命令操作

HDFS的格式化与启动

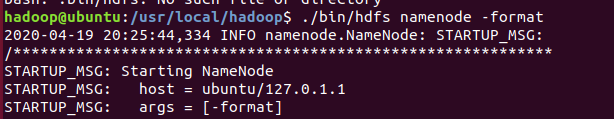

首次使用HDFS时,需要使用format 命令进行格式化

./bin/hdfs namenode -format

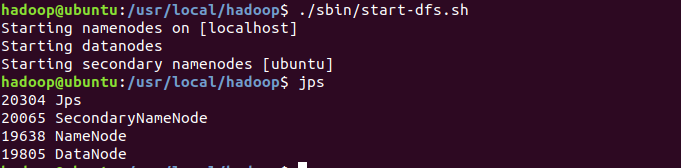

使用start-dfs.sh命令启动HDFS,可 使用JPS命令查看是否成功启动

./sbin/start-dfs.sh

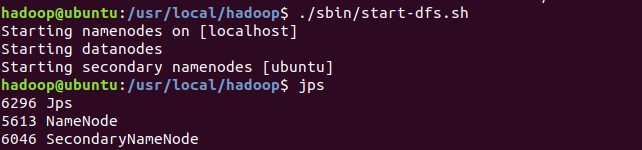

下面的图片是启动失败的截图,那么怎么解决这个问题呢。

HDFS启动失败

首先需要停止hdfs,这也是操作完hdfs的必要步骤。

./sbin/stop-dfs.sh

删除tmp/dfs目录下的data文件夹

rm -r ./tmp/dfs/data

最后重新执行HDFS的格式化与启动操作。

启动成功包括出现NameNode、SecondDaryNameNode、以及DataNode。

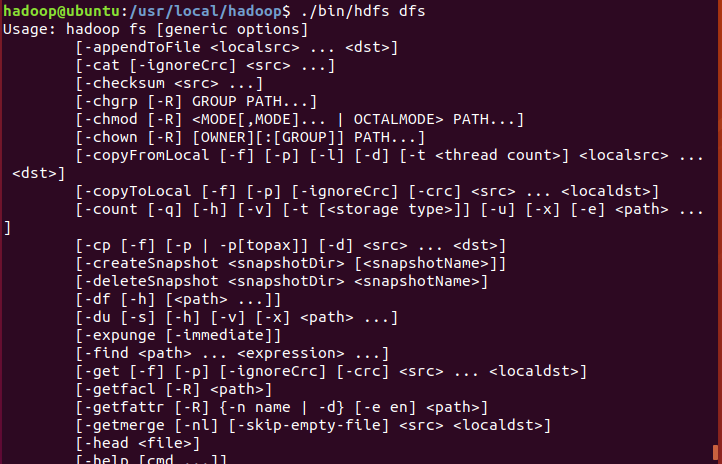

HDFS支持的命令

查看hdfs支持的所有命令

./bin/hdfs dfs

Ps:查看hadoop下put的使用方法

./bin/hadoop fs -help put

HDFS文件系统中目录创建操作

创建用户目录

Hadoop系统安装好以后,第一次使用HDFS时,需要首先在HDFS中创建用户目录。

./bin/hdfs dfs -mkdir -p /user/hadoop

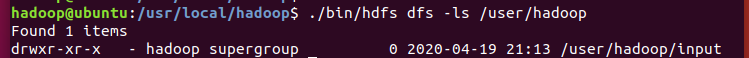

用查询命令查看我们在路径user下面创建的文件夹hadoop

./bin/hdfs dfs -ls /user

创建二级目录

在hadoop目录下再创建一个input文件夹

./bin/hdfs dfs -mkdir /user/hadoop/input

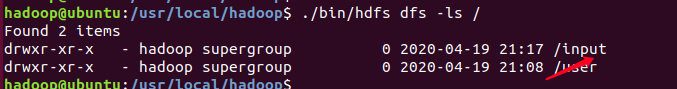

根目录下创建目录

在hadoop根目录下创建一个input文件夹

./bin/hdfs dfs -mkdir /input

HDFS文件系统中目录删除操作

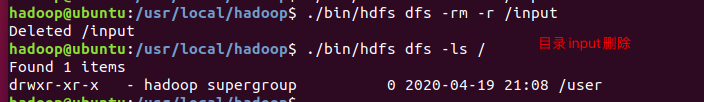

删除在hadoop根目录下面创建的input文件夹

./bin/hdfs dfs -rm -r /input

可以看到,hadoop根目录下的input文件夹已经被我们成功删除,现在只有存在user目录。

Hadoop的文件操作

创建文件的方式

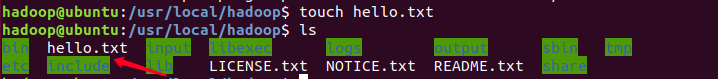

在当前环境目录下创建hello.txt文件,这里介绍两种方法。

number one

touch hello.txt

打开hello.txt文件,并写入如下内容并保存。

hello world

gedit hello.txt

number t two

利用vim编辑创建hello.txt。

vim hello.txt

关于vim怎么建立简单的文本文件我就不在这里解释了,不会的童鞋可以找找度娘。

传输文件

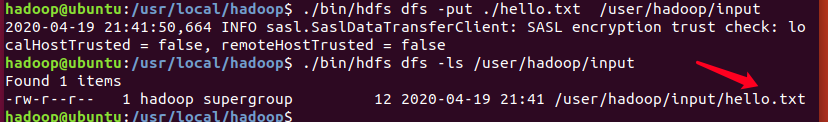

利用put命令将创建的hello.txt文件上传到user/hadoop/input的目录

./bin/hdfs dfs -put ./hello.txt /user/hadoop/input

/bin/hdfs dfs -ls /user/hadoop/input

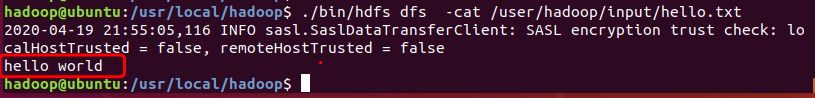

在user/hadoop/input目录下利用cat命令查看hello.txt文件内容

./bin/hdfs dfs -cat /user/hadoop/input/hello.txt

HDFS中的文件下载到本地文件系统

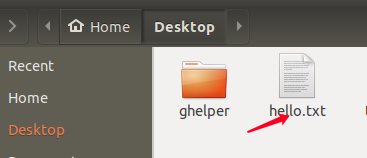

使用-get命令将HDFS中的hello.txt文件下载到本地文件系统中的/home/hadoop/Desktop这个目录下:

./bin/hdfs dfs -get /user/hadoop/input/hello.txt /home/hadoop/Desktop

本次给大家分享的内容就到这里啦,觉得还不错的点个赞支持一下小编,你的肯定就是小编前进的动力。另外如果想了解更多计算机专业的知识和技巧的,献上我的个人博客北徯,另外需要各种资料的童鞋,可以关注我的微信公众号北徯,免费的PPT模板,各种资料等你来领。