一、安装方式介绍

1、yum 安装

目前CentOS官方已经把Kubernetes源放入到自己的默认 extras 仓库里面,使用 yum 安装,好处是简单,坏处也很明显,需要官方更新 yum 源才能获得最新版本的软件,而所有软件的依赖又不能自己指定,尤其是你的操作系统版本如果低的话,使用 yum 源安装的 Kubernetes 的版本也会受到限制,通常会低于官方很多版本,我安装的时候目前官方版本为1.12,而 yum 源中的版本为1.5.2。

请查看博文:http://blog.51cto.com/wzlinux/2321767

2、二进制安装

使用二进制文件安装,好处是可以安装任意版本的 Kubernetes,对一些新版本新功能追求的同学比较合适,坏处是配置比较复杂,很多软件包因为一些原因,我们在大陆是访问不到的。

3、Kubeadm 安装

kubeadm 是 Kubernetes 官方提供的用于快速安装 Kubernetes 集群的工具,伴随Kubernetes每个版本的发布都会同步更新,kubeadm会对集群配置方面的一些实践做调整,通过实验 kubeadm 可以学习到 Kubernetes 官方在集群配置上一些新的最佳实践。

请查看博文:http://blog.51cto.com/wzlinux/2322616

这里我们选用第二种方式安装。

二、环境准备

1、软件版本

我们安装的版本基本是目前最新的版本。

| 软件 | 版本 |

|---|---|

| kubernetes | v1.12.2 |

| CentOS 7.5 | CentOS Linux release 7.5.1804 |

| Docker | v18.06 这是官方推荐的 |

| etcd | 3.3.10 |

| flannel | 0.10.0 |

2、节点规划

| IP | 角色 | 安装软件 |

|---|---|---|

| 172.18.8.200 | k8s master | etcd,kube-apiserver,kube-controller-manager,kube-scheduler,kubelet |

| 172.18.8.201 | k8s node01 | docker,kubelet,kube-proxy,flannel |

| 172.18.8.202 | k8s node02 | docker,kubelet,kube-proxy,flannel |

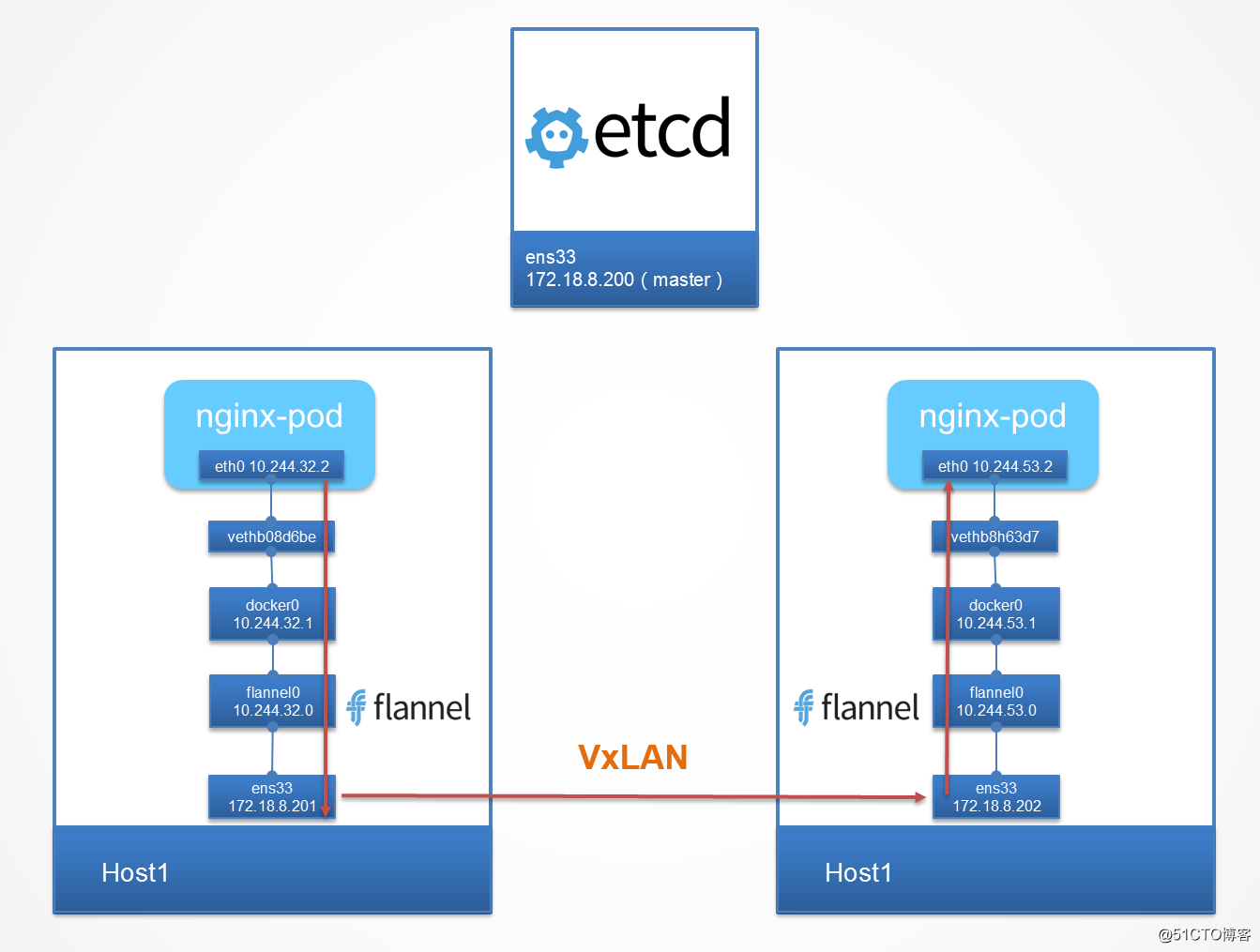

节点及网络规划如下:

3、系统配置

关闭防火墙。

systemctl stop firewalld

systemctl disable firewalld

配置/etc/hosts,添加如下内容。

172.18.8.200 master.wzlinux.com master

172.18.8.201 node01.wzlinux.com node01

172.18.8.202 node02.wzlinux.com node02

关闭SELinux。

sed -i 's#SELINUX=enforcing#SELINUX=disabled#g' /etc/selinux/config

setenforce 0

关闭swap。

swapoff -a

sed -i 's/.*swap.*/#&/' /etc/fstab

4、二进制软件包下载

我们可以下载编译好的二进制文件,也可以下载源码自己编译,这里只讨论二进制的安装方式。在Kubernetes的Github CHANGELOG日志中可以看到最新的版本号,也可以到Tag页面中找到自己需要的版本,我下载的是 v1.12.2。

上传我们下载的二进制软件包到各节点,并解压在root家目录,查看目录内容。

[root@master ~]# ll kubernetes/server/bin/

total 1821524

-rwxr-xr-x 1 root root 60859975 Oct 24 15:49 apiextensions-apiserver

-rwxr-xr-x 1 root root 142923436 Oct 24 15:49 cloud-controller-manager

-rw-r--r-- 1 root root 8 Oct 24 15:44 cloud-controller-manager.docker_tag

-rw-r--r-- 1 root root 144309760 Oct 24 15:44 cloud-controller-manager.tar

-rwxr-xr-x 1 root root 248021112 Oct 24 15:49 hyperkube

-rwxr-xr-x 1 root root 54042644 Oct 24 15:49 kubeadm

-rwxr-xr-x 1 root root 192781649 Oct 24 15:49 kube-apiserver

-rw-r--r-- 1 root root 8 Oct 24 15:44 kube-apiserver.docker_tag

-rw-r--r-- 1 root root 194167808 Oct 24 15:44 kube-apiserver.tar

-rwxr-xr-x 1 root root 162961401 Oct 24 15:49 kube-controller-manager

-rw-r--r-- 1 root root 8 Oct 24 15:44 kube-controller-manager.docker_tag

-rw-r--r-- 1 root root 164347392 Oct 24 15:44 kube-controller-manager.tar

-rwxr-xr-x 1 root root 57352138 Oct 24 15:49 kubectl

-rwxr-xr-x 1 root root 176648680 Oct 24 15:49 kubelet

-rwxr-xr-x 1 root root 50330867 Oct 24 15:49 kube-proxy

-rw-r--r-- 1 root root 8 Oct 24 15:44 kube-proxy.docker_tag

-rw-r--r-- 1 root root 98355200 Oct 24 15:44 kube-proxy.tar

-rwxr-xr-x 1 root root 57184656 Oct 24 15:49 kube-scheduler

-rw-r--r-- 1 root root 8 Oct 24 15:44 kube-scheduler.docker_tag

-rw-r--r-- 1 root root 58570752 Oct 24 15:44 kube-scheduler.tar

-rwxr-xr-x 1 root root 2330265 Oct 24 15:49 mounter

这些包都是存储在google的服务器上面,因为众所周知的原因,我们是无法访问的,所以需要各位科学上网才可以获取,不过我可以把我获取的包传到网盘分享给大家。

大家可以去下载使用。链接: https://pan.baidu.com/s/1Ut9VERgm55B4lmz0wjjzFQ 提取码: mjem

三、安装master

master节点需要安装的服务有kube-apiserver,kube-controller-manager,kube-scheduler,所以我们先把需要的二进制文件放到环境变量。

cd /root/kubernetes/server/bin

cp kube-apiserver kube-controller-manager kube-scheduler kubectl /usr/local/bin/

创建需要的目录。

mkdir -p /var/lib/etcd

mkdir -p /etc/etcd/

mkdir /etc/kubernetes

mkdir /etc/kubernetes/ssl

1、安装etcd

因为所以的组件都是需要etcd存储,所以我们第一安装的就是etcd,如果不是为了新版本,为了方便可以使用yum安装。

我这里采用二进制安装方法,首先下载安装包。

下载。

wget https://github.com/etcd-io/etcd/releases/download/v3.3.10/etcd-v3.3.10-linux-amd64.tar.gz

解压安装。

tar xf etcd-v3.3.10-linux-amd64.tar.gz

cd etcd-v3.3.10-linux-amd64

cp etcd etcdctl /usr/local/bin/

创建system启动文件etcd.service。

cat <<EOF > /usr/lib/systemd/system/etcd.service

[Unit]

Description=Etcd Server

After=network.target

After=network-online.target

Wants=network-online.target

[Service]

Type=notify

TimeoutStartSec=0

Restart=always

WorkingDirectory=/var/lib/etcd

EnvironmentFile=-/etc/etcd/etcd.conf

ExecStart=/usr/local/bin/etcd

Restart=on-failure

[Install]

WantedBy=multi-user.target

EOF

创建配置文件。

cat <<EOF >/etc/etcd/etcd.conf

ETCD_NAME=ETCD Server

ETCD_DATA_DIR="/var/lib/etcd/"

ETCD_LISTEN_CLIENT_URLS=http://0.0.0.0:2379

ETCD_ADVERTISE_CLIENT_URLS="http://172.18.8.200:2379"

EOF

启动etcd。

systemctl daemon-reload

systemctl start etcd.service

systemctl enable etcd.service

查看启动状态。

[root@master ~]# netstat -tlnp|grep etcd

tcp 0 0 127.0.0.1:2380 0.0.0.0:* LISTEN 1550/etcd

tcp6 0 0 :::2379 :::* LISTEN 1550/etcd

[root@master ~]# etcdctl cluster-health

member 8e9e05c52164694d is healthy: got healthy result from http://172.18.8.200:2379

cluster is healthy

说明: etcd 会启用两个端口,其中2380 是集群的通信端口,2379是服务端口。如果是配置etcd集群,则要修改配置文件,设置监听IP和端口。

2、安装 kube-apiserver

创建启动文件/usr/lib/systemd/system/kube-apiserver.service,修改为如下内容:

[Unit]

Description=Kubernetes API Server

Documentation=https://github.com/GoogleCloudPlatform/kubernetes

After=network.target

After=etcd.service

[Service]

EnvironmentFile=/etc/kubernetes/apiserver

ExecStart=/usr/local/bin/kube-apiserver

$KUBE_ETCD_SERVERS

$KUBE_BIND_ADDRESS

$KUBE_API_PORT

$KUBE_SERVICE_ADDRESSES

$KUBE_ADMISSION_CONTROL

$KUBE_API_ARGS

Restart=on-failure

Type=notify

LimitNOFILE=65536

[Install]

WantedBy=multi-user.target

创建目录和配置文件。

cat <<EOF > /etc/kubernetes/apiserver

KUBE_BIND_ADDRESS="--bind-address=0.0.0.0"

KUBE_API_PORT="--secure-port=6443"

KUBE_ETCD_SERVERS="--etcd-servers=http://172.18.8.200:2379"

KUBE_SERVICE_ADDRESSES="--service-cluster-ip-range=10.96.0.0/12"

KUBE_ADMISSION_CONTROL="--enable-admission-plugins=NamespaceLifecycle,LimitRanger,SecurityContextDeny,ServiceAccount,DefaultStorageClass,ResourceQuota"

KUBE_API_ARGS="--client-ca-file=/etc/kubernetes/ssl/ca.crt

--tls-private-key-file=/etc/kubernetes/ssl/server.key --tls-cert-file=/etc/kubernetes/ssl/server.crt"

EOF

service-cluster-ip-range是servcies的虚拟IP的IP范围,这里可以自己定义,不能当前的宿主机网段重叠。

bind-addres 指定的apiserver监听地址,对应的监听端口是6443,使用的https的方式。

client-ca-file 这是认证的相关文件,这预先定义,后面会创建证书文件,并放置到对应的路径。

3、安装kube-controller-manager

创建启动文件/usr/lib/systemd/system/kube-controller-manager.service,添加如下内容:

[Unit]

Description=Kubernetes Controller Manager

Documentation=https://github.com/GoogleCloudPlatform/kubernetes

After=kube-apiserver.service

Requires=kube-apiserver.service

[Service]

EnvironmentFile=-/etc/kubernetes/controller-manager

ExecStart=/usr/local/bin/kube-controller-manager

$KUBE_MASTER

$KUBE_CONTROLLER_MANAGER_ARGS

Restart=on-failure

LimitNOFILE=65536

[Install]

WantedBy=multi-user.target

创建配置文件controller-manager,IP根据自己的实际情况进行修改。

cat <<EOF > /etc/kubernetes/controller-manager

KUBE_MASTER="--master=https://172.18.8.200:6443"

KUBE_CONTROLLER_MANAGER_ARGS="--service-account-private-key-file=/etc/kubernetes/ssl/server.key

--root-ca-file=/etc/kubernetes/ssl/ca.crt --kubeconfig=/etc/kubernetes/kubeconfig"

EOF

4、安装kube-scheduler

创建启动文件/usr/lib/systemd/system/kube-scheduler.service,添加如下内容:

[Unit]

Description=Kubernetes Scheduler Plugin

Documentation=https://github.com/GoogleCloudPlatform/kubernetes

After=kube-apiserver.service

Requires=kube-apiserver.service

[Service]

EnvironmentFile=/etc/kubernetes/scheduler

ExecStart=/usr/local/bin/kube-scheduler

$KUBE_MASTER

$KUBE_SCHEDULER_ARGS

Restart=on-failure

LimitNOFILE=65536

[Install]

WantedBy=multi-user.target

创建配置文件/etc/kubernetes/scheduler。

cat <<EOF > /etc/kubernetes/scheduler

KUBE_MASTER="--master=https://172.18.8.200:6443"

KUBE_SCHEDULER_ARGS="--kubeconfig=/etc/kubernetes/kubeconfig"

EOF

5、创建kubeconfig文件

创建/etc/kubernetes/kubeconfig文件。

apiVersion: v1

kind: Config

users:

- name: controllermanager

user:

client-certificate: /etc/kubernetes/ssl/cs_client.crt

client-key: /etc/kubernetes/ssl/cs_client.key

clusters:

- name: kubernetes

cluster:

certificate-authority: /etc/kubernetes/ssl/ca.crt

contexts:

- context:

cluster: kubernetes

user: controllermanager

name: service-account-context

current-context: service-account-context

6、创建CA证书

配置kube-apiserver的CA证书和私钥文件。

cd /etc/kubernetes/ssl/

openssl genrsa -out ca.key 2048

# CN指定Master的IP地址

openssl req -x509 -new -nodes -key ca.key -subj "/CN=172.18.8.200" -days 5000 -out ca.crt

openssl genrsa -out server.key 2048

创建master_ssl.cnf文件,内容如下:

[req]

req_extensions = v3_req

distinguished_name = req_distinguished_name

[req_distinguished_name]

[ v3_req ]

basicConstraints = CA:FALSE

keyUsage = nonRepudiation, digitalSignature, keyEncipherment

subjectAltName = @alt_names

[alt_names]

DNS.1 = kubernetes

DNS.2 = kubernetes.default

DNS.3 = kubernetes.default.svc

DNS.4 = kubernetes.default.svc.cluster.local

DNS.5 = k8s_master

IP.1 = 10.96.0.1 # ClusterIP 地址

IP.2 = 172.18.8.200 # master IP地址

基于上述文件,创建server.csr和 server.crt文件,执行如下命令。

# CN指定主机名

openssl req -new -key server.key -subj "/CN=master.wzlinux.com" -config master_ssl.cnf -out server.csr

openssl x509 -req -in server.csr -CA ca.crt -CAkey ca.key -CAcreateserial -days 5000 -extensions v3_req -extfile master_ssl.cnf -out server.crt

设置kube-controller-manager相关证书。

cd /etc/kubernetes/ssl/

openssl genrsa -out cs_client.key 2048

# CN指定主机名

openssl req -new -key cs_client.key -subj "/CN=master.wzlinux.com" -out cs_client.csr

openssl x509 -req -in cs_client.csr -CA ca.crt -CAkey ca.key -CAcreateserial -out cs_client.crt -days 5000

确保/etc/kubernetes/ssl/ 目录下有如下文件。

[root@master ssl]# ll

total 40

-rw-r--r-- 1 root root 1103 Nov 28 21:58 ca.crt

-rw-r--r-- 1 root root 1679 Nov 28 21:58 ca.key

-rw-r--r-- 1 root root 17 Nov 28 22:07 ca.srl

-rw-r--r-- 1 root root 993 Nov 28 22:07 cs_client.crt

-rw-r--r-- 1 root root 903 Nov 28 22:07 cs_client.csr

-rw-r--r-- 1 root root 1675 Nov 28 22:06 cs_client.key

-rw-r--r-- 1 root root 493 Nov 28 22:01 master_ssl.cnf

-rw-r--r-- 1 root root 1216 Nov 28 22:03 server.crt

-rw-r--r-- 1 root root 1139 Nov 28 22:03 server.csr

-rw-r--r-- 1 root root 1679 Nov 28 21:58 server.key

7、启动服务

启动kube-apiserver。

systemctl daemon-reload

systemctl enable kube-apiserver

systemctl start kube-apiserver

说明:kube-apiserver 默认会启动两个端口(8080和6443),其中,8080是各个组件之间通信的端口,在新的版本中已经很少使用,kube-apiserver所在的主机一般称为Master, 另一个端口6443是为HTTPS提供身份验证和授权的端口。

启动kube-controller-manager。

systemctl daemon-reload

systemctl enable kube-controller-manager

systemctl start kube-controller-manager

说明:此服务会启动一个10252的端口。

启动kube-scheduler。

systemctl daemon-reload

systemctl enable kube-scheduler

systemctl start kube-scheduler

说明: 此服务会启动一个10251的端口

启动各项服务时,分别查看对应的日志和启动状态信息,确认服务没有报错。

使用 kubectl 查看状态。

[root@master ~]# kubectl get cs

NAME STATUS MESSAGE ERROR

etcd-0 Healthy {"health":"true"}

controller-manager Healthy ok

scheduler Healthy ok

四、安装node节点(node01为例)

1、环境准备

node节点需要安装的服务有docker,kubelet,kube-prox,flannel,所以我们先把需要的二进制文件放到环境变量。

cd /root/kubernetes/server/bin/

cp kubelet kube-proxy /usr/local/bin/

加载ipvs内核,使node节点kube-proxy支持ipvs代理规则。

modprobe ip_vs_rr

modprobe ip_vs_wrr

modprobe ip_vs_sh

创建需要的目录。

mkdir /var/lib/kubelet

mkdir /etc/kubernetes

mkdir /etc/kubernetes/ssl

配置转发参数。

cat <<EOF > /etc/sysctl.d/k8s.conf

net.bridge.bridge-nf-call-ip6tables = 1

net.bridge.bridge-nf-call-iptables = 1

EOF

sysctl --system

2、安装docker-ce

我们使用推荐的版本18.06,此时docker官方的最新版本为18.09,所以我们需要配置官方yum源。

wget https://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo -P /etc/yum.repos.d/

查看需要安装的版本。

yum list docker-ce.x86_64 --showduplicates |sort -r

yum install docker-ce-18.06.1.ce -y

配置加速器。

sudo mkdir -p /etc/docker

sudo tee /etc/docker/daemon.json <<-'EOF'

{

"registry-mirrors": ["https://hdi5v8p1.mirror.aliyuncs.com"]

}

EOF

2、创建需要的证书

复制Master上的ca.crt,ca.key到node节点上的ssl目录,执行如下命令生成kubelet_client.crt和kubelet_client.csr文件

cd /etc/kubernetes/ssl/

openssl genrsa -out kubelet_client.key 2048

# CN指定Node节点的IP

openssl req -new -key kubelet_client.key -subj "/CN=172.18.8.201" -out kubelet_client.csr

openssl x509 -req -in kubelet_client.csr -CA ca.crt -CAkey ca.key -CAcreateserial -out kubelet_client.crt -days 5000

3、安装 kube-proxy 服务

创建启动文件/usr/lib/systemd/system/kube-proxy.service,添加如下内容:

[Unit]

Description=Kubernetes Kube-Proxy Server

Documentation=https://github.com/GoogleCloudPlatform/kubernetes

After=network.target

[Service]

EnvironmentFile=/etc/kubernetes/proxy

ExecStart=/usr/local/bin/kube-proxy

$KUBE_MASTER

$KUBE_PROXY_ARGS

Restart=on-failure

LimitNOFILE=65536

[Install]

WantedBy=multi-user.target

创建需要的配置文件,IP请根据自己的实际情况进行修改。

cat <<EOF > /etc/kubernetes/proxy

KUBE_MASTER="--master=http://172.18.8.200:8080"

KUBE_PROXY_ARGS="--kubeconfig=/etc/kubernetes/kubeconfig.yaml"

EOF

3、安装 kubelete 服务

创建启动文件/usr/lib/systemd/system/kubelet.service,新增如下内容:

[Unit]

Description=Kubernetes Kubelet Server

Documentation=https://github.com/GoogleCloudPlatform/kubernetes

After=docker.service

Requires=docker.service

[Service]

WorkingDirectory=/var/lib/kubelet

ExecStart=/usr/local/bin/kubelet --kubeconfig=/etc/kubernetes/kubeconfig.yaml

Restart=on-failure

[Install]

WantedBy=multi-user.target

创建配置文件/etc/kubernetes/kubeconfig.yaml,具体参数请根据自己的需求进行修改,新增如下内容:

apiVersion: v1

kind: Config

users:

- name: kubelet

user:

client-certificate: /etc/kubernetes/ssl/kubelet_client.crt

client-key: /etc/kubernetes/ssl/kubelet_client.key

clusters:

- name: kubernetes

cluster:

certificate-authority: /etc/kubernetes/ssl/ca.crt

server: https://172.18.8.200:6443

contexts:

- context:

cluster: kubernetes

user: kubelet

name: service-account-context

current-context: service-account-context

4、启动服务。

启动kubelet。

systemctl daemon-reload

systemctl start kubelet.service

systemctl enable kubelet.service

kubelet的配置文件是一个yaml格式文件,对master的指定需要在配置文件中说明。默认监听10248、10250、10255、4194端口。

在master查看节点。

[root@master ~]# kubectl get nodes

NAME STATUS ROLES AGE VERSION

node01.wzlinux.com Ready <none> 5m7s v1.12.2

node02.wzlinux.com Ready <none> 5m7s v1.12.2

启动kube-proxy。

systemctl daemon-reload

systemctl start kube-proxy.service

systemctl enable kube-proxy.service

说明:启动服务后默认监听10249,10256.

4、配置flannel网络(Pod使用)

我们之所以要单独使用第三方的网络插件来扩展k8s,主要原因是在使用docker的环境中,在每个node节点的docker0默认的网段都是172.17.0.0/16的网络。如果要实现不同宿主node上pod(这里也可以理解为容器)互相通信,就不能使用默认的docker0提供的网段,我们需要部署一个覆盖网络,让每个node节点的docker0网络都处于不同的网段,这样,通过添加一些路由转发策略,就能让集群中各个pod在同一个虚拟的网络中实现通信。

从github官网下载最新版本。

wget https://github.com/coreos/flannel/releases/download/v0.10.0/flannel-v0.10.0-linux-amd64.tar.gz

tar xf flannel-v0.10.0-linux-amd64.tar.gz

cp flanneld /usr/local/bin/

cp mk-docker-opts.sh /usr/local/libexec/

创建启动文件/usr/lib/systemd/system/flanneld.service,新增如下内容:

[Unit]

Description=Flanneld overlay address etcd agent

After=network.target

After=network-online.target

Wants=network-online.target

After=etcd.service

Before=docker.service

[Service]

Type=notify

EnvironmentFile=/etc/sysconfig/flanneld

EnvironmentFile=-/etc/sysconfig/docker-network

ExecStart=/usr/local/bin/flanneld

$FLANNEL_ETCD_ENDPOINTS

$FLANNEL_ETCD_PREFIX

$FLANNEL_OPTIONS

ExecStartPost=/usr/local/libexec/mk-docker-opts.sh -d /run/flannel/docker

Restart=on-failure

[Install]

WantedBy=multi-user.target

RequiredBy=docker.service

对上面的文件做一下解释:

- Flannel网络必须在宿主机网络能对外(其它node节点)正常通信的情况下启动才有意义,所以这里定义

After=network.target - 只有当Flannel 网络启动之后,才能创建一个与其它节点不会冲突的网络,而docker的网络需要和fannel 网络相同才能保证跨主机通信,所以docker必须要在flannel网络创建后才能启动,这里定义

Before=docker.service

创建配置文件/etc/sysconfig/flanneld,设置为如下内容:

cat <<EOF > /etc/sysconfig/flanneld

# Flanneld configuration options

# etcd url location. Point this to the server where etcd runs

FLANNEL_ETCD_ENDPOINTS="-etcd-endpoints=http://172.18.8.200:2379"

# etcd config key. This is the configuration key that flannel queries

# For address range assignment

FLANNEL_ETCD_PREFIX="-etcd-prefix=/atomic.io/network"

# Any additional options that you want to pass

FLANNEL_OPTIONS=""

EOF

在master节点上为 falnnel 创建分配pod的网络。

[root@master ~]# etcdctl mk /atomic.io/network/config '{"Network": "10.244.0.0/16"}'

在各node节点上启动 flannel。

systemctl daemon-reload

systemctl start flanneld.service

systemctl enable flanneld.service

检查是否启动好。

ps -ef |grep flanneld

也可以使用自助安装,官方建议的使用方法。

kubectl apply -f https://raw.githubusercontent.com/coreos/flannel/master/Documentation/kube-flannel.yml

5、启动docker

编辑文件/usr/lib/systemd/system/docker.service,修改为如下内容,让docker使用flannel网络。

[Unit]

Description=Docker Application Container Engine

Documentation=https://docs.docker.com

After=network-online.target firewalld.service flannel.service

Wants=network-online.target

Requires=flanneld.service

[Service]

Type=notify

EnvironmentFile=-/run/flannel/docker

ExecStart=/usr/bin/dockerd $DOCKER_OPTS

ExecReload=/bin/kill -s HUP $MAINPID

LimitNOFILE=infinity

LimitNPROC=infinity

LimitCORE=infinity

TimeoutStartSec=0

Delegate=yes

KillMode=process

Restart=on-failure

StartLimitBurst=3

StartLimitInterval=60s

[Install]

WantedBy=multi-user.target

我们最后启动docker服务。

systemctl daemon-reload

systemctl restart docker.service

systemctl enable docker.service

我们可以看到docker0已经连接到flannel0,并且添加10.244.71.0/24的路由。

[root@node01 ~]# ip r

default via 172.18.8.1 dev ens33 proto static metric 100

10.244.0.0/16 dev flannel0 proto kernel scope link src 10.244.71.0

10.244.71.0/24 dev docker0 proto kernel scope link src 10.244.71.1

172.18.0.0/16 dev ens33 proto kernel scope link src 172.18.8.201 metric 100

五、master节点验证

[root@master ~]# kubectl get nodes

NAME STATUS ROLES AGE VERSION

node01.wzlinux.com Ready <none> 5m38s v1.12.2

node02.wzlinux.com Ready <none> 5m34s v1.12.2

先运行几个pod看一下。

kubectl run nginx --image=nginx --replicas=3

查看一下pod状态,发现容器的状态为ContainerCreating,使用kubectl describe pod POD_NAME发现在请求k8s.gcr.io/pause:3.1pod镜像模板。

因为我们还没有pod基础设施镜像k8s.gcr.io/pause:3.1,就是所有pod的模板,我们需要从gcr.io下载,但是这个地址我们国内是无法访问的,我们可以使用间接的方法,在所有的node节点上,我们可以从阿里云的镜像下载,然后再tag成我们需要的镜像。

docker pull registry.cn-hangzhou.aliyuncs.com/google_containers/pause:3.1

docker tag registry.cn-hangzhou.aliyuncs.com/google_containers/pause:3.1 k8s.gcr.io/pause:3.1

docker image rm registry.cn-hangzhou.aliyuncs.com/google_containers/pause:3.1

问题解决之后我们再次查看。

[root@master ~]# kubectl get pods -o wide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE

nginx-dbddb74b8-gzd6j 1/1 Running 0 2m11s 10.244.50.3 node02.wzlinux.com <none>

nginx-dbddb74b8-hmmll 1/1 Running 0 2m11s 10.244.50.2 node02.wzlinux.com <none>

nginx-dbddb74b8-lpkln 1/1 Running 0 2m11s 10.244.71.2 node01.wzlinux.com <none>

当前的网络结构图如下所示:

我们可以创建一个service,查看其分配的IP。

[root@master ~]# kubectl expose deploy nginx --port=8888 --target-port=80

[root@master ~]# kubectl get svc

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

kubernetes ClusterIP 10.96.0.1 <none> 443/TCP 51m

nginx ClusterIP 10.98.190.189 <none> 8888/TCP 7s

至此,使用二进制程序搭建的过程我们已经介绍完了。