keras.layers.recurrent.LSTM(units, activation='tanh', recurrent_activation='hard_sigmoid', use_bias=True, kernel_initializer='glorot_uniform', recurrent_initializer='orthogonal', bias_initializer='zeros', unit_forget_bias=True, kernel_regularizer=None, recurrent_regularizer=None, bias_regularizer=None, activity_regularizer=None, kernel_constraint=None, recurrent_constraint=None, bias_constraint=None, dropout=0.0, recurrent_dropout=0.0)

转载:https://blog.csdn.net/jiangpeng59/article/details/77646186

核心参数

units:

输出维度

input_dim:

输入维度,当使用该层为模型首层时,应指定该值(或等价的指定input_shape)

return_sequences:

布尔值,默认False,控制返回类型。若为True则返回整个序列,否则仅返回输出序列的最后一个输出

input_length:

当输入序列的长度固定时,该参数为输入序列的长度。当需要在该层后连接Flatten层,然后又要连接Dense层时,需要指定该参数,否则全连接的输出无法计算出来

输入shape

形如(samples,timesteps,input_dim)的3D张量

输出shape

如果return_sequences=True:返回形如(samples,timesteps,output_dim)的3D张量否则,返回形如(samples,output_dim)的2D张量

备注:

1.输入和输出的类型

相对之前的tensor,这里多了个参数timesteps.举个栗子,假如输入100个句子,每个句子由5个单词组成,每个单词用64维词向量表示。那么samples=100,timesteps=5,input_dim=64,可以简单地理解timesteps就是输入序列的长度input_length(视情而定).

2.units

假如units=128,就一个单词而言,可以把LSTM内部简化看成Y=X1×64W64×128 ,X为上面提及的词向量比如64维,W中的128就是units,也就是说通过LSTM把词的维度由64转变成了128.

3.return_sequences

我们可以把很多LSTM层串在一起,但是最后一个LSTM层return_sequences通常为False,具体看下面的栗子:

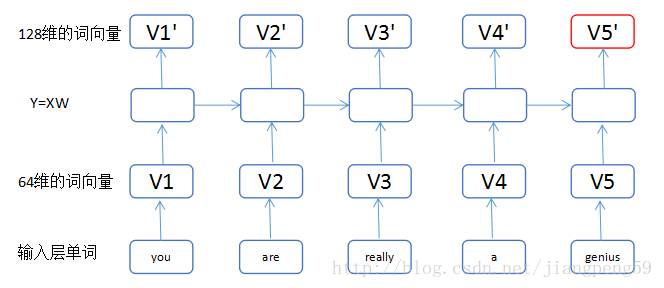

Sentence: you are really a genius

model = Sequential() model.add(LSTM(128, input_dim=64, input_length=5, return_sequences=True)) model.add(LSTM(256, return_sequences=False))

(1)我们把输入的单词,转换为维度64的词向量,小矩形的数目即单词的个数input_length

(2)通过第一个LSTM中的Y=XW,这里输入为维度64,输出为维度128,而return_sequences=True,我们可以获得5个128维的词向量V1’..V5’

(3)通过第二个LSTM,此时输入为V1’..V5’都为128维,经转换后得到V1”..V5”为256维,最后因为return_sequences=False,所以只输出了最后一个红色的词向量