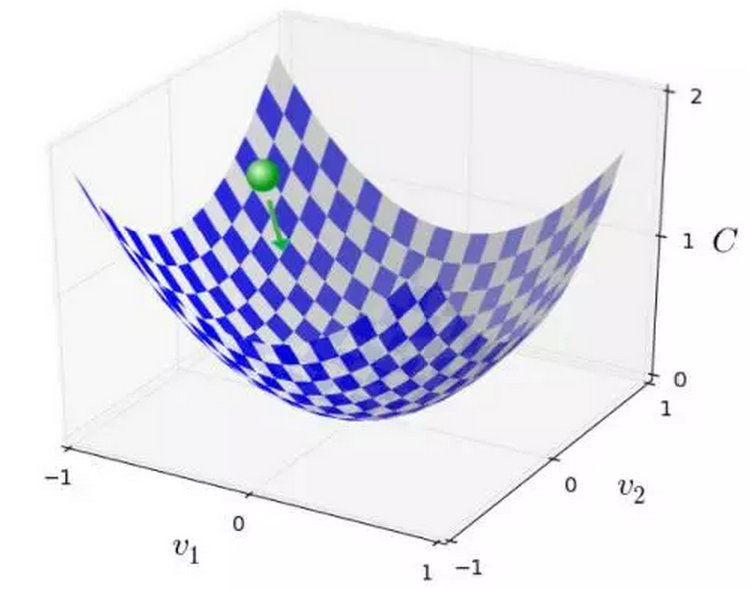

小球搜寻下坡最快的例子

成本函数为 C(w,b),为了取得L的最小值,采取朝着梯度方向的逐步逼近的策略,称为梯度下降,下面再介绍下它的具体实施步骤。

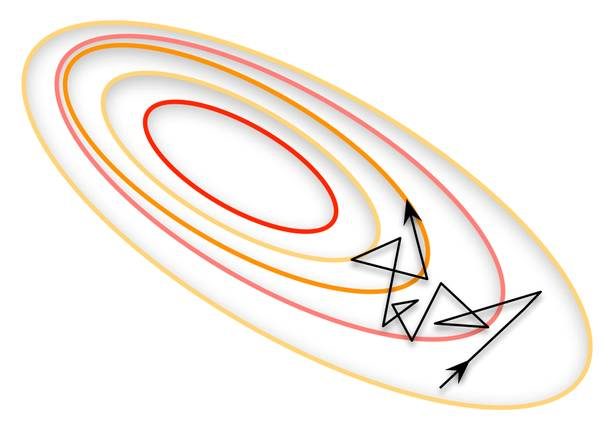

如下方所示的小球,位于v1, v2 空间中,图示位置所处的成本值还是比较大的,为了逐步减小,

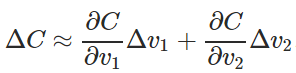

让小球在 v1 和 v2 方向分别移动一定距离 ,那么它移动的距离可表示为:

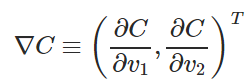

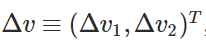

令,

2.4 批梯度下降

通常训练集内包括的样本数比较大,这里有3种梯度下降的策略:

1. 每次迭代只使用随机的一个样本(极限情况1),这种情况下,每次修正方向以各自样本的梯度方向修正,横冲直撞,难以达到收敛。

2. 每次迭代使用所有样本(极限情况2),计算效率很低,训练一套网络会很慢。

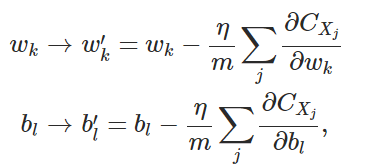

3. 批处理(中间情况),mini-batch,每次选取一定数量的样本进行训练,能避免情况1的出现,也能在迭代效率上有所提升,在这种情况下,权重参数和偏置项用批处理表示为如下,

至此,批处理参数迭代公式推导结束。