HBase是一个分布式的、面向列的开源数据库,该技术来源于 Fay Chang 所撰写的Google论文“Bigtable:一个结构化数据的分布式存储系统”。就像Bigtable利用了Google文件系统(File System)所提供的分布式数据存储一样,HBase在Hadoop之上提供了类似于Bigtable的能力。HBase是Apache的Hadoop项目的子项目。HBase不同于一般的关系数据库,它是一个适合于非结构化数据存储的数据库。另一个不同的是HBase基于列的而不是基于行的模式。

1、Hadoop生太圈

通过Hadoop生态圈,可以看到HBase的身影,可见HBase在Hadoop的生态圈是扮演这一个重要的角色那就是 实时、分布式、高维数据 的数据存储;

2、HBase简介

– HBase – Hadoop Database,是一个高可靠性、高性能、面向列、可伸缩、 实时读写的分布式数据库

– 利用Hadoop HDFS作为其文件存储系统,利用Hadoop MapReduce来处理 HBase中的海量数据,利用Zookeeper作为其分布式协同服务

– 主要用来存储非结构化和半结构化的松散数据(列存NoSQL数据库)

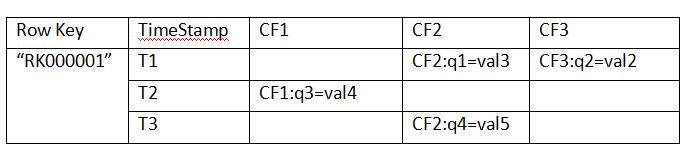

3、HBase数据模型

以关系型数据的思维下会感觉,上面的表格是一个5列4行的数据表格,但是在HBase中这种理解是错误的,其实在HBase中上面的表格只是一行数据;

Row Key:

– 决定一行数据的唯一标识

– RowKey是按照字典顺序排序的。

– Row key最多只能存储64k的字节数据。

Column Family列族(CF1、CF2、CF3) & qualifier列:

– HBase表中的每个列都归属于某个列族,列族必须作为表模式(schema) 定义的一部分预先给出。如create ‘test’, ‘course’;

– 列名以列族作为前缀,每个“列族”都可以有多个列成员(column,每个列族中可以存放几千~上千万个列);如 CF1:q1, CF2:qw,

新的列族成员(列)可以随后按需、动态加入,Family下面可以有多个Qualifier,所以可以简单的理解为,HBase中的列是二级列,

也就是说Family是第一级列,Qualifier是第二级列。两个是父子关系。

– 权限控制、存储以及调优都是在列族层面进行的;

– HBase把同一列族里面的数据存储在同一目录下,由几个文件保存。

– 目前为止HBase的列族能能够很好处理最多不超过3个列族。

Timestamp时间戳:

– 在HBase每个cell存储单元对同一份数据有多个版本,根据唯一的时间 戳来区分每个版本之间的差异,不同版本的数据按照时间倒序排序,

最新的数据版本排在最前面。

– 时间戳的类型是64位整型。

– 时间戳可以由HBase(在数据写入时自动)赋值,此时时间戳是精确到毫 秒的当前系统时间。

– 时间戳也可以由客户显式赋值,如果应用程序要避免数据版本冲突, 就必须自己生成具有唯一性的时间戳。

Cell单元格:

– 由行和列的坐标交叉决定;

– 单元格是有版本的(由时间戳来作为版本);

– 单元格的内容是未解析的字节数组(Byte[]),cell中的数据是没有类型的,全部是字节码形式存贮。

• 由{row key,column(=<family> +<qualifier>),version}唯一确定的单元。

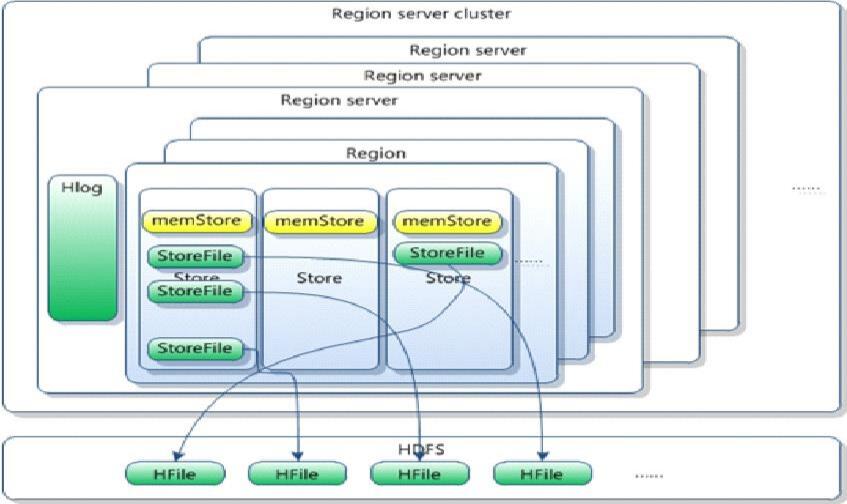

4、HBase体系架构

Client

• 包含访问HBase的接口并维护cache来加快对HBase的访问

Zookeeper

• 保证任何时候,集群中只有一个master

• 存贮所有Region的寻址入口。

• 实时监控Region server的上线和下线信息。并实时通知Master

• 存储HBase的schema和table元数据

Master

• 为Region server分配region

• 负责Region server的负载均衡

• 发现失效的Region server并重新分配其上的region

• 管理用户对table的增删改操作

RegionServer

• Region server维护region,处理对这些region的IO请求

• Region server负责切分在运行过程中变得过大的region

HLog(WAL log):

– HLog文件就是一个普通的Hadoop Sequence File,Sequence File 的Key是 HLogKey对象,HLogKey中记录了写入数据的归属信息,

除了table和 region名字外,同时还包括sequence number和timestamp,timestamp是” 写入时间”,sequence number的起始值为0,

或者是最近一次存入文件系 统中sequence number。

– HLog SequeceFile的Value是HBase的KeyValue对象,即对应HFile中的 KeyValue

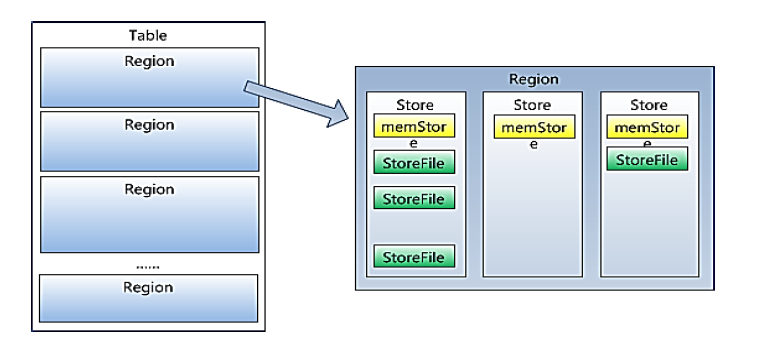

Region

– HBase自动把表水平划分成多个区域(region),每个region会保存一个表 里面某段连续的数据;每个表一开始只有一个region,随着数据不断插 入表,

region不断增大,当增大到一个阀值的时候,region就会等分会 两个新的region(裂变);

– 当table中的行不断增多,就会有越来越多的region。这样一张完整的表 被保存在多个Regionserver上。

Memstore 与 storefile

– 一个region由多个store组成,一个store对应一个CF(列簇)

– store包括位于内存中的memstore和位于磁盘的storefile写操作先写入 memstore,当memstore中的数据达到某个阈值,

hregionserver会启动 flashcache进程写入storefile,每次写入形成单独的一个storefile

– 当storefile文件的数量增长到一定阈值后,系统会进行合并(minor、 major compaction),在合并过程中会进行版本合并和删除工作 (majar),

形成更大的storefile。

– 当一个region所有storefile的大小和超过一定阈值后,会把当前的region 分割为两个,并由hmaster分配到相应的regionserver服务器,实现负载均衡。

– 客户端检索数据,先在memstore找,找不到再找storefile

– HRegion是HBase中分布式存储和负载均衡的最小单元。最小单元就表 示不同的HRegion可以分布在不同的HRegion server上。

– HRegion由一个或者多个Store组成,每个store保存一个columns family。

– 每个Strore又由一个memStore和0至多个StoreFile组成。

如图:StoreFile 以HFile格式保存在HDFS上。

理解难区:

1、flush刷新在HDFS上呈现究竟是怎么刷新的呢??

我们目前刚刚学习的时候,添加数据,都是一条一条的put进去,而我们在put的数据比较少(小于128M)的时候,我们put完去HDFS上并未查看到我们put的文件,这是因为数据还在内存中,也就是还在memStore中,所以要想在HDFS中查看到,我们必须手动刷新到磁盘中,这是将memStore的数据刷新到StoreFile中去,这样我们在HDFS中就可以查看到了。

2、为什么Hbase不可以使用像Mysql那样进行查询??

首先,我们应该可以感受到,我们在插入的时候,每行数据,有多少列,列名叫什么完全是我们自己定义的,之所以不支持像MySql那样对列进行查询和操作,因为不确定列的个数和名称。

3、数据最后存在HDFS上的,HDFS不支持删改,为什么Hbase就可以呢??

这里有个思想误区,的确,数据是以HFile形式存在HDFS上的,而且HDFS的确是不支持删改的,但是为什么Hbase就支持呢?首先,这里的删除并不是真正意义上的对数据进行删除,而是对数据进行打上标记,我们再去查的时,就不会查到这个打过标记的数据,这个数据Hmaster会每隔1小时清理。修改是put两次,Hbase会取最新的数据,过期数据也是这个方式被清理。