本系列笔记内容参考来源为李航《统计学习方法》

统计学习

统计学习时关于计算机基于数据构建概率统计模型 并运用模型 对数据进行预测与分析。

统计学习的三要素:

方法 = 模型+策略+算法

统计学习由监督学习、非监督学习、半监督学习和强化学习等组成。

实现统计学习方法的具体步骤如下:

(1)得到一个有限的训练数据集合;

(2)确定包含所有可能的模型的假设空间,即学习模型的集合;

(3)确定模型选择的准则,即学习的策略;

(4)实现求解最优模型的算法,即学习的算法;

(5)通过学习方法选择最优模型;

(6)利用学习的最优模型对数据进行预测或分析。

监督学习

一些基本概念:

- 输入空间、特征空间、输出空间

输入与输出所有可能取值的集合成为输入空间与输出空间。每个具体的输入是一个实例,通常由特征向量表示,所有特征向量存在的空间成为特征空间。

特征空间每一维对应一个特征,有时对输入空间与特征空间不加以区分,有时假设输入空间与特征空间为不同的空间,将实例从输入空间映射到特征空间。模型实际上都是定义在特征空间上的。

根据输入、输出变量的不同类型,对预测任务给予不同的名称:

回归问题:输入、输出变量均为连续变量的预测问题;

分类问题:输出变量为有限个离散变量的预测问题;

标注问题: 输入、输出变量均为变量序列的预测问题

监督学习的任务就是学习一个模型,应用这一模型,对给定的输入预测相应的输出,这个模型的一般形式为决策函数:Y=f(X)或者条件概率分布P(Y|X)

统计学习三要素

模型

模型就是要学习的条件概率分布或决策函数。模型的假设空间包含所有可能的条件概率分布或决策函数。

空间用F表示,假设空间可以定义为决策函数的集合,即:

F通常是由一个参数向量来决定的条件概率分布族

假设空间也可以定义为条件概率的集合

![]()

此时有

![]()

策略

- 经验风险最小化

- 结构风险最小化(正则化)

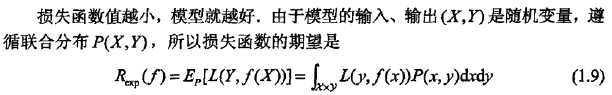

有了假设空间,考虑如何在假设空间中选取最优模型,因此引入损失函数和风险函数等来度量模型的好坏。

损失函数度量模型一次预测的好坏,风险函数度量平均意义下模型预测的好坏。

损失函数是f(X)和Y的非负实值函数,记做 L(Y,f(X))

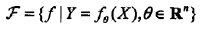

常用的损失函数:

这是理论上模型f(X)关于联合分布P(X,Y)的平均意义下的损失,称为风险函数或期望损失。

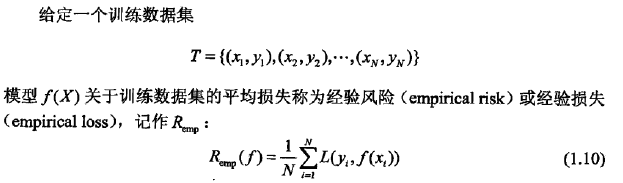

经验风险或经验损失:

选择令期望损失值最小的模型即为学习的目标,但是联合分布未知因此Rexp不能直接计算,但如知道了联合分布,可直接计算条件概率分布P(Y|X),也就不需要学习。因此监督学习成为一个病态问题。

根据大数定律,当样板容量趋于无穷,经验风险趋于期望风险,但实际中训练样本数量有限,因此用经验风险估计期望风险不理想,需进行矫正,则涉及监督学习的两个基本策略:经验风险最小化和结构风险最小化。

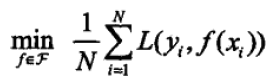

经验风险最小化(empirical risk minimization,ERM)

ERM认为,经验风险最小的模型最优,则最优模型可转换为:

当模型是条件概率分布,损失函数是对数损失函数时,经验风险最小化就等价于极大似然估计。

F为假设空间,当样本容量足够大,学习效果较好,但样本容量很小时,容易过拟合,则引申出结构风险最小化。

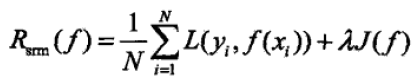

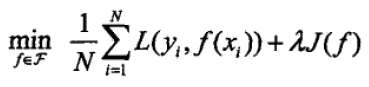

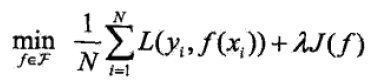

结构风险最小化(structural risk minimization,SRM)/正则化

在ERM基础上加上表示模型复杂度的正则化项或罚项,定义如下

其中J(f)为模型的复杂度,是定义在假设空间F上的泛函,模型f越复杂,J(f)越大。lamda是系数,≥0,用以权衡ERM和模型复杂度。

则SRM最小化将求最优模型转换为求解最优问题:

当模型是条件概率分布、损失函数是对数损失函数、模型复杂度由模型的先验概率表示时,结构风险最小化就等价于最大后验概率估计。

算法

指学习模型的具体计算方法

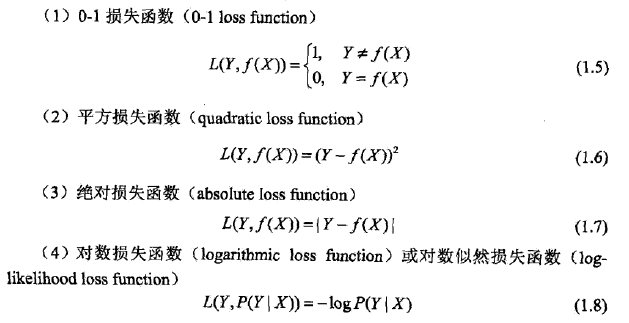

模型评估与模型选择

训练误差与测试误差

正则化与交叉验证

正则化一般形式如下:

第一项为经验风险,第二项为正则化项目,正则化项可取不同的形式。经验风险较小的模型可能较复杂(有多个非零参数),则第二项模型复杂度会较大,正则化的作用是选择经验风险与模型复杂度同时小的模型。

从贝叶斯估计角度看,正则化项对应模型的先验概率,可假设复杂的模型有较大的先验概率,简单的模型有较小的先验概率。

若样本充足,可随机将数据集分为训练集、验证集和测试集,验证集用于模型选择,在学习到的不同复杂度的模型中,选择对验证集有最小预测误差的模型。但实际中数据不够,因此采用交叉验证,即重复利用数据,将给定数据划分为训练集与测试集,反复训练、测试及模型选择。

- 简单交叉验证

随机将数据分为训练集和测试集,用训练集在各条件下训练模型,在测试集上评价各个模型的测试误差,选出测试误差最小的模型

- S折交叉验证

随机将数据切分为S个互不相交的大小相同的子集,利用S-1个子集的数据训练模型,利用余下的子集测试模型,重复进行算出S次评测中平均测试误差最小的模型

- 留一交叉验证

当S=N时,N为给定数据集的容量

泛化能力

指由该方法学习到的模型对未知数据的预测能力。泛化误差相当于所学习到的模型的期望风险。

![]()

泛化误差上界(泛化误差概率上界)

它是样本容量的函数,样本容量增加,泛化上界趋于0;是假设空间容量的函数,假设空间容量越大,模型越难学,泛化误差上界越大。

R(f)为期望风险,R^为经验风险。

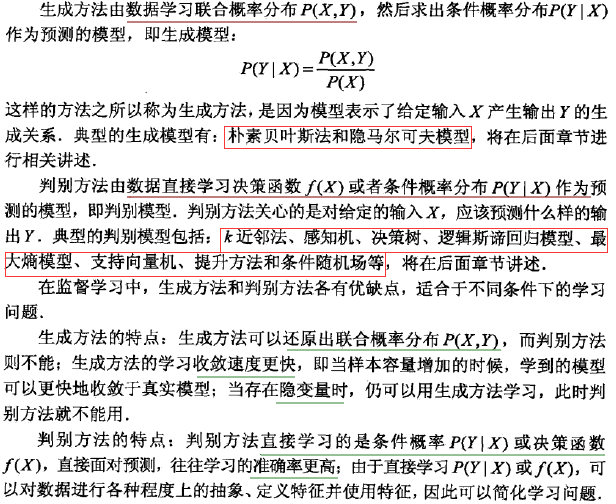

生成模型与判别模型

分类问题