1.环境

CDH 5.16.1

Centos 7.6

Scala 2.11.8

2.安装前准备

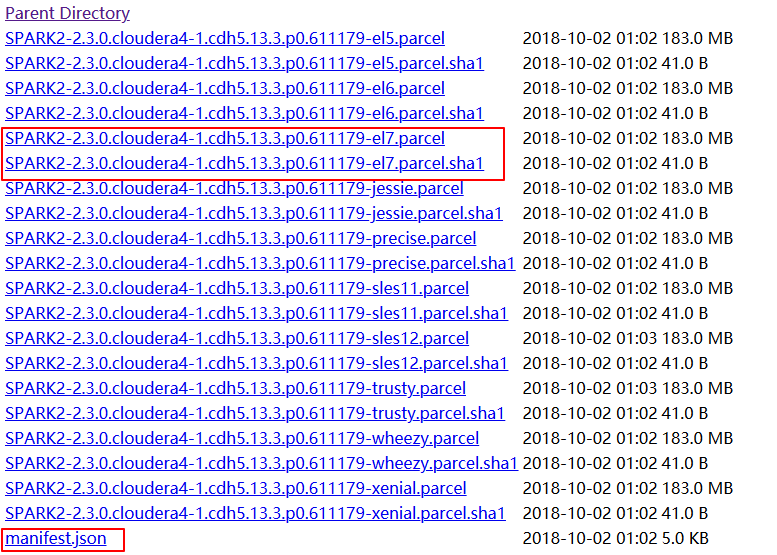

1.下载 Spark2.3 所需的Parcel包

http://archive.cloudera.com/spark2/parcels/2.3.0.cloudera4/

将三个文件拷贝到 /opt/cloudera/parcel-repo 目录下,如果有有相同文件,就将之前的文件重命名

2.下载Spark 的csd 包

http://archive.cloudera.com/spark2/csd/

将 SPARK2_ON_YARN-2.3.0.cloudera4.jar 拷贝到 /opt/cloudera/csd 目录中

3.重启CM和集群

4.安装Spark

依次点击 “主机” --> “parcel” --> “检查新parcel” --> “分配” --> “激活”

5.问题

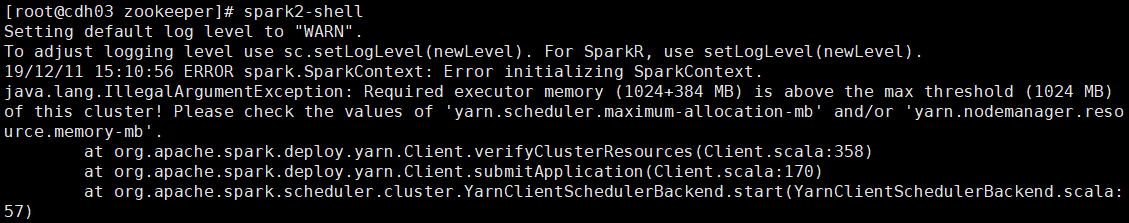

1.启动Spark2-shell报错

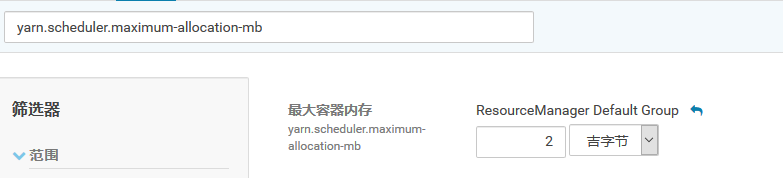

解决办法:修改 yarn.scheduler.maximum-allocation-mb 和 yarn.nodemanager.resource.memory-mb的默认值为2G