双精度张量内核加快了高性能计算

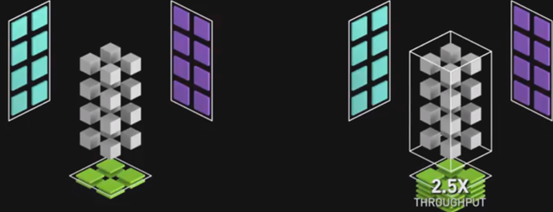

通过NVIDIA Ampere架构,仿真和迭代求解器可将FP64数学提高多达2.5倍。

模拟可以帮助了解黑洞的奥秘,并了解冠状病毒上的蛋白质尖峰如何导致COVID-19。还可以让设计师创建从时尚汽车到喷气发动机的所有东西。

但是仿真也是地球上最苛刻的计算机应用程序之一,因为需要大量最先进的数学。

通过使用称为FP64的双精度浮点格式的计算,仿真使数值模型变得可视化。格式中的每个数字在计算机中占用64位,使其成为当今GPU支持的多种数学格式中计算强度最高的一种。

NVIDIA Ampere架构定义了第三代Tensor内核,这是努力加速高性能计算的又一大举措,与上一代GPU相比,它们可将FP64数学运算速度提高2.5倍。

这意味着在最新的A100 GPU上运行时,可以在几个小时内查看使研究人员和设计师整夜等待的模拟。

科学使AI陷入循环

速度的提高打开了将AI与仿真和实验相结合的大门,创建了一个正反馈回路,从而节省了时间。

首先,模拟会创建训练AI模型的数据集。然后,AI和仿真模型一起运行,相互取长补短,直到AI模型准备好通过推理提供实时结果。训练有素的AI模型还可以从实验或传感器中获取数据,从而进一步完善其洞察力。

使用此技术,AI可以定义一些感兴趣的区域以进行高分辨率仿真。通过缩小范围,AI可以将数千个费时的仿真需求减少几个数量级。并且需要运行的仿真在A100 GPU上的运行速度将提高2.5倍。

视频播放器

借助FP64和其它新功能,基于NVIDIA Ampere架构的A100 GPU成为了灵活的平台,可用于仿真以及AI推理和训练-现代HPC的整个工作流程。该功能将推动开发人员将仿真代码迁移到A100。

用户可以调用新的CUDA-X库来访问A100中的FP64加速。这些GPU内置了支持DMMA的第三代Tensor内核,DMMA是一种新模式,可加速双精度矩阵乘法累加运算。

加速矩阵数学

单个DMMA作业使用一条计算机指令来代替八条传统的FP64指令。结果,A100的FP64数学运算速度比其它芯片更快,工作量更少,不仅节省了时间和功耗,而且还节省了宝贵的内存和I / O带宽。

将此新功能称为双精度张量核心。它为HPC应用程序提供了Tensor Core的功能,以完整的FP64精度加速了矩阵数学运算。

除了模拟之外,称为迭代求解器的HPC应用程序(具有重复矩阵数学计算的算法)将受益于此新功能。这些应用程序包括地球科学,流体动力学,医疗保健,材料科学和核能以及石油和天然气勘探领域的广泛工作。

为了服务于世界上最苛刻的应用程序,双精度Tensor内核进入了我们制造的最大,功能最强大的GPU中。与地球上的任何GPU相比,A100还拥有更多的内存和带宽。

NVIDIA Ampere架构中的第三代Tensor Core比以前的版本更强大。它们支持更大的矩阵尺寸-8x8x4,而Volta则为4x4x4,从而使用户能够解决更棘手的问题。

这就是为什么总共有432个Tensor Core的A100可以提供高达19.5 FP64 TFLOPS的原因,是Volta V100性能的两倍以上。