java环境安装 http://www.cnblogs.com/zeze/p/5902124.html

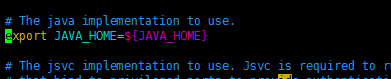

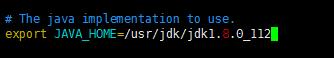

java 环境安装配置 etc/profile:

export JAVA_HOME=/usr/jdk/jdk1.8.0_112 export JRE_HOME=/usr/jdk/jdk1.8.0_112/jre export CLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar:$JRE_HOME/lib:$CLASSPATH export PATH=$JAVA_HOME/bin:$PATH

SSH安装 http://www.linuxidc.com/Linux/2014-01/94793.htm

yum install openssh-server

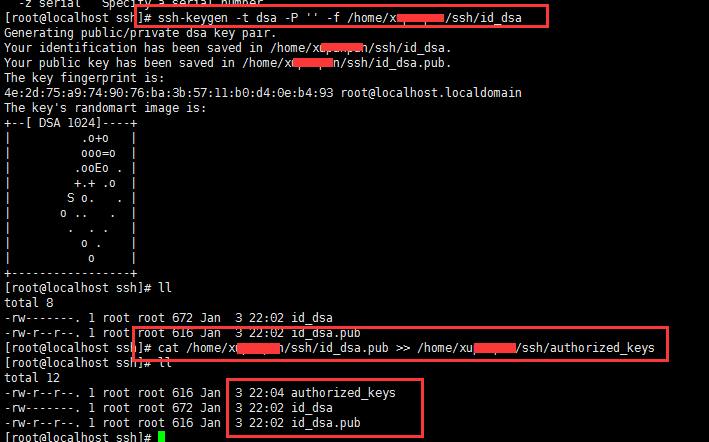

创建ssh文件夹,在ssh文件夹下创建两个文件id_dsa及id_dsa.pub,这是一对私钥和公钥,然后把id_dsa.pub(公钥)追加到授权的key里面去。

ssh-keygen -t dsa -P '' -f ~/.ssh/id_dsa cat ~/.ssh/id_dsa.pub >> ~/.ssh/authorized_keys

登陆ssh,输入命令:

ssh localhost

第一次登陆可能会询问是否继续链接,输入yes即可,以后登陆直接登进去。

安装hadoop2.7.3

下载:http://apache.fayea.com/hadoop/common/hadoop-2.7.3/hadoop-2.7.3.tar.gz

tar xzvf hadoop-2.7.0.tar.gz mv hadoop-2.7.0 hadoop

配置启动Hadoop

1、修改hadoop2.7.3/etc/hadoop/hadoop-env.sh指定JAVA_HOME

2、修改hdfs的配置文件

修改hadoop2.7.3/etc/hadoop/core-site.xml 如下:

<configuration>

<!-- 指定HDFS老大(namenode)的通信地址 -->

<property>

<name>fs.defaultFS</name>

<value>hdfs://0.0.0.0:9000</value>

</property>

<!-- 指定hadoop运行时产生文件的存储路径 -->

<property>

<name>hadoop.tmp.dir</name>

<value>/home/xupanpan/hadoop/temp</value>

</property>

</configuration>

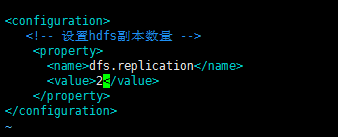

修改hadoop2.7.3/etc/hadoop/hdfs-site.xml 如下:

3、启动与停止

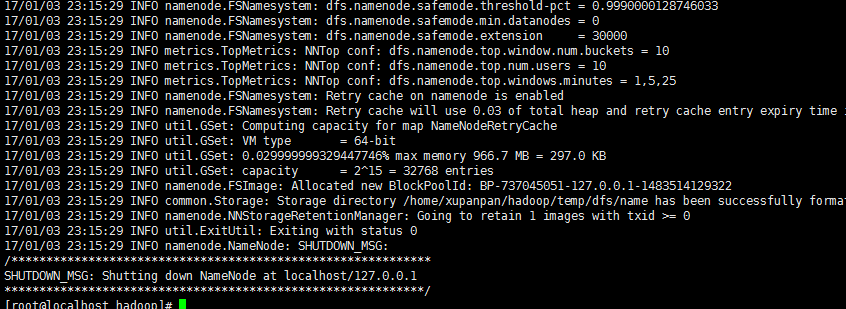

第一次启动得先格式化

/home/xupanpan/hadoop/hadoop/bin/hdfs namenode -format

启动hdfs

/home/xupanpan/hadoop/hadoop/sbin/start-dfs.sh

预览

http://192.168.20.225:50070/

停止hdfs

|

1

|

/home/xupanpan/hadoop/hadoop/sbin/stop-dfs.sh |