给你这些水果图片,告诉你哪些是苹果。那么现在,让你总结一下哪些是苹果?

1)苹果都是圆的。我们发现,有些苹果不是圆的、有些水果是圆的但不是苹果,

2)其中到这些违反“苹果都是圆的”这一规则的图片,我们得到“苹果都是圆的,可能是红色或者绿色”。。我们发现还是有些图片违反这一规则;

3)其中到违反规则的图片,我们发现“苹果都是圆的,可能是红色或者绿色,而且有梗”。

至此分类完成。

模拟这一过程,就是adaBoost算法。

首先从一个弱分类器开始,然后集中注意力放在发生错误的样本上,get下一次分类器。adaBoost的特点是:

1)不同的分类器是串行训练的,也就是:第二个分类器依赖于第一个分类器;

2)通过集中关注被已有分类器错分的那些数据来获得新的分类器。

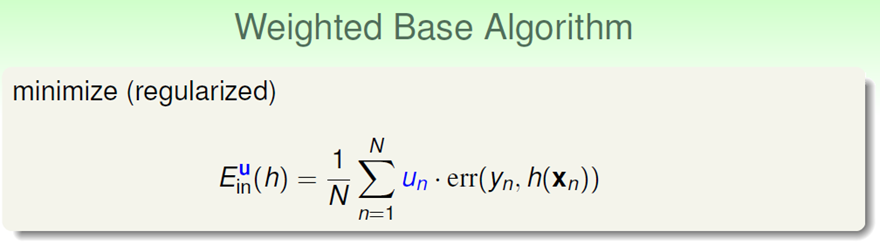

如何集中关注错分的数据?通过提高错分数据的权重。这就要求:

为了更具有物理意义,我们把ε给scaling一下:

这样有什么物理意义呢?当数据错分的时候,◇必然大于1.相当于将数据权重放大;而数据分类正确的时候,◇小于1,相当于将数据权重减小。

另一个问题:如何寻找弱分类器?我们知道任何机器学习算法都可以,但是这里一种常用的弱分类器是:单层决策树。