Pixel-BERT: Aligning Image Pixels with Text by Deep Multi-Modal Transformers

2020-12-23 11:54:13

Paper: https://arxiv.org/pdf/2004.00849

预训练模型如火如荼,多模态预训练也没有掉队。其中,image-language 领域,如何将这两者联合学习是一个较为火热的方向。本文提出一种基于跨模态 transformer 的模型,来进行联合特征的学习。整体方法示意图如下:

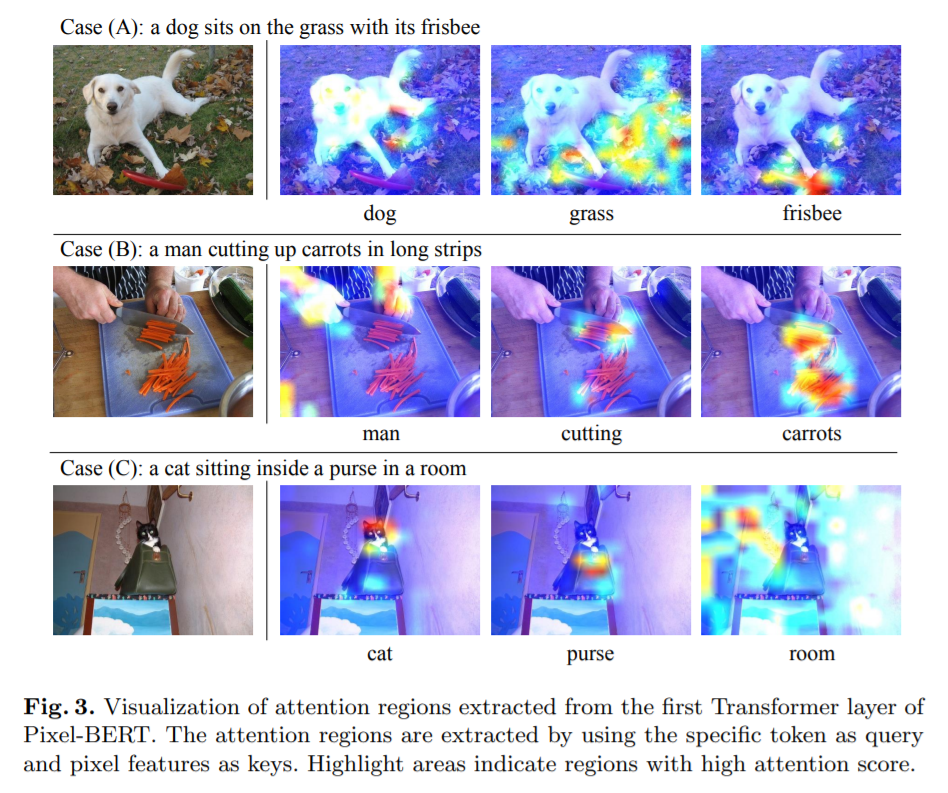

从上图可以看出,作者用 transformer 模型对 language 进行编码。同时,用 CNN 抽取 图像的特征,然后输入到一个特征映射模块中。该模块的特色是,随机的从中扣取 local feature patch,以防止过拟合。然后 language 和 vision feature 组合在一起,放到 transformer 模型中。本文采用两种训练损失,即:图像文本匹配的训练方法 和 掩模预测的训练方法。

从计算资源来看,本文在 64 张 V100 上进行了训练。一般人,玩不起。。。

训练方法上来说,对 CNN 用 SGD, 对 Transformer 部分用 AdamW 分别进行优化。