Long-Term Cloth-Changing Person Re-identification

2020-06-05 14:45:42

Paper: https://arxiv.org/pdf/2005.12633.pdf

Project: https://naiq.github.io/LTCC_Perosn_ReID.html

1. The Proposed Method:

Shape Embedding:

人类可以根据轮廓很容易识别出一个人物,所以作者认为人体的形状信息可以很具有判别性。此处,shape 是几个特定的生物特征的笼统叫法,即:身高、身体的比例等。一个直接的做法是将人体形状表示为不受 angle 和 distances,姿态变化影响的方式,就是用 joints/keypoints 并且建模这些点之间的关系。受到 Adaptive instance normalization 的影响,作者提出一种 shape embedding module 来编码身体的形状。

首先利用现成的姿态预测器,得到 n 个关键点。每一个点都有两个属性,即:position Pi 和 semantics Si。具体来说:

Pi = (xi/w, yi/h, w/h),其中(xi, yi)代表在行人图像中的节点 i 坐标,(w,h)代表图像原始的宽和高。

Si 是一个 n 维的 one-hot vector 来索引 keypoint i。如果设定的关键点未检测到,那么就设置为 Pi = (-1, -1, w/h)。

Keypoint Embedding:

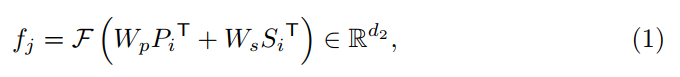

有了上述两个关键点分支表示,首先利用可学习的 weights W 来分别学习该映射。然后,作者采用一个 refinement network 来结合两个 part,来改善每一个关键点的表达:

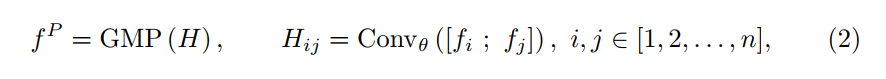

其中,Wp 和 Ws 是两组不同的映射权重;F(*) 是带有几个全连接层的优化网络,将维度从 d1 增加为 d2。在这篇论文中,作者有两个 hidden layers,并且设置 d1=128, d2=2048. 在 embedding 之后,可以得到一组关键点的特征 f。直观的来说,人体比例的信息无法简单地通过单个节点的特征来获得。所以,仍然需要建模节点对之间的关系。为了达到这个目标,作者拟提出利用关系网络来探索不同节点的关系。本文的关系网络将两个不同的 points 组合起来,然后输入到两个全卷积网络中进行关系推理。最终 key-point embedding feature 可以通过最大化输出来得到。整个过程可以描述为:

其中,GMP 是 global max pooling。

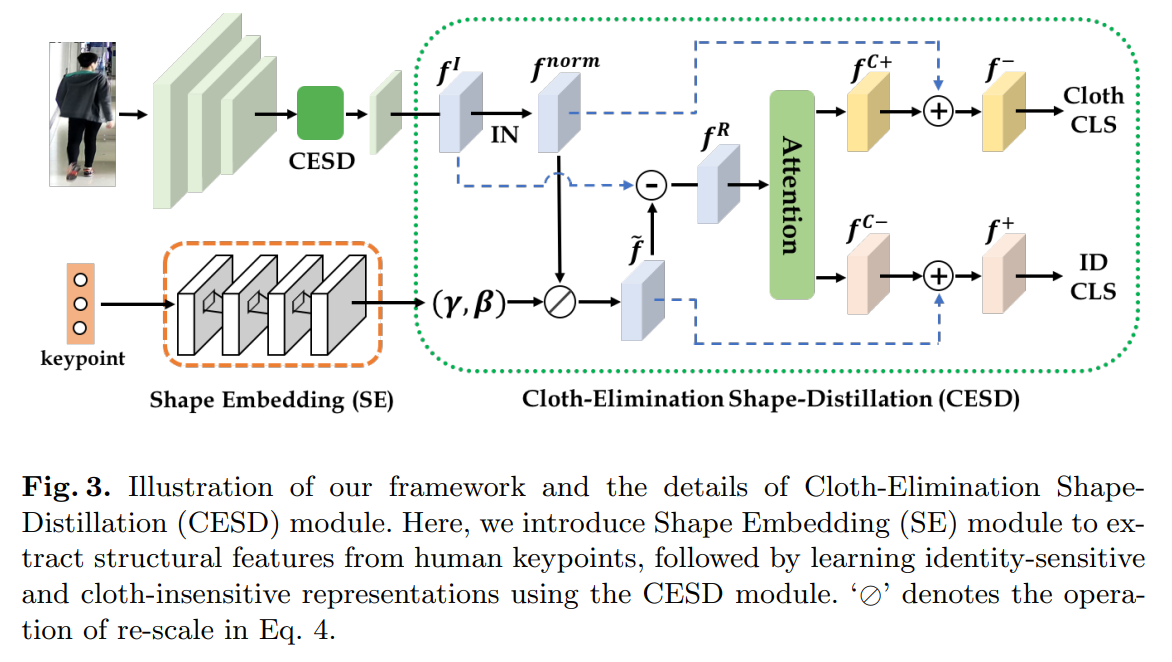

Cloth-Elimination Shape-Distillation(CESD):

本文提出该模块来提取形状信息,并且抑制衣着信息。

Shape Distillation. 首先为了降低原始 style information,和光照条件最相关,在输入的时候,执行 instance normalization。然后利用参数来 re-scaling 归一化的特征,得到形状特征:

其中,E[*], Var[*] 表示均值和方差。gs(*) 和 gb(*) 分别是 一层的 fc layer 来学习 scale 和 bias 新的参数。

Cloth Eliminating:

如图 3 所示,给定图像特征 和 迁移后的特征,首先通过相减,得到残差特征:

![]()

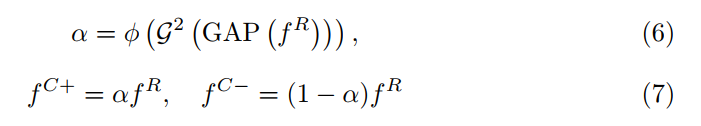

对于 fR 来说,不可避免的带有一些判别性的特征,和 对衣服改变较为敏感的特征。作者引入 self-attention 机制来处理这个问题。

其中,通过添加 cloth-irrelevant feature 来 re-scale shape feature,作者添加另外的卷积层来优化该特征,以得到 个体特征。类似的,作者将 cloth-relevant feature 和 normalized feature 进行相加,然后用不同的卷积层来得到最终 cloth-relevant feature:

Architecture Details:

作者这里用了两个分类的 loss 来训练最终的(person ID 和 cloth ID):

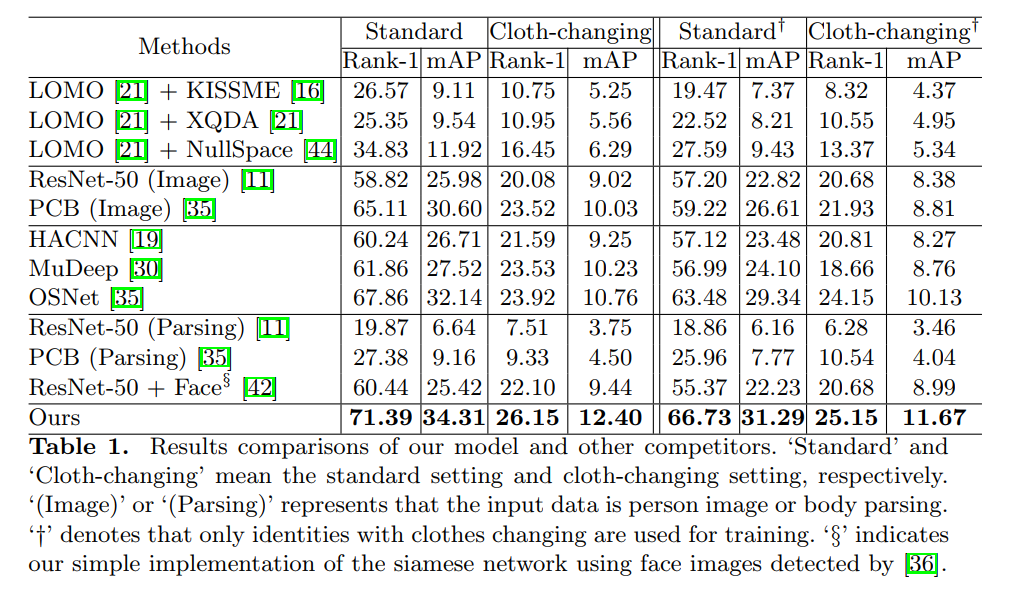

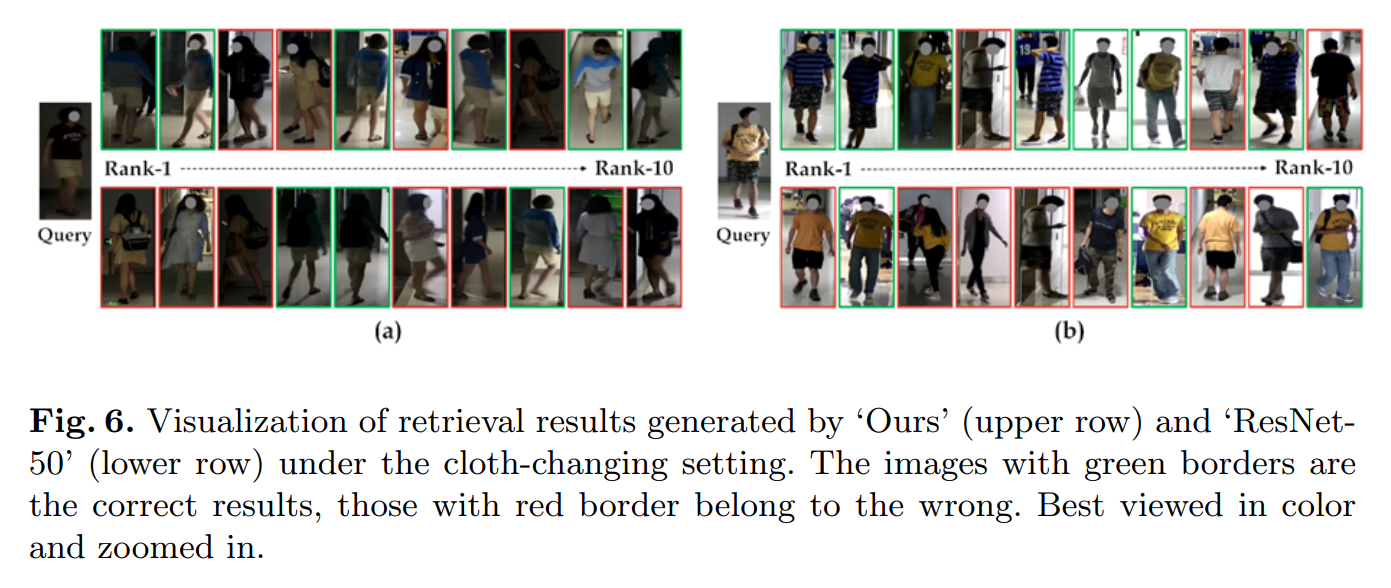

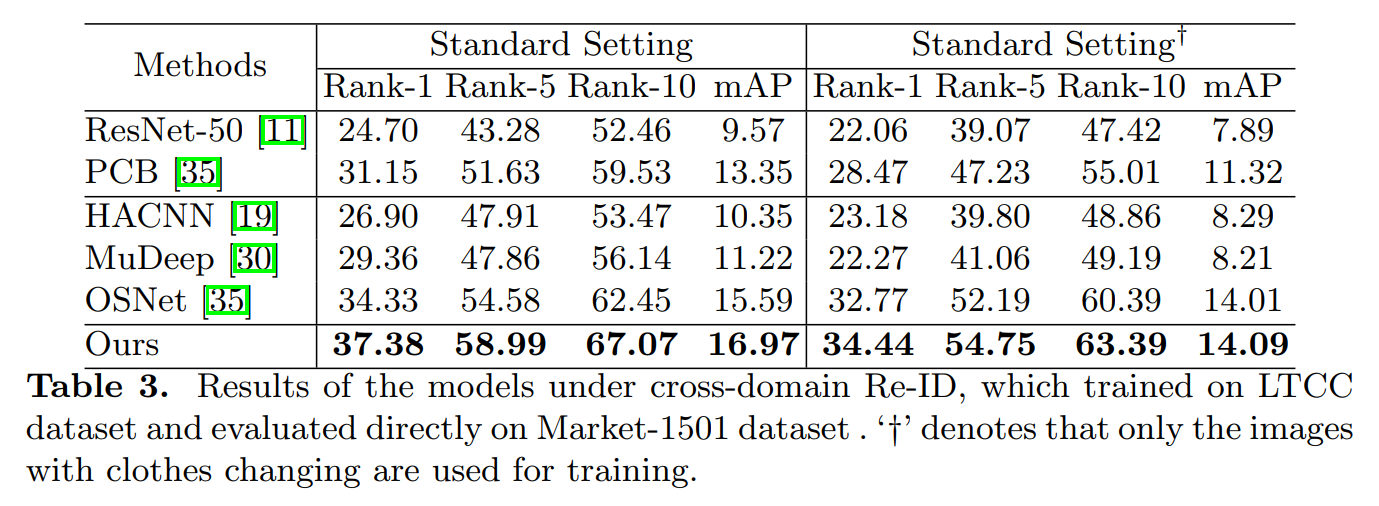

Experimental Results:

==