1. 概述

新闻是我们了解外界的重要渠道,以前,我们一般通过报纸和电视来获取新闻,那时候,获取新闻不仅有一定的成本,效率还不高。

而如今,获取新闻的途径太多太方便了,大量重复的新闻充斥着各大平台,获取新闻已经没有什么成本,问题变成了过滤和鉴别新闻的可信程度。

下面用 【新浪新闻】 作为采集对象,抛砖引玉,演示下新闻从采集到分析的整个过程。

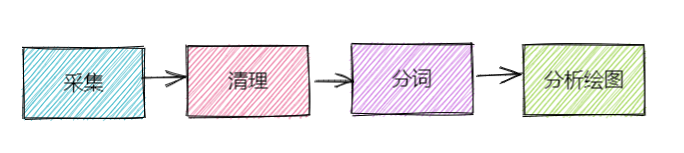

2. 采集流程

主要流程分为4个步骤:

2.1 采集

从新浪滚动新闻页面中,找出获取新闻的API,然后,并发的采集新闻。

这里为了简单起见,主要采集了新闻标题和摘要信息。

# -*- coding: utf-8 -*-

import requests

import csv

import time

import os

import threading

import math

host = "https://feed.mix.sina.com.cn/api/roll/get?pageid=153&lid=2509&k=&num=50&page={}"

class spiderThread(threading.Thread):

def __init__(self, fname, delay, start_page, end_page):

threading.Thread.__init__(self)

self.fname = fname

self.delay = delay

self.start_page = start_page

self.end_page = end_page

def run(self):

for page in range(self.start_page, self.end_page):

time.sleep(self.delay)

url = host.format(page)

rows = _parse_html_content(url)

_save_data(self.fname, rows)

print("thead: {} 已采集 第【{}】页的数据".format(self.fname, page))

def spider(start_page=1, pages=50, concurrency=2):

""" 采集数据

并发采集 sina 滚动新闻数据

Parameters:

start_page - 采集开始的页数,默认从第1页开始采集

pages - 采集的页数,默认采集500页

concurrency - 并发采集的数量,默认4个线程采集

Returns:

采集结果写入文件

"""

if pages < 0 or concurrency < 0:

print("pages or concurrency must more than 0")

return

threads = []

now_str = time.strftime("%Y-%m-%d--%H-%M-%S", time.localtime())

delta = math.ceil((pages - start_page + 1) / concurrency)

for i in range(concurrency):

end_page = delta + start_page

if end_page > pages:

end_page = pages + 1

t = spiderThread("{}-{}".format(now_str, i + 1), 2, start_page, end_page)

threads.append(t)

t.start()

start_page = end_page

for t in threads:

t.join()

print("采集结束")

def _parse_html_content(url):

""" parse html to csv row like: oid, intime, title, media_name, intro

"""

response = requests.get(url)

data = response.json()

data = data["result"]["data"]

rows = []

for d in data:

# print(d["oid"])

# print(d["intime"])

# print(d["title"])

# print(d["media_name"])

# print(d["intro"])

rows.append([d["oid"], d["intime"], d["title"], d["media_name"], d["intro"]])

return rows

def _save_data(filename, rows):

fp = os.path.join("./data", filename + ".csv")

print("fname {}: rows {}".format(filename, len(rows)))

with open(fp, "a", encoding='utf-8') as f:

writer = csv.writer(f)

writer.writerows(rows)

主要函数是:def spider(start_page=1, pages=50, concurrency=2)

可以设置采集的起始/结束页,以及并发采集的线程数。

新浪滚动新闻最多只提供了最近50页的新闻,大概4000多条新闻。

采集之后,默认会在 data文件夹下生成采集结果的 csv 文件(几个线程采集,就生成几个csv)

2.2 清理

清理数据主要将多线程采集的所有csv文件合并成一个,同时去重和按照时间排序。

# -*- coding: utf-8 -*-

import pandas as pd

import os

import time

def clean(data_dir="./data"):

""" 清洗数据

合并所有采集的数据文件,去除重复数据和不需要的字段

Parameters:

data - 采集数据的文件夹

Returns:

清理后的结果写入文件

"""

data = _read_all_data(data_dir)

data = _uniq_and_order(data)

_write_clean_data(data_dir, data)

def _read_all_data(data_dir):

all_data = []

for f in os.listdir(data_dir):

fp = os.path.join(data_dir, f)

if os.path.isdir(fp):

continue

data = pd.read_csv(

fp, names=["oid", "intime", "title", "media_name", "intro"], header=None,

)

all_data.append(data)

return pd.concat(all_data, ignore_index=True)

def _uniq_and_order(data):

data = data.drop_duplicates(keep="first")

data = data.drop(columns=["oid", "intime", "media_name", "intro"])

# data = data.sort_values(by=["intime"], ascending=False)

return data

def _write_clean_data(data_dir, data):

clean_data_dir = os.path.join(data_dir, "clean")

if not os.path.exists(clean_data_dir):

os.makedirs(clean_data_dir)

now_str = time.strftime("%Y-%m-%d--%H-%M-%S", time.localtime())

data.to_csv(

os.path.join(clean_data_dir, now_str + ".csv"), index=False, header=None

)

清理之后,所有新闻合并在一个文件中,只保留了【新闻标题】用来分析。

2.3 分词

新闻标题的文字是没有规律的,所以分析之前需要先分词。

# -*- coding: utf-8 -*-

import jieba.posseg as pseg

import pandas as pd

import os

import time

def split_word(fp, data_dir="./data"):

"""对标题进行分词

Parameters:

data_dir - 采集数据的文件夹

fp - 待分词的文件

Returns:

分词后的结果写入文件

"""

mdata = {}

with open(fp, "r", encoding="utf-8") as f:

total = len(f.readlines())

count = 0

f.seek(0)

for line in f:

count += 1

print("解析进度[{}/{}]...".format(count, total))

_jieba(line, mdata)

total = len(mdata)

count = 0

data_list = []

for word in mdata.keys():

count += 1

print("写入进度[{}/{}]...".format(count, total))

data_list.append([word, mdata[word][0], mdata[word][1]])

data = pd.DataFrame(data_list, columns=["单词", "词性", "数量"])

_write_split_data(data_dir, data)

def _jieba(s, mdata):

words = pseg.cut(s, HMM=True)

for word, flag in words:

if _check_flag(flag):

if word not in mdata.keys():

mdata[word] = [flag, 0]

mdata[word][1] += 1

return mdata

def _write_split_data(data_dir, data):

split_data_dir = os.path.join(data_dir, "jieba")

if not os.path.exists(split_data_dir):

os.makedirs(split_data_dir)

now_str = time.strftime("%Y-%m-%d--%H-%M-%S", time.localtime())

data.to_csv(os.path.join(split_data_dir, now_str + ".csv"), index=False)

def _check_flag(flag):

flags = ["n"] # n-名词类,a-形容词类 v-动词类

for fg in flags:

if flag.startswith(fg):

return True

return False

这里使用分词使用是 【结巴分词】库,并且只保留了新闻标题中的 【名词】。

2.4 分析绘图

最后是分析结果,为了快速获取新闻的有效信息,这一步必不可少。

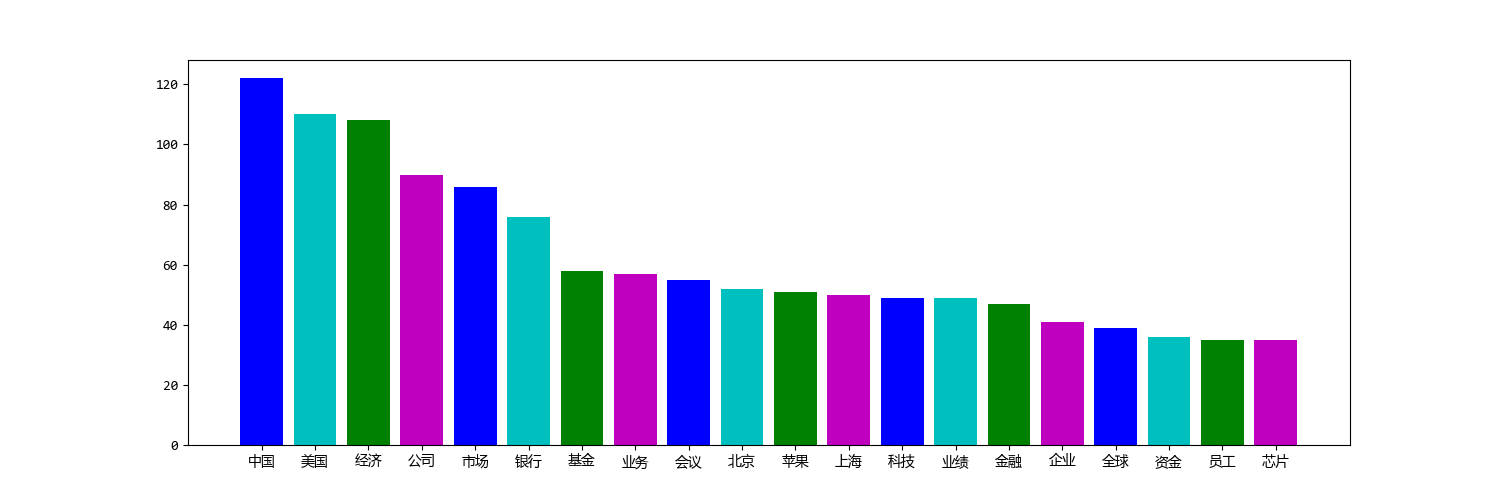

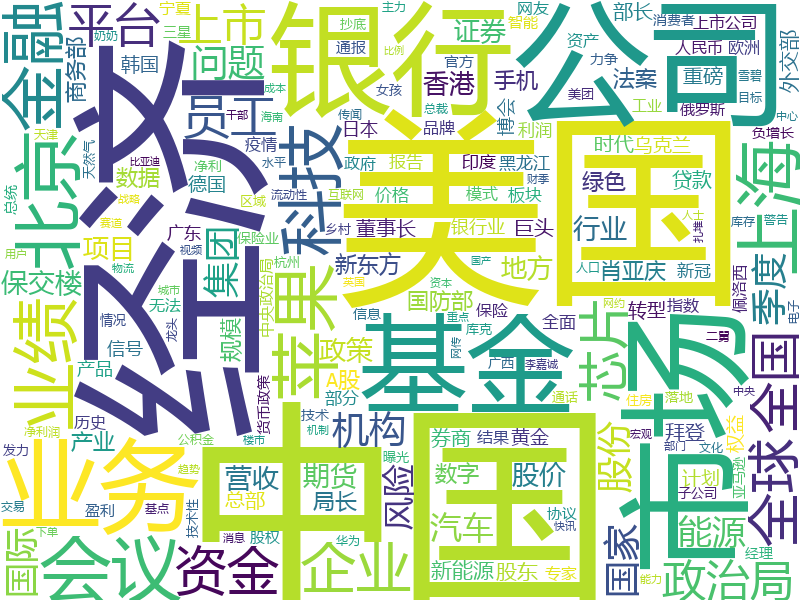

这里只分析了【新闻标题】中的名词,所以这里就做了两张图,一张是高频词的柱状图,一张是词云图。

# -*- coding: utf-8 -*-

import pandas as pd

import os

import wordcloud

from prettytable import PrettyTable

import matplotlib

import matplotlib.pyplot as plt

# 为了显示中文

matplotlib.rcParams["font.sans-serif"] = ["Microsoft YaHei Mono"]

matplotlib.rcParams["axes.unicode_minus"] = False

cn_font_path = "D:\\miniconda3\\envs\\databook\\Lib\\site-packages\\matplotlib\\mpl-data\\fonts\\ttf\\Microsoft-Yahei-Mono.ttf"

def analysis(fp, data_dir="./data"):

"""分析数据

根据分词结果分析结果

"""

data = pd.read_csv(fp)

# 过滤关键词长度为1的数据

data = data[data["单词"].str.len() > 1]

# 创建文件夹

analy_data_dir = os.path.join(data_dir, "analy")

if not os.path.exists(analy_data_dir):

os.makedirs(analy_data_dir)

# 显示前N个关键词

N = 20

_topN_table(data, N)

# 高频词柱状图比较

_topN_bar_graph(data, N, analy_data_dir)

# 词云 图

_word_cloud(data, analy_data_dir)

def _topN_table(data, n):

tbl = PrettyTable()

data = data.sort_values(by=["数量"], ascending=False)

tbl.field_names = data.columns.values.tolist()

tbl.add_rows(data.head(n).values.tolist())

print(tbl)

def _topN_bar_graph(data, n, d):

data = data.sort_values(by=["数量"], ascending=False)

data = data.head(n)

y = list(data["数量"])

plt.bar(range(n), height=y, tick_label=range(1, n + 1), color=["b", "c", "g", "m"])

plt.xticks(range(n), data["单词"])

fig = plt.gcf()

fig.set_size_inches(15, 5)

plt.savefig(os.path.join(d, "bar.png"))

def _word_cloud(data, d):

w = wordcloud.WordCloud(

width=800, height=600, background_color="white", font_path=cn_font_path

)

# 词频大于N的单词才展示

N = 5

data = data[data["数量"] > N]

dic = dict(zip(list(data["单词"]), list(data["数量"])))

w.generate_from_frequencies(dic)

w.to_file(os.path.join(d, "word_cloud.png"))

注意,这里为了显示中文,我引入了自己的字体(Microsoft-Yahei-Mono.ttf),你也可以换成任何能够显示中文的字体。

3. 总结

其实,上面的功能主要就是找出新闻中的高频词,从而可以看看公众最近关注最多的是哪方面。

虽然简单,但是麻雀虽小五脏俱全,整个流程是完备的,有兴趣的话,每个流程中的细节可以继续丰富。

代码运行的最终结果如下:(运行时间:2022-07-29 中午12点多,新闻是不断更新的,不同时间采集的话,运行结果会不一样)

4. 注意事项

爬取数据只是为了研究学习使用,本文中的代码遵守:

- 如果网站有 robots.txt,遵循其中的约定

- 爬取速度模拟正常访问的速率,不增加服务器的负担

- 只获取完全公开的数据,有可能涉及隐私的数据绝对不碰