一、Hive安装及配置

1,把apache-hive-2.3.6-bin.tar.gz上传到linux的/software目录下

清华大学资源包:https://mirrors.tuna.tsinghua.edu.cn/apache/hive/

2,解压apache-hive-2.3.6-bin.tar.gz到/module/目录下面:tar -zxvf apache-hive-2.3.6-bin.tar.gz -C /module/

3,修改apache-hive-2.3.6-bin.tar.gz的名称为hive-2.3.6 :mv apache-hive-2.3.6-bin/ hive-2.3.6

4,修改/module/hive/conf目录下的hive-env.sh.template名称为hive-env.sh:mv hive-env.sh.template hive-env.sh

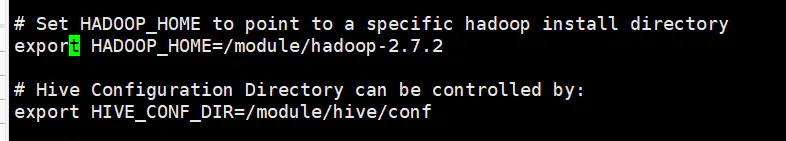

5,配置hive-env.sh文件:vi hive-env.sh

配置HADOOP_HOME路径:export HADOOP_HOME=/module/hadoop-2.7.2

配置HIVE_CONF_DIR路径:export HIVE_CONF_DIR=/module/hive/conf

二、Hadoop集群配置

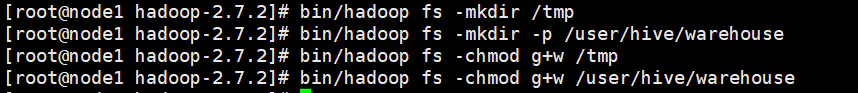

1,必须启动HDFS和YARN:sbin/start-dfs.sh ,sbin/start-yarn.sh

2,进入hadoop-2.7.2 目录,创建/tmp和/user/hive/warehouse两个目录并修改他们的同组权限可写

bin/hadoop fs -mkdir /tmp ,bin/hadoop fs -mkdir -p /user/hive/warehouse

改权限:bin/hadoop fs -chmod g+w /tmp , bin/hadoop fs -chmod g+w /user/hive/warehouse

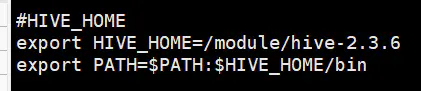

三、修改Hive环境变量,之后source一下

#HIVE_HOME

export HIVE_HOME=/module/hive-2.3.6

export PATH=$PATH:$HIVE_HOME/bin

三、Hive元数据配置到MySql

一、驱动拷贝

1.在/software/mysql-libs目录下解压mysql-connector-java-5.1.27.tar.gz驱动包:

tar -zxvf mysql-connector-java-5.1.27.tar.gz

官网包:https://dev.mysql.com/downloads/file/?id=476197

2.拷贝/software/mysql-libs/mysql-connector-java-5.1.27目录下的mysql-connector-java-5.1.27-bin.jar到/module/hive-2.3.6/lib/ :

cp mysql-connector-java-5.1.27-bin.jar /module/hive-2.3.6/lib/

二、配置Metastore到MySql

1.在/module/hive/conf目录下创建一个hive-site.xml :vi hive-site.xml

2.根据官方文档配置参数,拷贝数据到hive-site.xml文件中

2020421:mysql连接信息后增加 &useSSL=false ,不然hive 的任何命令会报ssl错误

https://cwiki.apache.org/confluence/display/Hive/AdminManual+MetastoreAdmin

<?xml version="1.0"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<configuration>

<property>

<name>javax.jdo.option.ConnectionURL</name>

<value>jdbc:mysql://node1:3306/hive?createDatabaseIfNotExist=true&useSSL=false</value>

<description>JDBC connect string for a JDBC metastore</description>

</property>

<property>

<name>javax.jdo.option.ConnectionDriverName</name>

<value>com.mysql.jdbc.Driver</value>

<description>Driver class name for a JDBC metastore</description>

</property>

<property>

<name>javax.jdo.option.ConnectionUserName</name>

<value>root</value>

<description>username to use against metastore database</description>

</property>

<property>

<name>javax.jdo.option.ConnectionPassword</name>

<value>000000</value>

<description>password to use against metastore database</description>

</property>

<property>

<name>hive.cli.print.header</name>

<value>true</value>

</property>

<property>

<name>hive.cli.print.current.db</name>

<value>true</value>

</property>

<property>

<name>hive.metastore.schema.verification</name>

<value>false</value>

</property>

</configuration>

3.关闭元数据检查:hive-site.xml 里面增加一个配置:不加这个使用Hive的时候会连接超时,并且找不到元数据

<property>

<name>hive.metastore.schema.verification</name>

<value>false</value>

</property>

4,进入到Hive的conf目录下(为什么别人是进bin?我进入bin执行的是derby的初始化,会失败),此条已废弃,存在问题,详细信息见下面解释。

4,更新: 在使用了上面的conf目录进行元数据初始化的之后,存在一个问题:即,必须在conf目录下进入Hive才会得到mysql的元数据,在别的目录下进Hive会是默认的derby元数据,而且会超时报错。也就是说实际上并没有做到真正的使用mysql存储元数据,困扰了一晚上,最后找的了下面的解决方式。

原因:是因为hive依赖hadoop(hive-env.sh里设置有hadoop的路径),但是hadoop的环境变量却没有读到hive-site.xml

解决方式:

参考文档:

https://blog.csdn.net/lsr40/article/details/78026125(hive-site.xml修改之后不生效与一些beeline,hiveserver2的报错)

重要重要重要

1,hadoop的配置文件hadoop-env.sh中(其实就是hadoop的根目录下的etc/hadoop里面的那些配置文件里)

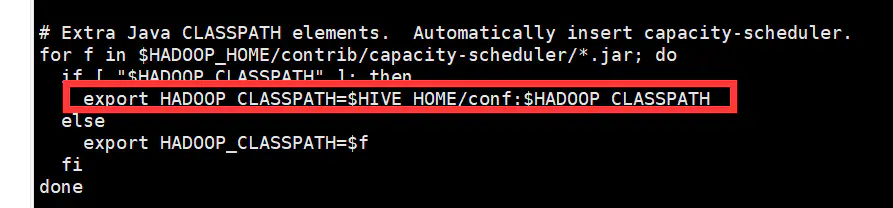

找到export HADOOP_CLASSPATH这行,修改值为

export HADOOP_CLASSPATH=$HIVE_HOME/conf:$HADOOP_CLASSPATH(HIVE_HOME必须配置环境变量,或者写死)

2,之后再回到Hive的bin目录下进行元数据初始化,这样无论在哪个目录下进入Hive,使用的都会是mysql。(bin目录下进行的初始化才是真的使用了mysql元数据)

配置元数据类型为mysql:schematool -dbType mysql -initSchema

注:如果创建失败,看看site 文件里(node1:3306/hive?createDatabaseIfNotExist=true),那个Hive的数据库是不是已经在Mysql 创建了,删掉再重新初始化即可。

5.配置完毕后,如果启动hive异常,可以重新启动虚拟机。(重启后,别忘了启动hadoop集群)