5 月 19、20 日,行业精英齐聚的 WebRTCon 2018 在上海举办。又拍云 PrismCDN 项目负责人凌建发在大会做了《又拍云低延时的 WebP2P 直播实践》的精彩分享。

分享介绍了 WebP2P 行业将从 FlashP2P 逐步进入 H5P2P,并分享了又拍云 PrismCDN 网络如何突破传统 P2P 网络高延迟、低分享率的难题。

因分享内容较多,特将演讲整理为两部分:

- 取代 FlashP2P,H5P2P 将成为 WebP2P 主流:介绍几类 P2P 的架构、原理、优劣势,介绍传统树状、网状两种 P2P 结构的不足。

- PrismCDN 网络的架构解析,以及低延迟、低成本的奥秘:介绍又拍云 PrismCDN 的结构、优势,分析又拍云 PrismCDN 达成好体验、低成本、易使用的奥秘。

本文是第二部分《PrismCDN 网络的架构解析,以及低延迟、低成本的奥秘》

又拍云做 PrismCDN 这个产品,主要有三个要求:

第一,把体验做好;

第二,降低成本;

第三,要易使用。

我们先来看一下又拍云 PrismCDN 所取得的成绩,一项项分析 PrismCDN 在好体验、低成本、易使用三方面是否达标。

PrismCDN 一开始做 SDK P2P,在体验好、低成本上做得比较到位,但在“易使用”上不够优秀。所以我们研发了 WebP2P 功能。

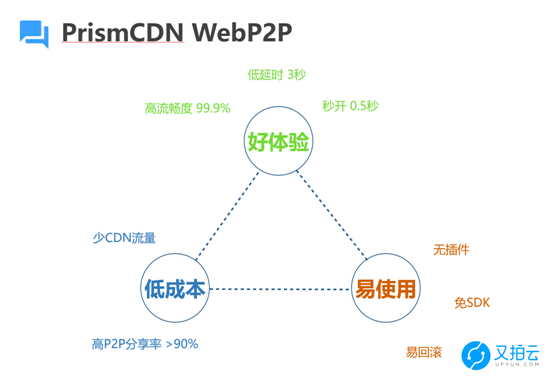

△ 又拍云 PrismCDN WebP2P

易使用:无插件、免 SDK、易回滚

SDK 要嵌入到客户的 App 里面去,客户会担心三个问题:

- SDK 的稳定性;

- SDK 升级的时候,客户需要重新发布新的App版本;

- SDK 部署之后,难回滚。

又拍云 PrismCDN 团队设计 WebP2P 的时候,集中解决了“易使用”这个难题。

WebP2P 没有插件,也没有 SDK,只是 JS 而已;发生异常只需切一下老版本就好,不需要像 App 那样重新发布一个新版本,客户的开发成本下降,风险也降低了。

体验好:流畅度高、延时低、秒开

我们把 P2P 直播的体验分为“流畅度”“延时低”“秒开”几个指标。

- 流畅度:尽量不要卡顿,把卡顿率降下来,我们做到了 99.9%;。

- 延时低:延时在 3 秒水平,和 CDN 直播的延时是相同的。秀场直播或者游戏直播,有一定的互动,延时一定控制在几秒之内,用户才可以接受。

- 秒开:首屏秒开,用户一点进去的时候,直播画面就能启动起来;当然首屏时间和 P2P 没什么关系。

低成本:

又拍云 PrismCDN 90%的流量来自于 P2P 雾节点,只需要 CDN 边缘节点补充 10% 的流量。雾节点的成本大大低于 CDN 边缘节点的成本,P2P 分享率高,就意味着整体成本下降,对客户来说非常划算。

PrismCDN 架构解析

后面我会分析我们是如何做到这三点的。在这之前,先了解一下又拍云 PrismCDN 的架构。

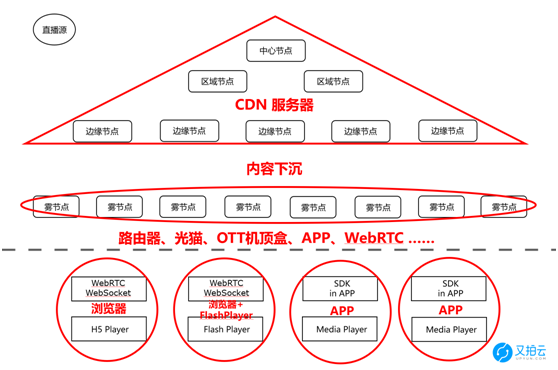

△ 又拍云 PrismCDN 架构示意图

三角形里是 CDN 服务器。熟悉 CDN 的人都知道它有三层的架构:中心节点、区域节点、边缘结点。

我们在做 PrismCDN 这张 P2P-CDN 网络时,引入了“雾节点”。雾节点包括 OTT 机顶盒、路由器、APP 等,运行 WebRTC 的网页也是可以充当雾节点。我们会把数据从 CDN 边缘节点再次下沉,下沉到雾节点上。最后通过雾节点向客户提供数据。

这个架构把 CDN 网络的三层模型变成了四层模型。第四层就是布置在用户边上的雾节点,在离用户最近的边缘计算资源里面。

第五排是最终用户端。示意图里把用户端要拆分为 WebRTC、Flash、App 几个模块,本质上是同一个。

放大 CDN 带宽的雾节点

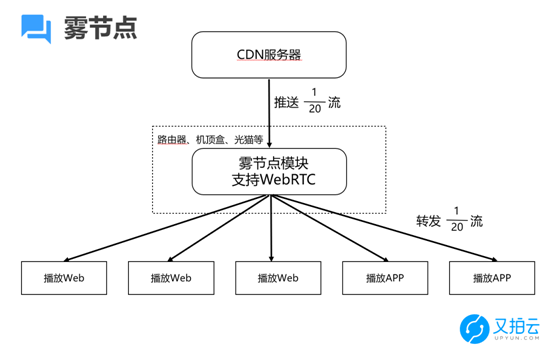

我们重点看一下“雾节点”是怎么回事。CDN 网络的边缘节点,统一看成一个 CDN 服务器。CDN 服务器会推送 1/20 的数据流到雾节点上。雾节点会和十几、二十个播放端相连,直接把这 1/20 数据流转发到各个播放端。

△ 又拍云 PrismCDN “雾节点”运行示意图

我们可以计算一下。假设 CDN 推送 2M 的直播流,到了雾节点这边就是 100K 的数据,假设雾节点转发到 10 个播放端,这 10 个播放端就得到了 1M 的数据。这 1M 数据对于播放端来讲都是有效数据,即 CDN 的 100K 宽带,通过一个雾节点使播放端得到了 1M 的带宽,这起到了放大 CDN 带宽的作用,相当于把 CDN 带宽放大了 10倍。

哪些设备能成为雾节点呢?以路由器举个例子。路由器只要集成一个 PrismCDN 雾节点的模块,在这个模块实现 WebRTC 需要的协议,比如 ICE、STUN 用于穿透的协议、DataChannel、DTLS、SCTP 等 P2P 连接的协议。有了这些协议就可以实现雾节点之间以及雾节点与 Web、 APP 之间的通讯。

同理,在播放的 App 也可以成为雾节点,只要它支持 WebRTC 协议并且保持在线。App 可以根据客户的需求来配置是否作雾节点。如果说客户需要提供转发,我们就可以把这个模块运行起来。

播放 Web 也可以作雾节点。这个比较好理解,本质上是两个 Web 之间传数据。同理,我们也可以通过根据客户的需求,配置 Web 要不要作雾节点转发数据。

PrismCDN 网络运作介绍

通过 PrismCDN 网络实现 P2P 直播,具体讲起来还是有点复杂的,我们一步步来介绍。

第一步,先是直播源把一个 RTMP 流推到 CDN 网络的中心节点上。CDN 中心节点对这个源进行做切块,比如 20K 大小的 Block,于是直播流就变成了一个个 Block 的序列。在 CDN 网络里先把 Block 序列逐层发送到边缘节点上。

在 CDN 边缘节点到雾节点之间,就不是传输一个 Block 了,而是传输 Block 里面的 1/20。我们通过一些算法从 Block 里面抽取 1/20 的数据推送到雾节点上面。雾节点再把 1/20 的数据转发给和它相连的若干个播放节点。

一个雾节点会连接很多个播放节点,一个播放节点也会和很多个雾节点相连,并从这些雾节点处收数据。播放节点从每个雾节点获取的数据,就是CDN边缘节点推送到雾节点的 Block 的 1/20 子数据流。

这就是 PrismCDN 网络 P2P 部分的工作逻辑。

如果说 P2P 某些节点是丢包了,或者是掉线了,那么播放节点可以直接连接 CDN 边缘节点,把丢失或者需要补充的数据给拉回来。最终播放节点能够把来自雾节点和 CDN 边缘节点的数据数据组合还原出来原始的流,然后再通过转封装成 MP4 或者 FLV 等格式之后,喂给相应的播放器。

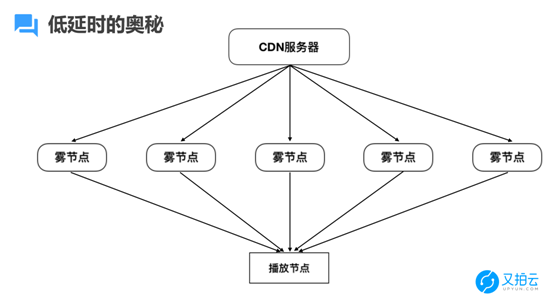

低延迟的奥秘:扁平化模型

传统 P2P 最大的问题就是延时很高,不论树型的直播方案,还是 Peer5、Streamroot 等网状型直播方案,延时都非常高。

PrismCDN 网络是怎么做到低延时的呢?这和我们的扁平化的模型有关。

CDN 服务器几乎同时把一个数据流的 1/20 子流推到很多雾节点,雾节点同时把数据推到了播放节点。整个过程中,数据路径非常短,它只是通过雾节点同时中转一下。

通过扁平化的方案,PrismCDN 把延时控制在了 3 秒以内,和传统 CDN 差不多,这个延时水平能够满足游戏直播、秀场直播、体育直播等多个直播场景。相比之下,传统 P2P 直播的延时有半分钟甚至 1 分钟之多。

△ PrismCDN 低延迟的奥秘:扁平化模型

高流畅的奥秘:雾节点智能选择、冗余链接

再来看看 PrismCDN 网络在高流畅方面是怎么做的。

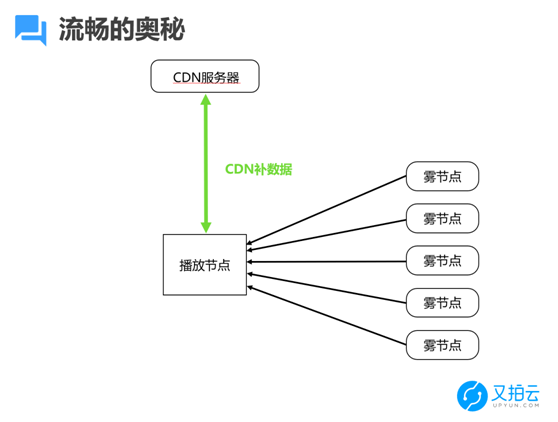

△ PrismCDN 高流畅的奥秘:CDN 边缘节点补数据

从上面的介绍,我们知道一个播放节点的大部分数据是来自于雾节点。完全依赖雾节点,会出现数据缺失。遇上数据丢失,PrismCDN 会通过数据通道从 CDN 边缘节点拉取数据。这个模型就是 P2SP。

要做到流畅的话,要分两大块去考虑的:一块是资源;另一方面是技术,包括调度算法、回源算法等内容。

比如说在数据通道里面,我们就会有各种方式做尝试、做测试。又拍云 PrismCDN 团队在线上、在生产环境里面去做对比测试,发现用 UDP 来传数据要比 TCP 效果好很多,流畅度上面大概要高 5%。

在 WebP2P 里面,有两种补数据的方式:一种是要 WebSocket 去补数据,另外一种是用 WebRTC DataChannel 去补数据。我们在这两种方案里面进行 AB Testing。

资源不足的话,技术做得再好都没用。好比 CDN 网络,需要备充足的资源之后才能提供很好的服务。我们依赖于又拍云 CDN 网络在全国各地的服务器、CDN 节点资源,同时雾节点的资源也部署了 100 多万个。

雾节点智能选择

PrismCDN 有超百万规模的雾节点,雾节点的选择是非常重要的。

我们在雾节点、播放节点方面有几个心得:

- 智能选择雾节点

- 雾节点、播放节点就近原则

- 雾节点、播放节点相同 ISP 原则

- 冗余链接,大数据分析雾节点质量

雾节点和播放节点,尽量匹配相同 ISP、相同区域进行对接。假设某个雾节点是使用上海电信的,我们尽量给他匹配上海电信的播放节点。因为跨地区、跨运营商的传输质量不太好。跨运营商的通信质量不大好,尤其是对 UDP 协议的支持质量。为了避免运营商之间的数据传输出现错误,PrismCDN 自写了一层去校验数据包是否正确。

我们还可以对雾节点的质量进行统计分析,做更好的匹配。

冗余链接

看完雾节点选择的优化,我们再看看连接的情况。又拍云 PrismCDM 的连接原则,概括一下就是:启用冗余 P2P 连接,根据节点质量调整冗余度,减少 CDN 回源量。

每个雾节点传输一个 Block 的 1/20 数据,按理说一个播放节点连接 20 个雾节点就可以了。实际上一个播放节点通常会多连接 1 到 2 个雾节点。因为雾节点毕竟是 P2P 节点,稳定性没有像 CDN 节点那么高,有时候会退出、会掉线、会丢包,必须给播放节点准备一些冗余连接。比如说播放节点连接了 21 个雾节点,某一个雾节点中断或者丢包了,没关系,播放节点已经收到 20 份数据了,还是能够组合、还原出原始数据。

同时可以根据实时的传输情况来调整播放节点的链接冗余度。如果传输都是稳定的,一个播放节点连 21 个雾节点就可以了。如果传输的抖动比较大,或者雾节点不太稳定,冗余链接数就放大一点。最终目的是播放节点需要的数据都能从雾节点收到,不需要启动 CDN 回源,不需要去 CDN 边缘节点拉取补充数据,这样流畅度就变得非常高。

CDN 的成本要高于 P2P,因此用冗余链接的方式减少 CDN 回源,除了保障流畅度,还可以降低成本。

低成本的奥秘:P2P 分享率高

最后看又拍云 PrismCDN 低成本的一些情况。

通过 PrismCDN,播放带宽由两部分组成:一部分是 CDN 带宽,一部分是 P2P 带宽。我们的原则就是,提高 P2P 雾节点的分享率:加大 P2P 带宽的比例,尽可能减少 CDN 带宽占比。

在传统 P2P 网络里,数据在播放节点之间互传,播放器会下载数据后分享一部分给别人。也就是说只有在播放的时候,节点才能给别人传输数据。

现在的家庭带宽都是上下不对称的,下行如果有 20M,上行一般只有 2 到 4M 左右。大致计算一下,如果是一个码率 3M 的直播流,有 1000 个并发观看,累加起来的播放带宽要达到 3G。那么这时候这 1000 个播放终端供应的带宽上限是 2G,即使每个人全部供应数据,连接非常高效率的话,也存在 1G 的差额。这 1G 的数据,就需要 CDN 边缘节点去补。

相比于传统的 P2P 来做的话,PrismCDN 引入了纯粹提供数据但不需要播放的设备,比如路由器、机顶盒、光猫等设备。这样就填补了上面所说的 1G 的差额。

刚才也提到了,冗余链接不仅能够保证流畅度,也可以提供低成本的优势。尽量从雾节点多传一点数据,减少通过 CDN 边缘节点拉取数据的概率。毕竟雾节点的成本比 CDN 低的多。雾节点的流量增多,CDN 边缘节点流量减少,整张 PrismCDN 网络的成本就会降下来。