配置的伪分布式,ubuntu14.04上

先配置hadoop,参见这个博客,讲的很好

http://www.powerxing.com/install-hadoop/,

但是我在配的过程中还是遇到了问题:

问题1:设置免登录的时候,虽然是按步骤做的,但ssh localhost测试,总是提示要输入密码。这个博客说的比较清楚:http://blog.csdn.net/budapest/article/details/8022926

解决办法:chmod 600 authorized_keys

问题2:在运行hadoop例子的过程中,提示找不到java_home的路径,虽然我在全局已经配置了,但是貌似这个是找hadoop的配置文件

解决办法:找到 /usr/local/hadoop/etc/hadoop 目录下的 hadoop-env.sh,最末尾加上JAVA_HOME的路径

配置完hadoop ,接下来配置spark

参见博客:http://bit1129.iteye.com/blog/2171761

1.这个博客里提到的hadoop.master 对应的ip 是在 /etc/hosts 文件中配置对应关系

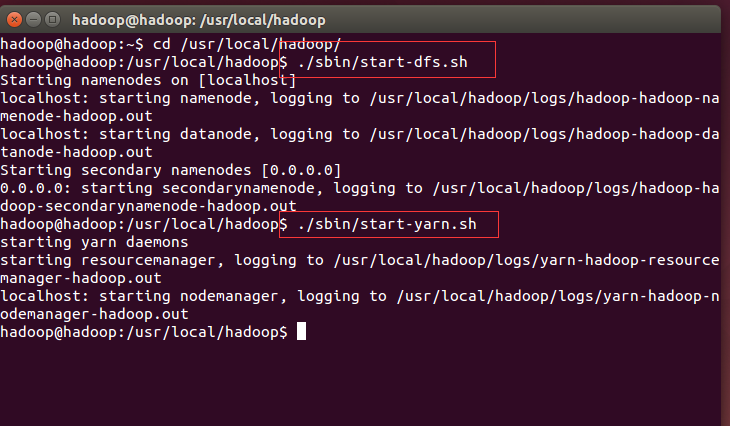

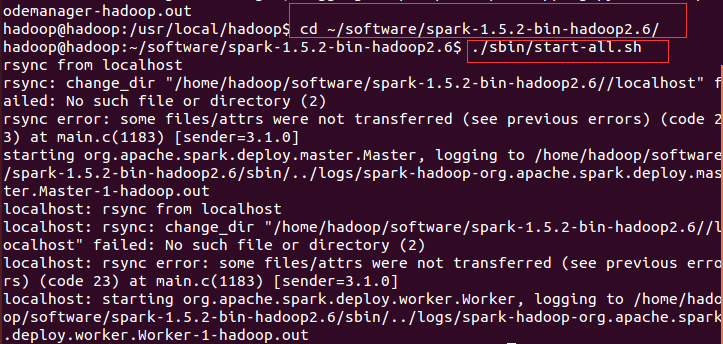

2.运行spark前,需要先启动hadoop。如图:

步骤一:

步骤二:

然后运行shell就好了