资料来源:1.、https://blog.csdn.net/guyuealian/article/details/70995333

2、http://freewill.top/2017/01/18/7%EF%BC%886%C%9AAdaBoost/

努力的小目标(SSD行人检测):1、https://blog.csdn.net/linolzhang/article/details/

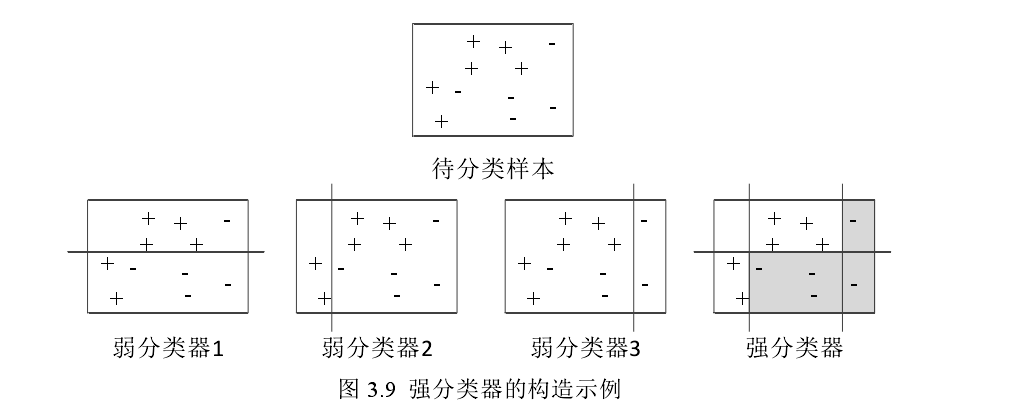

AdaBoost(自适应提升):使用多个弱分类器组合得到强的分类器。

其基本思想就是:1.现有一批训练样本,给定一些弱分类器类型(不指定分类器的具体形式,只指定分类器的基本形式);

2.初始给定每个样本点一样的权值,初始先选定几个弱分类器中错误率最小的(如H1)开始训练;

3.每次训练后,被错误分类的样本点权值增大,正确的权值减小,根据一定规则,

给这次的分类器一个权值为得到最后的强分类器做准备;

4.通过更新的权值,选择几个分类器中错误率最小的一个进行接下来的训练(也有可能还是H1);

5.经过这样的重复操作,最后将所有的带权值的若分类器相加组合得到最终的强分类器

图片来自:https://kns.cnki.net/kcms/detail/

AdaBoost算法误差界分析:https://zhuanlan.zhihu.com/p/79167891(讲得很通俗)

HOG特征提取中,由于局部光照的变化,使得 HOG 特征在计算过程中梯度强度的变化范围较大,因此需要对梯度强度进行归一化

常见的归一化的方法:1、https://davex.pw/2017/10/07/Normalization-and-Regularization/

2、https://blog.csdn.net/pipisorry/article/details/52247379(不是很懂,谨慎看待)

verilog中几种排序方法: 1、https://blog.csdn.net/yanchuan23/article/details/79780605

2、https://reborn.blog.csdn.net/article/details/80469391

流水线技术的简单解释:1、https://blog.csdn.net/Times_poem/article/details/52033535