注意力机制CV领域是从NLP领域借鉴过来的,比如:一段话中提取关键的、具备代表性的词语。这个其实在以前聚类算法中学习过,例如:利用bag of word技术,提取一篇论文的关键词,实现论文查重功能。

一、CBAM

如下图的Channel Attention Module,将一个32×32×256维度的特征图,在channel维度上,给出256个权重,所谓注意力就是重点考虑权重大特征图。类似于softmax,这里输出一个维度为256权重向量。然后将权重向量各自与Input Feature每张图相乘,得到新的特征图。 在后续Spatial Attention Module中,在32×32这两个维度,计算类似于上述的权重矩阵(32×32),同理,将256个权重矩阵依次与新的特征图相乘,得到最终新的特征图,即:优化后的特征图。

二、SAM

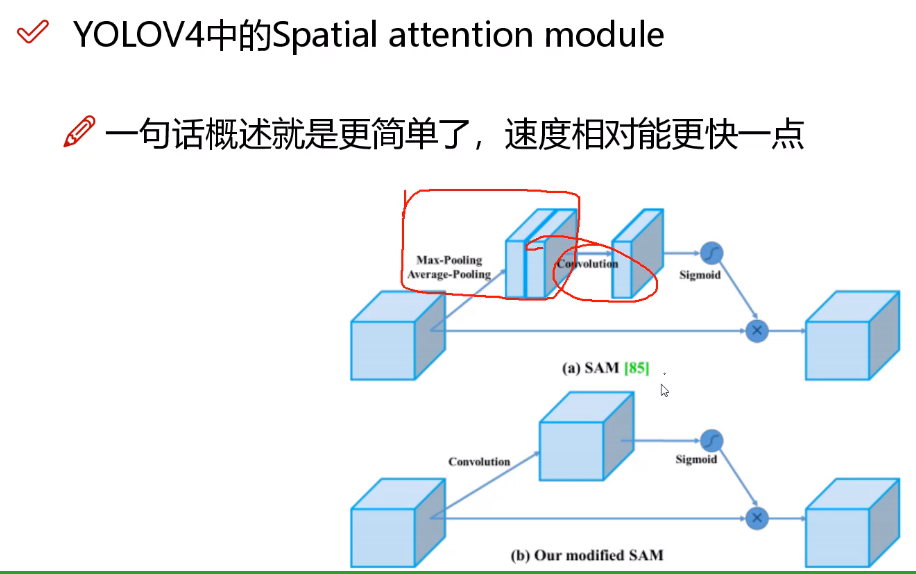

YOLOV4中并没有使用CBAM,而是SAM,SAM仅仅考虑在空间(Spatial)维度上进行特征图优化。 如下图(a)原始SAM,先是最大池化、平均池化,后续接着卷积,YOLOV4直接将这两步骤合并,可以降低计算量,如图(b)。