全局命令

startproject

genspider

settings

runspider

shell

fetch

view

version

这些全局命令就是不依托项目存在的,也就是不管你有没有项目都能够运行

startproject

创建项目

scrapy startproject quotetutorial

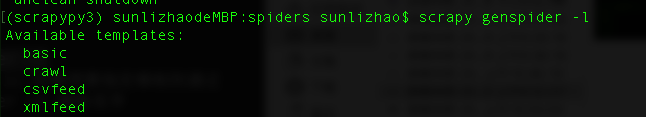

genspider

列出所有模板

scrapy genspider -l

创建一个spider蜘蛛(默认用的basic)

scrapy genspider quotes quotes.toscrape.com

创建一个指定的模板的spider

scrapy genspider -t crawl zhihu www.zhihu.com

settings

查看你对你的scrapy设置了哪些参数

通过scrapy settings -h 来获取这个命令的所有帮助信息,不常用

获得蜘蛛的下载延迟 scrapy settings --get DOWNLOAD_DELAY 得到蜘蛛项目的名称 scrapy settings --get BOT_NAME

如果没有获取结果则返回none

runspider

这个命令基于文件运行蜘蛛,

也就是 说你按照scrapy的蜘蛛格式编写了一个py文件,不想创建项目,可以用到runspider

scrapy runspider scrapy_cn.py

- 如果你要用runspider运行项目下的spider,要进入项目下的spider目录下运行,命令后面的是spider的文件名

shell

这个命令主要用于调试,穿入一个url,进入一个交互环境

scrapy shell http://www.baidu.com

通过css选择器以及xpath选择器来获取我们想要的内容

fetch

在项目外面,相当于一次请求,返回一些日志信息和网站源代码

scrapy fetch http://www.baidu.com 选项 --nolog 忽略日志xinxi scrapy fetch --nolog http://www.baidu.com --headers 输出请求头信息 scrapy fetch --nolog --headers http://www.baidu.com --no-redirect 禁止重定向 scrapy fetch --nolog --no-redirect http://www.baidu.com

view

和fetch类似都是查看蜘蛛看到的是否和你看到的一致,便于排错,

请求一个url,把网页源代码保存成一个文件,并用浏览器打开

scrapy view http://www.baidu.com

version

查看版本信息

scrapy version

查看依赖库信息

scrapy version -v

接下来我们看一下项目命令

crawl

check

list

edit

parse

bench

crawl

运行spider,spider名称不是文件名

scrapy crawl spider名称

check

检查蜘蛛,排错,查找错误

scrapy check spider名称

list

显示项目中的所有蜘蛛

scrapy list