假如我有一个文件在HDFS上分成了0~3,共四块,那么如何把它们下载到本地并且恢复成完整的文件呢?

public class TestCustomUploadAndDownload {

private FileSystem fs;

private FileSystem localFs;

private Configuration conf = new Configuration();

@Before

public void init() throws IOException, URISyntaxException {

//创建一个客户端对象

fs=FileSystem.get(new URI("hdfs://hadoop101:9000"),conf);

localFs=FileSystem.get(new Configuration());

}

@After

public void close() throws IOException {

if (fs !=null) {

fs.close();

}

}

//从HDFS中下载第一个块的文件,即0~128M

@Test

public void testFirstBlock() throws Exception {

//提供两个Path,和两个FileSystem

Path src=new Path("/sts.zip");

Path dest=new Path("e:/firstblock");

// 使用HDFS的分布式文件系统中获取的输入流,读取HDFS上指定路径的数据

FSDataInputStream is = fs.open(src);

// 使用本地文件系统中获取的输出流写入本地文件

FSDataOutputStream os = localFs.create(dest, true);

// 1k

byte [] buffer=new byte[1024];

// 流中数据的拷贝

for (int i = 0; i < 1024 * 128; i++) {

is.read(buffer);

os.write(buffer);

}

//关流

IOUtils.closeStream(is);

IOUtils.closeStream(os);

}

//从HDFS中下载第二个块的文件,即128~256M

@Test

public void testSecondBlock() throws Exception {

//提供两个Path,和两个FileSystem

Path src=new Path("/sts.zip");

Path dest=new Path("e:/secondblock");

// 使用HDFS的分布式文件系统中获取的输入流,读取HDFS上指定路径的数据

FSDataInputStream is = fs.open(src);

// 使用本地文件系统中获取的输出流写入本地文件

FSDataOutputStream os = localFs.create(dest, true);

//定位到流的指定位置

is.seek(1024*1024*128*2);

// 1k

byte [] buffer=new byte[1024];

// 流中数据的拷贝

for (int i = 0; i < 1024 * 128; i++) {

is.read(buffer);

os.write(buffer);

}

//关流

IOUtils.closeStream(is);

IOUtils.closeStream(os);

}

//从HDFS中下载第三个块的文件,即256~384M

@Test

public void testSecondBlock() throws Exception {

//提供两个Path,和两个FileSystem

Path src=new Path("/sts.zip");

Path dest=new Path("e:/thirdblock");

// 使用HDFS的分布式文件系统中获取的输入流,读取HDFS上指定路径的数据

FSDataInputStream is = fs.open(src);

// 使用本地文件系统中获取的输出流写入本地文件

FSDataOutputStream os = localFs.create(dest, true);

//定位到流的指定位置

is.seek(1024*1024*128*2);

// 1k

byte [] buffer=new byte[1024];

// 流中数据的拷贝

for (int i = 0; i < 1024 * 128; i++) {

is.read(buffer);

os.write(buffer);

}

//关流

IOUtils.closeStream(is);

IOUtils.closeStream(os);

}

//从HDFS中下载最后一个块的文件

@Test

public void testFinalBlock() throws Exception {

//提供两个Path,和两个FileSystem

Path src=new Path("/sts.zip");

Path dest=new Path("e:/fourthblock");

// 使用HDFS的分布式文件系统中获取的输入流,读取HDFS上指定路径的数据

FSDataInputStream is = fs.open(src);

// 使用本地文件系统中获取的输出流写入本地文件

FSDataOutputStream os = localFs.create(dest, true);

//定位到流的指定位置

is.seek(1024*1024*128*3);

//buffSize 默认不能超过4096

IOUtils.copyBytes(is, os, 4096, true);

//因为是最后一个块,所以直接使用流拷贝,拷贝剩下的所有文件

}

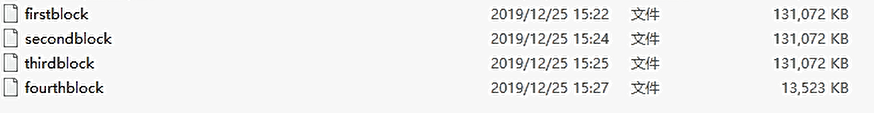

这就是从HDFS下载在本地后每个块对应的文件了

那么,如何把这些零散的文件拼接成一个完整的文件呢?

在linux中,对文件的拼接使用的命令是cat

例如,把文件1的内容追加到文件2中:

cat file1 >> file2

而在windows的cmd中,使用的命令是type

把四个文件拼接在一起,分别执行:

type secondblock >> firstblock

type thirdblock >> firstblock

type fourthblock >> firstblock

最后恢复成原文件,只需要改后缀名即可!