学习完了mycat的高可用还是复习一下MHA+atlas吧,个人感觉还是比mycat好用,毕竟MHA有数据补全和切换主从的机制

1 MHA是什么?

- MHA(Master High Availability)目前在MySQL高可用方面是一个相对成熟的解决方案,它由日本DeNA公司youshimaton(现就职于Facebook公司)开发,是一套优秀的作为MySQL高可用性环境下故障切换和主从提升的高可用软件。在MySQL故障切换过程中,MHA能做到在0~30秒之内自动完成数据库的故障切换操作,并且在进行故障切换的过程中,MHA能在最大程度上保证数据的一致性,以达到真正意义上的高可用。

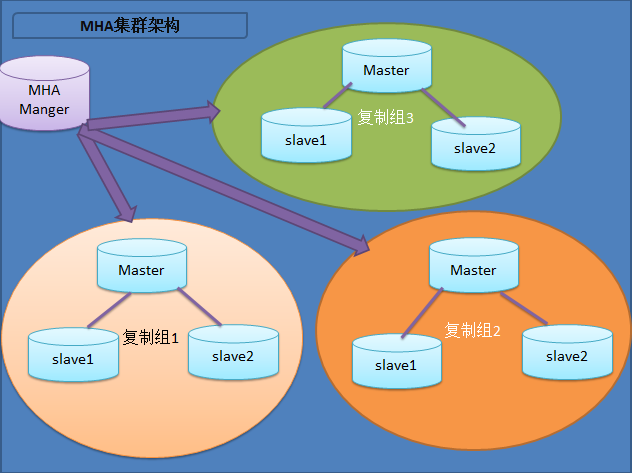

- 该软件由两部分组成:MHA Manager(管理节点)和MHA Node(数据节点)。MHA Manager可以单独部署在一台独立的机器上管理多个master-slave集群,也可以部署在一台slave节点上。MHA Node运行在每台MySQL服务器上,MHA Manager会定时探测集群中的master节点,当master出现故障时,它可以自动将最新数据的slave提升为新的master,然后将所有其他的slave重新指向新的master。整个故障转移过程对应用程序完全透明。

- 在MHA自动故障切换过程中,MHA试图从宕机的主服务器上保存二进制日志,最大程度的保证数据的不丢失,但这并不总是可行的。例如,如果主服务器硬件故障或无法通过ssh访问,MHA没法保存二进制日志,只进行故障转移而丢失了最新的数据。使用MySQL 5.5的半同步复制,可以大大降低数据丢失的风险。MHA可以与半同步复制结合起来。如果只有一个slave已经收到了最新的二进制日志,MHA可以将最新的二进制日志应用于其他所有的slave服务器上,因此可以保证所有节点的数据一致性

- 目前MHA主要支持一主多从的架构,要搭建MHA,要求一个复制集群中必须最少有三台数据库服务器,一主二从,即一台充当master,一台充当备用master,另外一台充当从库,因为至少需要三台服务器,出于机器成本的考虑,淘宝也在该基础上进行了改造,目前淘宝TMHA已经支持一主一从。

MHA实现机制:

- 监控AB的状态

- 完整的选举机制(看谁的数据跟master最接近)

- 让一个B切换到新A

- 保证数据的完整性(通过差异还原)

环境准备:

- db01 主 10.0.0.51

- db02 从 10.0.0.52

- db03 从 10.0.0.53

- mha+atlas 10.0.0.55

1.1 搭建MySQL主从

1.1.1 MySQL配置文件

[root@db01 ~]# cat /etc/my.cnf [client] socket = /data/mysql.sock [mysqld] lower_case_table_names = 1 default-storage-engine = InnoDB port = 3306 datadir = /data character-set-server = utf8 socket = /data/mysql.sock log_bin=mysql-bin #主从开启binlog server_id = 1 #serverID不能相同 gtid_mode=ON #开启GTID复制 log_slave_updates enforce_gtid_consistency innodb_buffer_pool_size = 200M slave-parallel-workers = 8 thread_cache_size = 600 back_log = 600 slave_net_timeout = 60 max_binlog_size = 512M key_buffer_size = 8M query_cache_size = 64M join_buffer_size = 2M sort_buffer_size = 2M query_cache_type = 1 thread_stack = 192K innodb_thread_concurrency = 8 connect_timeout = 300 max_connections = 6000 max_allowed_packet = 2048M max_connect_errors = 6000 wait_timeout = 200000 interactive_timeout = 200000 table_open_cache = 256 innodb_write_io_threads = 16 innodb_read_io_threads = 16 innodb_flush_log_at_trx_commit = 2 slow_query_log = 1 long_query_time = 1 lower_case_table_names = 1 skip-name-resolve

1.1.3 基于GTID复制

mysql> grant replication slave on *.* to rep@'10.0.0.%' identified by '123456';

mysql> show global variables like '%gtid%';

+---------------------------------+-------+

| Variable_name | Value |

+---------------------------------+-------+

| binlog_gtid_simple_recovery | OFF |

| enforce_gtid_consistency | ON | #执行GTID一致

| gtid_executed | |

| gtid_mode | ON | #开启GTID模块

| gtid_owned | |

| gtid_purged | |

| simplified_binlog_gtid_recovery | OFF |

+---------------------------------+-------+

mysql> change master to master_host='10.0.0.51',master_user='rep',master_password='123456',master_auto_position=1;

mysql> start slave;

mysql> show slave statusG

*************************** 1. row ***************************

Slave_IO_State: Waiting for master to send event

Master_Host: 10.0.0.51

Master_User: rep

Master_Port: 3306

Connect_Retry: 60

Master_Log_File: mysql-bin.000002

Read_Master_Log_Pos: 151

Relay_Log_File: db03-relay-bin.000002

Relay_Log_Pos: 361

Relay_Master_Log_File: mysql-bin.000002

Slave_IO_Running: Yes

Slave_SQL_Running: Yes

2.1 搭建MHA高可用

[root@db01 ~]# yum install perl-DBD-MySQL -y #所有节点都安装这条命令 [root@db01 src]# ll total 306824 -rw-r--r-- 1 root root 36326 Dec 18 14:00 mha4mysql-node-0.56-0.el6.noarch.rpm #每个节点安装node这个rpm包 [root@db01 src]# rpm -ivh mha4mysql-node-0.56-0.el6.noarch.rpm Preparing... ################################# [100%] Updating / installing... 1:mha4mysql-node-0.56-0.el6 ################################# [100%] mysql> grant all privileges on *.* to mha@'10.0.0.%' identified by 'mha'; #mha节点 [root@mha_atlas src]# yum install -y perl-Config-Tiny epel-release perl-Log-Dispatch perl-Parallel-ForkManager perl-Time-HiRes [root@mha_atlas src]# rpm -ivh mha4mysql-manager-0.56-0.el6.noarch.rpm

2.1.1 配置MHA

- 事前需要每台机器互信

- 主从复制搭建好

[root@mha_atlas ~]# mkdir -p /etc/mha [root@mha_atlas ~]# mkdir -p /var/log/mha/app1 [root@mha_atlas ~]# cat /etc/mha/app1.cnf [server default] manager_log=/var/log/mha/app1/manager manager_workdir=/var/log/mha/app1 master_binlog_dir=/usr/local/mysql/data password=mha ping_interval=2 repl_password=123456 repl_user=rep ssh_user=root user=mha [server1] hostname=10.0.0.51 port=3306 [server2] candidate_master=1 //设置为候选master,如果设置该参数以后,发生主从切换以后将会将此从库提升为主库,即使这个主库不是集群中事件最新的slave check_repl_delay=0 //默认情况下如果一个slave落后master 100M的relay logs的话,MHA将不会选择该slave作为一个新的master,因为对于这个slave的恢复需要花费很长时间,通过设置check_repl_delay=0,MHA触发切换在选择一个新的master的时候将会忽略复制延时,这个参数对于设置了candidate_master=1的主机非常有用,因为这个候选主在切换的过程中一定是新的master hostname=10.0.0.52 port=3306 [server3] hostname=10.0.0.53 port=3306 #检查ssh [root@mha_atlas ~]# masterha_check_ssh --conf=/etc/mha/app1.cnf #检查主从复制 [root@mha_atlas ~]# masterha_check_ssh --conf=/etc/mha/app1.cnf #后台启动MHA [root@mha_atlas ~]# nohup masterha_manager --conf=/etc/mha/app1.cnf --remove_dead_master_conf --ignore_last_failover < /dev/null > /var/log/mha/app1/manager.log 2>&1 &

2.1.2 禁止自动删除relay_log

(设置relay log的清除方式(在每个slave节点上):

在slave master03 192.168.2.129操作:

[rootdb01 ~]$ mysql -uroot -p123456 -e "set global relay_log_purge=0"

在slave master04 192.168.2.130操作:

[rootdb02 ~]$ mysql -uroot -p123456 -e "set global relay_log_purge=0"

注意:

MHA在发生切换的过程中,从库的恢复过程中依赖于relay log的相关信息,所以这里要将relay log的自动清除设置为OFF,采用手动清除relay log的方式。在默认情况下,从服务器上的中继日志会在SQL线程执行完毕后被自动删除。但是在MHA环境中,这些中继日志在恢复其他从服务器时可能会被用到,因此需要禁用中继日志的自动删除功能。定期清除中继日志需要考虑到复制延时的问题。在ext3的文件系统下,删除大的文件需要一定的时间,会导致严重的复制延时。为了避免复制延时,需要暂时为中继日志创建硬链接,因为在linux系统中通过硬链接删除大文件速度会很快。(在mysql数据库中,删除大表时,通常也采用建立硬链接的方式),mysql 在执行同步的时候 , 只要执行完一个sql线程 ,就会自动删除一次relaylog

可以手动删除purge_relay_logs

3.1 搭建atlas读写分离

[root@mha_atlas src]# rpm -ivh Atlas-2.2.1.el6.x86_64.rpm [root@mha_atlas src]# cd /usr/local/mysql-proxy/ [root@mha_atlas mysql-proxy]# ll total 4 drwxr-xr-x 2 root root 71 Jan 27 08:13 bin drwxr-xr-x 2 root root 21 Jan 27 08:13 conf drwxr-xr-x 3 root root 4096 Jan 27 08:13 lib drwxr-xr-x 2 root root 6 Dec 17 2014 log [root@mha_atlas conf]# cat test.cnf [mysql-proxy] #带#号的为非必需的配置项目 #管理接口的用户名 admin-username = user #管理接口的密码 admin-password = pwd #Atlas后端连接的MySQL主库的IP和端口,可设置多项,用逗号分隔 proxy-backend-addresses = 10.0.0.52:3306 #Atlas后端连接的MySQL从库的IP和端口,@后面的数字代表权重,用来作负载均衡,若省略则默认为1,可设置多项,用逗号分隔 proxy-read-only-backend-addresses = 10.0.0.51:3306@1,10.0.0.53:3306@1 #用户名与其对应的加密过的MySQL密码,密码使用PREFIX/bin目录下的加密程序encrypt加密,下行的user1和user2为示例,将其替换为你的MySQL的用户名和加密密码! pwds = root:/iZxz+0GRoA= #设置Atlas的运行方式,设为true时为守护进程方式,设为false时为前台方式,一般开发调试时设为false,线上运行时设为true,true后面不能有空格。 daemon = true #设置Atlas的运行方式,设为true时Atlas会启动两个进程,一个为monitor,一个为worker,monitor在worker意外退出后会自动将其重启,设为false时只有worker,没有monitor,一般开发调试时设为false,线上运行时设为true,true后面不能有空格。 keepalive = true #工作线程数,对Atlas的性能有很大影响,可根据情况适当设置 event-threads = 8 #日志级别,分为message、warning、critical、error、debug五个级别 log-level = message #日志存放的路径 log-path = /usr/local/mysql-proxy/log #SQL日志的开关,可设置为OFF、ON、REALTIME,OFF代表不记录SQL日志,ON代表记录SQL日志,REALTIME代表记录SQL日志且实时写入磁盘,默认为OFF sql-log = ON #慢日志输出设置。当设置了该参数时,则日志只输出执行时间超过sql-log-slow(单位:ms)的日志记录。不设置该参数则输出全部日志。 #sql-log-slow = 10 #实例名称,用于同一台机器上多个Atlas实例间的区分 #instance = test #Atlas监听的工作接口IP和端口 proxy-address = 0.0.0.0:3306 #Atlas监听的管理接口IP和端口 admin-address = 0.0.0.0:2345 #分表设置,此例中person为库名,mt为表名,id为分表字段,3为子表数量,可设置多项,以逗号分隔,若不分表则不需要设置该项 #tables = person.mt.id.3 #默认字符集,设置该项后客户端不再需要执行SET NAMES语句 charset = utf8 #允许连接Atlas的客户端的IP,可以是精确IP,也可以是IP段,以逗号分隔,若不设置该项则允许所有IP连接,否则只允许列表中的IP连接 #client-ips = 127.0.0.1, 192.168.1 #Atlas前面挂接的LVS的物理网卡的IP(注意不是虚IP),若有LVS且设置了client-ips则此项必须设置,否则可以不设置 #lvs-ips = 192.168.1.1 #启动Atlas [root@mha_atlas conf]# /usr/local/mysql-proxy/bin/mysql-proxyd test start

3.1.1 进入Atlas管理

[root@db01 ~]# mysql -uuser -ppwd -h 10.0.0.55 -P2345 mysql> SELECT * FROM backends; +-------------+----------------+-------+------+ | backend_ndx | address | state | type | +-------------+----------------+-------+------+ | 1 | 10.0.0.52:3306 | up | rw | | 2 | 10.0.0.51:3306 | up | ro | | 3 | 10.0.0.53:3306 | up | ro | +-------------+----------------+-------+------+ #平滑摘除mysql mysql> REMOVE BACKEND 2; #检查是否摘除成功 mysql> SELECT * FROM backends; #保存到配置文件中 mysql> SAVE CONFIG;