支持向量机(Support Vector Machines)

优化目标

到目前为止,你已经见过一系列不同的学习算法。在监督学习中,许多学习算法的性能都非常类似,因此,重要的不是你该选择使用学习算法A还是学习算法B,而更重要的是,应用这些算法时,所创建的大量数据在应用这些算法时,表现情况通常依赖于你的水平。比如:你为学习算法所设计的特征量的选择,以及如何选择正则化参数,诸如此类的事。还有一个更加强大的算法广泛的应用于工业界和学术界,它被称为支持向量机(Support Vector Machine)。与逻辑回归和神经网络相比,支持向量机,或者简称SVM,在学习复杂的非线性方程时提供了一种更为清晰,更加强大的方式。因此,在接下来的视频中,我会探讨这一算法。在稍后的课程中,我也会对监督学习算法进行简要的总结。当然,仅仅是作简要描述。但对于支持向量机,鉴于该算法的强大和受欢迎度,在本课中,我会花许多时间来讲解它。它也是我们所介绍的最后一个监督学习算法。

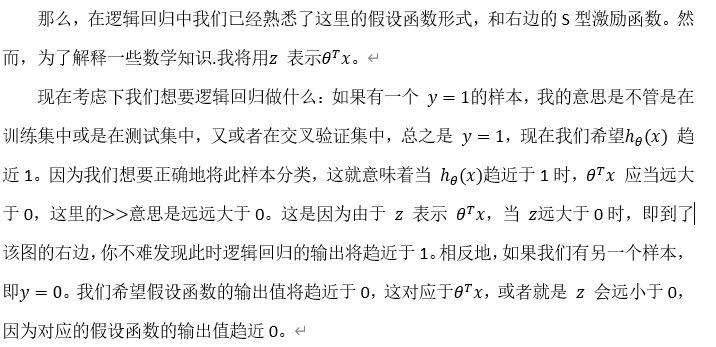

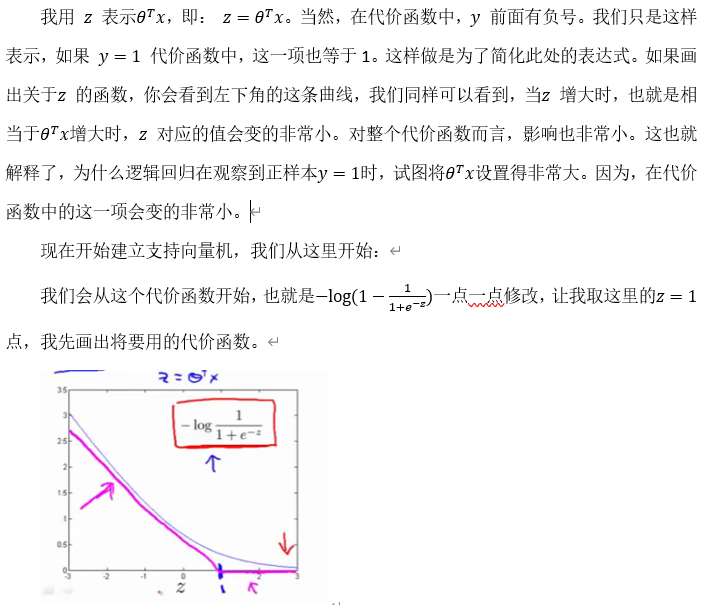

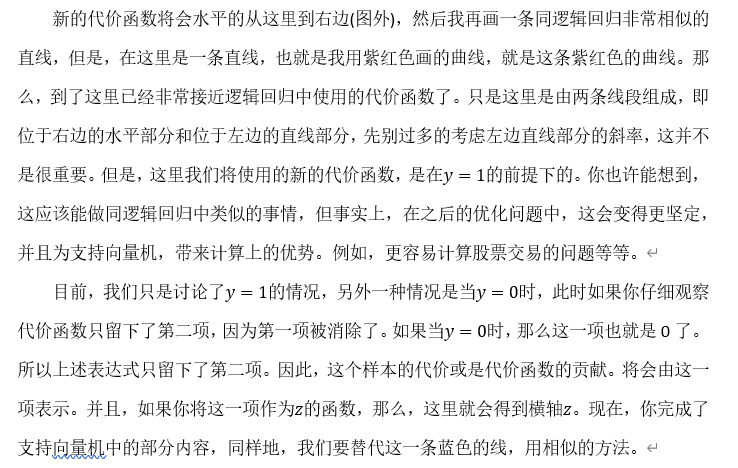

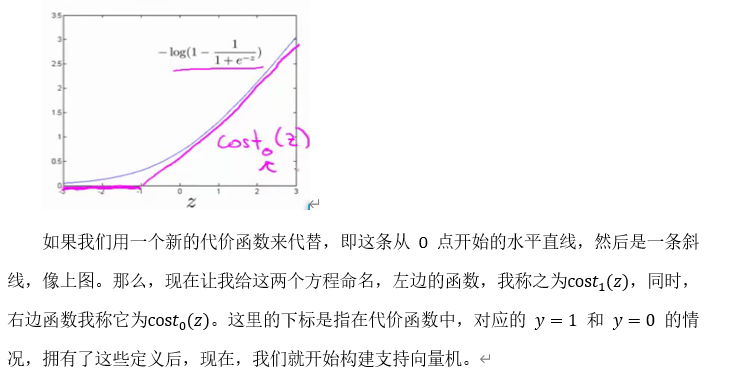

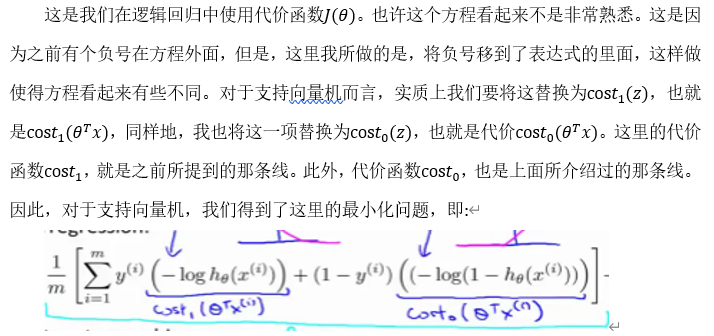

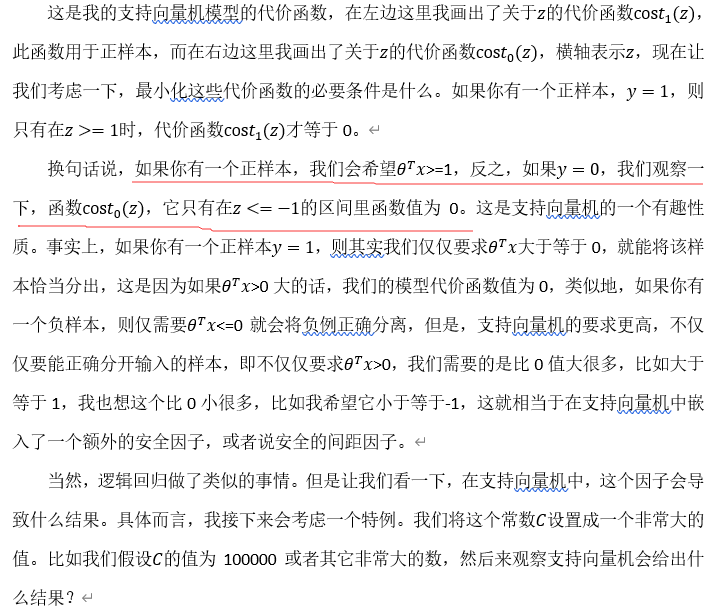

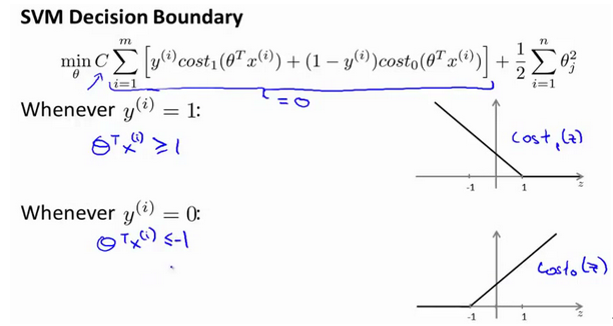

正如我们之前开发的学习算法,我们从优化目标开始。那么,我们开始学习这个算法。为了描述支持向量机,事实上,我将会从逻辑回归开始展示我们如何一点一点修改来得到本质上的支持向量机。

如果你进一步观察逻辑回归的代价函数,你会发现每个样本(x,y) 都会为总代价函数,增加这里的一项,因此,对于总代价函数通常会有对所有的训练样本求和,并且这里还有一个1/m项,但是,在逻辑回归中,这里的这一项就是表示一个训练样本所对应的表达式。现在,如果我将完整定义的假设函数代入这里。那么,我们就会得到每一个训练样本都影响这一项。

现在,先忽略 1/m这一项,但是这一项是影响整个总代价函数中的这一项的。

现在,一起来考虑两种情况:

一种是y等于1的情况;另一种是 y等于0的情况。

在第一种情况中,假设 y=1,此时在目标函数中只需有第一项起作用,因为 y=1时,(1-y) 项将等于0。因此,当在(x,y) 的样本中时,即在(x,y) 中 ,我们得到![]() 这样一项,这里同上一张幻灯片一致。

这样一项,这里同上一张幻灯片一致。

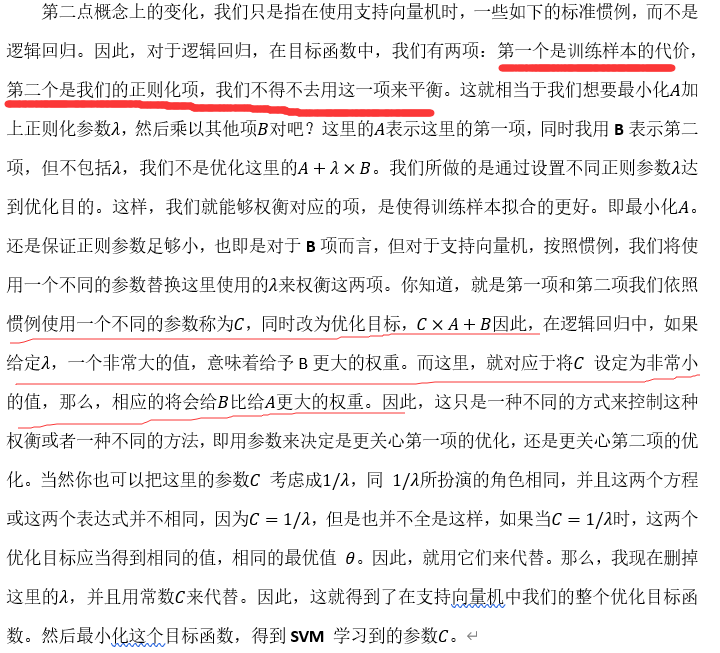

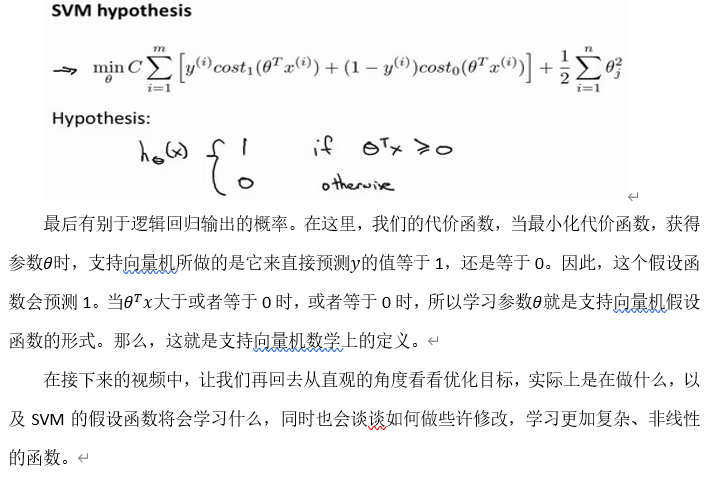

然后,再加上正则化参数。现在,按照支持向量机的惯例,事实上,我们的书写会稍微有些不同,代价函数的参数表示也会稍微有些不同。

首先,我们要除去1/m这一项,当然,这仅仅是由于人们使用支持向量机时,对比于逻辑回归而言,不同的习惯所致,但这里我所说的意思是:你知道,我将要做的是仅仅除去 这一项,但是,这也会得出同样的 theta最优值,好的,因为1/m 仅是个常量,因此,你知道在这个最小化问题中,无论前面是否有 1/m 这一项,最终我所得到的最优值theta都是一样的。这里我的意思是,先给你举一个实例,假定有一最小化问题:即要求![]() 取得最小值时的μ值,这时最小值为:当μ=5 时取得最小值。

取得最小值时的μ值,这时最小值为:当μ=5 时取得最小值。

现在,如果我们想要将这个目标函数乘上常数10,这里我的最小化问题就变成了:求使得![]() 最小的值μ ,然而,使得这里最小的 μ值仍为5。因此将一些常数乘以你的最小化项,这并不会改变最小化该方程时得到μ值。因此,这里我所做的是删去常量 。也相同的,我将目标函数乘上一个常量m,并不会改变取得最小值时的θ值。

最小的值μ ,然而,使得这里最小的 μ值仍为5。因此将一些常数乘以你的最小化项,这并不会改变最小化该方程时得到μ值。因此,这里我所做的是删去常量 。也相同的,我将目标函数乘上一个常量m,并不会改变取得最小值时的θ值。

大边界的直观理解

人们有时将支持向量机看作是大间距分类器。在这一部分,我将介绍其中的含义,这有助于我们直观理解SVM模型的假设是什么样的。

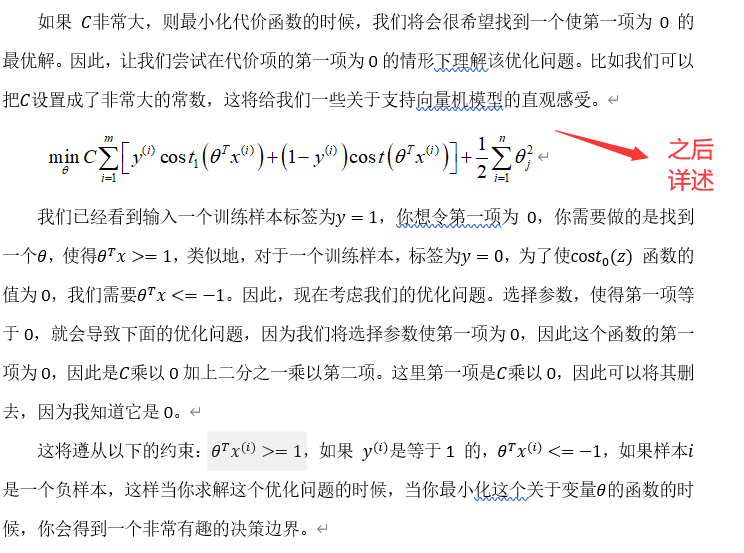

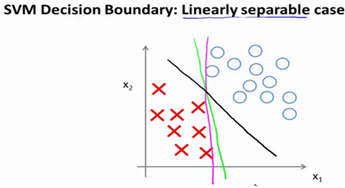

具体而言,如果你考察这样一个数据集,其中有正样本,也有负样本,可以看到这个数据集是线性可分的。我的意思是,存在一条直线把正负样本分开。当然有多条不同的直线,可以把正样本和负样本完全分开。

比如,这就是一个决策边界可以把正样本和负样本分开。但是多多少少这个看起来并不是非常自然是么?

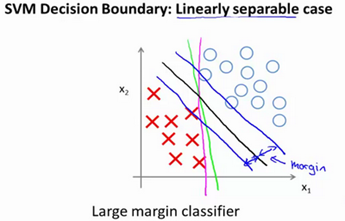

或者我们可以画一条更差的决策界,这是另一条决策边界,可以将正样本和负样本分开,但仅仅是勉强分开,这些决策边界看起来都不是特别好的选择,支持向量机将会选择这个黑色的决策边界,相较于之前我用粉色或者绿色画的决策界。这条黑色的看起来好得多,黑线看起来是更稳健的决策界。在分离正样本和负样本上它显得的更好。数学上来讲,这是什么意思呢?这条黑线有更大的距离,这个距离叫做间距(margin)。

画出这两条额外的蓝线,我们看到黑色的决策界和训练样本之间有更大的最短距离。然而粉线和蓝线离训练样本就非常近,在分离样本的时候就会比黑线表现差。因此,这个距离叫做支持向量机的间距,而这是支持向量机具有鲁棒性的原因,因为它努力用一个最大间距来分离样本。因此支持向量机有时被称为大间距分类器,而这其实是求解上一页幻灯片上优化问题的结果。

我知道你也许想知道求解上一页幻灯片中的优化问题为什么会产生这个结果?它是如何产生这个大间距分类器的呢?我知道我还没有解释这一点。

我将会从直观上略述为什么这个优化问题会产生大间距分类器。总之这个图示有助于你理解支持向量机模型的做法,即努力将正样本和负样本用最大的间距分开。

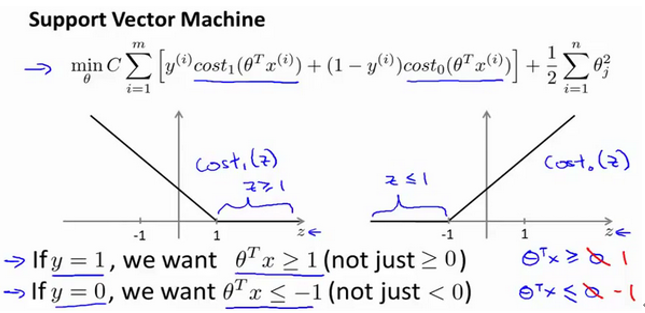

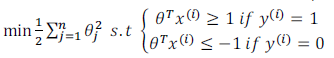

在本节课中关于大间距分类器,我想讲最后一点:我们将这个大间距分类器中的正则化因子常数 设置的非常大,我记得我将其设置为了100000,因此对这样的一个数据集,也许我们将选择这样的决策界,从而最大间距地分离开正样本和负样本。那么在让代价函数最小化的过程中,我们希望找出在 和 两种情况下都使得代价函数中左边的这一项尽量为零的参数。如果我们找到了这样的参数,则我们的最小化问题便转变成:

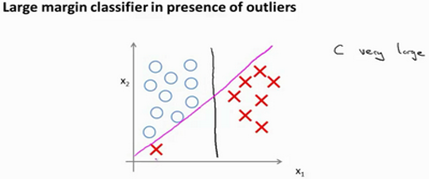

事实上,支持向量机现在要比这个大间距分类器所体现得更成熟,尤其是当你使用大间距分类器的时候,你的学习算法会受异常点(outlier) 的影响。比如我们加入一个额外的正样本。

我们稍后会介绍支持向量机的偏差和方差,希望在那时候关于如何处理参数的这种平衡会变得更加清晰。我希望,这节课给出了一些关于为什么支持向量机被看做大间距分类器的直观理解。它用最大间距将样本区分开,尽管从技术上讲,这只有当参数C是非常大的时候是真的,但是它对于理解支持向量机是有益的。

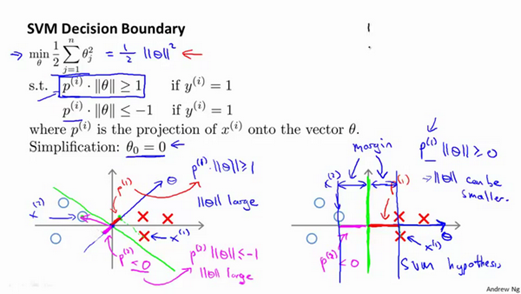

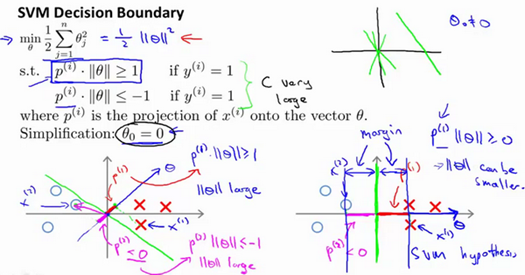

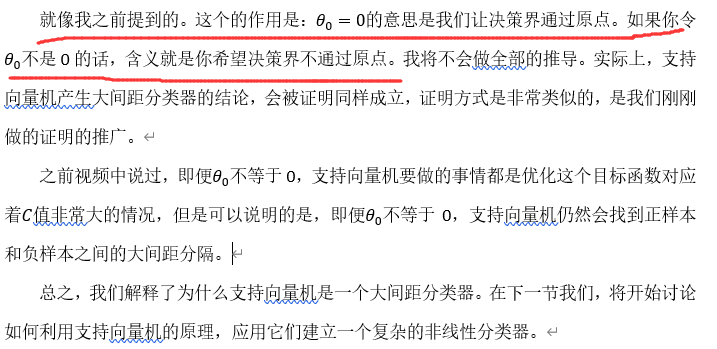

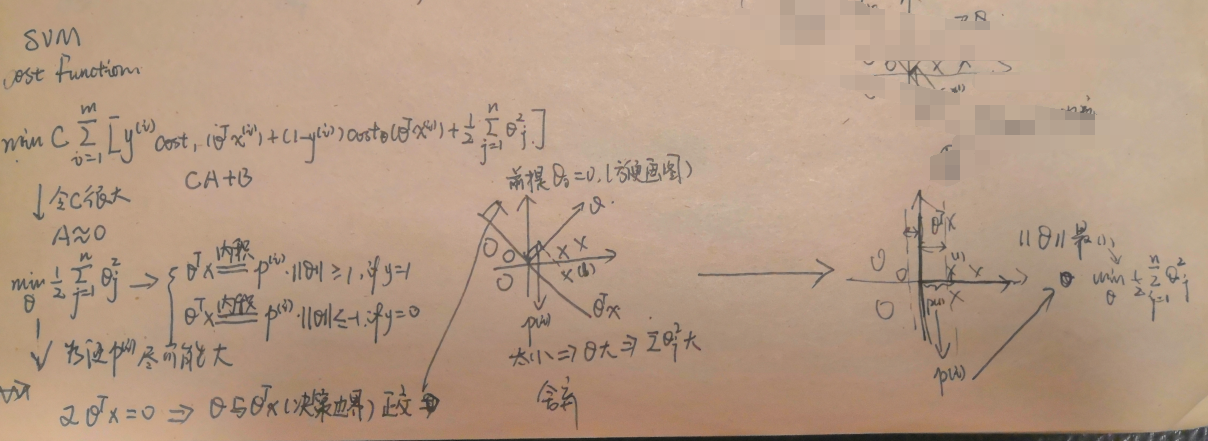

大边界分类背后的数学(重点)

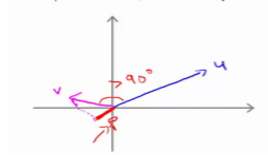

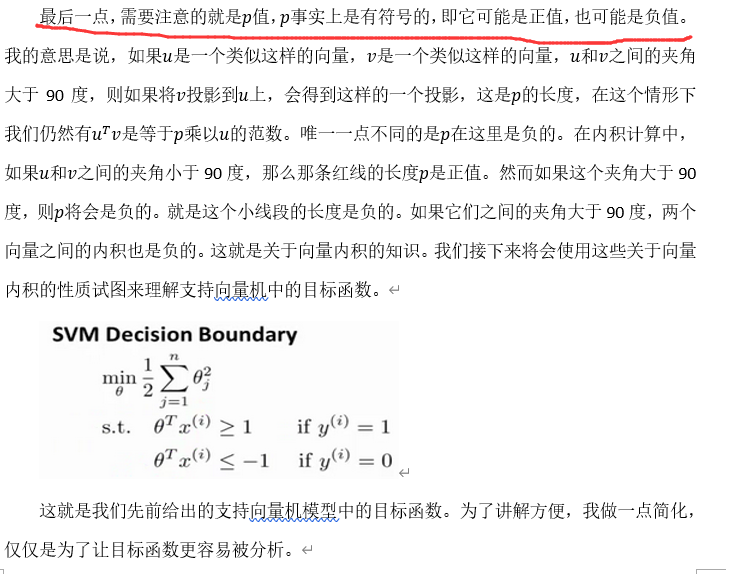

在本节课中,我将介绍一些大间隔分类背后的数学原理。本节为选学部分,你完全可以跳过它,但是听听这节课可能让你对支持向量机中的优化问题,以及如何得到大间距分类器,产生更好的直观理解

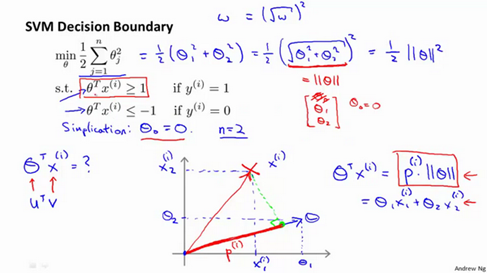

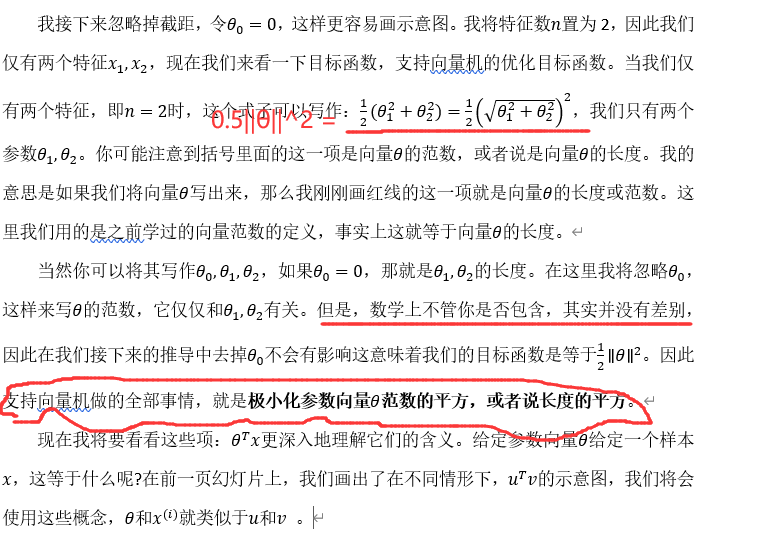

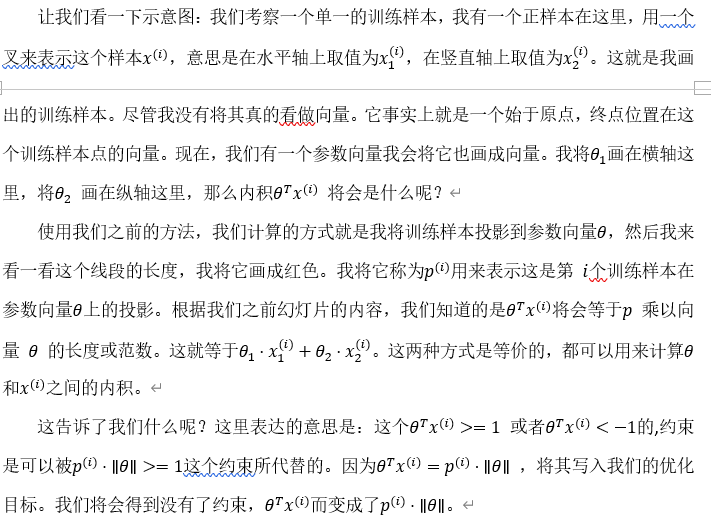

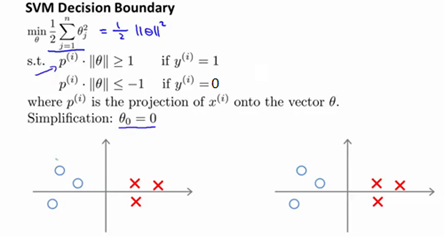

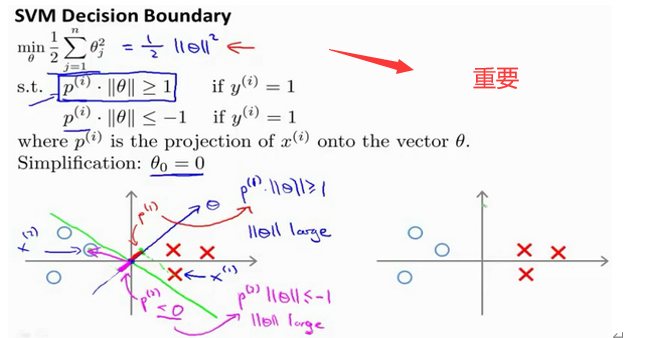

小结一下

为什么得到一个大间距分类器的。

[]有错误