接口与抽象类的区别

单继承多实现

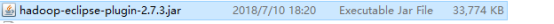

Eclipse里面添加hadoop查看插件

把以下这个放在eclipse的

里面

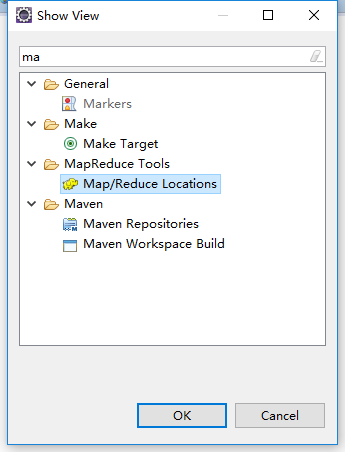

然后在windows里面的shouviews里面找出这个

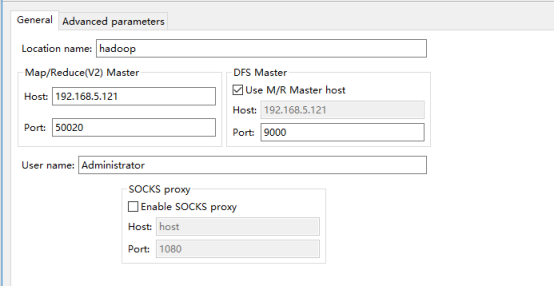

之后进行连接设置

这样设置即可使用

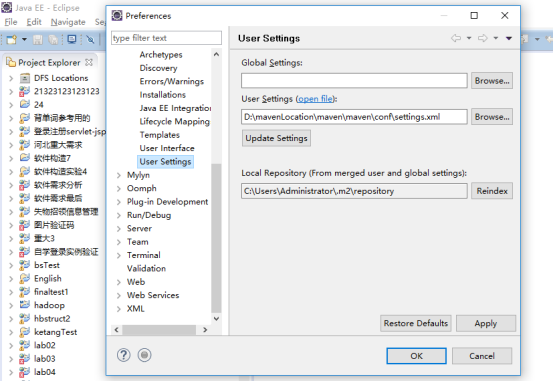

Maven的设置

解压maven放在一个纯英文的位置

Windows-》user settings 然后第二栏选择你放的位置

Apply 然后OK

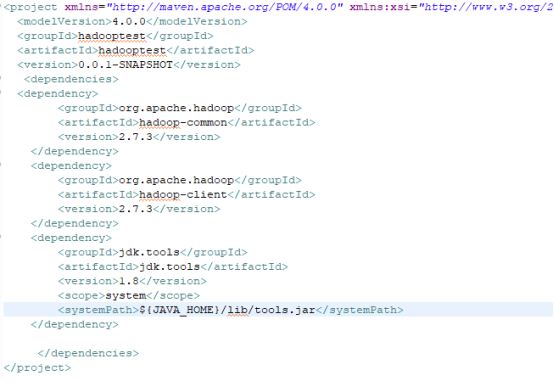

打开pom.xml

如下配置,导入jar包

成功!

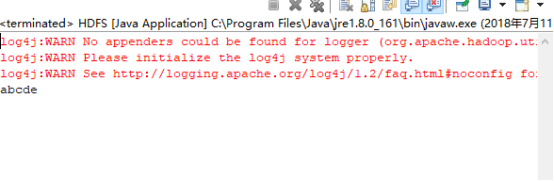

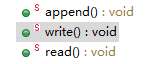

实现对hadoop上面文件查看,覆盖,增加

代码如下

package hadooptest;

import java.io.BufferedReader;

import java.io.IOException;

import java.io.InputStreamReader;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FSDataInputStream;

import org.apache.hadoop.fs.FSDataOutputStream;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

public class HDFS {

public static void main(String[] args) {

read();

}

public static void append(){

Configuration conf=new Configuration();

conf.set("fs.defaultFS", "hdfs://192.168.5.121:9000");

try {

FileSystem fs=FileSystem.get(conf);

FSDataOutputStream outpustream = fs.append(new Path("/hadoop/abc.txt"));

outpustream.writeBytes("abcdefg");

outpustream.close();

} catch (IOException e) {

// TODO Auto-generated catch block

e.printStackTrace();

}

}

public static void write(){

Configuration conf=new Configuration();

conf.set("fs.defaultFS", "hdfs://192.168.5.121:9000");

try {

FileSystem fs=FileSystem.get(conf);

FSDataOutputStream outputStream = fs.create(new Path("/hadoop/abc.txt"));

outputStream.writeBytes("abcde");

outputStream.close();

} catch (IOException e) {

// TODO Auto-generated catch block

e.printStackTrace();

}

}

public static void read(){

// 创建一个 配置对象

Configuration conf=new Configuration();

// 在配置对象中 设置 namenode

conf.set("fs.defaultFS", "hdfs://192.168.5.121:9000");

try {

// 创建 FileSystem

FileSystem fs=FileSystem.get(conf) ;

// 创建 输入流

FSDataInputStream inputstream = fs.open(new Path("/hadoop/abc.txt"));

// 字节流转字符流

InputStreamReader isr=new InputStreamReader(inputstream);

BufferedReader br=new BufferedReader(isr);

String str=br.readLine();

while(str!=null){

System.out.println(str);

str=br.readLine();

}

br.close();

isr.close();

inputstream.close();

} catch (IOException e) {

// TODO Auto-generated catch block

e.printStackTrace();

}

}

}