0. 说明

使用Hadoop文件系统,只用一个主机

在 Hadoop 本地模式安装 基础上进行操作

相关链接:

1. 设置伪分布式模式

1.1 进入 Hadoop 配置文件夹

cd /soft/hadoop/etc/

1.2 重命名 Hadoop 文件夹为 local (本地模式)

mv hadoop local

1.3 拷贝 local 文件夹为 pseudo

cp -r local pseudo

1.4 创建hadoop符号链接指向pseudo

ln -s pseudo hadoop

2. 修改配置文件

2.1 进入 Hadoop 配置文件夹

cd /soft/hadoop/etc/hadoop

2.2 配置文件 [ core-site.xml ]

<configuration> <!-- value标签需要写本机ip --> <property> <name>fs.defaultFS</name> <value>hdfs://192.168.23.101/</value> </property> </configuration>

2.3 配置文件 [ hdfs-site.xml ]

<configuration> <property> <name>dfs.replication</name> <value>1</value> </property> </configuration>

2.4 配置文件 [ mapred-site.xml ]

cp mapred-site.xml.template mapred-site.xml

<configuration> <property> <name>mapreduce.framework.name</name> <value>yarn</value> </property> </configuration>

2.5 配置文件 [ yarn-site.xml ]

<configuration> <!-- Site specific YARN configuration properties --> <property> <name>yarn.resourcemanager.hostname</name> <value>192.168.23.101</value> </property> <property> <name>yarn.nodemanager.aux-services</name> <value>mapreduce_shuffle</value> </property> </configuration>

2.6 修改 [ hadoop-env.sh ] ,修改第25行

export JAVA_HOME=/soft/jdk

2.7 格式化文件系统

hdfs namenode -format

2.8 启动 Hadoop

start-all.sh //其中要输入多次密码

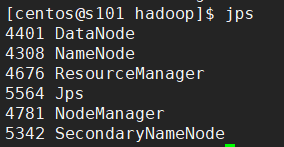

2.9 通过 jps 查看进程

3. 体验 Hadoop 的 HDFS

3.0 关闭 Linux 防火墙

参考 Linux 防火墙配置

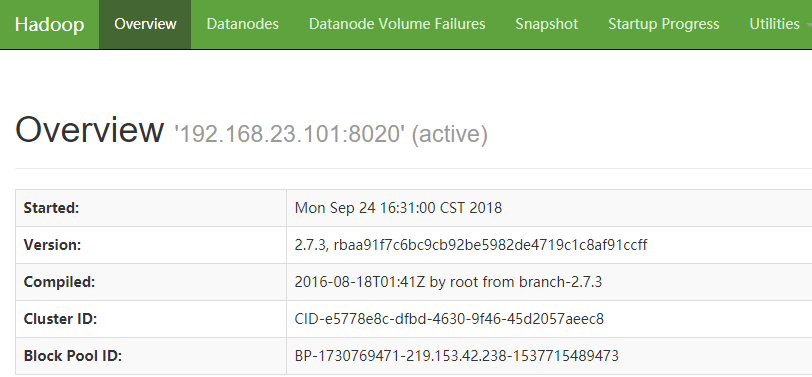

3.1 进入 Hadoop 的 Web 界面

在浏览器地址栏输入 192.168.23.101:50070

3.2 列出 hdfs 的文件系统

在 Linux 命令行中输入

hdfs dfs -ls /

3.3 在 hdfs 中创建文件

在 Linux 命令行中输入

hdfs dfs -touchz /1.txt

3.4 上传文件到 hdfs

hdfs dfs -put jdk-8u161-linux-x64.tar.gz /

3.5 从 hdfs 下载文件

hdfs dfs -get /1.txt

3.6 删除文件

hdfs dfs -rm /jdk-8u161-linux-x64.tar.gz

4. 体验 Mapreduce

4.1 创建文件 hadoop.txt 并添加数据

touch hadoop.txt

echo aa aa b c sweet > hadoop.txt

4.2 将 hadoop.txt 上传到 hdfs

hdfs dfs -put hadoop.txt /

4.3 使用 Hadoop 自带的 demo 进行词频统计

hadoop jar /soft/hadoop/share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.3.jar wordcount /hadoop.txt /out

4.4 通过 Web 界面查看 Hadoop 运行状态

http://192.168.23.101:8088

5. 配置 SSH 远程登陆

参考 SSH 远程登陆

启动 Hadoop

stop-all.sh

停止 Hadoop

stop-all.sh