一、选题与意义

1.Hadoop平台应用

2.Kaggle分析数据项目

简要说明理由与意义

选择题目一淘宝双11数据分析与预测,对于淘宝双11数据的分析与预测也可以更了解人们的购物行为。而且选择hadoop可以巩固知识。

二、实践方案

简要说明理由。

步骤零:实验环境准备

| 所需知识储备 | Windows操作系统、Linux操作系统、大数据处理架构Hadoop的关键技术及其基本原理、列族数据库HBase概念及其原理、数据仓库概念与原理、关系型数据库概念与原理 |

| 训练技能 | 双操作系统安装、虚拟机安装、Linux基本操作、Hadoop安装、HBase安装、Sqoop安装、Eclipse安装 |

| 任务清单 | 1. 安装Linux系统;2. 安装Hadoop;3. 安装MySQL;4. 安装Hive;5. 安装Sqoop;6. 安装Spark;7. 安装Eclipse |

步骤一:本地数据集上传到数据仓库Hive

| 所需知识储备 | Linux系统基本命令、Hadoop项目结构、分布式文件系统HDFS概念及其基本原理、数据仓库概念及其基本原理、数据仓库Hive概念及其基本原理 |

| 训练技能 | Hadoop的安装与基本操作、HDFS的基本操作、Linux的安装与基本操作、数据仓库Hive的安装与基本操作、基本的数据预处理方法 |

| 任务清单 | 1. 安装Linux系统;2. 数据集下载与查看;3. 数据集预处理;4. 把数据集导入分布式文件系统HDFS中;5. 在数据仓库Hive上创建数据库 |

步骤二:Hive数据分析

| 所需知识储备 | 数据仓库Hive概念及其基本原理、SQL语句、数据库查询分析 |

| 训练技能 | 数据仓库Hive基本操作、创建数据库和表、使用SQL语句进行查询分析 |

| 任务清单 | 1. 启动Hadoop和Hive;2. 创建数据库和表;3. 简单查询分析;4. 查询条数统计分析;5. 关键字条件查询分析;6. 根据用户行为分析;7. 用户实时查询分析 |

步骤三:将数据从Hive导入到MySQL

| 所需知识储备 | 数据仓库Hive概念与基本原理、关系数据库概念与基本原理、SQL语句 |

| 训练技能 | 数据仓库Hive的基本操作、关系数据库MySQL的基本操作、Sqoop工具的使用方法 |

| 任务清单 | 1. Hive预操作;2. 使用Sqoop将数据从Hive导入MySQL |

步骤四:利用ECharts进行数据可视化分析

| 所需知识储备 | 数据可视化、Java、JSP、JavaScript、HTML |

| 训练技能 | 利用JSP语言获取MySQL中的数据、搭建一个简单的动态Web应用、ECharts可视化应用 |

| 任务清单 | 1. 搭建tomcat+mysql+JSP开发环境2. 利用Eclipse新建可视化Web应用3. 前后端代码编写, 并添加ECharts可视化分析 |

步骤五:利用Spark预测回头客行为

| 所需知识储备 | Spark、机器学习 |

| 训练技能 | Spark的安装与基本操作、利用Spark 自带的MLlib库,对数据集进行分类预测 |

| 任务清单 | 1. 安装Spark 2.预处理训练集和测试集3.使用支持向量机SVM分类器预测回客行为 |

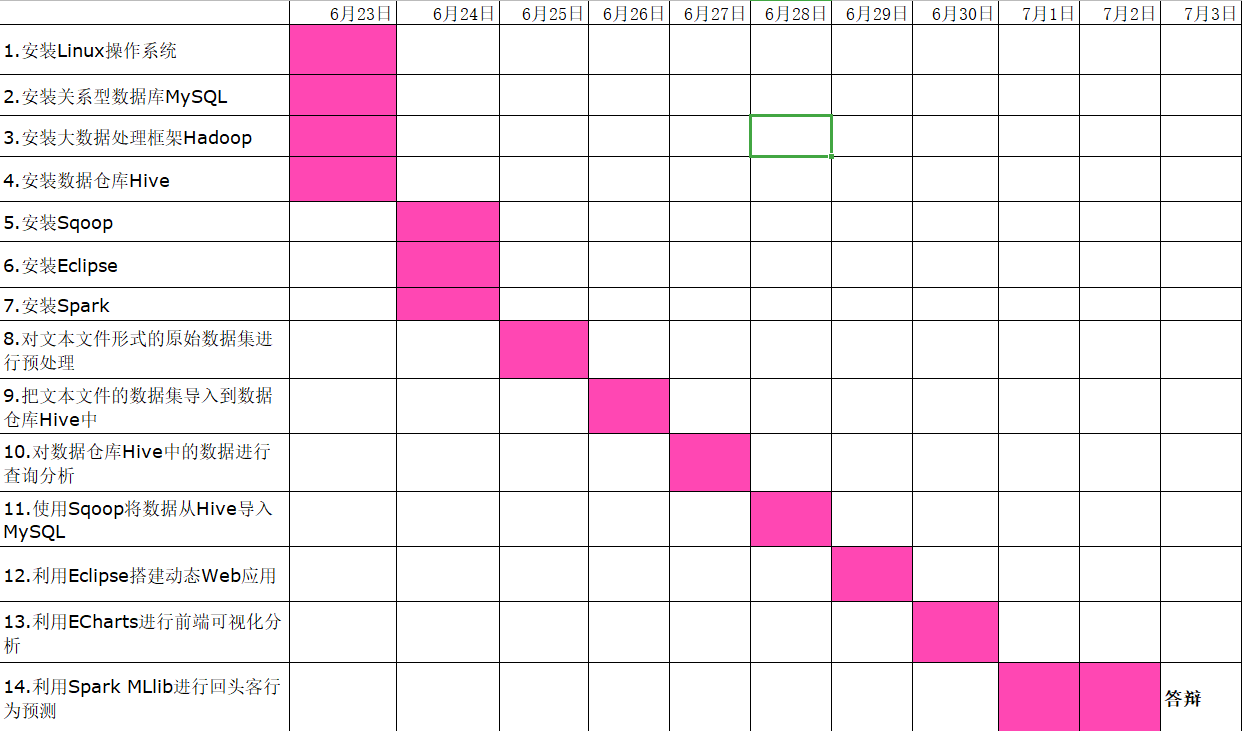

三、实践任务分解

根据所选的题目,明确实验步骤,分解任务到每天。

答:

1.安装Linux操作系统

2.安装关系型数据库MySQL

3.安装大数据处理框架Hadoop

4.安装数据仓库Hive

5.安装Sqoop

6.安装Eclipse

7.安装Spark

8.对文本文件形式的原始数据集进行预处理

9.把文本文件的数据集导入到数据仓库Hive中

10.对数据仓库Hive中的数据进行查询分析

11.使用Sqoop将数据从Hive导入MySQL

12.利用Eclipse搭建动态Web应用

13.利用ECharts进行前端可视化分析

14.利用Spark MLlib进行回头客行为预测

四、实践计划

按任务分解撰写计划表,每天按计划表开展工作。

第天根据实际情况更新计划表,有必要时调整。