一 介绍

'''

定义:

In CPython, the global interpreter lock, or GIL, is a mutex that prevents multiple

native threads from executing Python bytecodes at once. This lock is necessary mainly

because CPython’s memory management is not thread-safe. (However, since the GIL

exists, other features have grown to depend on the guarantees that it enforces.)

'''

结论:在Cpython解释器中,同一个进程下开启的多线程,同一时刻只能有一个线程执行,无法利用多核优势

首先需要明确的一点是GIL并不是Python的特性,它是在实现Python解析器(CPython)时所引入的一个概念。就好比C++是一套语言(语法)标准,但是可以用不同的编译器来编译成可执行代码。有名的编译器例如GCC,INTEL C++,Visual C++等。Python也一样,同样一段代码可以通过CPython,PyPy,Psyco等不同的Python执行环境来执行。像其中的JPython就没有GIL。然而因为CPython是大部分环境下默认的Python执行环境。所以在很多人的概念里CPython就是Python,也就想当然的把GIL归结为Python语言的缺陷。所以这里要先明确一点:GIL并不是Python的特性,Python完全可以不依赖于GIL

二 GIL介绍

GIL本质就是一把互斥锁,既然是互斥锁,所有互斥锁的本质都一样,都是将并发运行变成串行,以此来控制同一时间内共享数据只能被一个任务所修改,进而保证数据安全。

可以肯定的一点是:保护不同的数据的安全,就应该加不同的锁。

要想了解GIL,首先确定一点:每次执行python程序,都会产生一个独立的进程。例如python test.py,python aaa.py,python bbb.py会产生3个不同的python进程

'''

#验证python test.py只会产生一个进程

#test.py内容

import os,time

print(os.getpid())

time.sleep(1000)

'''

python3 test.py

#在windows下

tasklist |findstr python

#在linux下

ps aux |grep python

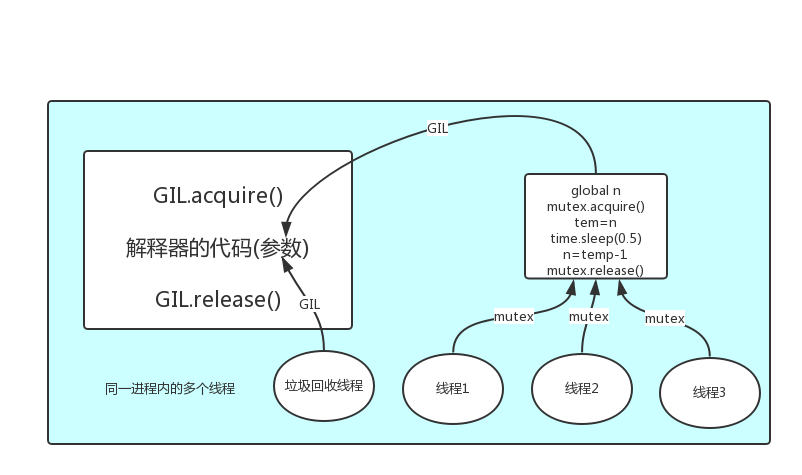

在一个python的进程内,不仅有test.py的主线程或者由该主线程开启的其他线程,还有解释器开启的垃圾回收等解释器级别的线程,总之,所有线程都运行在这一个进程内,毫无疑问

#1 所有数据都是共享的,这其中,代码作为一种数据也是被所有线程共享的(test.py的所有代码以及Cpython解释器的所有代码)

例如:test.py定义一个函数work(代码内容如下图),在进程内所有线程都能访问到work的代码,于是我们可以开启三个线程然后target都指向该代码,能访问到意味着就是可以执行。

#2 所有线程的任务,都需要将任务的代码当做参数传给解释器的代码去执行,即所有的线程要想运行自己的任务,首先需要解决的是能够访问到解释器的代码。

综上:

如果多个线程的target=work,那么执行流程是

多个线程先访问到解释器的代码,即拿到执行权限,然后将target的代码交给解释器的代码去执行

解释器的代码是所有线程共享的,所以垃圾回收线程也可能访问到解释器的代码而去执行,这就导致了一个问题:对于同一个数据100,可能线程1执行x=100的同时,而垃圾回收执行的是回收100的操作,解决这种问题没有什么高明的方法,就是加锁处理,如下图的GIL,保证python解释器同一时间只能执行一个任务的代码

三 GIL与Lock

GIL保护的是解释器级的数据,保护用户自己的数据则需要自己加锁处理,如下图

四 GIL与多线程

有了GIL的存在,同一时刻同一进程中只有一个线程被执行

听到这里,有的同学立马质问:进程可以利用多核,但是开销大,而python的多线程开销小,但却无法利用多核优势,也就是说python没用了,php才是最牛逼的语言?

别着急啊,老娘还没讲完呢。

要解决这个问题,我们需要在几个点上达成一致:

#1. cpu到底是用来做计算的,还是用来做I/O的?

#2. 多cpu,意味着可以有多个核并行完成计算,所以多核提升的是计算性能

#3. 每个cpu一旦遇到I/O阻塞,仍然需要等待,所以多核对I/O操作没什么用处

一个工人相当于cpu,此时计算相当于工人在干活,I/O阻塞相当于为工人干活提供所需原材料的过程,工人干活的过程中如果没有原材料了,则工人干活的过程需要停止,直到等待原材料的到来。

如果你的工厂干的大多数任务都要有准备原材料的过程(I/O密集型),那么你有再多的工人,意义也不大,还不如一个人,在等材料的过程中让工人去干别的活,

反过来讲,如果你的工厂原材料都齐全,那当然是工人越多,效率越高

结论:

对计算来说,cpu越多越好,但是对于I/O来说,再多的cpu也没用

当然对运行一个程序来说,随着cpu的增多执行效率肯定会有所提高(不管提高幅度多大,总会有所提高),这是因为一个程序基本上不会是纯计算或者纯I/O,所以我们只能相对的去看一个程序到底是计算密集型还是I/O密集型,从而进一步分析python的多线程到底有无用武之地

#分析:

我们有四个任务需要处理,处理方式肯定是要玩出并发的效果,解决方案可以是:

方案一:开启四个进程

方案二:一个进程下,开启四个线程

#单核情况下,分析结果:

如果四个任务是计算密集型,没有多核来并行计算,方案一徒增了创建进程的开销,方案二胜

如果四个任务是I/O密集型,方案一创建进程的开销大,且进程的切换速度远不如线程,方案二胜

#多核情况下,分析结果:

如果四个任务是计算密集型,多核意味着并行计算,在python中一个进程中同一时刻只有一个线程执行用不上多核,方案一胜

如果四个任务是I/O密集型,再多的核也解决不了I/O问题,方案二胜

#结论:现在的计算机基本上都是多核,python对于计算密集型的任务开多线程的效率并不能带来多大性能上的提升,甚至不如串行(没有大量切换),但是,对于IO密集型的任务效率还是有显著提升的。

五 多线程性能测试

计算密集型:多进程效率高

from multiprocessing import Process

from threading import Thread

import os,time

def work():

res=0

for i in range(100000000):

res*=i

if __name__ == '__main__':

l=[]

print(os.cpu_count()) #本机为4核

start=time.time()

for i in range(4):

p=Process(target=work) #耗时5s多

p=Thread(target=work) #耗时18s多

l.append(p)

p.start()

for p in l:

p.join()

stop=time.time()

print('run time is %s' %(stop-start))

I/O密集型:多线程效率高

from multiprocessing import Process

from threading import Thread

import threading

import os,time

def work():

time.sleep(2)

print('===>')

if __name__ == '__main__':

l=[]

print(os.cpu_count()) #本机为4核

start=time.time()

for i in range(400):

# p=Process(target=work) #耗时12s多,大部分时间耗费在创建进程上

p=Thread(target=work) #耗时2s多

l.append(p)

p.start()

for p in l:

p.join()

stop=time.time()

print('run time is %s' %(stop-start))

应用:

多线程用于IO密集型,如socket,爬虫,web

多进程用于计算密集型,如金融分析

### GIL全局解释器锁

```python

"""

In CPython, the global interpreter lock, or GIL, is a mutex that prevents multiple

native threads from executing Python bytecodes at once. This lock is necessary mainly

because CPython’s memory management is not thread-safe. (However, since the GIL

exists, other features have grown to depend on the guarantees that it enforces.)

"""

"""

python解释器其实有多个版本

Cpython

Jpython

Pypypython

但是普遍使用的都是CPython解释器

在CPython解释器中GIL是一把互斥锁,用来阻止同一个进程下的多个线程的同时执行

同一个进程下的多个线程无法利用多核优势!!!

疑问:python的多线程是不是一点用都没有???无法利用多核优势

因为cpython中的内存管理不是线程安全的

内存管理(垃圾回收机制)

1.引用计数

2.标记清除

3.分代回收

"""

"""

重点:

1.GIL不是python的特点而是CPython解释器的特点

2.GIL是保证解释器级别的数据的安全

3.GIL会导致同一个进程下的多个线程的无法同时执行即无法利用多核优势(******)

4.针对不同的数据还是需要加不同的锁处理

5.解释型语言的通病:同一个进程下多个线程无法利用多核优势

"""

```

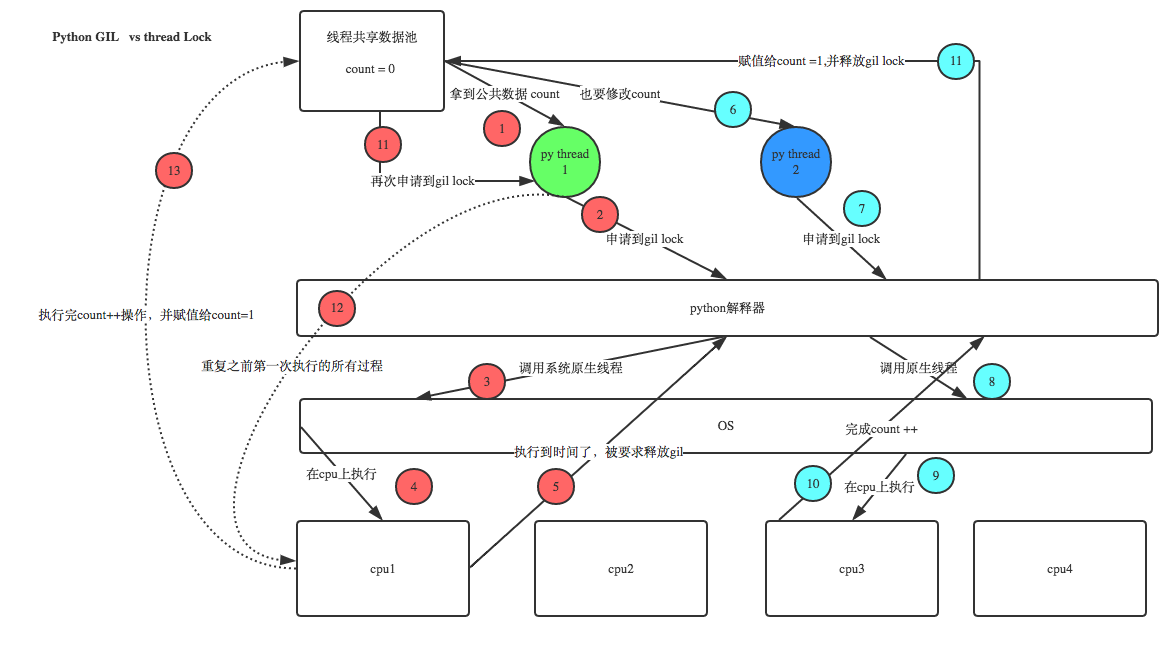

### GIL与普通互斥锁的区别

```python

from threading import Thread,Lock

import time

mutex = Lock()

money = 100

def task():

global money

# with mutex: #第二种写法,用with

# tmp = money

# time.sleep(0.1)

# money = tmp -1

mutex.acquire()

tmp = money

time.sleep(0.1) # 只要你进入IO了 GIL会自动释放

money = tmp - 1

mutex.release()

if __name__ == '__main__':

t_list = []

for i in range(100):

t = Thread(target=task)

t.start()

t_list.append(t)

for t in t_list:

t.join()

print(money)

"""

100个线程起起来之后 要先去抢GIL

我进入io GIL自动释放 但是我手上还有一个自己的互斥锁

其他线程虽然抢到了GIL但是抢不到互斥锁

最终GIL还是回到你的手上 你去操作数据

"""

```

### 同一个进程下的多线程无法利用多核优势,是不是就没有用了

```python

"""

多线程是否有用要看具体情况

单核:四个任务(IO密集型计算密集型)

多核:四个任务(IO密集型计算密集型)

"""

# 计算密集型 每个任务都需要10s

单核(不用考虑了)

多进程:额外的消耗资源

多线程:节省开销

多核

多进程:4个CPU一起算 假设总耗时 10+

多线程:总耗时 耗时40+

# IO密集型

多核

多进程:相对浪费资源,4个CPU都在等待IO

多线程:更加节省资源,节省了创建进程的开销

IO密集型的,都不能利用多核优势,多线程节省资源

```

### 代码验证

```python

# 计算密集型

# from multiprocessing import Process

# from threading import Thread

# import os,time

#

#

# def work():

# res = 0

# for i in range(10000000):

# res *= i

#

# if __name__ == '__main__':

# l = []

# print(os.cpu_count()) # 获取当前计算机CPU个数

# start_time = time.time()

# for i in range(12):

# p = Process(target=work) # 1.4679949283599854

# t = Thread(target=work) # 5.698534250259399

# t.start()

# # p.start()

# # l.append(p)

# l.append(t)

# for p in l:

# p.join()

# print(time.time()-start_time)

# IO密集型

from multiprocessing import Process

from threading import Thread

import os,time

def work():

time.sleep(2)

if __name__ == '__main__':

l = []

print(os.cpu_count()) # 获取当前计算机CPU个数

start_time = time.time()

for i in range(4000):

# p = Process(target=work) # 21.149890184402466

t = Thread(target=work) # 3.007986068725586

t.start()

# p.start()

# l.append(p)

l.append(t)

for p in l:

p.join()

print(time.time()-start_time)

```

### 总结

```python

"""

多进程和多线程都有各自的优势

并且我们后面在写项目的时候通常可以

多进程下面再开设多线程

这样的话既可以利用多核也可以节省资源消耗

"""

```

鸣谢:Jason老师

作者: 小猿取经

出处:https://www.cnblogs.com/xiaoyuanqujing/articles/11715730.html

版权:本文采用「署名-非商业性使用-相同方式共享 4.0 国际」知识共享许可协议进行许可。

js 日期比较大小,js判断日期是否在区间内,js判断时间段是否在另外一个时间段内

tfs 2013 利用 web deploy 完成asp.net站点自动发布

Web Deploy 服务器安装设置与使用

MD5加密解密类(asp.net)&使用MD5过时处理

C# 中Web.config文件的读取与写入

巧用Ajax的beforeSend 提高用户体验

一个通用的分页类

EventSource 对象用于接收服务器发送事件通知,是网页自动获取来自服务器的更新

Java WebSockets