集成学习是一大类模型融合策略和方法的统称,以下以bagging和boosting为例进行说明:

1、boosting

- boosting方法训练分类器采用串行的方式,每个弱分类器之间是相互依赖的,尤其后一个弱分类器是依赖于前一个分类器的分类结果而构建的

- 此方法的基本思想是在每一层训练时,对前一层基分类器分错的样本,基于更高的权重,测试时,根据各层分类器的结果加权得到最终结果,即boosting方法的中心思想是进行迭代学习。

2、bagging

- bagging采用并行的方式进行弱分类器的训练,各个弱分类器之间相互独立,对训练集采用又放回的抽样为每个弱分类器构建训练子集。

- 对于预测样本,采取投票表决的方式进行最后的分类。

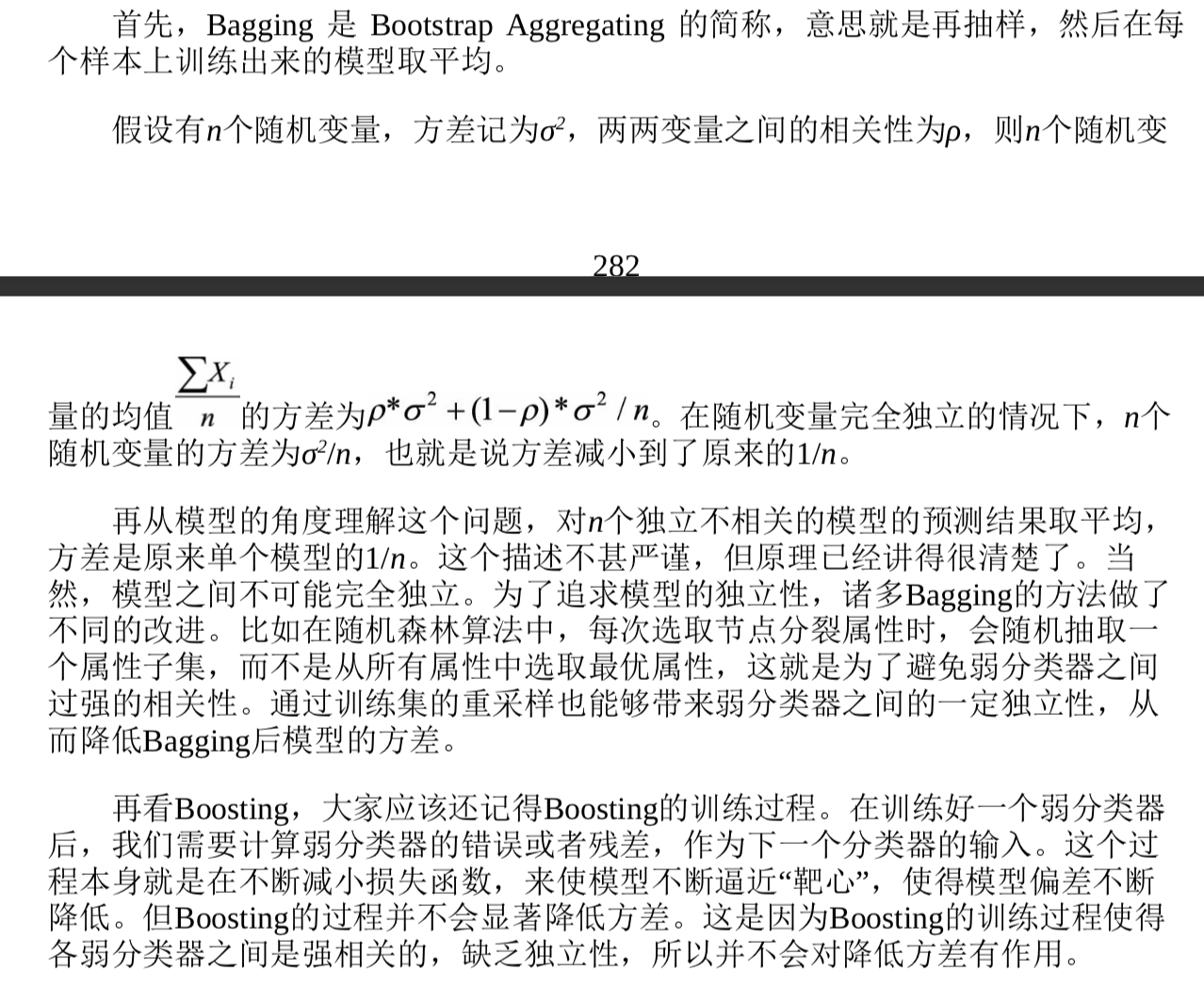

以方差和偏差的角度来看待两个方法,集成学习的误差来源于偏差和方差之和,boosting基于逐步迭代聚焦于错分类的样本,减少集成学习的偏差,而bagging基于多个模型独立训练,利用多数表决以减少方差的方式来对集成模型进行优化。

如何解释bagging的减少方差和boosting的减少方差?