人工智能和机器学习的最新技术 - 带代码的论文的亮点

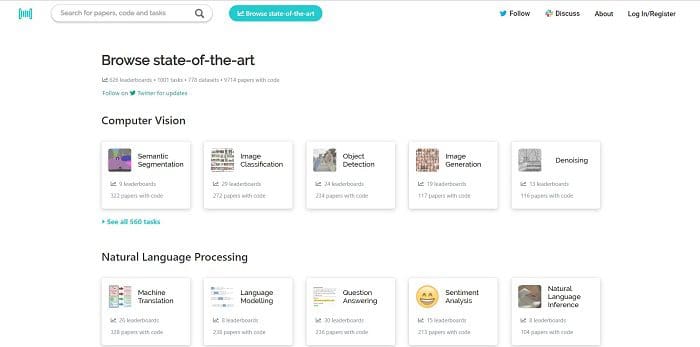

我们介绍包含代码的论文,最先进的机器学习论文,代码和评估表的免费和开放资源。

任何机器学习,AI或计算机科学家爱好者都会知道,找到您感兴趣的主题的资源和论文可能会很麻烦。通常,您需要注册一个网站,有些人甚至会尝试向您收取阅读其他人工作的订阅费。

这就是使网站Papers代码如此出色的原因; 它们提供了大量免费资源,涵盖了大量主题。他们的使命宣言如下:

这就是使网站Papers代码如此出色的原因; 它们提供了大量免费资源,涵盖了大量主题。他们的使命宣言如下:

Papers With Code的使命是利用机器学习论文,代码和评估表创建一个免费和开放的资源。

我们相信这最好与社区一起完成,并由自动化提供支持。

我们已经自动将代码链接到论文,我们现在正致力于从论文中自动提取评估指标。

除此之外,它们还有自己的松弛通道,它们允许用户下载有助于运行网站的所有数据。他们对捐款持开放态度,因此请随意潜入并保持社区的成长!

为了庆祝这个伟大的资源,我们试图总结我们最喜欢的6个主题(网站上称之为“任务”)在网站上以及他们提供的一些论文:

语义分割

语义分割的概念是识别和理解像素级图像中的内容。这是网站内容最大的类别之一,有322篇论文和代码。其中最受欢迎的是题为具有用于语义图像分割的Atrous可分离卷积的编码器 - 解码器。本文旨在结合两种语义分割方法的优点:空间金字塔池模块和编码 - 解码器结构。本文附有TensorFlow中提出的模型的公开参考实现。

关于语义分割的其他顶级论文:

NLP

自然语言处理是网站上最大的任务集合之一,包括机器翻译,语言建模,情感分析,文本分类等等。其中最受欢迎的类别之一是Question Answering,有200多篇关于这个主题的论文。关于这一主题的排名靠前的论文是Jacob Devlin,Ming-Wei Chang,Kenton Lee和Kristina Toutanova,名为BERT:用于语言理解的深度双向变换器的预训练。本文介绍称为BERT一个新的语言表示模型,它代表乙 idirectional é ncoder ř从对产权Ťransformers。与最近的语言表示模型不同,BERT旨在通过联合调节所有层中的左右上下文来预训练深度双向表示。

关于NLP的其他顶级论文:

转学习

转移学习是一种方法,其中从一个任务训练的模型的权重被采用并使用:

- 构造固定特征提取器

- 作为权重初始化和/或微调

关于转移学习的最受欢迎的论文是来自私人培训数据的深度学习的半监督知识转移。本文旨在解决影响使用私有数据的模型的问题,因为模型可能无意中和隐含地存储了一些训练数据,因此随后对模型的仔细分析可能会揭示敏感信息。为了解决这个问题,本文演示了一种为敏感数据提供安全性的普遍适用的方法:教师合奏的私人聚合(PATE)。该方法以黑盒方式组合了使用不相交数据集训练的多个模型,例如来自不同用户子集的记录。本文还包含一个指向GitHub仓库的链接,其中包含TensorFlow中该项目的所有代码。

关于转学习的其他顶级论文:

多任务学习

多任务学习旨在同时学习多个不同的任务,同时最大化一个或所有任务的性能。目前大多数明星的论文是:DRAGNN:基于过渡的动态连接神经网络框架。这项工作提出了一个紧凑的模块化框架,用于构建新颖的递归神经结构。同样,本文还介绍了TensorFlow中的完整工作代码示例。

关于多任务学习的其他顶级论文:

推荐系统

推荐系统的目标是为用户生成推荐列表。此类别中的一篇颇受欢迎的论文是由Oleksii Kuchaiev和Boris Ginsburg 为Collaborative Filtering培训Deep AutoEncoders。本文提出了推荐系统中评级预测任务的新模型,该模型在时间分割的Netflix数据集上明显优于先前的现有技术模型。该模型基于6层深度自动编码器,端到端训练,无需任何分层预训练。这是PyTorch的NVIDIA研究项目,所有代码都可供公众使用。

关于推荐系统的其他顶级论文: