0.介绍(摘录自https://www.hi-linux.com/posts/25047.html)

什么是Prometheus?

Prometheus是由SoundCloud开发的开源监控报警系统和时序列数据库(TSDB)。Prometheus使用Go语言开发,是Google BorgMon监控系统的开源版本。Prometheus性能也足够支撑上万台规模的集群。

Prometheus的特点

- 多维度数据模型。

- 灵活的查询语言。

- 不依赖分布式存储,单个服务器节点是自主的。

- 通过基于HTTP的pull方式采集时序数据。

- 可以通过中间网关进行时序列数据推送。

- 通过服务发现或者静态配置来发现目标服务对象。

- 支持多种多样的图表和界面展示,比如Grafana等。

Prometheus相关组件

Prometheus生态系统由多个组件组成,它们中的一些是可选的。多数Prometheus组件是Go语言写的,这使得这些组件很容易编译和部署。

- Prometheus Server

主要负责数据采集和存储,提供PromQL查询语言的支持。

- 客户端SDK

官方提供的客户端类库有go、java、scala、python、ruby,其他还有很多第三方开发的类库,支持nodejs、php、erlang等。

- Push Gateway

支持临时性Job主动推送指标的中间网关。

- PromDash

使用Rails开发可视化的Dashboard,用于可视化指标数据。

- Exporter

Exporter是Prometheus的一类数据采集组件的总称。它负责从目标处搜集数据,并将其转化为Prometheus支持的格式。与传统的数据采集组件不同的是,它并不向中央服务器发送数据,而是等待中央服务器主动前来抓取。

Prometheus提供多种类型的Exporter用于采集各种不同服务的运行状态。目前支持的有数据库、硬件、消息中间件、存储系统、HTTP服务器、JMX等。

- alertmanager

警告管理器,用来进行报警。

- prometheus_cli

命令行工具。

- 其他辅助性工具

多种导出工具,可以支持Prometheus存储数据转化为HAProxy、StatsD、Graphite等工具所需要的数据存储格式。

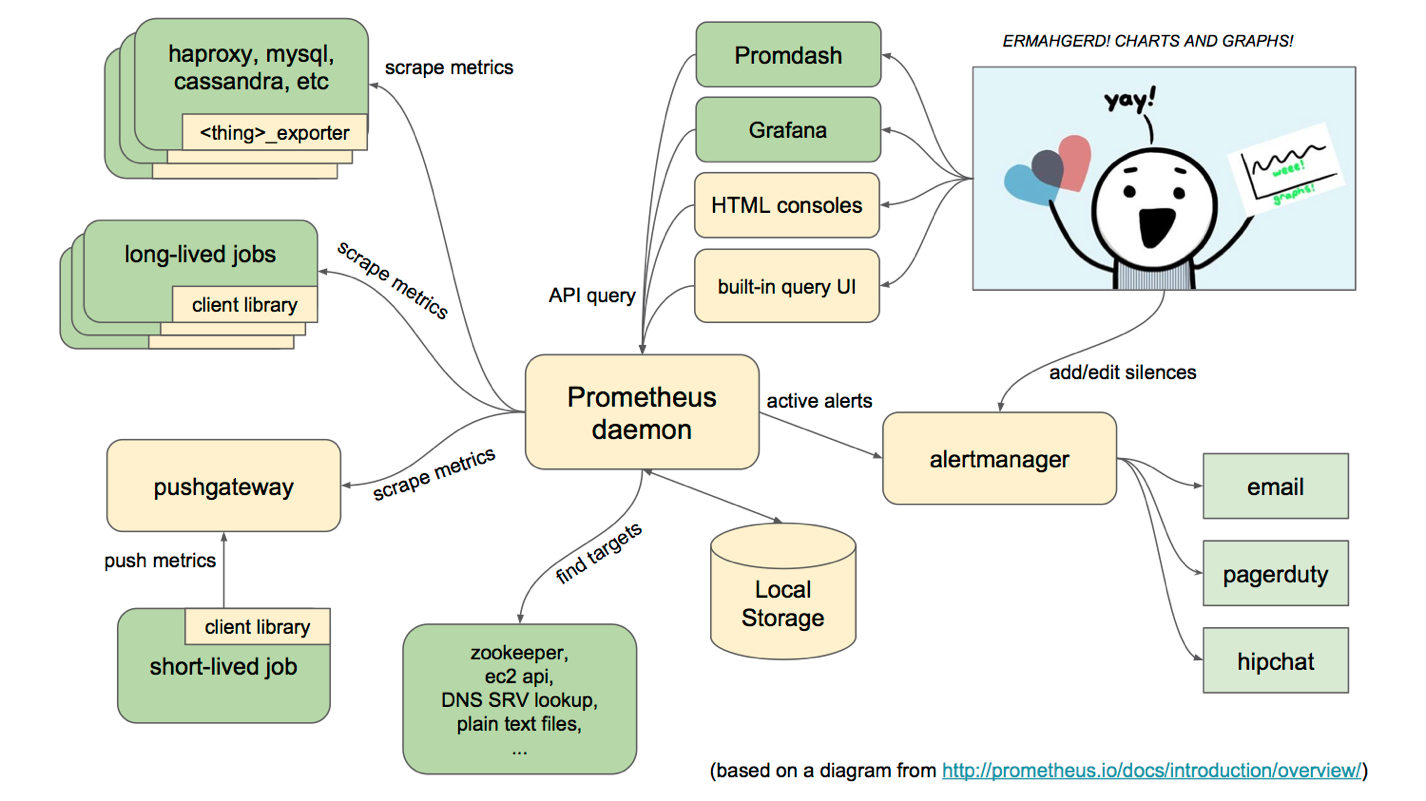

Prometheus的架构

下面这张图说明了Prometheus的整体架构,以及生态中的一些组件作用:

Prometheus的基本原理是通过HTTP协议周期性抓取被监控组件的状态,任意组件只要提供对应的HTTP接口就可以接入监控。不需要任何SDK或者其他的集成过程。这样做非常适合做虚拟化环境监控系统,比如VM、Docker、Kubernetes等。输出被监控组件信息的HTTP接口被叫做exporter 。目前互联网公司常用的组件大部分都有exporter可以直接使用,比如Varnish、Haproxy、Nginx、MySQL、Linux系统信息(包括磁盘、内存、CPU、网络等等)。

Prometheus服务过程大概是这样:

-

Prometheus Daemon负责定时去目标上抓取metrics(指标)数据,每个抓取目标需要暴露一个http服务的接口给它定时抓取。Prometheus支持通过配置文件、文本文件、Zookeeper、Consul、DNS SRV Lookup等方式指定抓取目标。Prometheus采用PULL的方式进行监控,即服务器可以直接通过目标PULL数据或者间接地通过中间网关来Push数据。

-

Prometheus在本地存储抓取的所有数据,并通过一定规则进行清理和整理数据,并把得到的结果存储到新的时间序列中。

-

Prometheus通过PromQL和其他API可视化地展示收集的数据。Prometheus支持很多方式的图表可视化,例如Grafana、自带的Promdash以及自身提供的模版引擎等等。Prometheus还提供HTTP API的查询方式,自定义所需要的输出。

-

PushGateway支持Client主动推送metrics到PushGateway,而Prometheus只是定时去Gateway上抓取数据。

-

Alertmanager是独立于Prometheus的一个组件,可以支持Prometheus的查询语句,提供十分灵活的报警方式。

Prometheus适用的场景

Prometheus在记录纯数字时间序列方面表现非常好。它既适用于面向服务器等硬件指标的监控,也适用于高动态的面向服务架构的监控。对于现在流行的微服务,Prometheus的多维度数据收集和数据筛选查询语言也是非常的强大。Prometheus是为服务的可靠性而设计的,当服务出现故障时,它可以使你快速定位和诊断问题。它的搭建过程对硬件和服务没有很强的依赖关系。

Prometheus不适用的场景

Prometheus它的价值在于可靠性,甚至在很恶劣的环境下,你都可以随时访问它和查看系统服务各种指标的统计信息。 如果你对统计数据需要100%的精确,它并不适用,例如:它不适用于实时计费系统。

1.部署prometheus280、验证安装

解压安装包到指定目录 /usr/local/prom/prometheus280

# ./prometheus --version

prometheus, version 2.7.1 (branch: HEAD, revision: 62e591f928ddf6b3468308b7ac1de1c63aa7fcf3)

build user: root@f9f82868fc43

build date: 20190131-11:16:59

go version: go1.11.5

2.配置监控

# cat prometheus.yml # my global config global: scrape_interval: 15s # Set the scrape interval to every 15 seconds. Default is every 1 minute.

# 默认抓取间隔, 15秒向目标抓取一次数据。 evaluation_interval: 15s # Evaluate rules every 15 seconds. The default is every 1 minute. # scrape_timeout is set to the global default (10s). # Alertmanager configuration alerting: alertmanagers: - static_configs: - targets: # - alertmanager:9093 # Load rules once and periodically evaluate them according to the global 'evaluation_interval'. rule_files: # - "first_rules.yml" # - "second_rules.yml" # A scrape configuration containing exactly one endpoint to scrape: # Here it's Prometheus itself. scrape_configs: # The job name is added as a label `job=<job_name>` to any timeseries scraped from this config.

这个配置是表示在这个配置内的时间序例,每一条都会自动添加上这个{job_name:"prometheus"}的标签。 - job_name: 'prometheus' # metrics_path defaults to '/metrics' # scheme defaults to 'http'. static_configs: - targets: ['localhost:9090']

[小记录,可能也没啥用,只是突然发现可以修改] metrics_path 默认 '/metrics',即http://*:*/metrics,可以修改为其他的,在static_configs前自定义即可,即

metrics_path: '/jmx'

static_configs:

3.配置prometheus为开机自动运行

1)创建用户

单独创建一个专门用于运行prometheus的用户,不用root运行程序是一种好习惯。主目录为/var/lib/prometheus,用作prometheus的数据目录

# groupadd prometheus

# useradd -g prometheus -m -d /var/lib/prometheus -s /sbin/nologin prometheus

# chown -R prometheus:prometheus /usr/local/prom/

# chown -R prometheus:prometheus /var/lib/prometheus

2)创建systemd服务

# cat /etc/systemd/system/prometheus.service

[Unit]

Description=prometheus

After=network.target

[Service]

Type=simple

User=prometheus

ExecStart=/usr/local/prom/prometheus280/prometheus --config.file=/usr/local/prom/prometheus280/prometheus.yml --storage.tsdb.path=/var/lib/prometheus

Restart=on-failure

[Install]

WantedBy=multi-user.target

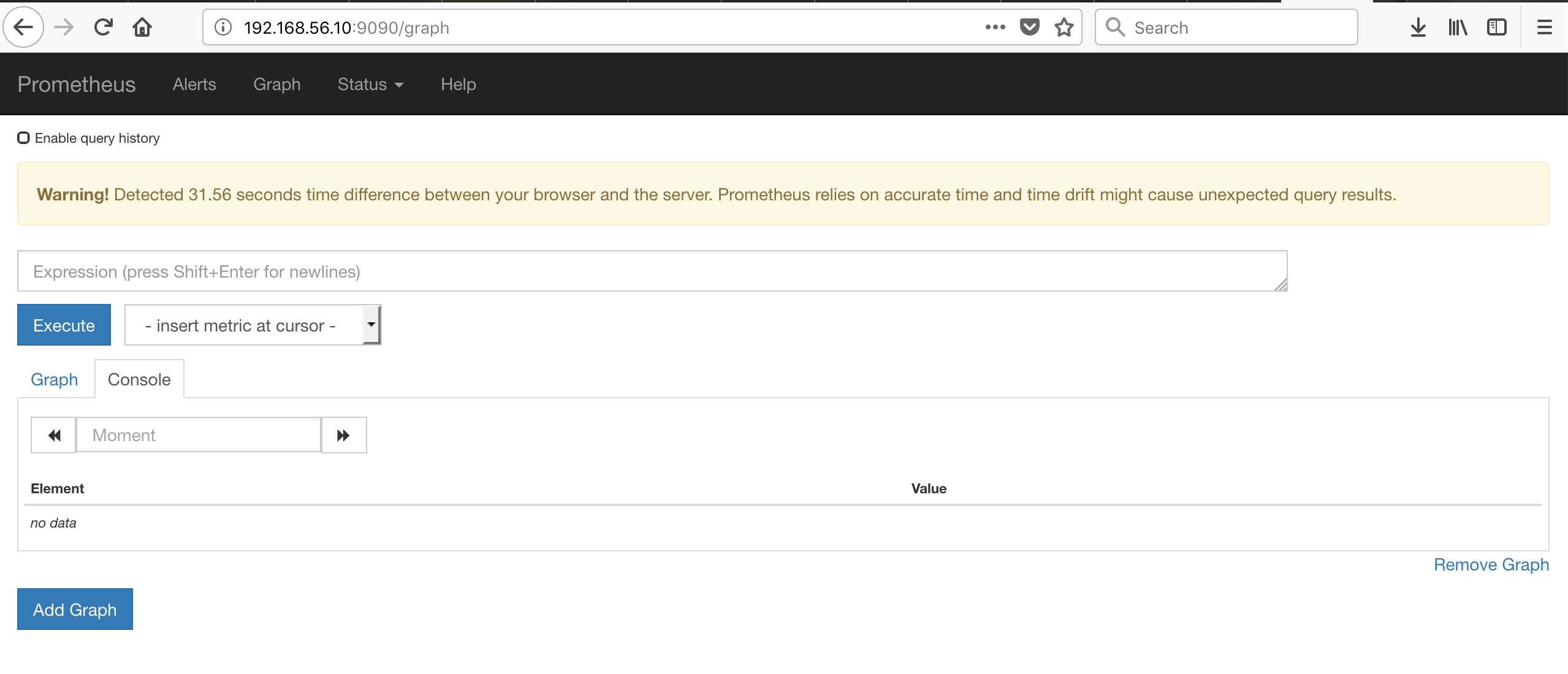

3)验证

4.为hadoop添加jmx_exporter插件

1)下载jmx_exporter

https://repo1.maven.org/maven2/io/prometheus/jmx/jmx_prometheus_javaagent/0.11.0/jmx_prometheus_javaagent-0.11.0.jar

cp /media/sf_Downloads/jmx_prometheus_javaagent-0.11.0.jar /usr/local/prom/exporter/jmx

2)配置nn、dn配置文件

cat namenode.yaml

startDelaySeconds: 0

hostPort: 192.168.56.10:1234 #master为本机IP(一般可设置为localhost);1234为想设置的jmx端口(可设置为未被占用的端口)

#jmxUrl: service:jmx:rmi:///jndi/rmi://127.0.0.1:1234/jmxrmi

ssl: false

lowercaseOutputName: false

lowercaseOutputLabelNames: false

[root@redhat74 jmx]# cat datanode.yaml

startDelaySeconds: 0

hostPort: 192.168.56.10:1235 #master为本机IP(一般可设置为localhost);1234为想设置的jmx端口(可设置为未被占用的端口)

#jmxUrl: service:jmx:rmi:///jndi/rmi://127.0.0.1:1234/jmxrmi

ssl: false

lowercaseOutputName: false

lowercaseOutputLabelNames: false

3)修改hadoop相关脚本

# cat /usr/hdp/3.1.0.0-78/hadoop-hdfs/bin/hdfs 和/usr/hdp/3.1.0.0-78/hadoop/bin/hdfs

#!/bin/bash

export HADOOP_HOME=${HADOOP_HOME:-/usr/hdp/3.1.0.0-78/hadoop}

export HADOOP_MAPRED_HOME=${HADOOP_MAPRED_HOME:-/usr/hdp/3.1.0.0-78/hadoop-mapreduce}

export HADOOP_YARN_HOME=${HADOOP_YARN_HOME:-/usr/hdp/3.1.0.0-78/hadoop-yarn}

export HADOOP_LIBEXEC_DIR=${HADOOP_HOME}/libexec

export HDP_VERSION=${HDP_VERSION:-3.1.0.0-78}

export HADOOP_OPTS="${HADOOP_OPTS} -Dhdp.version=${HDP_VERSION}"

#jmx_exporter#

export HDFS_NAMENODE_OPTS="$HDFS_NAMENODE_JMX_OPTS -javaagent:/usr/local/prom/exporter/jmx/jmx_prometheus_javaagent-0.11.0.jar=9200:/usr/local/prom/exporter/jmx/namenode.yaml"

export HDFS_DATANODE_OPTS="$HDFS_DATANODE_JMX_OPTS -javaagent:/usr/local/prom/exporter/jmx/jmx_prometheus_javaagent-0.11.0.jar=9300:/usr/local/prom/exporter/jmx/datanode.yaml"

exec /usr/hdp/3.1.0.0-78//hadoop-hdfs/bin/hdfs.distro "$@"

编辑前台hadoop-env template(hadoop-env.sh每次都是依据template重新生成的)

#jmx_exporter#

export HDFS_NAMENODE_JMX_OPTS="-Dcom.sun.management.jmxremote.authenticate=false -Dcom.sun.management.jmxremote.ssl=false -Dcom.sun.management.jmxremote.local.only=false -Dcom.sun.management.jmxremote.port=1234 $HDFS_NAMENODE_JMX_OPTS "

export HDFS_DATANODE_JMX_OPTS="-Dcom.sun.management.jmxremote.authenticate=false -Dcom.sun.management.jmxremote.ssl=false -Dcom.sun.management.jmxremote.local.only=false -Dcom.sun.management.jmxremote.port=1235 $HDFS_DATANODE_JMX_OPTS "

4)重启集群

chown -R hdfs:hadoop /usr/local/prom/exporter/jmx

因为只配了一个节点,standby nn一直没有进行checkpoint,手工执行一下

$ hdfs dfsadmin -safemode enter

Safe mode is ON

$ hdfs dfsadmin -saveNamespace

Save namespace successful

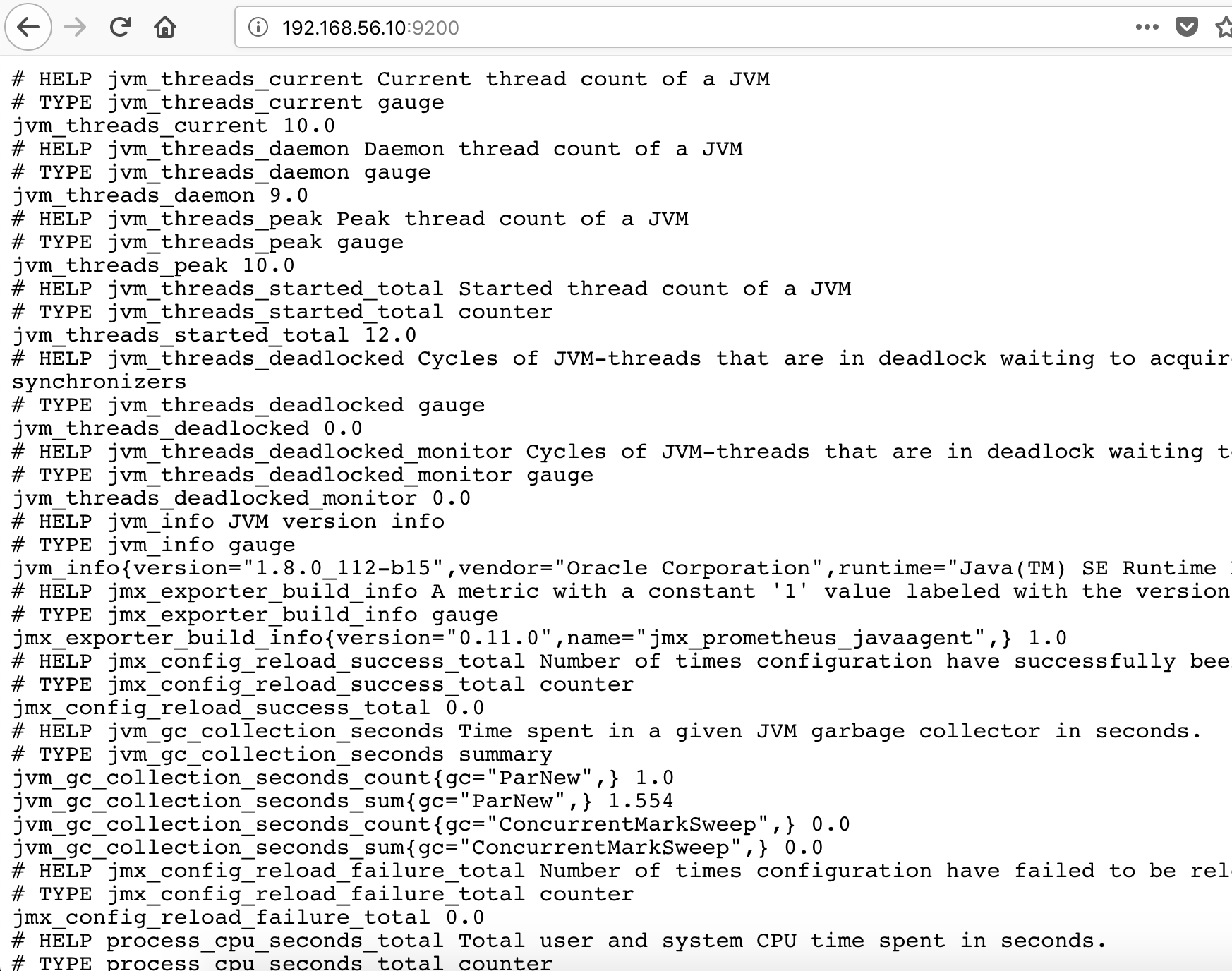

5)9200和9300验证

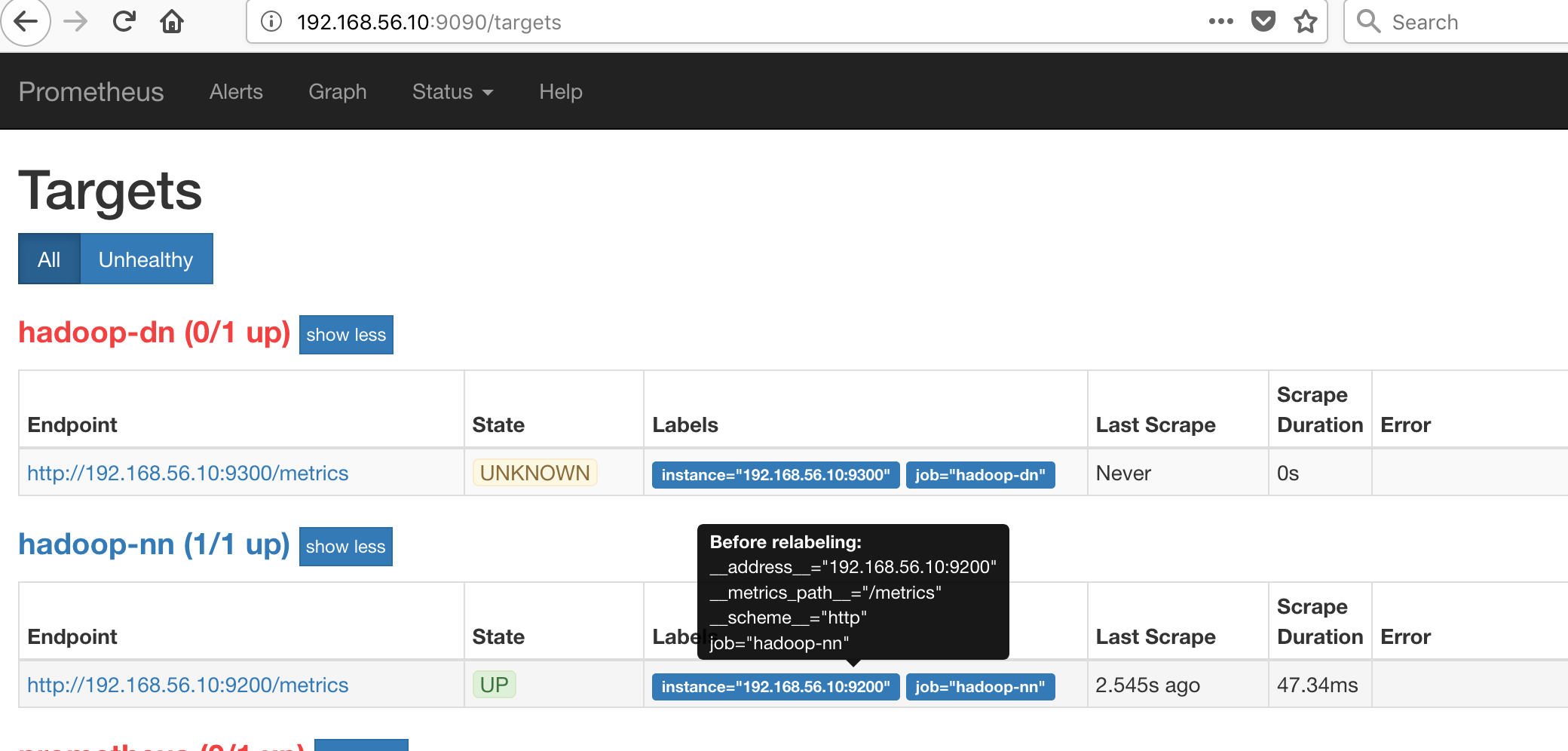

6)为jmx添加prometheus配置

vi prometheus.yml

- job_name: 'hadoop-nn'

static_configs:

- targets: ['localhost:1234']

- job_name: 'hadoop-dn'

static_configs:

- targets: ['localhost:1235']

7)重启prometheus验证

5.grafana展现

1)安装grafana并运行

#yum install grafana-5.4.3-1.x86_64.rpm

# systemctl start grafana-server

# systemctl status grafana-server

2)前台配置

http://192.168.56.10:3000/login

admin/admin

添加数据库prometheus

终于搭完了,没感觉咋滴,哎。。。。