闲来无聊,整理下,以飨各位,有的没按照顺序来, 类似的知识点放在一起了,觉得自己的知识点掌握的差不多的童鞋,可以考虑一边看题目一边有声回答,就当做这就是面试。

需要进行公式推导的

SVM

LR

贝叶斯

LSTM

LDA

机器学习:

1、请简要介绍下SVM (http://blog.csdn.net/v_july_v/article/details/7624837)

2、哪些机器学习算法不需要做归一化处理?

3、对于树形结构为什么不需要归一化?

4、在k-means或kNN,我们常用欧氏距离来计算最近的邻居之间的距离,有时也用曼哈顿距离,请对比下这两种距离的差别

5、数据归一化(或者标准化,注意归一化和标准化不同)的原因

(http://blog.csdn.net/woaidapaopao/article/details/77806273)

42、机器学习中,为何要经常对数据做归一化

(http://www.cnblogs.com/LBSer/p/4020370.html)

47、标准化与归一化的区别?

6、请简要说说一个完整机器学习项目的流程

7、逻辑斯特回归为什么要对特征进行离散化。

34、简单介绍下logistics回归?

8、简单介绍下LR (把LR从头到脚都给讲一遍。

(http://blog.csdn.net/cyh_24/article/details/50359055)

(https://blog.csdn.net/zouxy09/article/details/20319673)

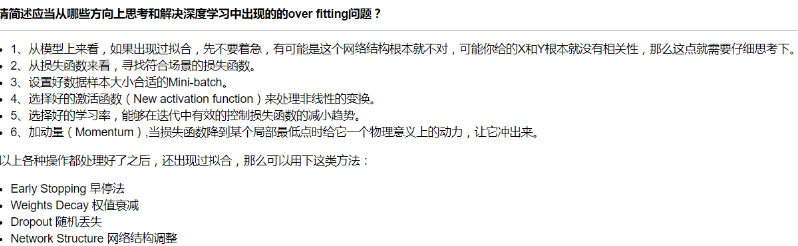

9、overfitting怎么解决

41、防止过拟合的方法

10、LR和SVM的联系与区别

11、什么是熵 (https://blog.csdn.net/v_july_v/article/details/40508465)

14、熵、联合熵、条件熵、相对熵、互信息的定义

21、什么是最大熵

12、说说梯度下降法。

13、牛顿法和梯度下降法有什么不同?

15、说说你知道的核函数

16、什么是拟牛顿法(Quasi-Newton Methods)?

17、kmeans的复杂度?

18、请说说随机梯度下降法的问题和挑战?

19、说说共轭梯度法?

20、对所有优化问题来说, 有没有可能找到比現在已知算法更好的算法?

22、LR与线性回归的区别与联系

23、简单说下有监督学习和无监督学习的区别

24、请问(决策树、Random Forest、Booting、Adaboot)GBDT和XGBoost的区别是什么?

(https://blog.csdn.net/v_july_v/article/details/7577684)

(https://blog.csdn.net/ns708865818/article/details/51426624)

25、了解正则化么

32、L1和L2的区别

33、L1和L2正则先验分别服从什么分布

26、说说常见的损失函数?

27、为什么xgboost要用泰勒展开,优势在哪里?

29、xgboost如何寻找最优特征?是又放回还是无放回的呢?

28、协方差和相关性有什么区别?

30、谈谈判别式模型和生成式模型?

31、线性分类器与非线性分类器的区别以及优劣

35、说一下Adaboost,权值更新公式。当弱分类器是Gm时,每个样本的的权重是w1,w2...,请写出最终的决策公式。(http://blog.csdn.net/v_july_v/article/details/40718799)

36、经常在网上搜索东西的朋友知道,当你不小心输入一个不存在的单词时,搜索引擎会提示你是不是要输入某一个正确的单词,比如当你在Google中输入“Julw”时,

系统会猜测你的意图:是不是要搜索“July”,如下图所示:

这叫做拼写检查。根据谷歌一员工写的文章显示,Google的拼写检查基于贝叶斯方法。请说说的你的理解,具体Google是怎么利用贝叶斯方法,实现"拼写检查"的功能。

37、为什么朴素贝叶斯如此“朴素”?45、简单说说贝叶斯定理 (https://blog.csdn.net/v_july_v/article/details/40984699)

38、请大致对比下plsa和LDA的区别

(http://blog.csdn.net/v_july_v/article/details/41209515)

39、请简要说说EM算法

40、KNN中的K如何选取的?

(https://blog.csdn.net/v_july_v/article/details/8203674)

43、什么最小二乘法?最小二乘法跟SVM有什么联系呢?请参见《支持向量机通俗导论(理解SVM的三层境界)

44、梯度下降法找到的一定是下降最快的方向么?

46、怎么理解决策树、xgboost能处理缺失值?而有的模型(svm)对缺失值比较敏感。

(https://www.zhihu.com/question/58230411)

48、随机森林如何处理缺失值?

49、随机森林如何评估特征重要性?

50、优化Kmeans?

51、KMeans初始类簇中心点的选取。

52、解释对偶的概念。

53、如何进行特征选择?

54、衡量分类器的好坏?

55、机器学习和统计里面的auc的物理意义是啥?(https://www.zhihu.com/question/39840928)

56、数据预处理。

57、观察增益gain, alpha和gamma越大,增益越小?

58、什麽造成梯度消失问题?

59、简单说说特征工程。

60、你知道有哪些数据处理和特征工程的处理?

61、准备机器学习面试应该了解哪些理论知识?

62、数据不平衡问题

63、特征比数据量还大时,选择什么样的分类器?

(http://blog.sina.com.cn/s/blog_178bcad000102x70r.html )

64、常见的分类算法有哪些?

65、常见的监督学习算法有哪些?

66、说说常见的优化算法及其优缺点?

67、特征向量的归一化方法有哪些?

68、RF与GBDT之间的区别与联系?

69、

70、请比较下EM算法、HMM、CRF

71、带核的SVM为什么能分类非线性问题?

72、请说说常用核函数及核函数的条件

73 boosting与bagging的区别

74 逻辑回归

75、什么是共线性, 跟过拟合有什么关联?

76、机器学习中,有哪些特征选择的工程方法? (答案有点怪异

77、用贝叶斯机率说明Dropout的原理

78、对于维度极低的特征,选择线性还是非线性分类器?

79、请问怎么处理特征向量的缺失值

80、SVM、LR、决策树的对比。

81、什么是ill-condition病态问题?

82、简述KNN最近邻分类算法的过程?

83、常用的聚类划分方式有哪些?列举代表算法。

84、什么是偏差与方差? (过拟合与欠拟合)

85、解决bias和Variance问题的方法是什么?

86、采用 EM 算法求解的模型有哪些,为什么不用牛顿法或梯度下降法?

87、xgboost怎么给特征评分?

88、什么是OOB?随机森林中OOB是如何计算的,它有什么优缺点?

89、推导朴素贝叶斯分类 P(c|d),文档 d(由若干 word 组成),求该文档属于类别 c 的概率, 并说明公式中哪些概率可以利用训练集计算

90、请写出你了解的机器学习特征工程操作,以及它的意义

深度学习:

1、CNN的卷积核是单层的还是多层的?

2、什么是卷积?

3、什么是CNN的池化pool层?

4、简述下什么是生成对抗网络。

5、学梵高作画的原理是什么?

6、请简要介绍下tensorflow的计算图

7、你有哪些deep learning(rnn、cnn)调参的经验? (*)

8、CNN最成功的应用是在CV,那为什么NLP和Speech的很多问题也可以用CNN解出来?为什么AlphaGo里也用了CNN?这几个不相关的问题的相似性在哪里?CNN通过什么手段抓住了这个共性?

23、简单说说CNN常用的几个模型 (*)

34、请详细说说CNN的工作原理

35、CNN究竟是怎样一步一步工作的?

39、CNN是什么,CNN关键的层有哪些?

36、聊一聊基于深度学习的目标检测技术演进:R-CNN、Fast R-CNN、Faster R-CNN (*)

37、rcnn、fast-rcnn和faster-rcnn三者的区别是什么 (*)

32、简单说下sigmoid激活函数

9、LSTM结构推导,为什么比RNN好?

33、如何理解LSTM网络

10、Sigmoid、Tanh、ReLu这三个激活函数有什么缺点或不足,有没改进的激活函数。

11、为什么引入非线性激励函数?

12、请问人工神经网络中为什么ReLu要好过于tanh和sigmoid function?

13、为什么LSTM模型中既存在sigmoid又存在tanh两种激活函数?

14、如何解决RNN梯度爆炸和弥散的问题?

梯度爆炸就是由于初始化权值过大,前面层会比后面层变化的更快,就会导致权值越来越大。

17、如何解决梯度消失和梯度膨胀

26、梯度爆炸会引发什么问题?

27、如何确定是否出现梯度爆炸?

28、如何修复梯度爆炸问题?

15、什麽样的资料集不适合用深度学习?

16、广义线性模型是怎被应用在深度学习中?

19、深度学习常用方法

20、请简述神经网络的发展史

21、神经网络中激活函数的真正意义?一个激活函数需要具有哪些必要的属性?还有哪些属性是好的属性但不必要的?

22、梯度下降法的神经网络容易收敛到局部最优,为什么应用广泛?

24、为什么很多做人脸的Paper会最后加入一个Local Connected Conv?

29、LSTM神经网络输入输出究竟是怎样的?

30、什么是RNN? (*)

31、RNN是怎么从单层网络一步一步构造的? (*)

38、在神经网络中,有哪些办法防止过拟合?

40、GRU是什么?GRU对LSTM做了哪些改动?

K-means,如何用hadoop实现k-means

naive bayes和logistic regression的区别

做广告点击率预测,需要的数据、算法

推荐系统的算法中最近邻和矩阵分解各自适用场景